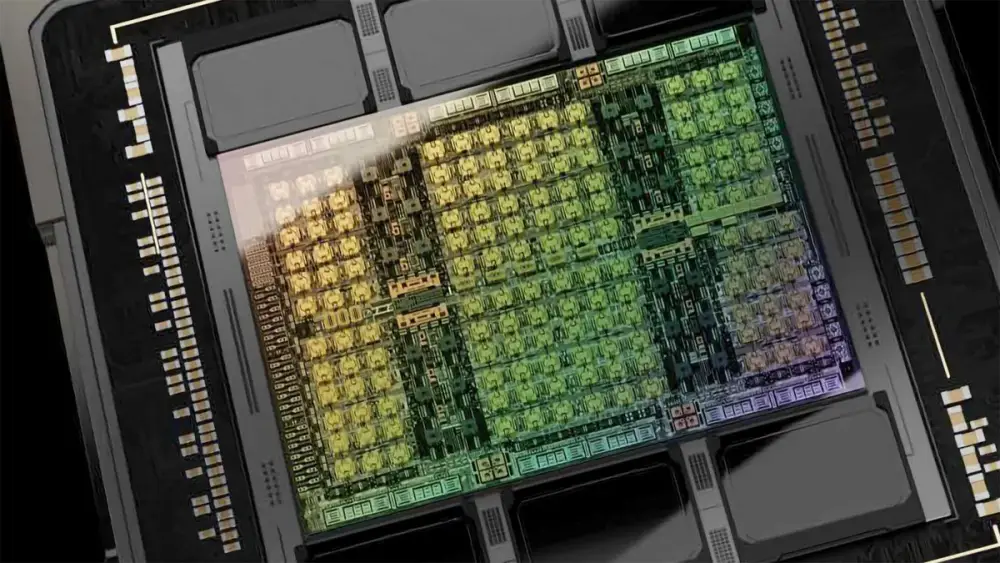

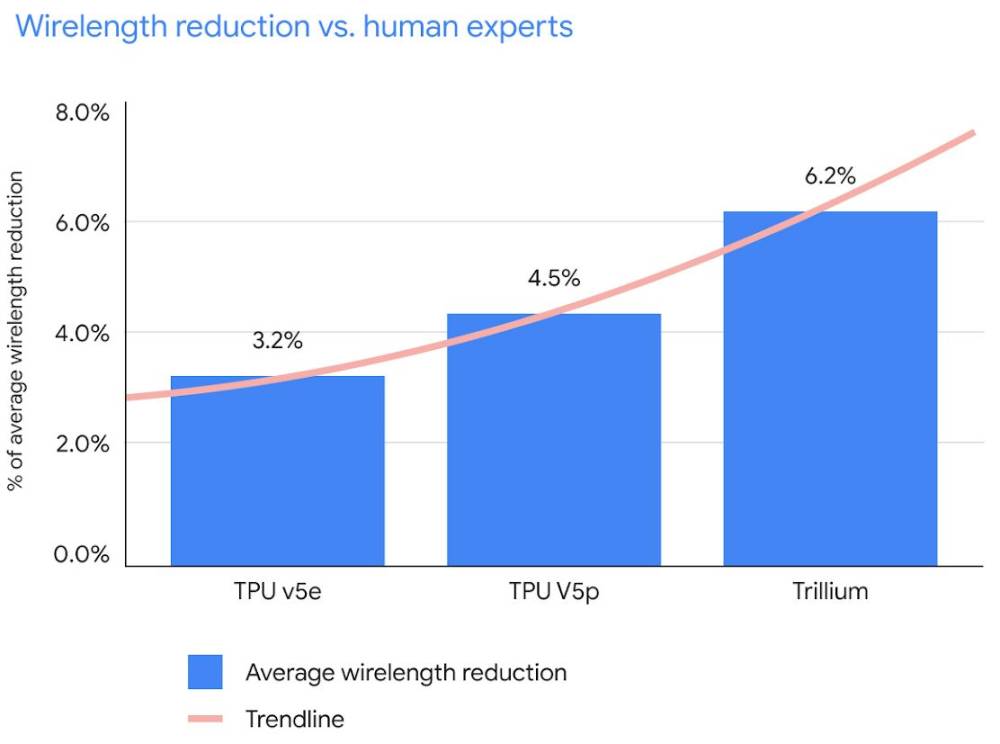

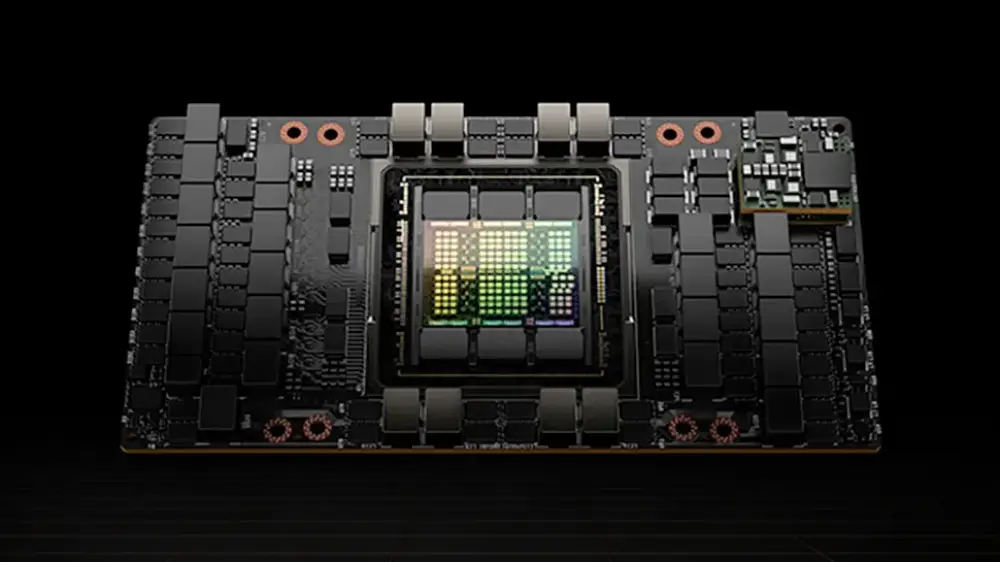

Các nhà nghiên cứu Trung Quốc đã phát triển thành công GPU nội địa với hiệu suất vượt trội, nhanh hơn gần 10 lần so với máy tính siêu cấp sử dụng GPU của Nvidia

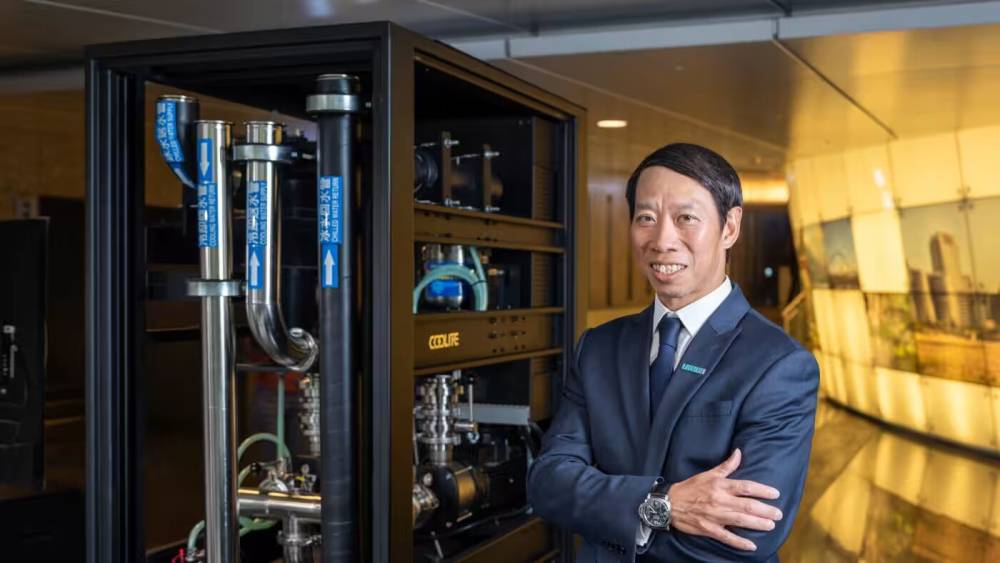

Giáo sư Nan Tongchao từ Đại học Hohai ở Nam Kinh đã dẫn đầu nhóm nghiên cứu phát triển mô hình tính toán song song "đa nút, đa GPU"

Hệ thống chỉ cần 7 nút để đạt hiệu suất tương đương với hệ thống TRITON của Mỹ cần tới 64 nút, giảm 89% số nút sử dụng

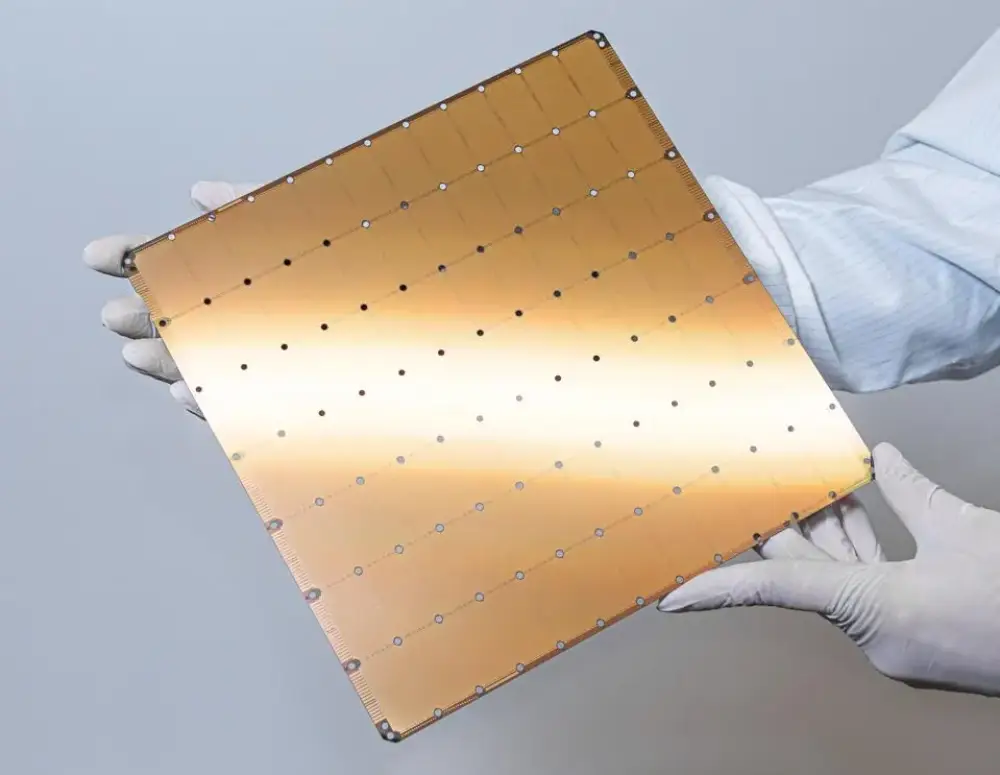

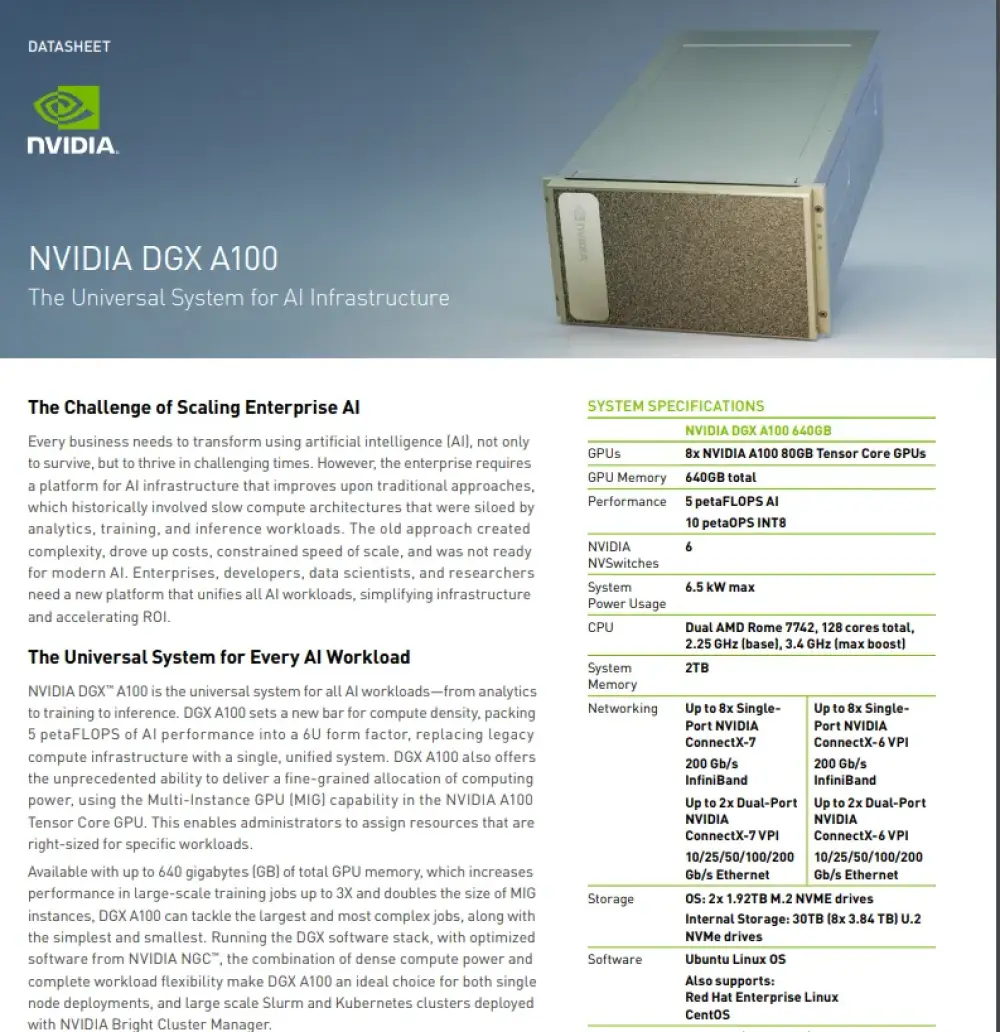

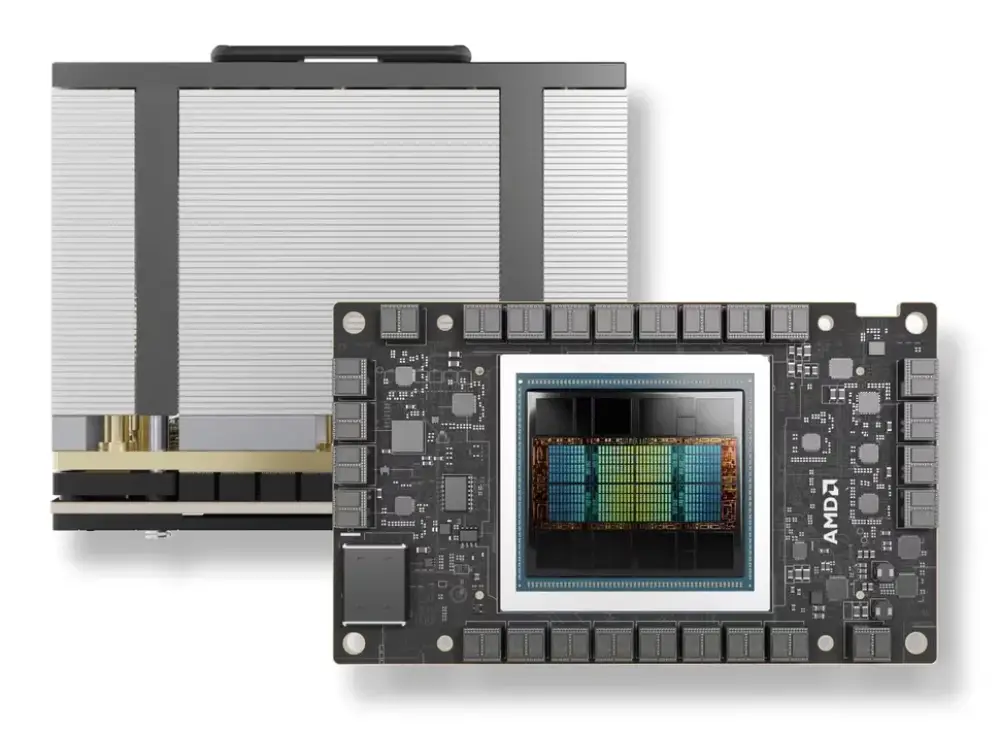

Cấu hình phần cứng bao gồm:

CPU Hygon 7185 (32 nhân, 64 luồng) tốc độ 2,5 GHz

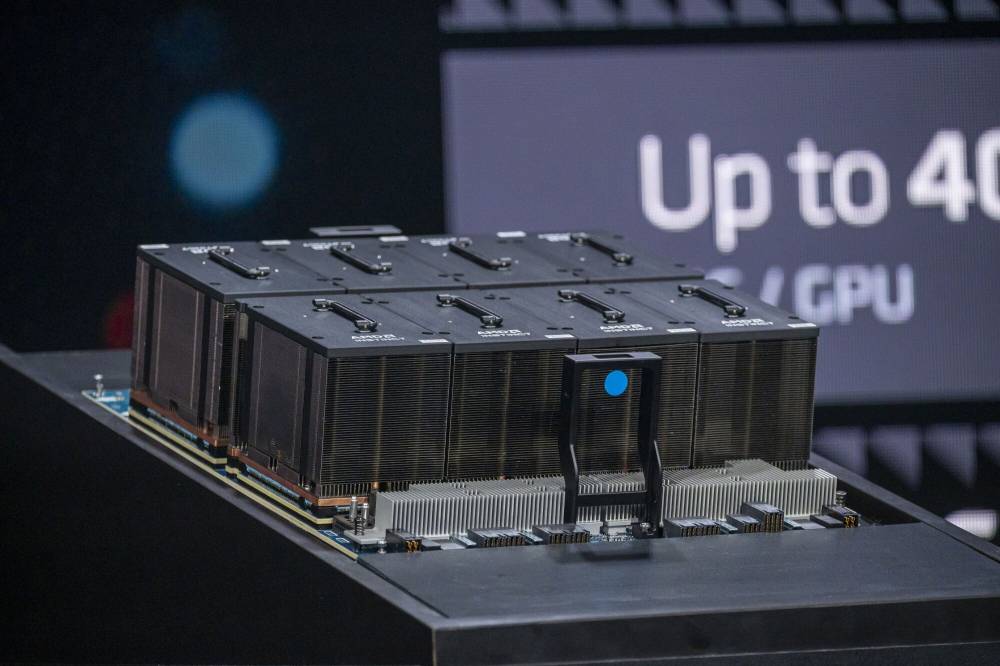

GPU nội địa với 128GB bộ nhớ

Băng thông mạng 200 Gb/giây

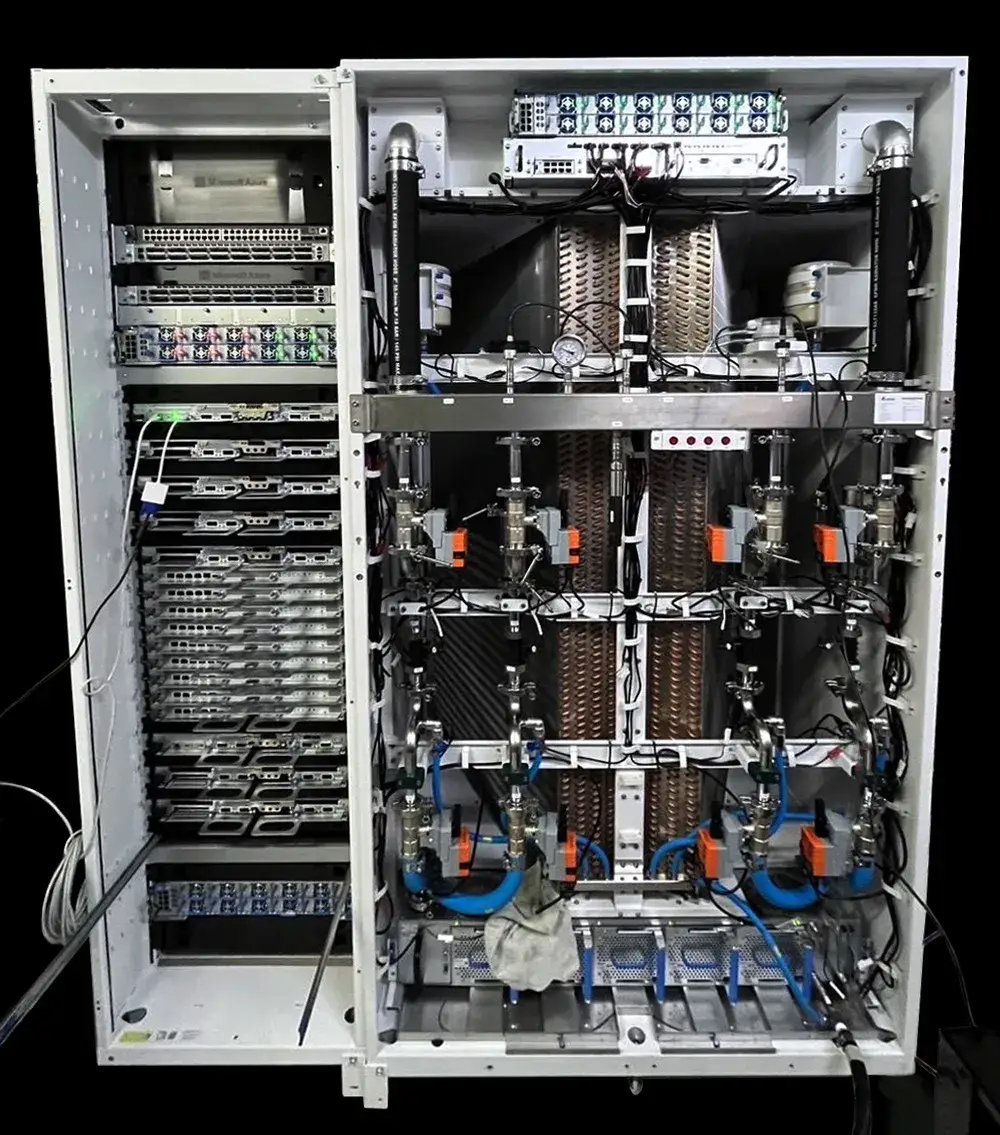

Thử nghiệm mô phỏng lũ lụt tại hồ chứa Zhuangli ở Sơn Đông:

Sử dụng 200 nút và 800 GPU

Hoàn thành trong 3 phút

Nhanh hơn 160 lần so với phương pháp truyền thống

Nghiên cứu được công bố trên Tạp chí Kỹ thuật Thủy lợi Trung Quốc ngày 3/1/2025, mã nguồn được công bố dưới dạng nguồn mở

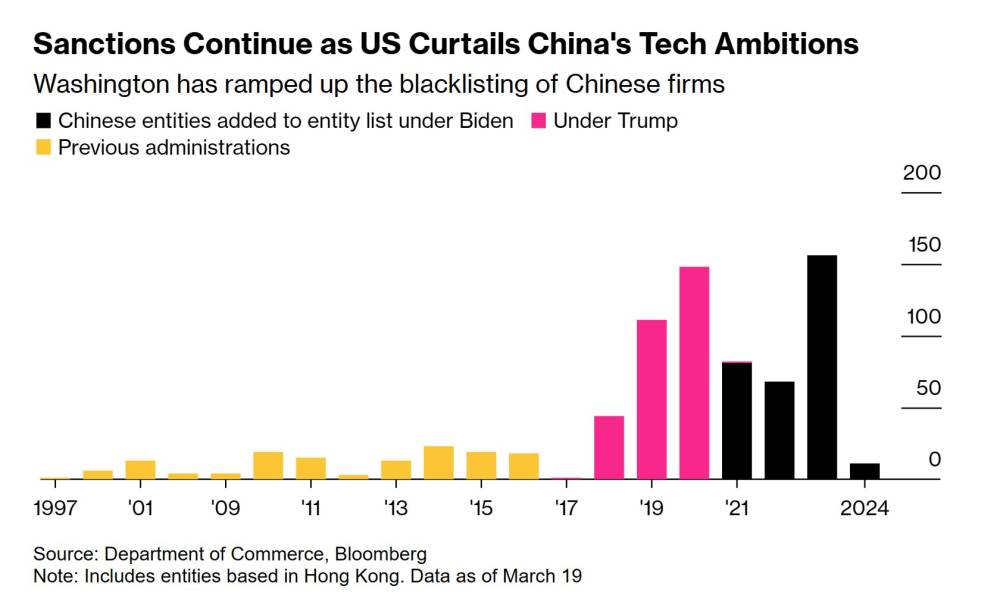

Lệnh cấm vận của Mỹ ngăn Trung Quốc tiếp cận GPU A100 và H100 của Nvidia, cùng với phần mềm CUDA đã thúc đẩy Trung Quốc phát triển giải pháp riêng

Ứng dụng tiềm năng bao gồm thủy văn học, mô hình hóa phù sa và tương tác nước mặt

📌 GPU nội địa của Trung Quốc đã vượt qua GPU của Nvidia với hiệu suất cao hơn 10 lần, chỉ cần 7 nút thay vì 64 nút, và hoàn thành mô phỏng lũ lụt trong 3 phút - nhanh hơn 160 lần so với phương pháp truyền thống. Đây là dấu mốc quan trọng thách thức vị thế thống trị công nghệ của Mỹ.

https://www.gizmochina.com/2025/02/19/chinese-gpus-outperform-nvidia-in-supercomputing-a-challenge-to-us-tech-dominance/

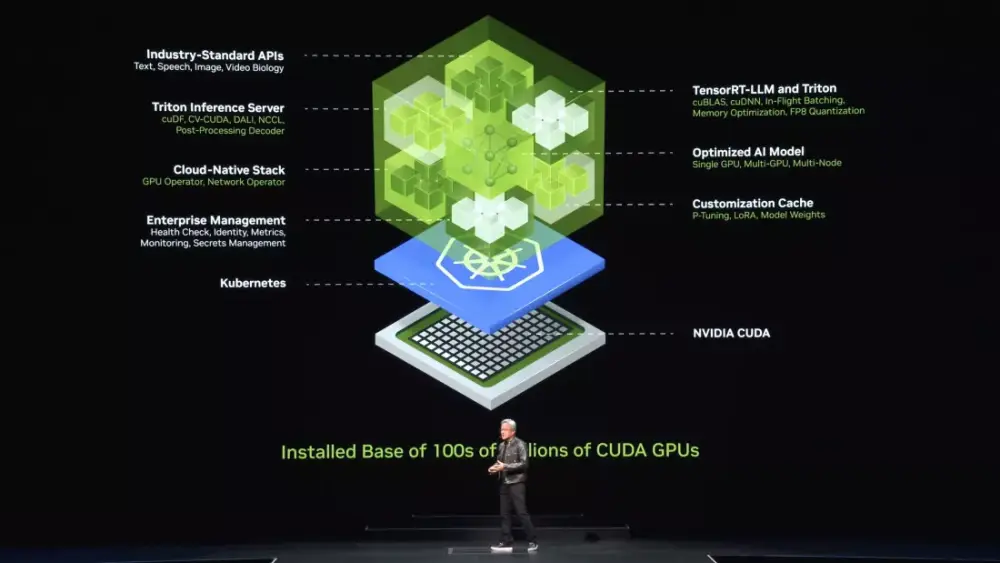

Startup AI Nhật Bản Sakana AI ra mắt The AI CUDA Engineer - framework tự động phát hiện và tối ưu hóa CUDA kernel nhằm cải thiện hiệu suất GPU

Framework này có khả năng tạo CUDA kernel nhanh hơn từ 10 đến 100 lần so với các thao tác PyTorch thông thường và nhanh hơn 5 lần so với CUDA kernel đang được sử dụng trong sản xuất

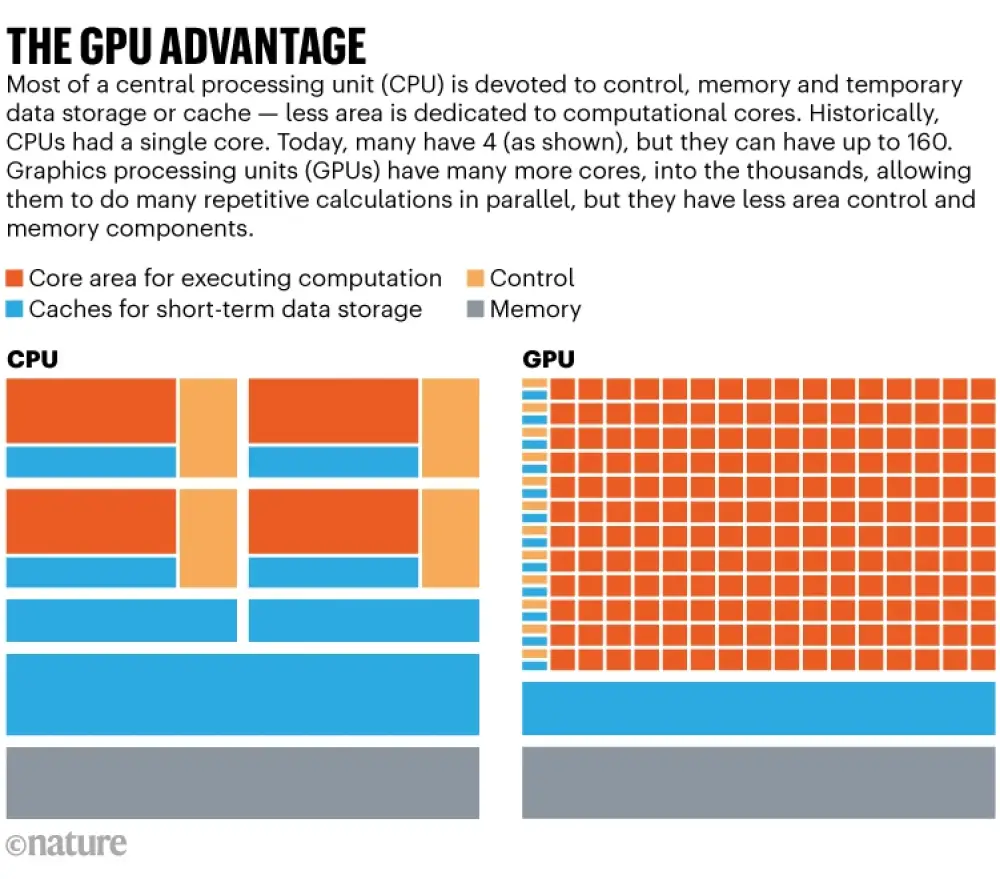

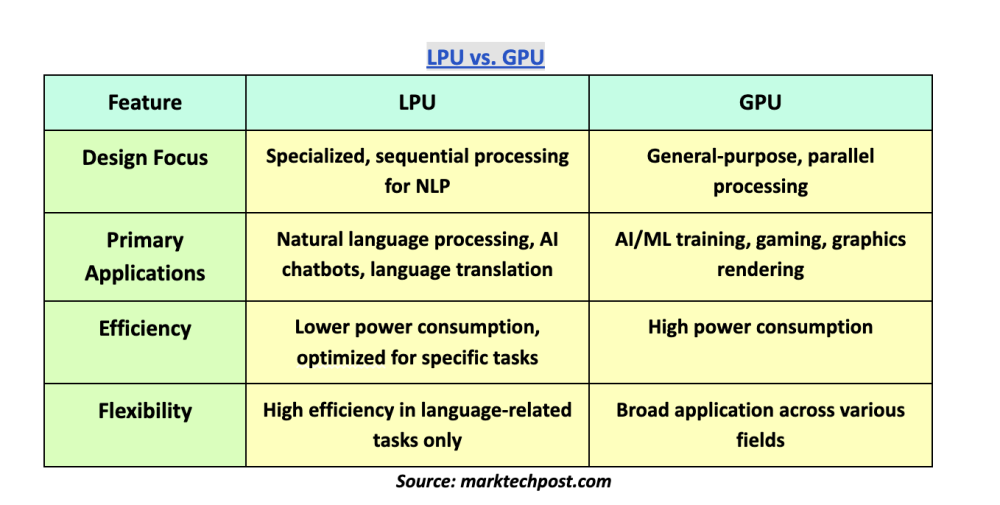

CUDA là giao diện lập trình cấp thấp cho phép truy cập trực tiếp vào GPU NVIDIA để tính toán song song

Jim Fan, giám đốc nghiên cứu cấp cao tại NVIDIA đánh giá đây là agent lập trình tự động ấn tượng nhất gần đây

Framework hoạt động theo quy trình nhiều giai đoạn:

Chuyển đổi mã PyTorch thành CUDA kernel

Áp dụng tối ưu hóa tiến hóa

Sử dụng chiến lược "crossover" và "innovation archive" để cải thiện hiệu suất

Kết quả đạt được:

Đã chuyển đổi thành công hơn 230/250 thao tác PyTorch được đánh giá

Tạo ra hơn 30.000 CUDA kernel

17.000 kernel đã được xác minh tính chính xác

50% kernel có hiệu suất vượt trội so với PyTorch nguyên bản

Sakana AI đã công bố:

Bộ dữ liệu theo giấy phép CC-By-4.0 trên Hugging Face

Website tương tác cho phép người dùng khám phá dữ liệu và bảng xếp hạng kernel đã tối ưu

Cung cấp mã nguồn kernel, số liệu hiệu suất và các thử nghiệm tối ưu hóa liên quan

📌 Framework AI CUDA Engineer của Sakana đã chứng minh khả năng tăng tốc GPU lên đến 100 lần, với 17.000 kernel được xác thực và 50% vượt trội so với PyTorch. Đây là bước tiến quan trọng trong việc tự động hóa tối ưu hóa CUDA kernel thông qua AI.

https://analyticsindiamag.com/ai-news-updates/sakanas-ai-cuda-engineer-delivers-up-to-100x-speed-gains-over-pytorch/

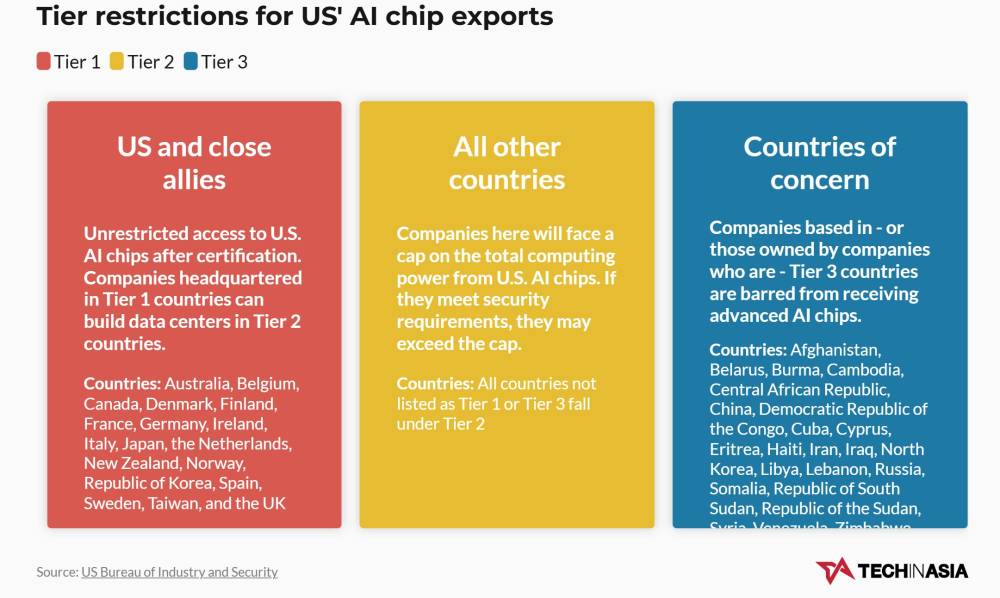

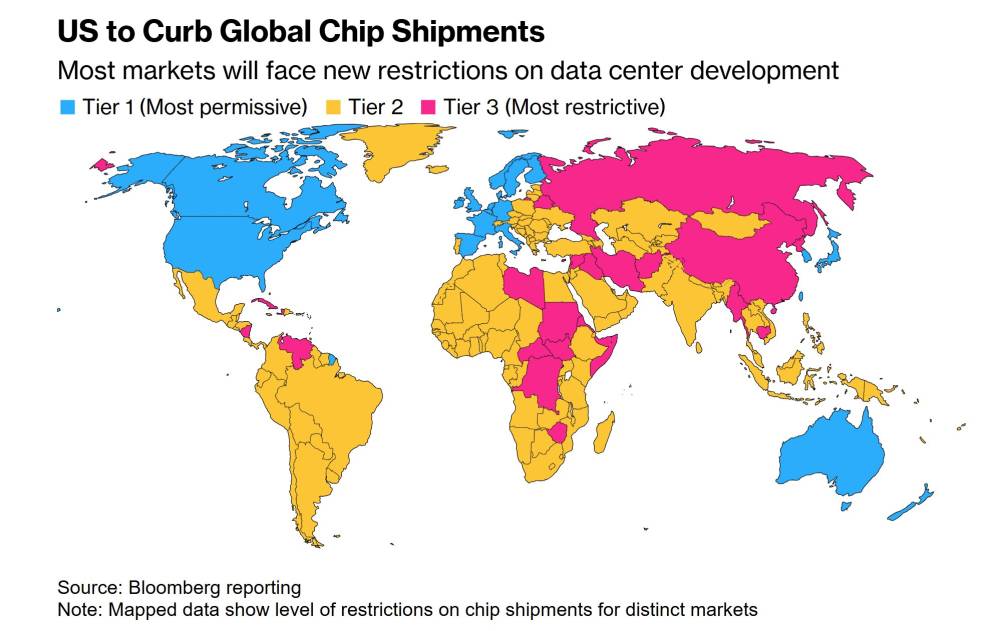

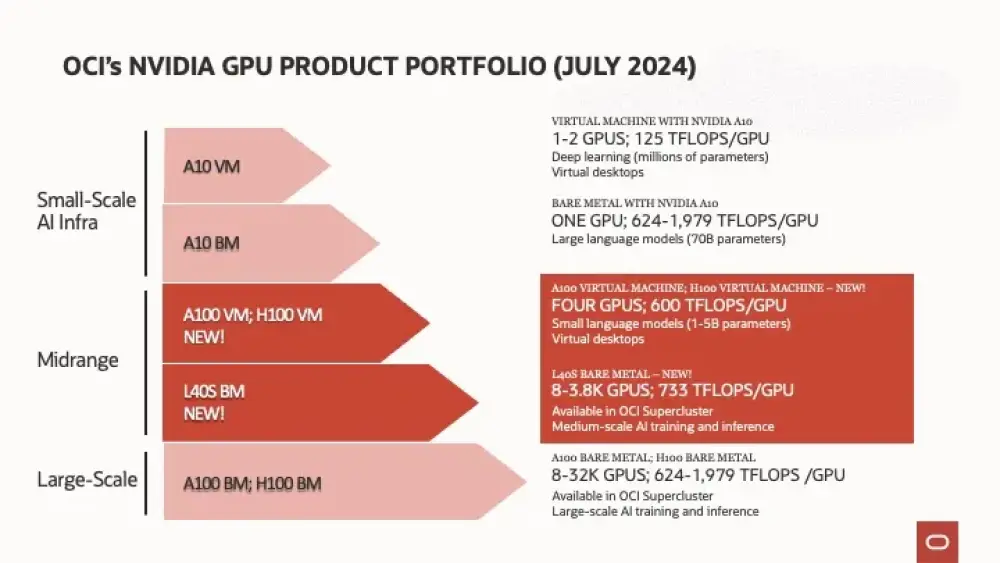

Sắc lệnh hành pháp 14141 của Tổng thống Biden hạn chế xuất khẩu chip AI cao cấp, ảnh hưởng đến các startup AI ở Đông Nam Á phụ thuộc vào dịch vụ đám mây

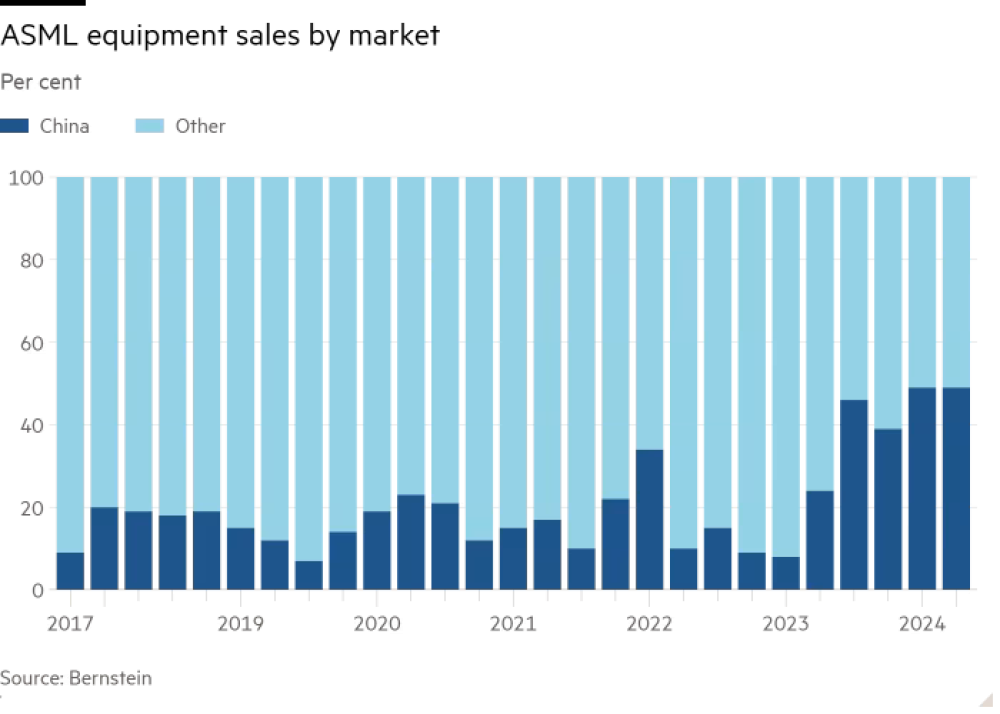

Singapore bị điều tra liên quan đến việc startup DeepSeek của Trung Quốc mua chip Nvidia qua bên thứ ba

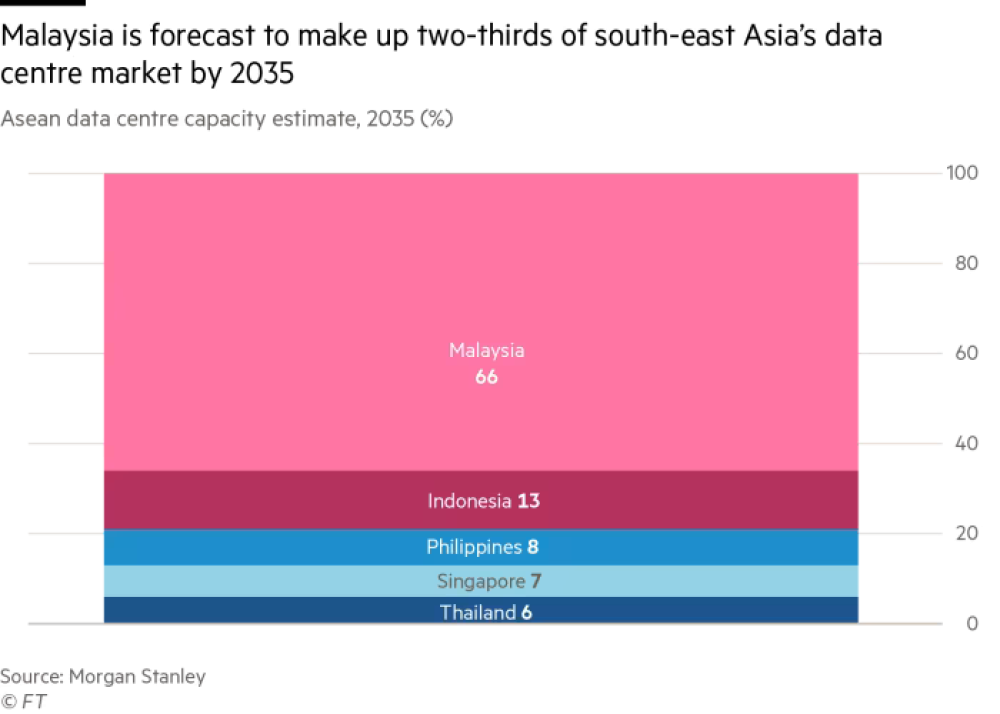

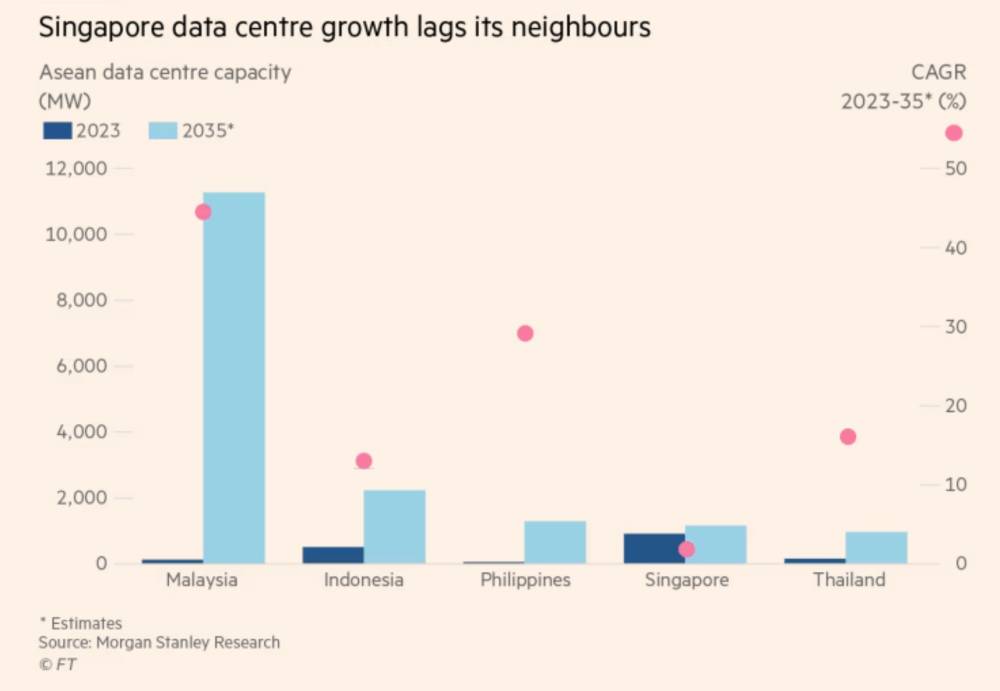

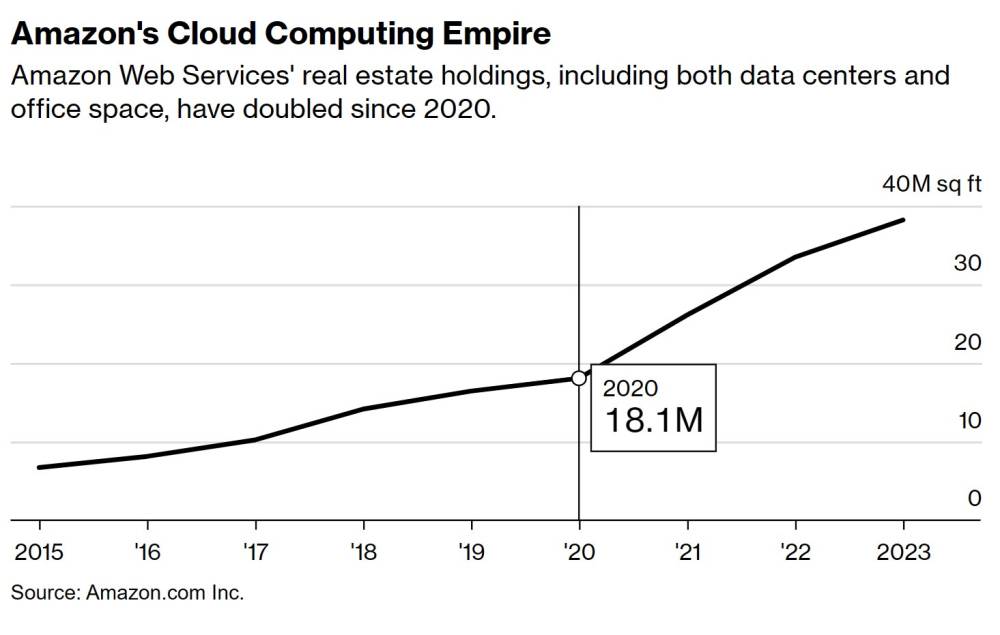

Malaysia đã đầu tư 21,7 tỷ USD vào trung tâm dữ liệu trong 2 năm qua

Singapore cam kết chi 740 triệu USD hỗ trợ phát triển AI trong 5 năm tới

Theo quy định mới, công ty AI Mỹ phải giữ:

50% năng lực tính toán ở Mỹ

25% được triển khai ở các nước đồng minh (Tier 1)

7% cho các nước Tier 2 (bao gồm hầu hết quốc gia Đông Nam Á)

Cấm bán chip cho 22 quốc gia Tier 3

Các chuyên gia nhận định:

Tác động ngắn hạn sẽ ít do khu vực hiện có đủ năng lực tính toán

Có thể đẩy các công ty về phía công nghệ Trung Quốc

Hyperscaler có thể rút GPU về Mỹ, Nhật, Đài Loan

Startup có thể di chuyển đến các nước Tier 1

Thế hệ chip Nvidia mới dự kiến nhanh hơn 3-5 lần, công ty không tuân thủ quy định sẽ gặp khó khăn trong việc tiếp cận

Các nước như Thái Lan, Indonesia, Vietnam có thể bị ảnh hưởng nếu hyperscaler xem xét lại kế hoạch mở rộng

📌 Quy định hạn chế chip AI mới của Mỹ có thể làm chậm tham vọng trở thành trung tâm AI của Đông Nam Á. Khu vực đã đầu tư lớn với 21,7 tỷ USD từ Malaysia và 740 triệu USD từ Singapore, nhưng đối mặt nguy cơ mất cơ hội phát triển và đẩy các công ty về phía công nghệ Trung Quốc.

https://www.techinasia.com/chips-stacked-against-sea-new-rules-may-hinder-ai-boom-in-region

#TechinAsia

Những quy định mới của Mỹ về chip AI đã gây ra sự hoang mang trong ngành công nghệ Đông Nam Á vào tháng trước, khi các công ty chạy đua để tìm hiểu tác động của chúng đối với khu vực.

Sắc lệnh hành pháp 14141 của Mỹ, được Tổng thống Joe Biden ký vào tuần cuối cùng trước khi rời nhiệm sở, hạn chế xuất khẩu chip AI cao cấp.

Chính sách này có thể gây ra vấn đề nghiêm trọng cho các nhà phát triển AI, do hầu hết startup trong khu vực đều dựa vào các dịch vụ AI đám mây sử dụng những con chip cao cấp này.

Trung tâm kinh doanh của Đông Nam Á, Singapore, gần đây đã bị Mỹ đưa vào danh sách điều tra về việc startup AI Trung Quốc DeepSeek có mua chip Nvidia cao cấp từ bên thứ ba hay không.

Những người trong ngành được Tech in Asia phỏng vấn đồng tình rằng tác động ngắn hạn của quy định mới sẽ không quá lớn.

Các lô hàng chip đã được vận chuyển đến khu vực này sẽ vẫn ở lại đây. Đồng thời, cũng có những nghi vấn liệu chính quyền Trump có giữ nguyên các hạn chế này hay không.

Tuy nhiên, trong dài hạn, nếu quy định này vẫn duy trì, tham vọng trở thành trung tâm AI của Đông Nam Á có thể chậm lại. Điều này có thể đẩy khu vực vào thế phải hợp tác với các nhà cung cấp chip Trung Quốc.

Hiện tại, ngành công nghệ đang tập trung vào quyết định của Tổng thống Donald Trump. Ngay khi nhậm chức, ông đã hủy bỏ nhiều sắc lệnh của Biden. Tuy nhiên, sắc lệnh hành pháp 14141 vẫn chưa bị động đến.

"Không ai có thể đoán trước Trump sẽ làm gì," một nguồn tin giấu tên cho biết. "Ông ấy có thể bãi bỏ một số điều khoản hoặc thậm chí siết chặt hơn nữa. Cũng có thể ông ấy chỉ dùng nó như một con bài thương lượng."

Tác động ngay lập tức của quy định mới cũng không lớn vì Đông Nam Á hiện vẫn có đủ năng lực để đáp ứng nhu cầu AI hiện tại.

Dù vậy, các nhà đầu tư và startup trong khu vực vẫn lo lắng về khả năng căng thẳng Mỹ - Trung leo thang sẽ ảnh hưởng đến ngành AI.

Malaysia đã đầu tư 21,7 tỷ USD vào các trung tâm dữ liệu trong 2 năm qua, theo dữ liệu từ Tập đoàn Kinh tế Kỹ thuật số Malaysia.

Trong khi đó, Singapore cam kết chi hơn 740 triệu USD để hỗ trợ phát triển AI trong 5 năm tới. Năm 2019, đảo quốc này tuyên bố mục tiêu trở thành trung tâm AI khu vực.

Hiện nay, hầu hết các trung tâm dữ liệu ở Đông Nam Á không tham gia vào việc phát triển mô hình AI tạo sinh (genAI), theo Matthew Walker, chuyên gia phân tích chính tại MTN Consulting ở Bangkok.

Việc phát triển mô hình genAI là phần tiêu tốn nhiều tài nguyên tính toán nhất khi đào tạo mô hình ngôn ngữ lớn. Hầu hết startup trong khu vực chỉ tham gia vào quá trình tinh chỉnh (fine-tuning), vốn ít tiêu tốn tài nguyên hơn.

“Hạn chế này sẽ có rất ít tác động ngay lập tức vì việc phát triển mô hình AI chủ yếu vẫn diễn ra ở Mỹ,” Walker giải thích.

Nguồn tin giấu tên chia sẻ rằng hầu hết startup họ trao đổi đang áp dụng chiến lược “chờ xem”, vì vẫn còn thời gian trước khi quy định có hiệu lực.

Hiện tại, lệnh hạn chế đang trong giai đoạn bình luận kéo dài 120 ngày, cho phép Cục Công nghiệp và An ninh thuộc Bộ Thương mại Mỹ điều chỉnh nếu cần thiết. Nvidia đã chính thức phản đối quy định này.

“Chưa ai thực hiện động thái lớn nào, nhưng họ đã bắt đầu bàn về nó,” nguồn tin cho hay.

Theo quy định mới, các công ty AI có trụ sở tại Mỹ cung cấp dịch vụ đám mây phải giữ lại 50% năng lực tính toán trong nước. 25% khác được phép triển khai tới các đồng minh thân cận của Mỹ (nhóm Tier 1).

Trong số năng lực tính toán còn lại, 7% có thể được triển khai tới các quốc gia thuộc nhóm Tier 2 – trong đó có tất cả các nước lớn ở Đông Nam Á, nhưng với các quy định nghiêm ngặt hơn nhiều.

Trong khi đó, quy định cấm bán hoặc chuyển giao chip AI cao cấp cho 22 quốc gia thuộc nhóm Tier 3.

Như thường thấy với các sắc lệnh hành pháp, có nhiều ngoại lệ. Các công ty có trụ sở bên ngoài Mỹ có thể mua và sở hữu các chip vượt quá giới hạn nếu đạt trạng thái Người dùng cuối được xác minh quốc gia (National Verified End User).

Những người trong ngành lưu ý rằng chi tiết về các ngoại lệ này vẫn chưa được công bố. Tuy nhiên, một quy tắc khá rõ ràng: không được giao dịch với các công ty Nga, Triều Tiên hoặc Trung Quốc.

Dù vậy, các chuyên gia cũng cho rằng dù quy định này có thể làm chậm hoặc đẩy các startup Trung Quốc ra khỏi các máy chủ AI đám mây của Đông Nam Á, nó khó có thể ngăn chặn hoàn toàn việc chuyển nhượng chip trái phép.

Một hệ quả ngoài mong muốn là các công ty Đông Nam Á có thể khó chịu với các hạn chế này và quyết định sử dụng chip và mô hình đào tạo của Trung Quốc.

Đây chính là điều Mỹ muốn tránh, vì Washington muốn các startup dựa vào công nghệ Mỹ, theo Alex Yeh, đồng sáng lập kiêm CEO GMI Cloud – một nhà cung cấp dịch vụ AI đám mây có trụ sở tại Mỹ với các trung tâm dữ liệu ở Malaysia, Thái Lan và Đài Loan.

Ông cảnh báo rằng nếu các quy định này buộc các công ty chuyển sang công nghệ Trung Quốc, điều đó sẽ giúp các doanh nghiệp Trung Quốc phát triển nhanh hơn và độc lập hơn.

Các chuyên gia dự đoán Trung Quốc có thể tận dụng cơ hội này để gia tăng ảnh hưởng công nghệ trong khu vực.

Hiện tại, các bên liên quan trong ngành AI tại Malaysia và Singapore cho rằng họ đã có đủ năng lực tính toán AI để đối phó với bất kỳ hạn chế nào từ Mỹ.

Một nguồn tin giấu tên nói với Tech in Asia rằng các trung tâm hiện có và sắp xây dựng ở các quốc gia này được thiết kế để có dư công suất và đáp ứng nhu cầu ngày càng tăng.

“Tại thời điểm này, nhu cầu tính toán trong Malaysia và Singapore vẫn thấp hơn rất, rất nhiều so với năng lực hiện tại,” nguồn tin cho biết. Họ dự đoán khu vực này sẽ không đạt đến giới hạn công suất hiện có trong ít nhất 10 năm tới.

Tuy nhiên, không phải ai cũng đồng tình.

Yeh từ GMI Cloud tin rằng các hạn chế có thể bắt đầu ảnh hưởng chỉ trong một năm. Công ty của ông hợp tác chặt chẽ với Nvidia và là một phần trong mạng lưới đối tác của tập đoàn này.

Ông cho rằng các công ty không tuân thủ quy định sẽ gặp khó khăn khi thế hệ chip Nvidia mới – được dự đoán có tốc độ nhanh gấp 3 đến 5 lần hiện tại – ra mắt.

“Người ta sẽ bỏ ra số tiền tương tự nhưng làm được nhiều gấp 5 lần so với bạn,” ông giải thích.

Ông cũng dự đoán rằng các tập đoàn điện toán đám mây quy mô lớn như Amazon, Apple, Google, Meta và Microsoft có thể chuyển công suất GPU về các nền kinh tế tiên tiến hơn như Mỹ, Nhật Bản hoặc Đài Loan.

Điều này có thể tác động nghiêm trọng đến các nước như Thái Lan, Indonesia và Việt Nam – những nơi đang thúc đẩy phát triển AI và xây dựng trung tâm dữ liệu.

Helen Chiang, trưởng bộ phận nghiên cứu bán dẫn tại IDC Asia/Pacific, cho rằng tình trạng này có thể dẫn đến làn sóng startup rời khỏi Đông Nam Á.

“Việc này sẽ tác động đến sự phát triển AI trong khu vực như thế nào vẫn còn là điều đáng theo dõi,” bà nói với Tech in Asia.

Chips stacked against SEA? New rules may hinder AI boom in region

Confusion over new US AI chip restrictions dampened Southeast Asia’s AI party last month as the industry scrambled to understand what they would mean for the region.

US Executive Order 14141, signed by President Joe Biden in his last week in office, limits the export of high-end AI chips.

The directive could pose serious problems for AI developers as most startups in the region rely on cloud-based AI services powered by these high-end chips.

Southeast Asia’s business hub, Singapore, has recently been included in a US investigation into whether Chinese AI startup DeepSeek purchased advanced Nvidia chips from third parties.

Industry insiders interviewed by Tech in Asia agree that the short-term effect of the new rules will likely be minimal.

Chips already shipped to the region will stay there for now. At the same time, there are questions on whether the Trump administration will retain the restrictions.

There are also concerns about longer-term growth if the rules stay in place. Southeast Asia’s ambitions to become an AI hub will likely slow down. However, this may end up pushing the region into the arms of Chinese chip players.

14141 intact

Most of the industry is currently focused on what President Donald Trump will do. The day he took office, he began to undo many of Biden’s orders. However, Executive Order 14141 remains untouched.

“It’s pretty much impossible to predict what Trump would do, actually,” says an insider who asked not to be named. “He might roll back some of these provisions or he might escalate them even more. He might just use it as bargaining chips.”

Any immediate effect is also likely to be limited because Southeast Asia currently has more than enough capacity to cope with the existing demand for AI services.

Yet, investors and startups in the area still worry about what an escalation in US-China tensions could mean for the region’s AI industry.

Malaysia has invested US$21.7 billion in data centers in the past two years, information from Malaysia Digital Economy Corporation reveals.

Singapore, on the other hand, has pledged to allocate over US$740 million to support AI development in the next five years. In 2019, the city-state declared its goal to become a regional hub for AI development.

Right now, most of the data centers in Southeast Asia are not involved in the development of generative AI models, Matthew Walker, chief analyst at MTN Consulting in Bangkok, tells Tech in Asia.

The development of genAI models is the most computing-intensive part of training a large language model. Most startups in the region are involved in the fine-tuning process, which is less intensive.

“The restrictions will have little immediate effect because AI model development is already based primarily in the US,” Walker explains.

The unnamed insider shares that most of the startups they have talked to are taking a wait-and-see approach and that there’s time before the rules take effect.

The restrictions are currently in a 120-day comment phase, which allows the US Department of Commerce’s Bureau of Industry and Security to alter them if necessary. Nvidia has officially opposed the rules.

“No one’s making big moves yet, but they’re already talking about it,” the insider says.

Under the new restrictions, US-headquartered AI companies offering cloud services are required to keep half of their computing power in the country. Another 25% is allowed to be deployed to US close allies. This group is called Tier 1.

Of the firms’ remaining computing power, 7% can be deployed to most other countries that belong to Tier 2. This group, which includes every major country in Southeast Asia, faces much stricter regulations.

Meanwhile, the rules prevent the sale or transfer of high-end AI chips to the 22 countries listed under Tier 3.

Many exceptions

There are, as is common with executive orders, lots of exemptions. Companies based outside the US can buy and hold chips that exceed these caps if they get the National Verified End User status.

The insiders interviewed by Tech in Asia note that the details of these exemptions haven’t been announced yet. However, one rule appears particularly clear: no dealings with Russian, North Korean, or Chinese companies.

Yet, these insiders also note that while the rules might slow down or force out Chinese startups from Southeast Asia’s AI cloud servers, they probably wouldn’t stop the illegal transfer of chips to these firms.

An unintended consequence is that Southeast Asian firms may chafe at the restrictions and decide to use Chinese training models and chips instead.

That’s something the US wants to avoid as it wants startups to rely on American technologies, according to Alex Yeh, co-founder and CEO of GMI Cloud, a US-headquartered AI cloud service provider with data centers in Malaysia, Thailand, and Taiwan.

He warns that if the restrictions force companies to adopt Chinese tech, it will just allow Chinese players to grow faster and be more independent.

Analysts expect that China will likely use the restrictions as an opportunity to increase its tech presence in the region.

When too much is not enough

For now, stakeholders in Malaysia’s and Singapore’s AI industries think they already have enough AI-grade computing capacity in their countries to weather any US restrictions.

The unnamed insider tells Tech in Asia that the existing and upcoming centers in these countries were built to have excess capacity and handle growing demand.

“As of now, the amount of computing demand within Malaysia, within Singapore, is far, far, far less than what’s been built,” the insider adds. They don’t expect the region to reach its current maximum capacity for at least 10 years.

Not everyone agrees, however.

GMI Cloud’s Yeh thinks the restrictions could begin to have an impact in as little as one year. His company works closely with Nvidia and is part of the tech giant’s partner network.

Yeh says companies that fail to comply with the rules and are facing restrictions will struggle when the new generation of Nvidia chips, which are estimated to be 3x or 5x faster than what it currently offers, hit the market.

“So people will be able to spend the same amount of money and get 5x things done faster than you,” he explains.

He also anticipates that hyperscalers – including Amazon, Apple, Google, Meta, and Microsoft – could move their GPU capacity to more advanced economies.

Hyperscalers may bring their chips back to the US, Japan, or Taiwan. But these chips are unlikely to be replaced, thereby reducing the region’s computing capacity.

This scenario could also have a serious effect on countries like Thailand, Indonesia, and Vietnam. All three have been pushing to develop AI and bring in data centers. If hyperscalers are pulling back, it could mean they are reconsidering their expansion plans in these countries.

Helen Chiang, head of semiconductor research at IDC Asia/Pacific, points out that this could lead to an exodus of startups from Southeast Asia.

She says if firms based in the region – which are aggressively developing AI – need to get US approval to get access to chips, they may think it’s more efficient to move to a Tier 1 country and set up headquarters there.

“How this will impact local AI development is worth watching,” she tells Tech in Asia.

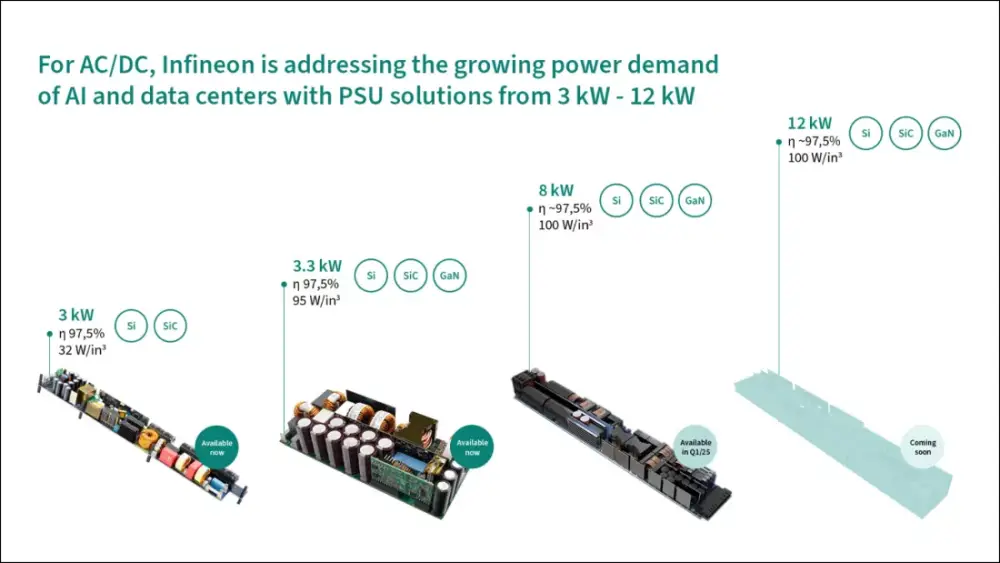

Công ty phát triển trung tâm dữ liệu DataVolt của Ả Rập Saudi đầu tư 5 tỷ USD xây dựng khuôn viên trung tâm dữ liệu AI phát thải ròng bằng 0 tại Neom

Dự án nằm trong khu công nghiệp Oxagon thuộc Neom - thành phố tương lai ở phía bắc Biển Đỏ

Neom là một phần của Tầm nhìn 2030 của Ả Rập Saudi nhằm đa dạng hóa nền kinh tế, giảm phụ thuộc vào doanh thu từ nhiên liệu hóa thạch

Công suất mục tiêu của cơ sở là 1,5 GW, hoàn toàn được cung cấp từ nguồn năng lượng tái tạo

Giai đoạn đầu tiên với khoản đầu tư 5 tỷ USD dự kiến hoàn thành vào năm 2028

Oxagon sẽ có quyền tiếp cận các nguồn năng lượng tái tạo cạnh tranh về chi phí, bao gồm hydro xanh và kết nối cáp quang dưới biển

Trung tâm dữ liệu được thiết kế để hỗ trợ khối lượng công việc AI bằng cách tích hợp nhiều mật độ điện toán và kiến trúc tiết kiệm năng lượng

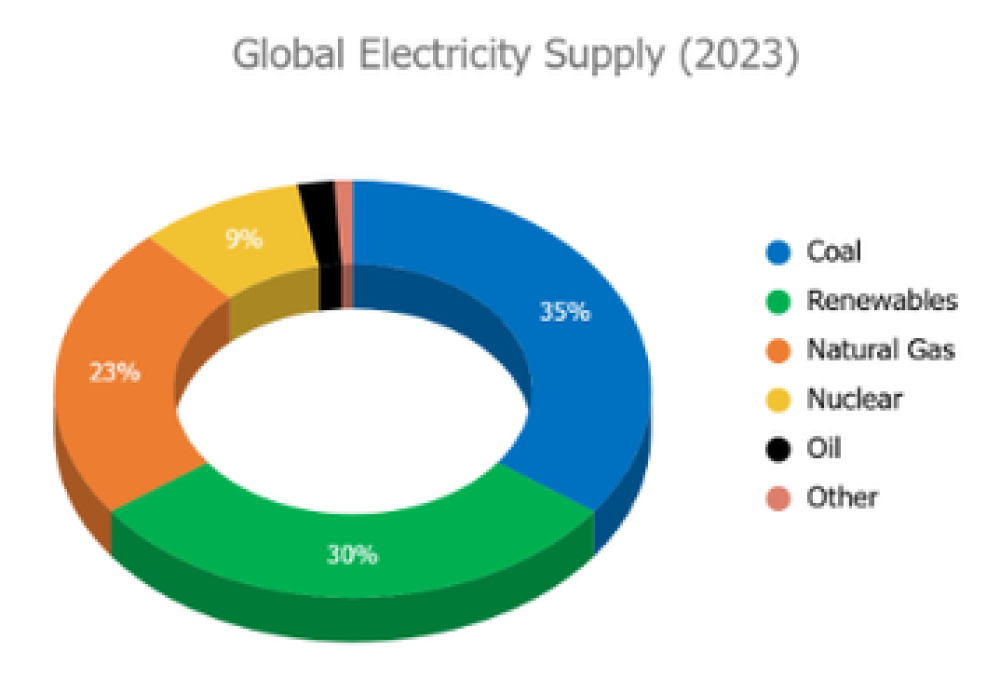

Các trung tâm dữ liệu hiện tiêu thụ khoảng 1-2% điện năng toàn cầu

Để đạt được mục tiêu phát thải ròng bằng 0, cần xem xét toàn bộ vòng đời của trung tâm dữ liệu:

Lựa chọn vật liệu phát thải carbon thấp

Áp dụng thiết kế dễ nâng cấp

Áp dụng chiến lược tái chế và tái sử dụng để giảm thiểu chất thải

Các phương pháp cách mạng bao gồm:

Sử dụng pin quy mô tiện ích để lưu trữ năng lượng tái tạo

Áp dụng pin nhiên liệu hydro

📌 Ả Rập Saudi đầu tư 5 tỷ USD vào trung tâm dữ liệu AI tại Neom với công suất 1,5 GW hoàn toàn từ năng lượng tái tạo. Dự án dự kiến hoàn thành năm 2028, đánh dấu bước tiến quan trọng trong việc xây dựng cơ sở hạ tầng điện toán hiệu năng cao bền vững.

https://www.datacenterknowledge.com/sustainability/net-zero-ai-data-center-project-gets-a-5b-boost-in-saudi-arabia

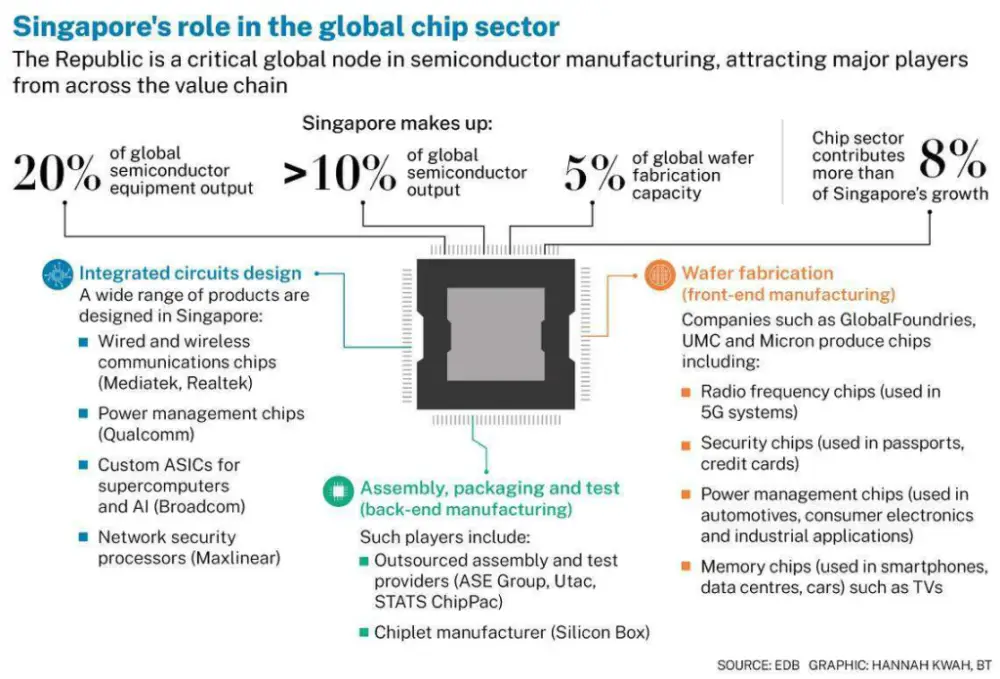

- Singapore chỉ chiếm chưa đến 1% tổng doanh thu của Nvidia trong quý kết thúc vào tháng 10/2024, theo chia sẻ của Bộ trưởng thứ hai về Thương mại và Công nghiệp Tan See Leng

- Mặc dù Nvidia ghi nhận 22% doanh số bán hàng từ Singapore trong giai đoạn tháng 8-10/2024, nhưng đây chỉ là nơi khách hàng của Nvidia nhận hóa đơn

- Chính quyền Mỹ đang điều tra liệu DeepSeek, startup AI của Trung Quốc, có mua chip Nvidia cao cấp thông qua bên thứ ba tại Singapore để vượt qua hạn chế của Washington

- DeepSeek gần đây đã ra mắt chatbot R1, có hiệu suất tương đương với các công cụ của Mỹ, cho thấy Trung Quốc đang tiến xa hơn dự kiến trong cuộc đua AI

- Nvidia đã chỉ ra rằng họ không nghĩ DeepSeek vi phạm kiểm soát xuất khẩu

- Singapore khẳng định hải quan nước này làm việc chặt chẽ với các đối tác nước ngoài, bao gồm Mỹ, để hỗ trợ điều tra khi cần thiết

- Chính phủ Singapore tuyên bố không dung túng các doanh nghiệp lợi dụng quan hệ với Singapore để phá vỡ kiểm soát xuất khẩu của các nước khác

📌 Singapore chỉ chiếm dưới 1% doanh thu Nvidia, mặc dù 22% doanh số được ghi nhận tại đây do tập trung hóa đơn. Trong khi đó, chatbot R1 của DeepSeek đạt hiệu suất ngang với công cụ của Mỹ, khiến Washington lo ngại về việc tiếp cận chip AI cao cấp của Trung Quốc.

https://fortune.com/asia/2025/02/18/singapore-buys-small-amount-nvidia-chips-official-says/

- CEO Mistral Arthur Mensch kêu gọi châu Âu tăng cường đầu tư vào cơ sở hạ tầng AI tại hội nghị Visionaries Unplugged ở Paris

- Nhiều nhà lãnh đạo công nghệ hàng đầu tham dự hội nghị như:

+ Demis Hassabis - nhà sáng lập DeepMind

+ Reid Hoffman - đồng sáng lập LinkedIn

+ Dario Amodei - nhà sáng lập Anthropic

+ Eric Schmidt - cựu CEO Google

- Eric Schmidt nhận định tham vọng của châu Âu không thua kém Mỹ, vấn đề nằm ở cơ cấu chứ không phải nhân tài

- Tỷ phú công nghệ Pháp Xavier Niel cảnh báo:

+ Các mô hình AI từ Mỹ và Trung Quốc không phù hợp với lối sống châu Âu

+ Công ty viễn thông Iliad của ông cam kết đầu tư 3 tỷ euro phát triển AI tại Pháp

- Các nhà sáng lập và nhà đầu tư kêu gọi quy định AI ở châu Âu cần:

+ Đủ linh hoạt để hỗ trợ đổi mới

+ Tăng cường khả năng cạnh tranh

- EU đang thúc đẩy Luật AI:

+ Có hiệu lực từ năm ngoái

+ Thiết lập quy tắc quản lý AI dựa trên mức độ rủi ro

+ Đảm bảo triển khai công nghệ an toàn, minh bạch và đạo đức

- Phó tổng thống Mỹ JD Vance chỉ trích nỗ lực quản lý AI của EU tại Hội nghị thượng đỉnh AI ở Paris, khẳng định chính quyền Trump sẽ không chấp nhận các chính phủ nước ngoài "siết chặt" các công ty công nghệ Mỹ

📌 Châu Âu đang đối mặt với nguy cơ tụt hậu trong cuộc đua AI toàn cầu. Trong khi EU áp đặt quy định chặt chẽ, Mỹ nới lỏng bảo vệ AI và trao quyền cho các lãnh đạo công nghệ. Khoản đầu tư 3 tỷ euro của Iliad là động thái quan trọng nhằm thúc đẩy phát triển AI tại châu Âu.

https://thenextweb.com/news/mistral-ceo-wants-europe-to-own-ai-infrastructure

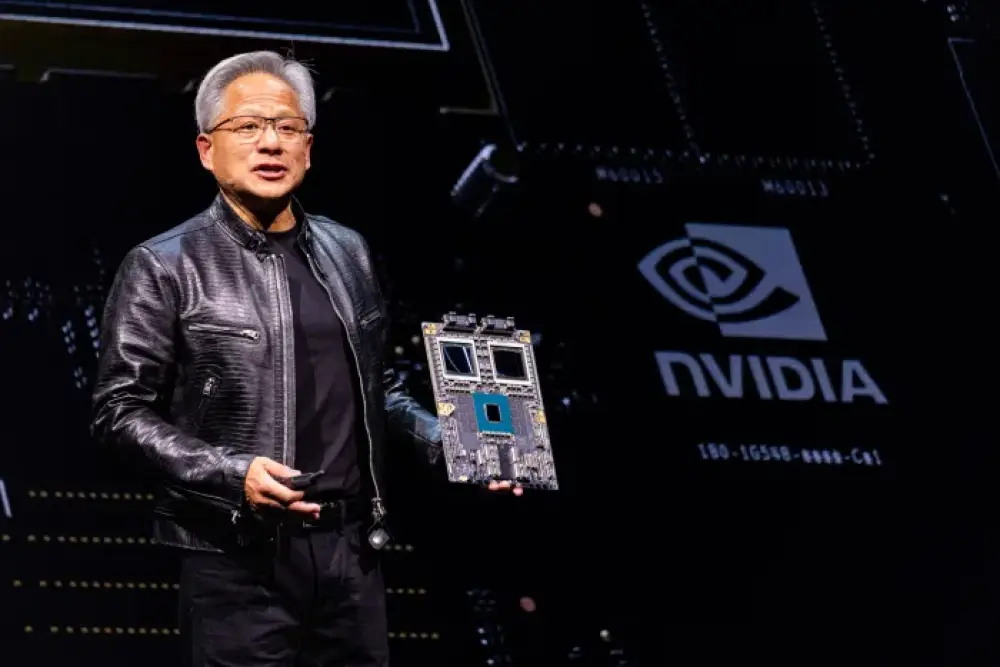

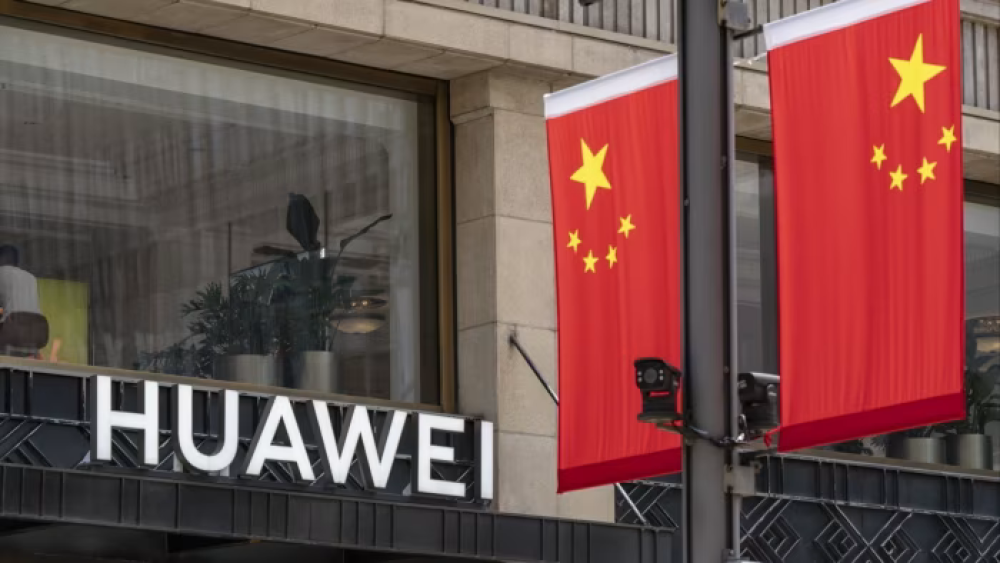

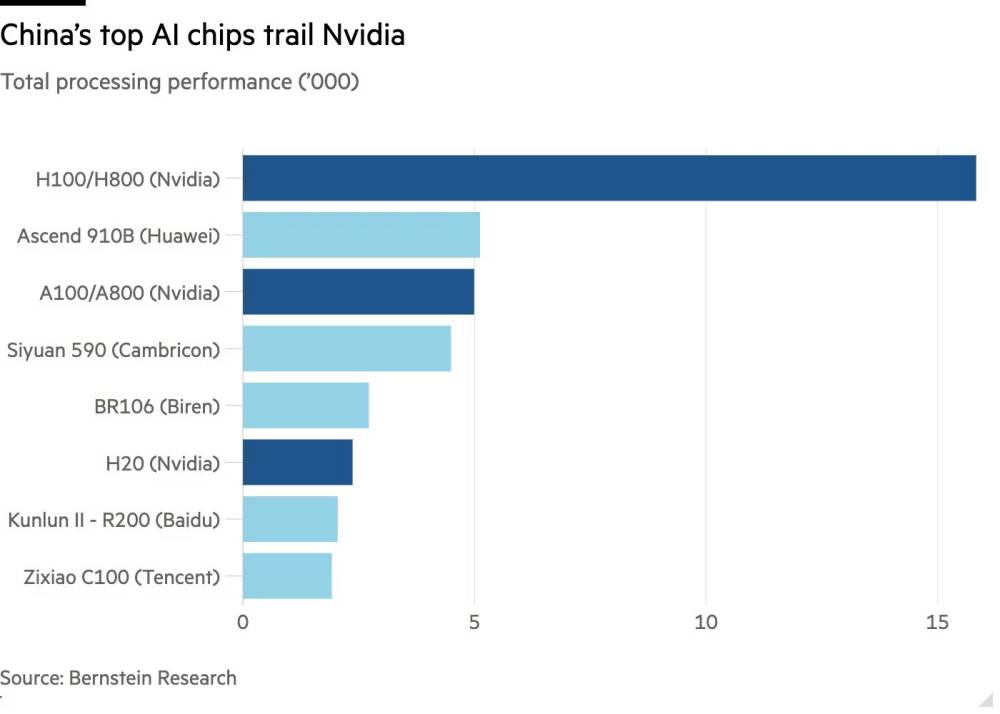

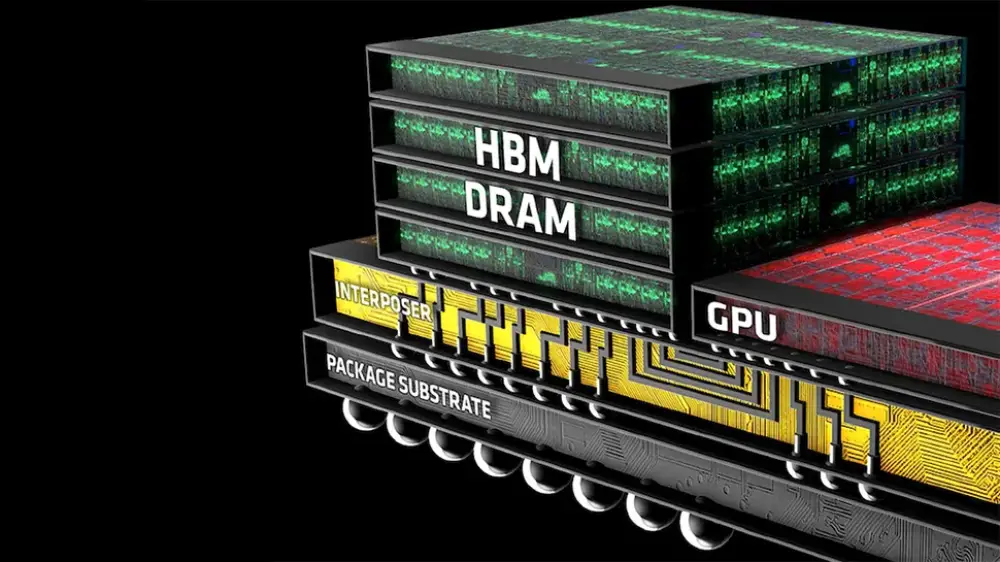

- DeepSeek đang tạo cơ hội cho các nhà sản xuất chip Trung Quốc như Huawei cạnh tranh tốt hơn trong thị trường nội địa với các bộ xử lý của Mỹ

- Mô hình DeepSeek tập trung vào "suy luận" - giai đoạn AI đưa ra kết luận, thay vì chỉ dựa vào sức mạnh xử lý thuần túy

Nhiều công ty chip AI Trung Quốc đã công bố hỗ trợ mô hình DeepSeek:

- Huawei

- Hygon

- EnFlame (được Tencent hậu thuẫn)

- Tsingmicro

- Moore Threads

Chip Ascend 910B của Huawei được ByteDance đánh giá phù hợp với các tác vụ "suy luận" đòi hỏi ít tính toán

- Hàng chục công ty Trung Quốc từ ô tô đến viễn thông đã lên kế hoạch tích hợp mô hình DeepSeek

Chip AI Trung Quốc có lợi thế cạnh tranh về giá trong thị trường nội địa, tuy nhiên:

- Chỉ giới hạn ở thị trường Trung Quốc

- Nvidia vẫn vượt trội cả trong tác vụ suy luận

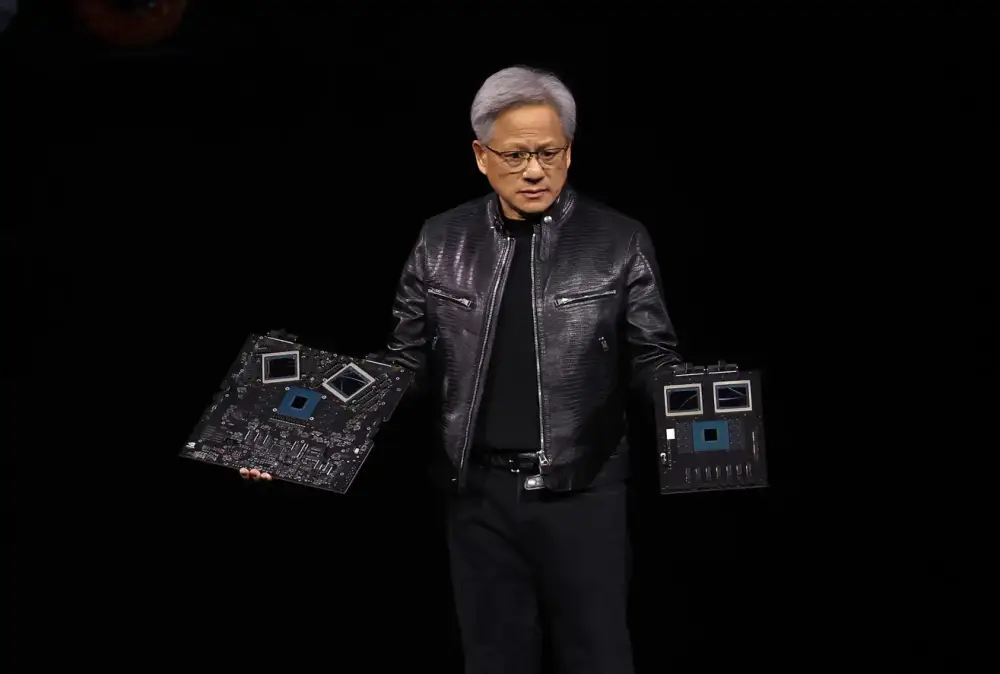

Nvidia vẫn duy trì ưu thế nhờ:

- Được phép bán chip training ít mạnh hơn vào Trung Quốc

- Nền tảng CUDA giúp lập trình viên tận dụng GPU cho điện toán đa mục đích

- Thư viện phong phú và khả năng phần mềm đa dạng

- Huawei đang nỗ lực cạnh tranh với CUDA thông qua kiến trúc CANN (Compute Architecture for Neural Networks) nhưng gặp khó khăn trong việc thuyết phục các nhà phát triển

📌 DeepSeek đang mở ra cơ hội cho ngành công nghiệp chip AI Trung Quốc thông qua tối ưu hóa suy luận, tuy nhiên Nvidia vẫn dẫn đầu nhờ ưu thế về phần mềm CUDA và thư viện phong phú. Các công ty như Huawei đang tích cực phát triển giải pháp thay thế như CANN để giảm phụ thuộc vào công nghệ Mỹ.

https://www.reuters.com/technology/artificial-intelligence/deepseek-gives-chinas-chipmakers-leg-up-race-cheaper-ai-2025-02-13/

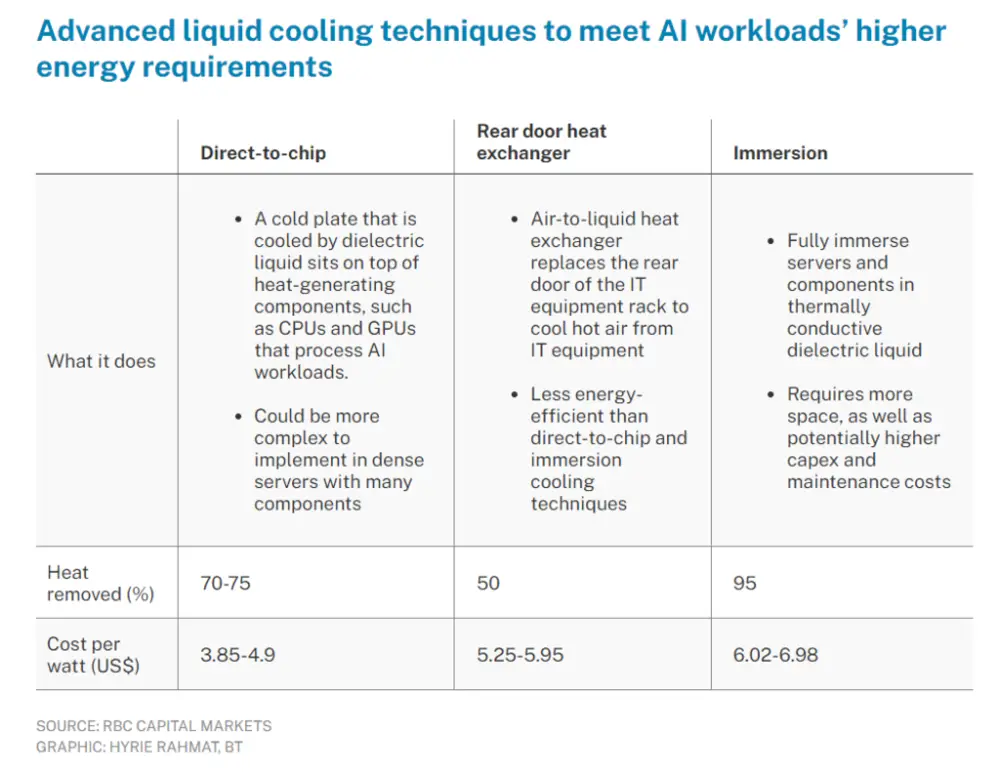

- AI đang tạo ra thách thức lớn về bền vững do khối lượng công việc tiêu tốn nhiều năng lượng, tuy nhiên cũng mang lại tiềm năng cải thiện hiệu quả hoạt động

- Orange Poland áp dụng AI để tối ưu hóa ăng-ten 5G, giúp giảm 20-25% lượng điện tiêu thụ trong cơ sở hạ tầng mạng

- So với tìm kiếm Google thông thường, một truy vấn AI tạo sinh thải ra lượng khí CO2 cao hơn 100%

- T-Mobile US đang quản lý khoảng 100 trung tâm dữ liệu, phải cân bằng giữa chi phí, công suất, kiểm soát khí thải và rủi ro vận hành

- Tại Ireland, các trung tâm dữ liệu tiêu thụ hơn 20% tổng điện năng của cả nước, dẫn đến lệnh cấm xây mới gần Dublin đến năm 2028

- T-Mobile US phát hiện 40-50% CPU hoạt động không hiệu quả, lãng phí năng lượng khi không thực hiện công việc

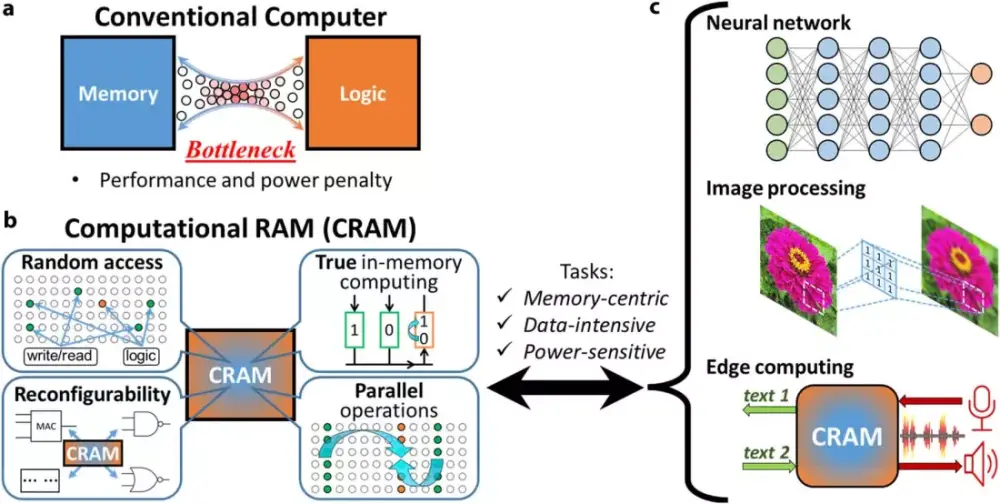

- Bộ nhớ chiếm khoảng 20% điện năng tiêu thụ trong trung tâm dữ liệu

Các giải pháp được đề xuất:

+ Chỉ sử dụng AI khi thực sự cần thiết

+ Tối ưu hóa hiệu suất tính toán

+ Điều phối khối lượng công việc thông minh hơn

+ Hiện đại hóa thiết bị để tăng hiệu quả năng lượng

+ Áp dụng các khái niệm kinh tế tuần hoàn

📌 Trung tâm dữ liệu đang đối mặt với áp lực kép từ nhu cầu tính toán AI và giới hạn nguồn điện. Một truy vấn AI tạo sinh thải CO2 gấp đôi tìm kiếm thông thường. Ireland phải cấm xây mới trung tâm dữ liệu do tiêu thụ 20% điện toàn quốc.

https://www.rcrwireless.com/20250106/fundamentals/ai-data-centers

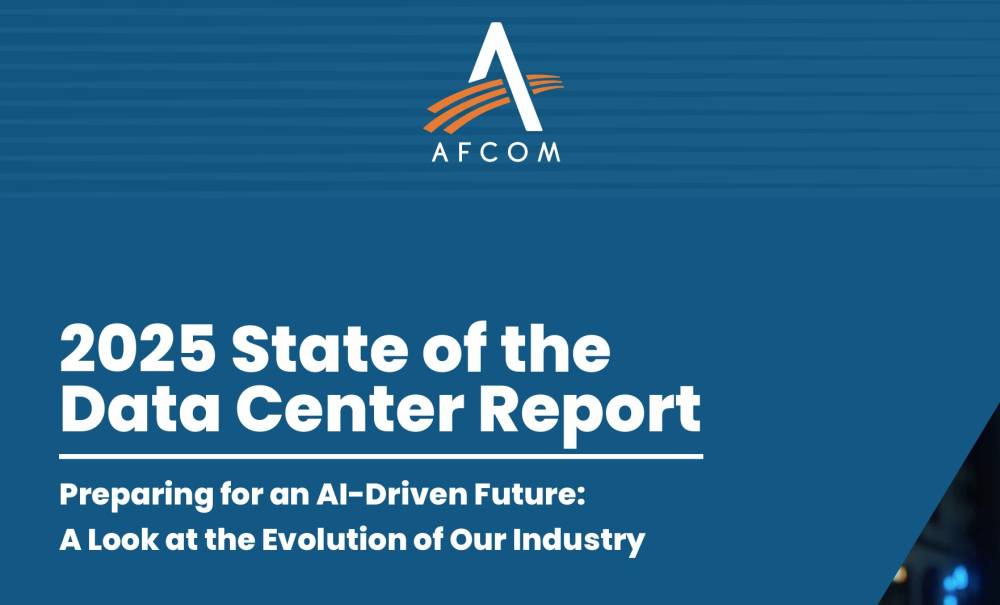

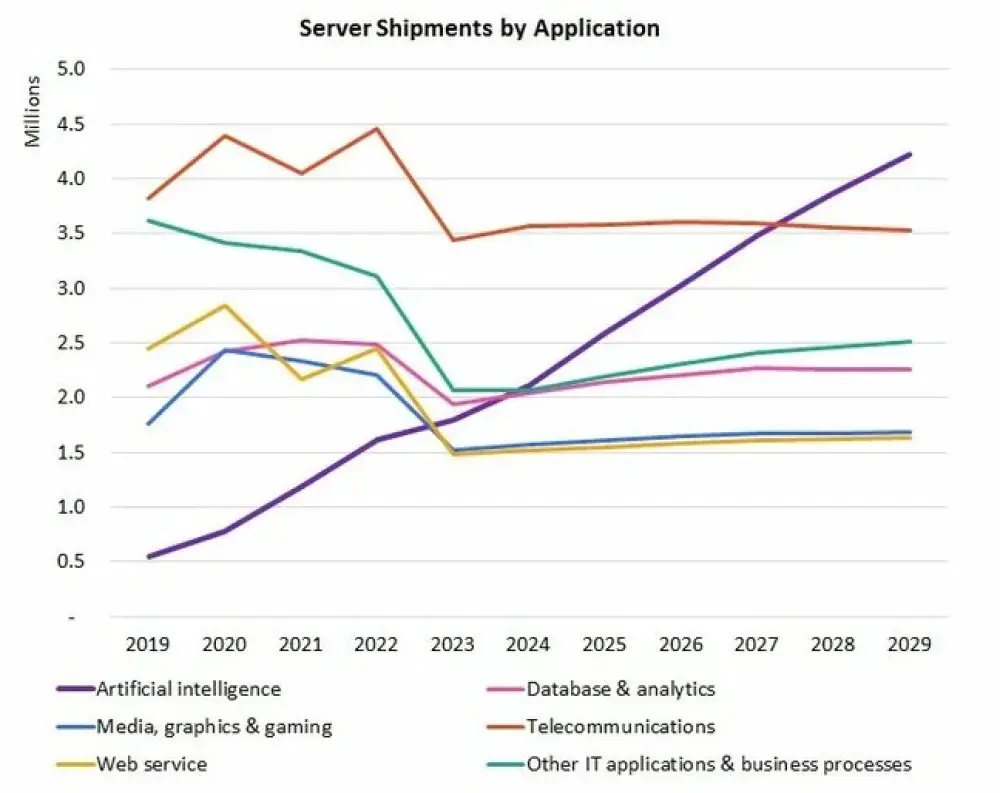

- Khảo sát cho thấy 80% người tham gia dự đoán nhu cầu năng lực xử lý sẽ tăng mạnh do khối lượng công việc AI, trong khi 64% đang triển khai các giải pháp hỗ trợ AI

- Số lượng trung tâm dữ liệu sẽ tăng từ trung bình 1 lên 6 trong 3 năm tới, quy mô trung bình mỗi cơ sở là 32 Megawatt

- Năng lượng hạt nhân đang trở thành xu hướng mới với 33% người được hỏi coi đây là nguồn năng lượng tái tạo quan trọng, tăng 12% so với 2024. Năng lượng mặt trời vẫn dẫn đầu với 55%

Các mối đe dọa an ninh hàng đầu bao gồm:

- Ransomware: 60% (tăng từ 54% năm 2024)

- Mối đe dọa từ con người: 57% (tăng từ 40%)

- Tấn công có chủ đích vào IT: 48%

- Tấn công DDoS: 47% (tăng từ 25%)

- Rò rỉ dữ liệu: 43% (tăng từ 28%)

- 78% báo cáo có thay đổi về yêu cầu an ninh vật lý trong 12-24 tháng qua:

- 48% tăng cường giám sát và theo dõi

- 38% nâng cao quy trình kiểm tra nhà cung cấp

Nhu cầu nhân sự cao cấp tập trung vào:

- Vận hành đa kỹ năng: 58%

- Kỹ sư trung tâm dữ liệu: 50% (tăng từ 45%)

- Chuyên gia bảo mật: 44% (tăng từ 39%)

📌 Trung tâm dữ liệu đang chuyển mình mạnh mẽ với 80% dự kiến tăng công suất cho AI. Năng lượng hạt nhân tăng 12%, ransomware vẫn là mối đe dọa hàng đầu (60%). Số lượng trung tâm dữ liệu sẽ tăng gấp 6 lần trong 3 năm tới, kèm theo nhu cầu cao về nhân sự đa kỹ năng.

https://datacenterworld.com/press-releases/2025-state-of-the-data-center-industry-report

- Robin Li, CEO Baidu phát biểu tại Hội nghị thượng đỉnh chính phủ thế giới ở Dubai ngày 11/2/2025, nhấn mạnh việc đầu tư vào trung tâm dữ liệu và cơ sở hạ tầng đám mây vẫn rất cần thiết

- DeepSeek, một startup AI của Trung Quốc, gần đây gây chú ý khi phát triển các mô hình ngôn ngữ có hiệu suất tương đương với các hệ thống hàng đầu như OpenAI's GPT nhưng sử dụng ít năng lực tính toán hơn đáng kể

- Baidu là một trong những công ty Trung Quốc đầu tiên ra mắt sản phẩm AI sau khi ChatGPT được phát hành cuối năm 2022. Tuy nhiên, mô hình ngôn ngữ lớn Ernie của công ty, được cho là có khả năng tương đương GPT-4, chưa được người dùng đón nhận rộng rãi

- Trước đây, Li từng tuyên bố mạnh mẽ rằng khó có thể xuất hiện một công ty như OpenAI từ Trung Quốc và ủng hộ mô hình đóng là con đường duy nhất khả thi cho phát triển AI

- Tại hội nghị, Li thừa nhận sự xuất hiện bất ngờ của DeepSeek cho thấy bản chất khó đoán của đổi mới công nghệ

- Các hạn chế về năng lực tính toán đã thúc đẩy các công ty Trung Quốc đổi mới để giảm chi phí

- Li cũng thay đổi quan điểm về phát triển nguồn đóng, giờ đây công nhận cách tiếp cận nguồn mở có thể thúc đẩy việc áp dụng AI nhanh hơn

📌 Từ chỗ ủng hộ mạnh mẽ mô hình đóng, CEO Baidu Robin Li đã thay đổi quan điểm về AI nguồn mở sau thành công của DeepSeek. Mặc dù vậy, ông vẫn khẳng định cần tiếp tục đầu tư lớn vào cơ sở hạ tầng để phát triển các mô hình AI vượt trội.

https://www.reuters.com/technology/baidu-ceo-says-more-ai-spend-still-needed-despite-deepseeks-success-2025-02-11/

- Tổng thống Pháp Emmanuel Macron công bố thỏa thuận trị giá 30-50 tỷ euro với UAE để xây dựng khuôn viên AI và trung tâm dữ liệu tại Pháp

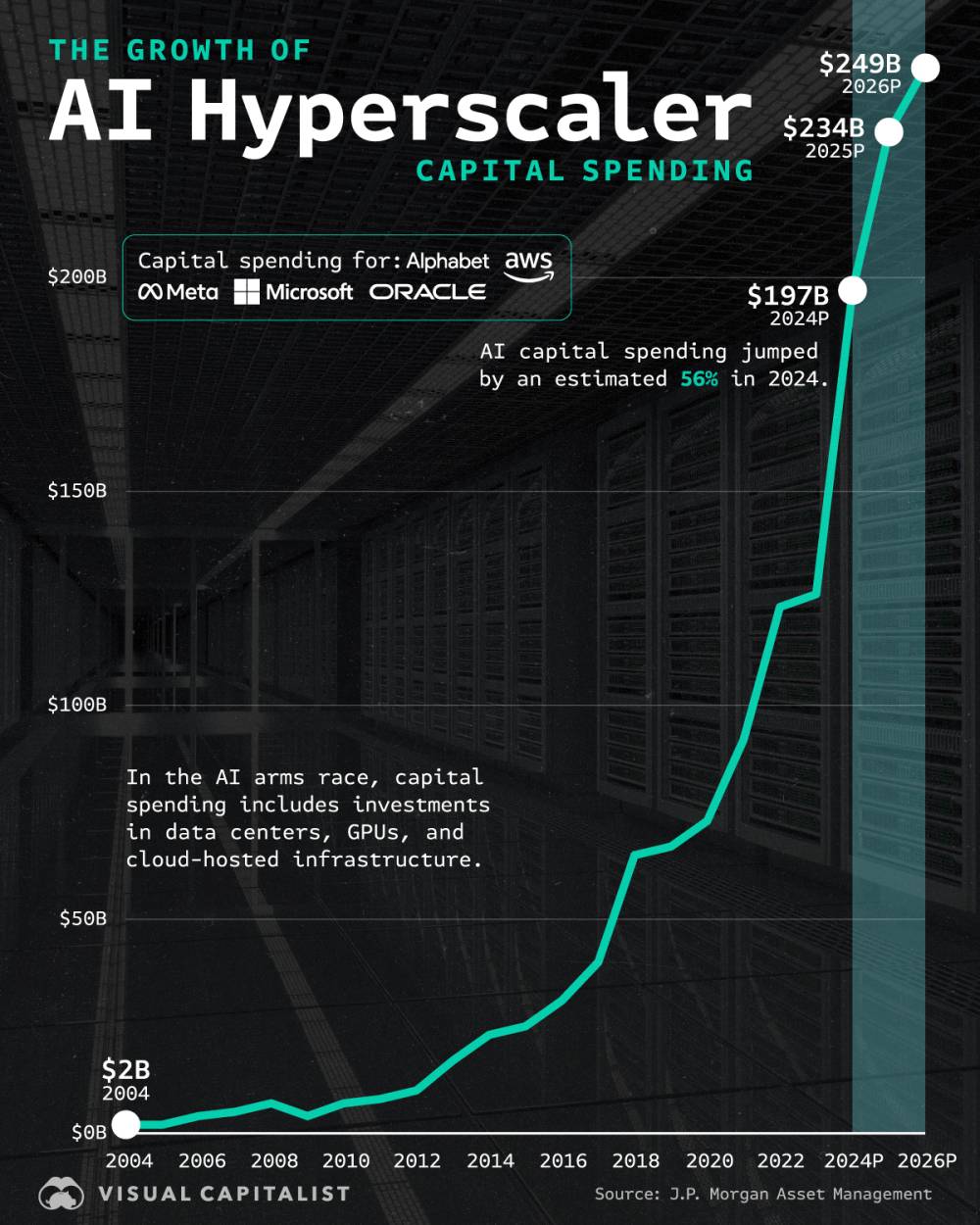

- Tổng thống Mỹ Donald Trump đã công bố dự án Stargate trị giá 500 tỷ USD để đầu tư vào hạ tầng AI, tuyên bố đây là dự án AI lớn nhất lịch sử

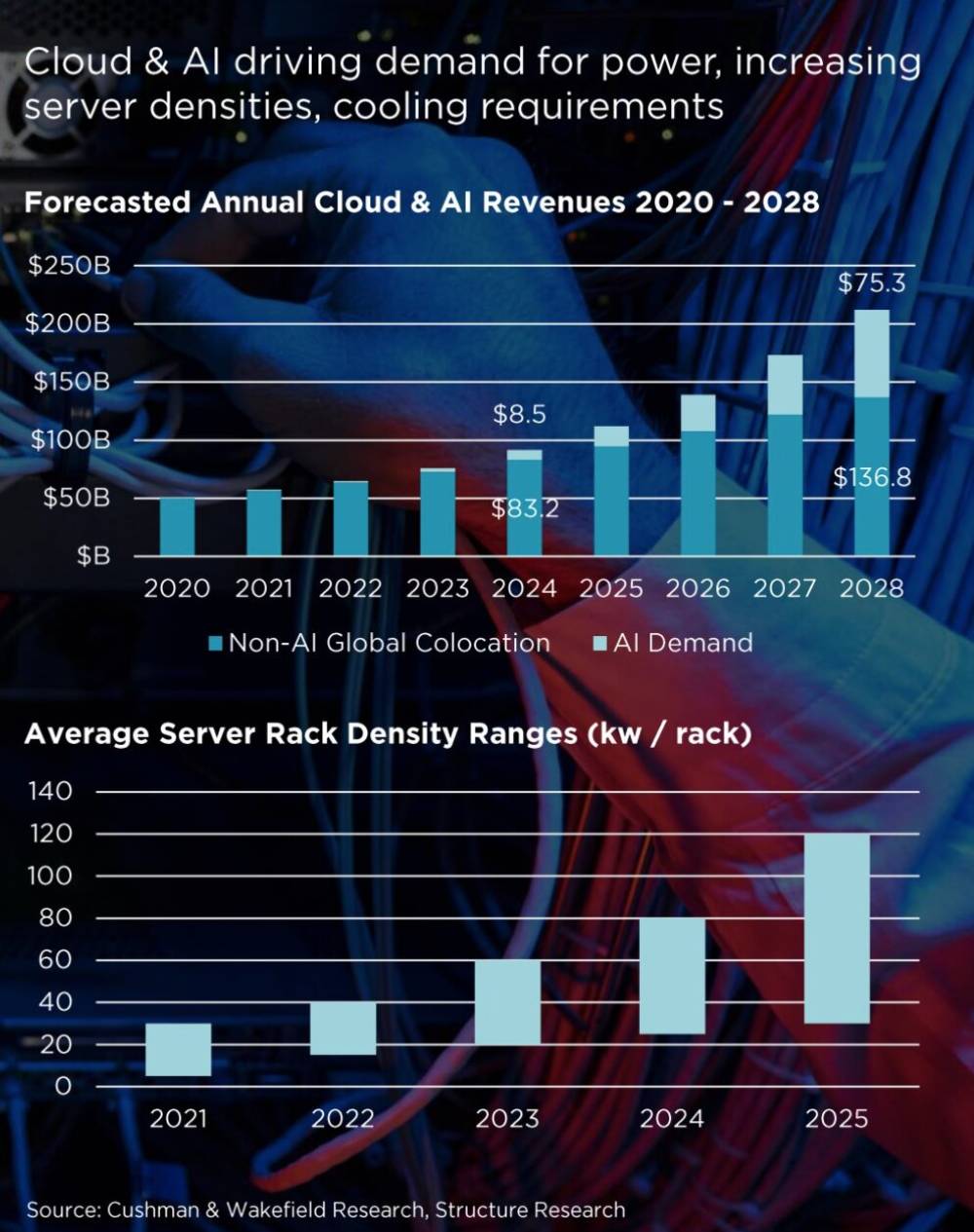

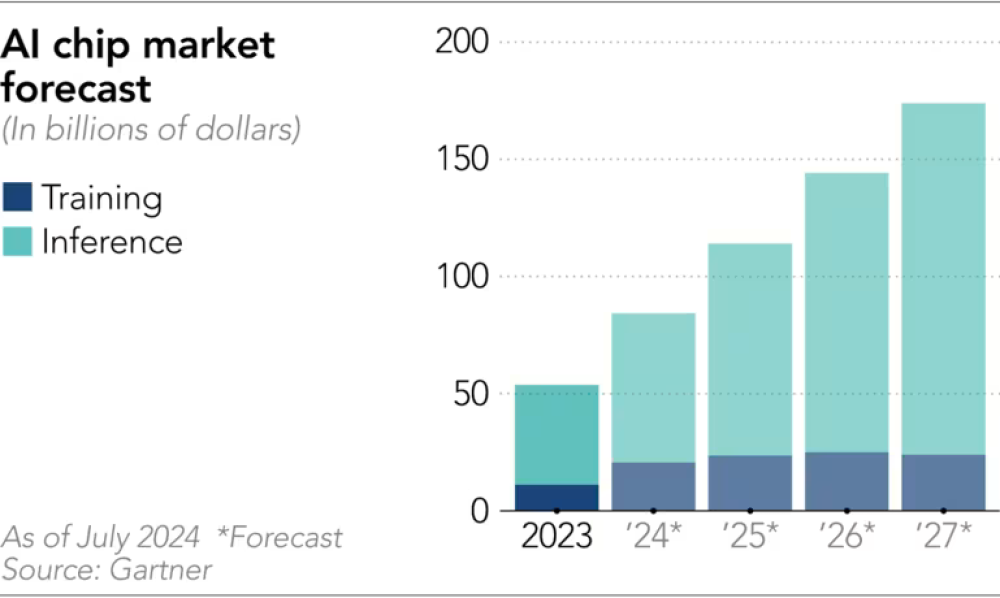

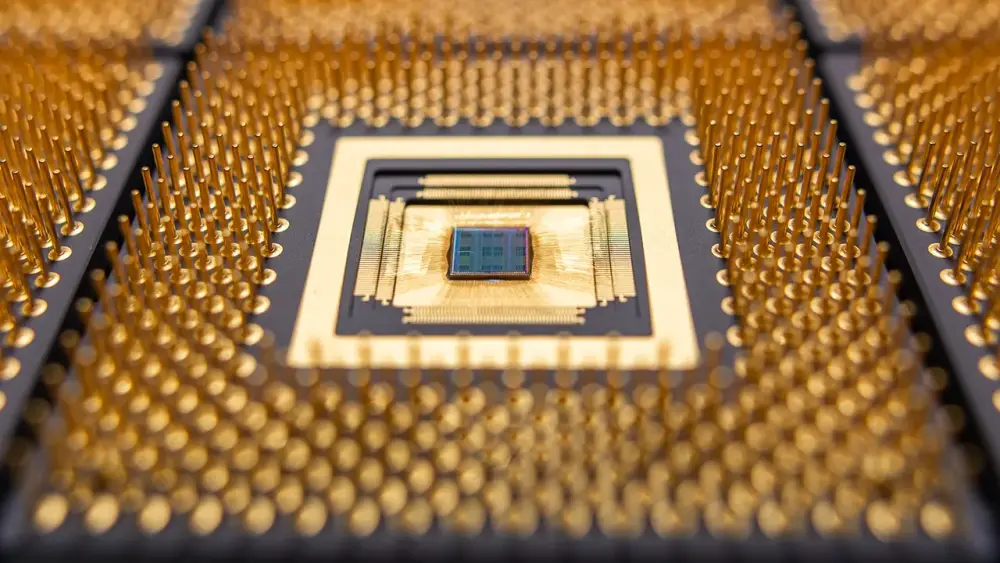

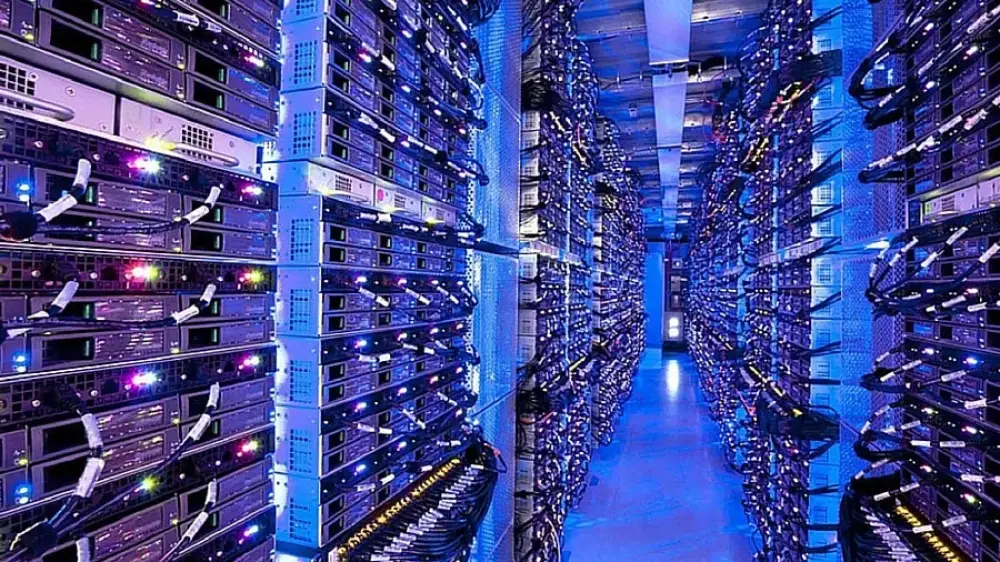

- Các chatbot như ChatGPT cần rất nhiều GPU (card đồ họa) để xử lý hàng triệu truy vấn mỗi ngày, đòi hỏi phải tập trung tại các trung tâm dữ liệu lớn

- Goldman Sachs dự báo nhu cầu điện toán cho chatbot của OpenAI, Meta và Anthropic sẽ tăng 160% từ nay đến năm 2026

- Các trung tâm dữ liệu hiện tại chưa sẵn sàng cho AI vì thiếu hạ tầng điện và hệ thống làm mát cần thiết

- Theo Cơ quan Năng lượng Quốc tế, đến năm 2030 nhu cầu điện của các trung tâm dữ liệu sẽ tương đương mức tiêu thụ hiện tại của Mỹ và EU cộng lại

- Châu Âu đang tụt hậu trong cuộc đua trung tâm dữ liệu, phần lớn các trung tâm tại châu Âu thuộc sở hữu của các tập đoàn Mỹ như Microsoft

- Việc xây dựng trung tâm dữ liệu gây tác động lớn đến môi trường do tiêu thụ nhiều điện năng và nước làm mát

- DeepSeek của Trung Quốc chứng minh có thể phát triển chatbot hiệu quả với ít năng lượng tính toán hơn nhiều so với đối thủ Mỹ

📌 Cuộc đua hạ tầng AI toàn cầu đang nóng lên với các khoản đầu tư khổng lồ: 500 tỷ USD từ Mỹ và 30-50 tỷ euro từ liên minh Pháp-UAE. Tuy nhiên, thách thức về môi trường và tiêu thụ năng lượng đặt ra câu hỏi về tính bền vững của mô hình phát triển này.

https://www.france24.com/en/technology/20250210-the-global-race-to-build-ai-computing-infrastructure

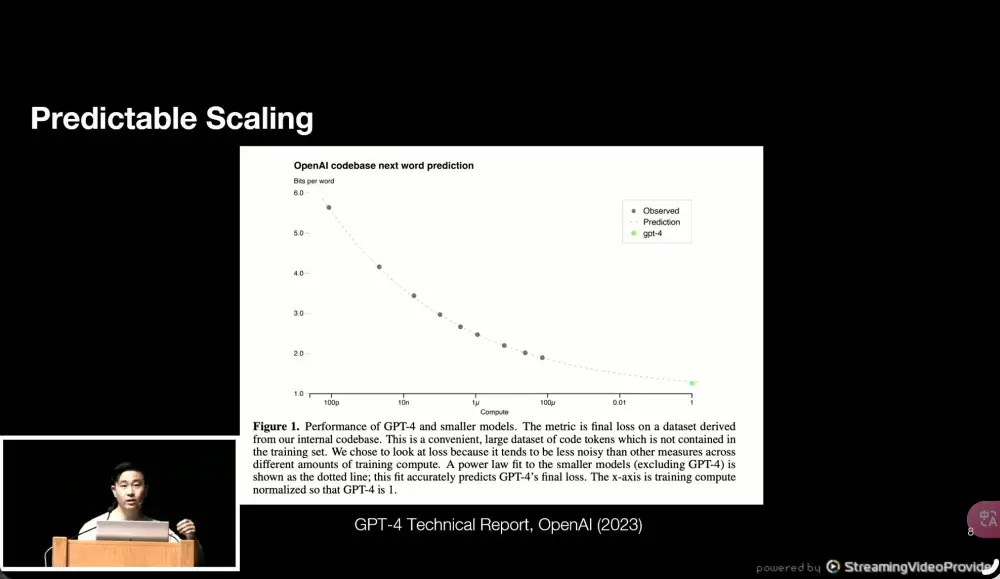

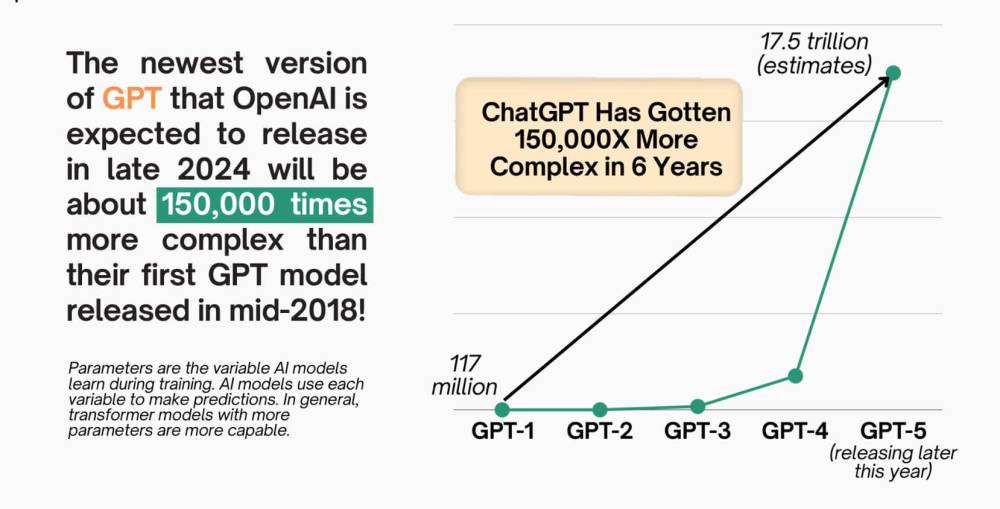

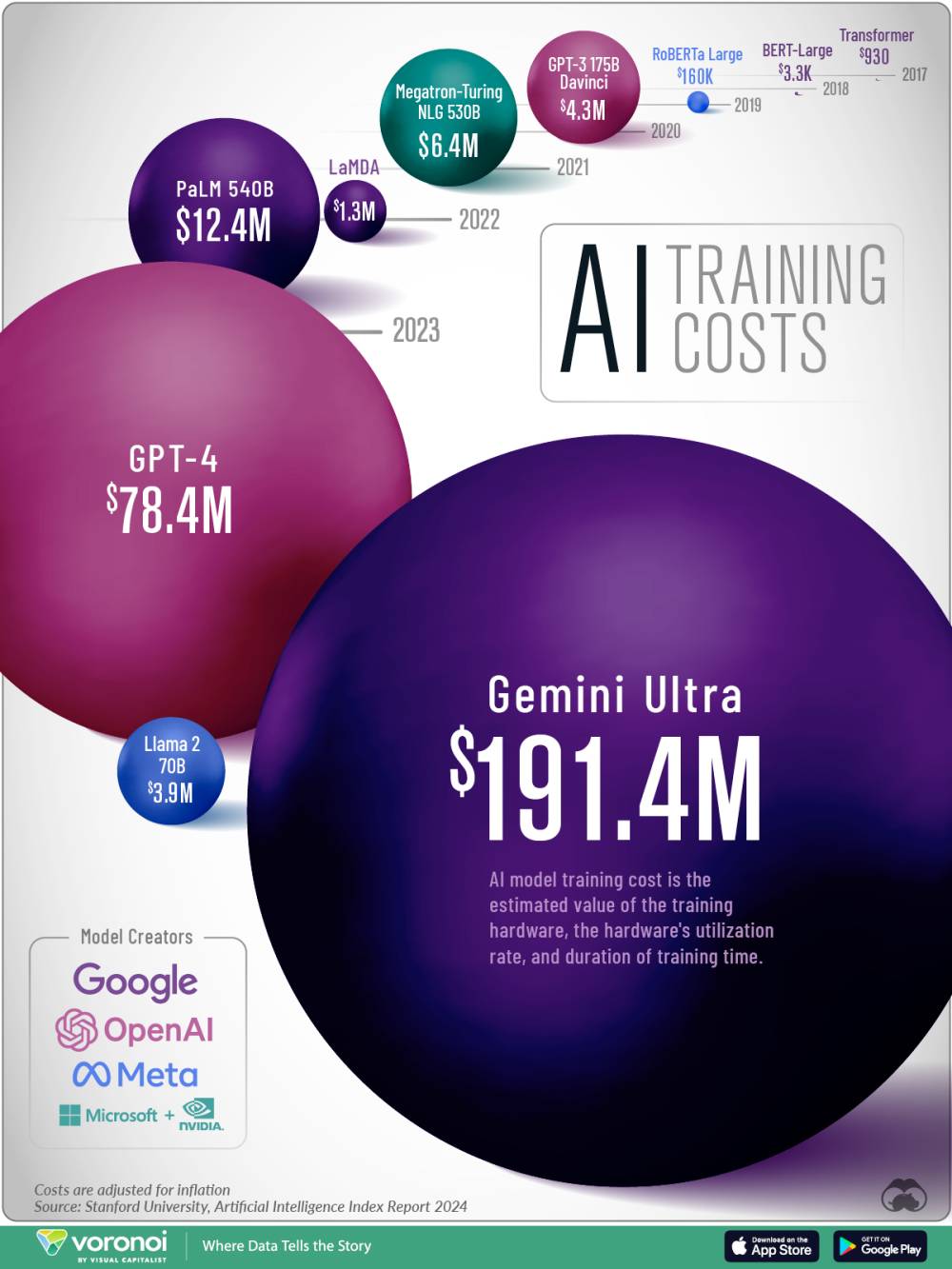

3 xu hướng chính trong phát triển AI:

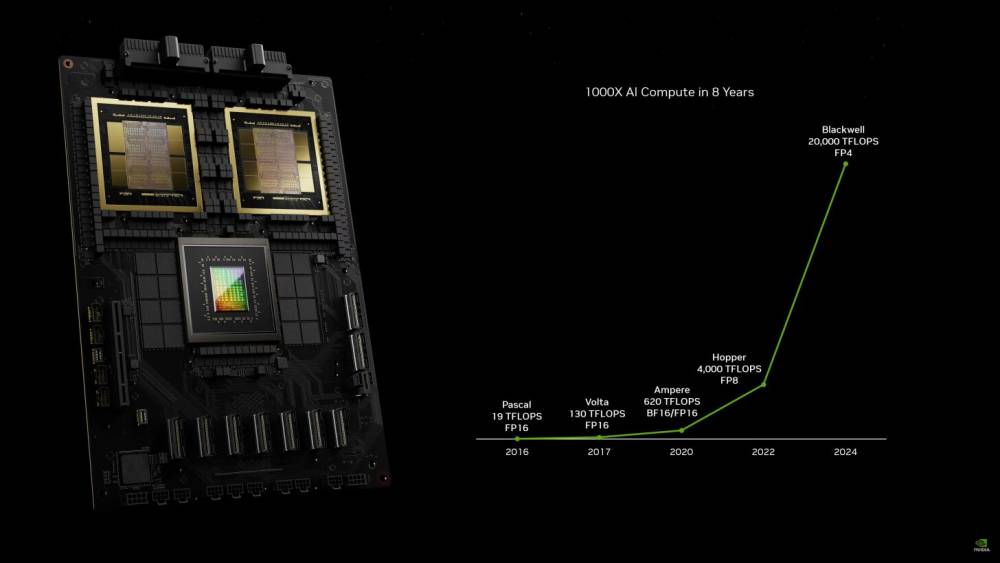

- Quy luật mở rộng quy mô: Chi phí huấn luyện tăng sẽ cải thiện khả năng nhận thức của AI. Ví dụ: mô hình 1 triệu USD giải được 20% bài toán lập trình, 10 triệu USD giải được 40%

- Đường cong chi phí giảm khoảng 4x mỗi năm nhờ cải tiến về kiến trúc, phần cứng và hiệu quả vận hành

- Chuyển đổi mô hình huấn luyện: Từ 2020-2023 tập trung vào mô hình được huấn luyện trước, 2024 chuyển sang học tăng cường (RL) để tạo chuỗi suy luận

Về DeepSeek:

- DeepSeek-V3 là mô hình được huấn luyện với chi phí 6 triệu USD, đạt hiệu suất gần với các mô hình hàng đầu của Mỹ

- Công ty sở hữu khoảng 50.000 chip Hopper trị giá khoảng 1 tỷ USD

- Mô hình R1 được phát hành sau đó sử dụng học tăng cường, tương tự như mô hình o1 của OpenAI

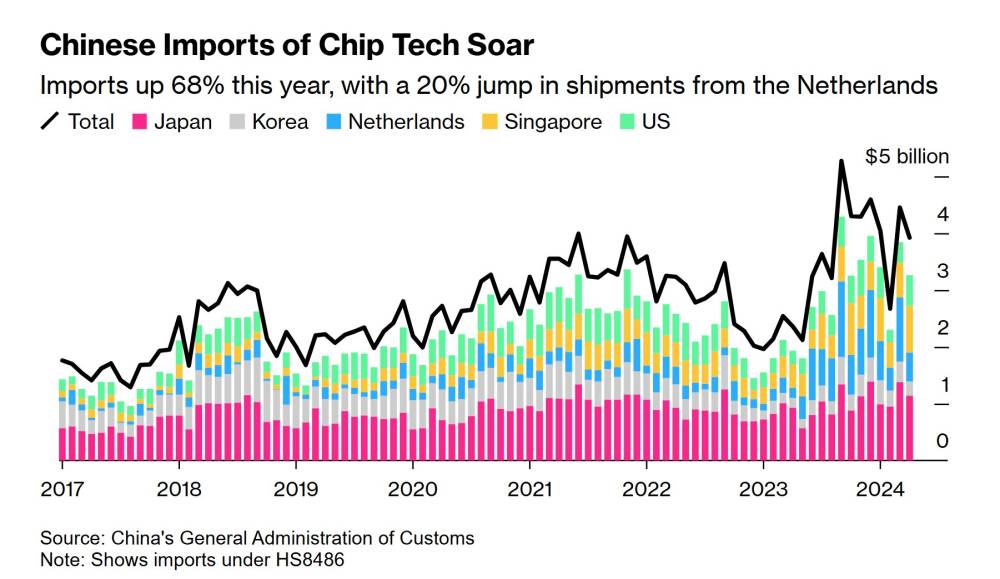

Về chính sách kiểm soát xuất khẩu:

- Mục tiêu ngăn Trung quốc tiếp cận hàng triệu chip AI vào 2026-2027

- Hạn chế xuất khẩu H100 hoàn toàn, H800 bị cấm từ 10/2023

- DeepSeek vẫn có thể tiếp cận chip thông qua nhiều nguồn khác nhau nhưng khó có thể đạt quy mô hàng triệu chip

📌 DeepSeek không thực sự phá vỡ đường cong chi phí của ngành AI mà chỉ theo xu hướng giảm chi phí tự nhiên. Chính sách kiểm soát xuất khẩu chip vẫn cần thiết để duy trì lợi thế công nghệ của Mỹ, đặc biệt khi ngành AI cần hàng triệu chip trị giá hàng chục tỷ USD vào 2026-2027.

https://darioamodei.com/on-deepseek-and-export-controls

Tháng 01 năm 2025

Vài tuần trước, tôi đã lập luận rằng Mỹ cần thắt chặt hơn nữa các biện pháp kiểm soát xuất khẩu chip sang Trung Quốc. Kể từ đó, DeepSeek—một công ty AI Trung Quốc—đã đạt được hiệu suất gần tương đương với các mô hình AI tiên tiến của Mỹ nhưng với chi phí thấp hơn.

Ở đây, tôi sẽ không tập trung vào việc liệu DeepSeek có thực sự đe dọa các công ty AI Mỹ như Anthropic hay không (dù tôi tin rằng nhiều lo ngại về việc Trung Quốc vượt mặt Mỹ trong AI đang bị phóng đại quá mức【1】). Thay vào đó, tôi muốn bàn về việc liệu những bước tiến của DeepSeek có làm suy yếu lý do áp đặt các biện pháp kiểm soát xuất khẩu chip hay không.

Câu trả lời của tôi là không.

Thực tế, DeepSeek càng phát triển, chính sách kiểm soát xuất khẩu càng trở nên quan trọng hơn.

Kiểm soát xuất khẩu có mục tiêu cốt lõi: giữ các quốc gia dân chủ ở vị trí tiên phong trong phát triển AI.

Hãy rõ ràng: đây không phải là cách để né tránh cạnh tranh giữa Mỹ và Trung Quốc.

Cuối cùng, các công ty AI tại Mỹ và các nền dân chủ khác vẫn cần tạo ra những mô hình tốt hơn Trung Quốc nếu chúng ta muốn dẫn đầu.

Nhưng chúng ta không nên trao cho Đảng Cộng sản Trung Quốc lợi thế công nghệ khi không bắt buộc phải làm vậy.

Trước khi đi sâu vào lập luận chính sách, tôi muốn giải thích 3 yếu tố cơ bản trong AI mà chúng ta cần hiểu:

Một tính chất quan trọng của AI—mà tôi và các đồng nghiệp đã từng nghiên cứu khi còn ở OpenAI—là khi tăng quy mô huấn luyện mô hình AI, hiệu suất sẽ tăng một cách có hệ thống.

Ví dụ:

Những khác biệt này có tác động rất lớn trong thực tế—một mức tăng thêm 10 lần chi phí có thể tương đương với chênh lệch trình độ giữa một sinh viên đại học và một tiến sĩ.

Do đó, các công ty AI đang đầu tư mạnh vào huấn luyện mô hình với quy mô ngày càng lớn.

Ngành AI liên tục đưa ra những cải tiến lớn và nhỏ giúp tăng hiệu quả hoặc giảm chi phí:

Những cải tiến này có tác dụng dịch chuyển đường cong hiệu suất:

Mỗi công ty AI hàng đầu đều thường xuyên tìm ra những CM mới:

Vì giá trị của một hệ thống AI thông minh hơn là rất cao, các công ty không giảm ngân sách khi chi phí huấn luyện giảm—họ chỉ đơn giản là huấn luyện các mô hình thông minh hơn, nhanh hơn.

Có một quan niệm sai lầm phổ biến rằng "đầu tiên AI đắt đỏ, sau đó nó trở nên rẻ hơn"—cứ như thể AI là một sản phẩm có chất lượng cố định. Nhưng thực tế không phải như vậy.

Cái quan trọng là đường cong Scaling: khi chi phí huấn luyện giảm, chúng ta không giảm số lượng chip dùng để huấn luyện, mà thay vào đó, chúng ta huấn luyện những mô hình mạnh hơn nhanh hơn.

Năm 2020, tôi và nhóm của mình đã công bố một nghiên cứu cho thấy định luật cải tiến thuật toán đang tăng tốc ở mức ~1.68x/năm.

Tôi tin rằng hiện nay tốc độ này đã tăng lên ít nhất ~4x/năm, đặc biệt khi tính đến cả phần cứng và tối ưu hóa hiệu suất.

Khi đường cong huấn luyện được cải thiện, đường cong suy luận (inference) cũng dịch chuyển theo, giúp giảm mạnh giá thành triển khai AI mà vẫn giữ nguyên chất lượng mô hình.

Ví dụ:

Kết luận: Những cải tiến này không làm AI rẻ hơn—chúng chỉ giúp AI mạnh hơn với cùng mức chi phí.

Không.

Thực tế, những bước tiến của DeepSeek lại khiến kiểm soát xuất khẩu trở nên quan trọng hơn bao giờ hết.

Tại sao?

Kiểm soát xuất khẩu không thể ngăn cản Trung Quốc phát triển AI, nhưng có thể làm chậm tốc độ của họ, giúp Mỹ có thêm thời gian củng cố vị thế dẫn đầu.

Nói cách khác: DeepSeek không chứng minh rằng kiểm soát xuất khẩu là vô ích—mà nó chứng minh rằng kiểm soát xuất khẩu là cần thiết hơn bao giờ hết.

Thỉnh thoảng, cách mà AI được mở rộng quy mô lại thay đổi, hoặc một phương pháp mở rộng mới được bổ sung vào quá trình huấn luyện.

Các công ty như Anthropic, DeepSeek, và đặc biệt là OpenAI với mô hình o1-preview ra mắt vào tháng 9, đều nhận thấy rằng học tăng cường (RL) có thể cải thiện đáng kể hiệu suất trên một số nhiệm vụ đo lường khách quan như:

Mô hình này hoạt động theo hai giai đoạn:

Điều quan trọng cần hiểu là việc sử dụng RL vẫn còn rất mới.

Điều này đưa chúng ta đến một "điểm giao thoa" quan trọng:

3 yếu tố trên có thể giúp giải thích các bước tiến gần đây của DeepSeek.

Khoảng một tháng trước, DeepSeek ra mắt mô hình "DeepSeek-V3", đây chỉ là mô hình tiền huấn luyện, tức giai đoạn 1 trong quy trình nêu trên.

Tuần trước, họ tiếp tục ra mắt "R1", mô hình có thêm giai đoạn 2 với RL.

Từ bên ngoài, chúng ta không thể biết chính xác mọi thứ về các mô hình này, nhưng dưới đây là những gì tôi hiểu rõ nhất về hai phiên bản của DeepSeek.

Mô hình DeepSeek-V3 thực chất mới là đột phá quan trọng, và đáng lẽ phải được chú ý nhiều hơn ngay từ khi ra mắt.

DeepSeek đạt được kết quả này nhờ một số cải tiến kỹ thuật thực sự ấn tượng, chủ yếu tập trung vào tối ưu hóa hiệu suất kỹ thuật:

1. DeepSeek không phải "làm được với 6 triệu USD những gì Mỹ cần hàng tỷ USD để làm".

Tôi chỉ có thể nói thay cho Anthropic, nhưng:

Vì vậy, một tuyên bố công bằng hơn là:

DeepSeek đã tạo ra một mô hình gần với các mô hình của Mỹ ra mắt trước đó 7-10 tháng, với chi phí thấp hơn đáng kể (nhưng không đến mức tỷ lệ mà nhiều người đã suy đoán).

Nếu chi phí huấn luyện AI theo định luật giảm chi phí (cost curve decrease) giảm ~4 lần mỗi năm, thì theo xu hướng lịch sử (giống như năm 2023 và 2024), ta có thể dự đoán rằng:

Điều này có nghĩa là:

Điểm khác biệt duy nhất lần này là:

Đây là một sự kiện quan trọng về mặt địa chính trị, nhưng không phải là một đột phá kỹ thuật chưa từng có.

Các công ty AI của Mỹ không cần phải sao chép DeepSeek để đạt được mức chi phí thấp hơn—họ cũng đang tiến theo quy luật giảm chi phí thông thường của ngành AI.

Theo một số báo cáo (chưa thể xác nhận hoàn toàn), DeepSeek hiện có 50.000 GPU Hopper.

Như vậy, tổng chi tiêu của DeepSeek với tư cách một công ty (không chỉ riêng chi phí huấn luyện mô hình) không chênh lệch quá nhiều so với các phòng thí nghiệm AI lớn của Mỹ.

DeepSeek-R1 là mô hình được ra mắt tuần trước và đã tạo ra làn sóng chú ý lớn, gây giảm 17% giá cổ phiếu của Nvidia.

Tuy nhiên, từ góc độ đổi mới và kỹ thuật, R1 kém thú vị hơn nhiều so với V3.

Nhưng vì chúng ta đang ở giai đoạn đầu của đường cong Scaling, nhiều công ty có thể tạo ra các mô hình AI suy luận tốt bằng cách áp dụng RL lên một mô hình tiền huấn luyện mạnh.

Tuy nhiên, điều này sẽ không kéo dài lâu.

Các công ty AI đang chi tiêu ngày càng nhiều để huấn luyện những mô hình mạnh hơn, ngay cả khi chi phí huấn luyện giảm theo xu hướng định kỳ.

Tại sao?

Mốc thời gian?

DeepSeek không làm thay đổi thực tế này—họ đơn giản chỉ là một điểm dữ liệu trên đường cong chi phí đã được tính toán từ trước.

Vào năm 2026-2027, chúng ta có thể đối mặt với hai kịch bản hoàn toàn khác nhau.

Nếu Trung Quốc có thể đạt được số lượng GPU này:

Nếu Trung Quốc không thể tiếp cận hàng triệu GPU, chúng ta sẽ có một thế giới đơn cực (unipolar world)—nơi chỉ Mỹ và các đồng minh sở hữu AI mạnh nhất.

Biện pháp kiểm soát xuất khẩu là yếu tố quan trọng nhất quyết định liệu thế giới sẽ đơn cực hay hai cực.

DeepSeek không chứng minh rằng các biện pháp kiểm soát xuất khẩu đã thất bại.

Trung Quốc có thể buôn lậu một số lượng GPU nhỏ, nhưng:

Theo SemiAnalysis, DeepSeek hiện sở hữu khoảng 50.000 GPU, bao gồm:

Những gì DeepSeek sở hữu cho thấy kiểm soát xuất khẩu đang phát huy tác dụng:

DeepSeek không phải là kẻ thù của Mỹ.

Nhưng họ hoạt động dưới sự kiểm soát của một chính phủ độc tài, chính phủ này:

Chính vì công nghệ AI ngày càng mạnh, việc kiểm soát xuất khẩu càng trở nên quan trọng hơn bao giờ hết.

Mỹ không thể để Trung Quốc có đủ GPU để xây dựng một AI ngang hàng với Mỹ.

Nếu kiểm soát xuất khẩu được thực thi đúng cách, Mỹ có thể duy trì vị thế AI số một thế giới trong nhiều thập kỷ tới.

- Quỹ Brookfield của Canada sẽ đầu tư 20 tỷ euro (tương đương 21 tỷ USD) đến năm 2030 để xây dựng các trung tâm dữ liệu AI tại Pháp

- Thông báo được đưa ra trước thềm hội nghị thượng đỉnh AI toàn cầu tại Paris vào ngày 12-13/02/2025

- Trong tổng số 20 tỷ euro:

- 15 tỷ euro dành cho xây dựng trung tâm mới

- 5 tỷ euro đầu tư vào cơ sở hạ tầng liên quan, đặc biệt là các nhà máy điện

- Dự án trọng điểm sẽ được xây dựng tại thành phố Cambrai ở phía bắc Pháp

- Thỏa thuận được ký kết ngày 31/01/2025 giữa tổng thống Pháp Emmanuel Macron và CEO Brookfield Bruce Flatt

- Các Tiểu vương quốc Ả rập thống nhất (UAE) cũng đã công bố kế hoạch xây dựng trung tâm dữ liệu lớn nhất châu Âu tại Pháp với tổng đầu tư từ 30-50 tỷ euro

Hiện trạng trung tâm dữ liệu tại Pháp:

- Có hơn 300 trung tâm

- Xếp hạng thứ 6 thế giới

- Các nước dẫn đầu: Mỹ, Đức, Anh, Trung Quốc và Canada

- Mỹ gần đây đã công bố kế hoạch đầu tư 500 tỷ USD vào cơ sở hạ tầng AI do OpenAI và SoftBank dẫn đầu

📌 Pháp đang trở thành điểm đến hấp dẫn cho đầu tư AI với 2 thương vụ lớn từ Brookfield (20 tỷ euro) và UAE (30-50 tỷ euro). Với hơn 300 trung tâm dữ liệu hiện có, quốc gia này đang khẳng định vị thế trong cuộc đua công nghệ AI toàn cầu.

https://www.france24.com/en/business/20250209-paris-ai-summit-canadian-fund-brookfield-to-invest-%E2%82%AC20-billion-in-france

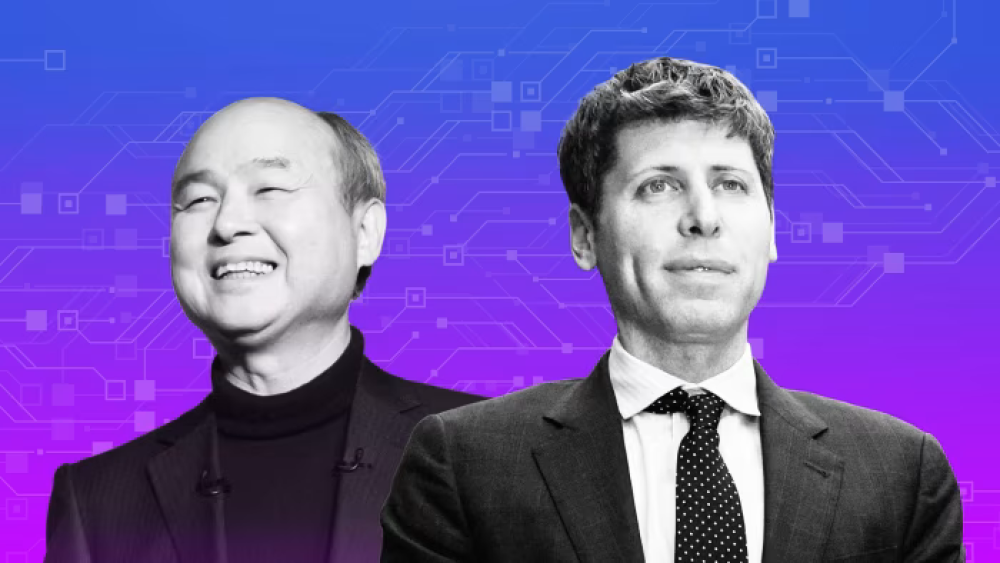

- Masayoshi Son và Sam Altman lần đầu gặp nhau năm 2017 tại Tokyo, khi đó Altman chưa có dự án đủ lớn để thu hút đầu tư từ SoftBank

- Son từng cố gắng đầu tư gần 1 tỷ USD vào OpenAI nhưng bị Altman từ chối, thay vào đó OpenAI chọn Microsoft làm đối tác chiến lược

- SoftBank hiện đang dẫn đầu vòng đầu tư kỷ lục 40 tỷ USD vào OpenAI với mức định giá trước đầu tư là 260 tỷ USD

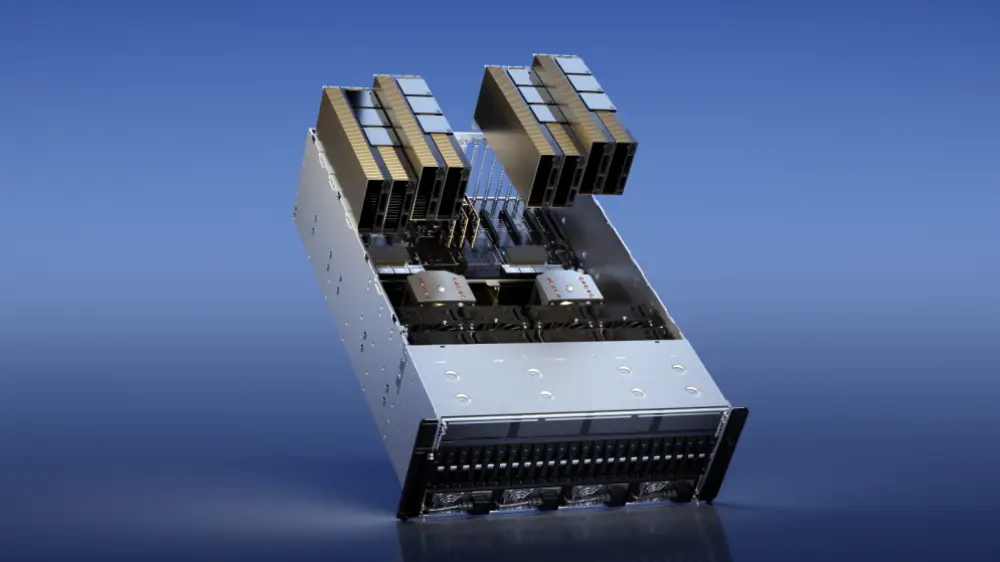

- Dự án Stargate - trung tâm dữ liệu AI trị giá 500 tỷ USD đang được hai bên phát triển:

+ SoftBank cam kết đầu tư 15-20 tỷ USD

+ OpenAI sẽ đầu tư một khoản tương đương

+ MGX (quỹ đầu tư nhà nước Abu Dhabi) cũng tham gia góp vốn

- Son có tiền lệ đặt cược lớn vào các doanh nhân trẻ:

+ Thành công với khoản đầu tư 20 triệu USD vào Alibaba của Jack Ma

+ Thất bại với khoản lỗ 14,2 tỷ USD từ WeWork của Adam Neumann

- Thỏa thuận được thảo luận nhanh chóng trong vài tháng qua, chủ yếu giữa Son và Altman, với sự tham gia của đội ngũ điều hành chủ chốt từ hai bên

- OpenAI chưa ký hợp đồng đảm bảo sử dụng Stargate, dù dự án được thiết kế riêng cho công ty

📌 Masayoshi Son và Sam Altman thiết lập quan hệ đối tác chiến lược với tổng giá trị đầu tư lên tới 540 tỷ USD, bao gồm 40 tỷ USD vào OpenAI và 500 tỷ USD cho dự án Stargate, đánh dấu thương vụ lớn nhất trong lịch sử công nghệ AI.

https://www.ft.com/content/fc57feea-db72-4e86-b3ce-8956b3d739e3

#FT

Masayoshi Son của SoftBank và Sam Altman của OpenAI đặt cược vào AI—và vào nhau

Hai tỷ phú dẫn đầu cuộc đàm phán về thỏa thuận kỷ lục, biến nhà đầu tư Nhật Bản thành cổ đông lớn nhất của nhà phát triển ChatGPT

Khi Masayoshi Son và Sam Altman lần đầu gặp nhau vào năm 2017 tại trụ sở SoftBank ở Tokyo, vị doanh nhân trẻ chưa có dự án nào đủ lớn để khiến tỷ phú công nghệ rút séc đầu tư.

Trong hai năm tiếp theo, khi OpenAI của Altman phát triển thành một trong những công ty trí tuệ nhân tạo (AI) mạnh nhất thế giới, Son đã cố gắng đầu tư gần 1 tỷ USD vào nhà phát triển ChatGPT.

Altman từ chối.

Thay vào đó, ông chọn Microsoft, công ty có thể cung cấp sức mạnh tính toán cần thiết để thúc đẩy sự tăng trưởng của OpenAI, theo một người trực tiếp biết về quyết định này.

Kể từ đó, OpenAI của Altman đã trở thành một trong những startup phát triển nhanh nhất mọi thời đại và đang tìm cách mở rộng vượt ra khỏi quan hệ hợp tác với Microsoft. Điều này tạo cơ hội cho SoftBank dẫn đầu khoản đầu tư vào startup lớn nhất từ trước đến nay—một vòng huy động 40 tỷ USD vào OpenAI. Đổi lại, Son có được điều ông khao khát: một vị trí trung tâm trong thế giới AI.

Trên sân khấu ở Tokyo tuần này, hai người đã thảo luận về một kế hoạch liên quan: dự án trung tâm dữ liệu AI trị giá 500 tỷ USD có tên “Stargate”. Son, dù chưa đầy 70 tuổi, vẫn tận hưởng vai trò một người dẫn dắt đầy nhiệt huyết, ngồi đối diện với Altman, người trẻ hơn gần 30 tuổi và có vẻ kém thoải mái hơn trước đám đông.

Dù khác biệt, cả hai đều tin tưởng rằng kỷ nguyên trí tuệ nhân tạo tổng quát (AGI)—khi máy móc có thể vượt trội con người trong các lĩnh vực nhận thức—đang đến gần, và một siêu trí tuệ mạnh hơn theo cấp số nhân sẽ xuất hiện sau đó.

“Khi tôi gặp cậu lúc còn trẻ... cậu nói rằng sẽ theo đuổi AGI và tôi lập tức nói, ‘Tôi tin cậu. Tôi muốn đầu tư,’” Son nói với Altman tại Tokyo. “Từ đó tôi đã là một người tin tưởng. Tôi chưa bao giờ nghi ngờ. Lúc đó hầu hết mọi người nghĩ cậu điên, đúng không?”

“Một số người cũng nghĩ ông điên. Cuối cùng thì mọi thứ cũng đâu vào đó,” Altman đáp lại.

Thỏa thuận mà Son và Altman đang thiết lập có quy mô và cấu trúc chưa từng có, với các cuộc đàm phán giữa SoftBank và OpenAI diễn ra theo hai giai đoạn, theo những người biết về kế hoạch này.

Đầu tiên, là một vòng huy động vốn độc quyền, trong đó SoftBank cam kết đầu tư tới 40 tỷ USD vào OpenAI. SoftBank không nhất thiết phải cung cấp toàn bộ số tiền mà có quyền mời các đối tác khác tham gia vòng gọi vốn. OpenAI có quyền chấp thuận hoặc từ chối các nhà đầu tư mới, theo một người trực tiếp biết về kế hoạch này.

Vòng gọi vốn dự kiến định giá OpenAI ở mức 260 tỷ USD trước đầu tư mới. “Đây là vòng gọi vốn của Masa, nhưng Masa sẽ được phép đưa một số nhà đầu tư khác vào OpenAI với giới hạn nhất định,” một người tham gia đàm phán cho biết.

Trong giai đoạn thứ hai, SoftBank dự kiến ban đầu rót khoảng 15 tỷ-20 tỷ USD vào Stargate. OpenAI, với nguồn vốn mới từ vòng đầu tư của SoftBank, đã đồng ý đầu tư số tiền tương đương với con số mà tập đoàn Nhật Bản rót vào dự án hạ tầng này.

Các đối tác, bao gồm MGX, quỹ thuộc sở hữu nhà nước Abu Dhabi và một nhà đầu tư cổ phần của Stargate, có kế hoạch đưa ra các quyết định đầu tư tiếp theo khi thấy tiến triển của dự án, theo 3 người quen thuộc với kế hoạch này.

OpenAI và SoftBank từ chối bình luận.

Thỏa thuận này phù hợp với phong cách đầu tư của Son—liều lĩnh đặt niềm tin, hậu thuẫn bằng hàng tỷ USD, và thường bỏ qua khuyến nghị từ các cố vấn cấp dưới.

Một khoản đầu tư sớm trị giá 20 triệu USD vào Jack Ma chỉ một năm sau khi Alibaba thành lập đã giúp Son kiếm được hàng tỷ USD và củng cố danh tiếng như một nhà đầu tư ngôi sao.

Nhưng cuộc tìm kiếm "cơ hội lớn tiếp theo" của ông cũng dẫn đến nhiều khoản lỗ nghiêm trọng, bao gồm 14,2 tỷ USD khi đặt cược vào Adam Neumann, khi WeWork lao vào phá sản. Theo một người biết về quyết định đó, có thời điểm, chính một số nhà đầu tư của Son đã phải ngăn ông rót thêm hàng tỷ USD vào công ty của Neumann.

"Điểm yếu chí mạng của Masa là ông ấy dễ bị cuốn hút bởi những chàng trai trẻ có tầm nhìn," một người từng làm việc chặt chẽ với ông nhận xét.

Kế hoạch cho Stargate được vạch ra trong vài tháng gần đây, chủ yếu do Son và Altman tự bàn bạc mà không có cố vấn bên cạnh, theo những người quen thuộc với quá trình này.

“3 tháng trước, Sam vẫn còn 'hẹn hò'… nhưng trong vài tháng qua, anh ấy đã quyết định cam kết với Masa,” một người thân cận với SoftBank cho biết.

Một số cố vấn của Son đang cố gắng kiềm chế ông, lo ngại rằng Altman có những động cơ riêng—bao gồm việc mở rộng quan hệ hợp tác vượt ra khỏi nhà đầu tư lớn nhất hiện tại của OpenAI là Microsoft.

“[Sam] không còn điều hành một startup nữa. Đây là một công ty lớn với tham vọng lớn. Vậy thì cứ để họ làm,” một người quen thuộc với quan điểm của Microsoft nhận xét.

Ngoài 2 nhân vật chính, một đội ngũ điều hành chủ chốt cũng được giao nhiệm vụ xử lý các chi tiết của thỏa thuận. Đội ngũ này bao gồm Sarah Friar, giám đốc tài chính của OpenAI, Peter Hoeschele, phụ trách xây dựng cơ sở hạ tầng tại OpenAI, Rene Haas, CEO của Arm, và Vikas Parekh, một giám đốc điều hành từ SoftBank.

Stargate được thiết kế chỉ dành riêng cho OpenAI, dựa trên giả định rằng nhu cầu tính toán của công ty AI có trụ sở tại San Francisco sẽ tiếp tục tăng vọt. Tuy nhiên, theo một người trực tiếp biết về liên doanh này, OpenAI chưa ký hợp đồng đảm bảo sẽ sử dụng cơ sở hạ tầng đó.

“Thỏa thuận Stargate không phải là một hợp đồng tiêu chuẩn... [Son] phải xây dựng với niềm tin và hiểu rằng OpenAI sẽ muốn sử dụng năng lực tính toán này. Nhưng chưa có hợp đồng ràng buộc,” người này cho biết.

OpenAI dự kiến sẽ ký kết các thỏa thuận để sử dụng bất kỳ cơ sở nào mà Stargate phát triển hoặc đầu tư vào, và về lâu dài có thể mở dự án này cho các khách hàng khác, theo một người thân cận với công ty. Một người khác hiểu về chiến lược của SoftBank cho biết họ sẽ không bắt đầu xây dựng trung tâm dữ liệu nếu chưa có hợp đồng cam kết từ OpenAI.

Trong một báo cáo năm ngoái, OpenAI lập luận rằng “hạ tầng chính là định mệnh,” và Altman tỏ ra lạc quan về khả năng đánh bại các đối thủ trong cuộc đua đến AGI nếu có đủ nguồn lực.

Tuy nhiên, các mô hình AI mới, hiệu quả hơn đang xuất hiện, chẳng hạn như R1 của công ty AI Trung Quốc DeepSeek, đặt ra thách thức đối với giả định rằng quy mô lớn luôn mang lại lợi thế.

Bất kỳ sự chững lại nào trong nhu cầu đối với các trung tâm dữ liệu khổng lồ sẽ gây ra vấn đề nghiêm trọng cho Stargate. “Nếu OpenAI không thúc đẩy nhu cầu, bạn sẽ thấy điều từng xảy ra với ngành bán dẫn: các nhà máy sản xuất chip trống rỗng,” một nhà đầu tư từng làm việc với Son nhận xét. “Tình hình sẽ rất tệ, rất khốc liệt.”

Thỏa thuận độc đáo này gắn chặt Son với Altman, khiến tương lai của SoftBank phụ thuộc vào khả năng của OpenAI trong việc tiếp tục tăng trưởng cả về định giá lẫn nhu cầu trung tâm dữ liệu. Hai bên cũng đã thành lập một liên doanh tại Nhật Bản để bán các sản phẩm của OpenAI, trong khi các công ty thuộc tập đoàn SoftBank cam kết chi thêm 3 tỷ USD mỗi năm để sử dụng dịch vụ của OpenAI.

“Hiện tại, cái gì tốt cho Sam cũng tốt cho Masa,” một người quen thuộc với cả hai cho biết, đồng thời lưu ý rằng kế hoạch của Son không chỉ dừng lại ở OpenAI, mà còn bao gồm việc lấn sân sang sản xuất chip.

Những người này cũng lập luận rằng không phải mọi quyết định lớn của Son đều dựa trên niềm tin vào cá nhân, nhấn mạnh thương vụ thâu tóm Arm. Nhà thiết kế chip của Anh—niêm yết vào năm ngoái và vẫn thuộc sở hữu gần 90% của SoftBank—đã mang lại cho Son khả năng tiếp cận hàng tỷ USD thông qua quỹ đầu tư và các khoản vay thế chấp, cũng như một vị trí cốt lõi trong ngành AI.

“Mọi quỹ đầu cơ, doanh nhân và nhà công nghệ đều đang tự hỏi ‘làm thế nào để cạnh tranh với Sam Altman?’” một nhà đầu tư lớn nhận xét. “Với tiền của Masa, liệu ông ấy có thể tạo ra một lợi thế không thể bị đánh bại?”

SoftBank’s Masayoshi Son and OpenAI’s Sam Altman bet on AI — and each other

The two billionaires lead talks over record deal to make Japanese investor biggest backer of ChatGPT maker

When Masayoshi Son and Sam Altman first met each other in 2017 at SoftBank’s offices in Tokyo, the younger entrepreneur lacked a project large enough to tempt the tech billionaire to get his cheque book out.

Over the next two years, as Altman’s OpenAI evolved into one of the world’s most potent artificial intelligence companies, Son tried to invest close to $1bn in the ChatGPT maker.

Altman refused.

He instead opted for Microsoft, which could provide the computing power needed to turbocharge his company’s growth, according to a person with direct knowledge of the decision.

Altman’s OpenAI has since become one of the fastest-growing start-ups of all time and is straining to grow beyond its partnership with Microsoft. That has cleared a path for SoftBank to lead the largest-ever start-up investment — a $40bn round into OpenAI. In return, Son gets something he craves: a place at the centre of the AI world.

On stage in Tokyo this week, the two men discussed a connected plan: a $500bn AI data centre project dubbed “Stargate”. Son, a few years shy of 70, still revelling in his abilities as a showman, sat across from Altman, nearly 30 years his junior and a man who seemed less at ease in front of a crowd.

For all their differences, they share a conviction that the era of artificial general intelligence — when machines can outperform humans across cognitive fields — is at hand, and that exponentially more powerful superintelligence will follow.

“When I met you when you were younger . . . you said that you’re going to go for AGI and I immediately said, ‘I believe you. I want to invest,’” Son told Altman in Tokyo. “From there I was a believer. I never doubted. Most people at that time thought you were crazy, right?”

“Some people think you’re crazy too. It all works out,” Altman replied.

The deal Son and Altman are putting together is unprecedented in size and structure, with talks between SoftBank and OpenAI playing out over two stages, according to people with knowledge of the plans.

First, there is an exclusive funding round in which SoftBank has committed to invest up to $40bn in OpenAI. SoftBank is not expected to provide the full amount on its own and has the right to bring other partners into the funding round. OpenAI can approve or veto the new investors, according to a person with direct knowledge of the plans.

The funding round is expected to value OpenAI at a pre-money valuation of $260bn. “It’s Masa’s round, but Masa will be allowed to bring other investors into OpenAI on a limited basis,” said one person involved in the talks.

In the second phase, SoftBank is planning to initially put about $15bn-$20bn into Stargate. OpenAI, with new money from the SoftBank round, has agreed to match whatever figure the Japanese group puts into the infrastructure project.

Partners including MGX, the Abu Dhabi state-owned fund and a Stargate equity investor, intend to make further investment decisions once they see progress on the project, according to three people with knowledge of the plans.

OpenAI and SoftBank declined to comment.

The deal fits Son’s record of taking leaps of faith, backed by billions in capital, often overriding the recommendations of his lieutenants.

An early $20mn bet on Jack Ma just a year after Alibaba was founded made Son billions and forged his reputation as a star investor.

His search for the next big thing has also resulted in numerous dramatic losses, including $14.2bn on Adam Neumann as WeWork tumbled into bankruptcy. At one point, some of Son’s own backers had to veto his attempts to invest billions more into Neumann’s company, according to a person with knowledge of that decision.

“The Achilles heel of Masa is he just falls in love with these visionary young men,” said one person who has worked closely with him.

The plan for Stargate was put together rapidly over the past few months, often with just Son and Altman thrashing out the details without advisers present, said people familiar with the process.

“Until three months ago, Sam was dating . . . but in the past few months he’s decided he will commit to Masa,” said one of the people close to SoftBank.

Some of Son’s advisers are trying to rein him in again, mindful that Altman has his own motivations — including trying to extend its partnerships beyond its current biggest backer, Microsoft.

“[Sam] is no longer running a start-up. It’s a big company with big ambitions. So all power to them,” said a person familiar with Microsoft’s thinking.

As well as the two main characters, a core executive team was tasked with working out the details. It included Sarah Friar, OpenAI chief financial officer, Peter Hoeschele, in charge of infrastructure buildout at OpenAI, Rene Haas, Arm CEO and Vikas Parekh, an executive from SoftBank.

Stargate is designed solely for the use of OpenAI, based on the assumption that the San Francisco-based group’s demand for computing power will continue to skyrocket. But, according to one person with direct knowledge of the joint venture, OpenAI has not signed a contract guaranteeing its usage.

“The Stargate deal is not a standard deal . . . [Son] has to build this with the belief and understanding that OpenAI will want to take the compute. But there’s no contract,” they said.

OpenAI expects to sign agreements to make use of any sites that Stargate develops or invests in, and could ultimately open the project to other customers, according to a person close to the company. Another person familiar with SoftBank’s thinking said they would not start building data centres without such a contract in place.

OpenAI argued in a paper last year that “infrastructure is destiny” and Altman has been bullish about the company’s ability to beat rivals to AGI given enough resources.

But new, more efficient AI models are emerging, such as Chinese AI company DeepSeek’s R1, which have challenged assumptions about the advantages of scale.

Any slowing of demand for massive data centres would pose a significant problem for Stargate. “If you don’t have OpenAI driving demand, you will have what you had in the semiconductor cycle: empty fabs [semiconductor fabrication plants],” said the investor who has worked with Son. “It will get very bloody, very ugly.”

The novel arrangement anchors Son to Altman, tying SoftBank’s fate to OpenAI’s ability to continue growing both its valuation and its demand for data centres. The two groups have also put together a joint venture in Japan to sell OpenAI products and SoftBank group companies have committed to spending another $3bn a year on OpenAI services.

“At the moment, what’s good for Sam is good for Masa,” said a person familiar with the pair, noting that Son’s plans remain bigger than OpenAI, including moving into chip production.

The same people also argue that not all of Son’s biggest moves are due to a belief in individuals, highlighting the bet to acquire Arm. The UK chip designer — which was listed last year and in which SoftBank still owns close to 90 per cent — has given Son the potential to access billions in funds and collateralised loans, as well as a core piece of the AI sector.

“Every hedge fund, entrepreneur and technologist is thinking ‘how do I chip away at Sam Altman?’’’ said one major investor. “With Masa’s money can he create an unassailable lead?”

- Pháp và UAE đã ký kết thỏa thuận khung để phát triển trung tâm dữ liệu AI công suất 1 gigawatt, với tổng mức đầu tư từ 30-50 tỷ USD

- Tổng thống Pháp Emmanuel Macron đã tiếp đón người đồng cấp UAE Sheikh Mohamed bin Zayed al-Nahyan tại Paris ngày 6/2/2025

- Thỏa thuận được ký kết trước thềm hội nghị thượng đỉnh AI tại Paris (diễn ra ngày 10-11/2/2025) với sự tham gia của khoảng 100 quốc gia

- Hai nhà lãnh đạo cam kết thiết lập quan hệ đối tác chiến lược trong lĩnh vực AI, tập trung vào:

+ Phát triển chuỗi giá trị AI

+ Mua sắm chip công nghệ cao

+ Xây dựng trung tâm dữ liệu

+ Phát triển nhân tài

+ Thành lập đại sứ quán dữ liệu ảo

- Dự án nhằm giúp Pháp và châu Âu cạnh tranh với Mỹ và Trung Quốc trong lĩnh vực AI

- Chính phủ Pháp đã xác định 35 địa điểm để xây dựng trung tâm dữ liệu AI

- Chi tiết về các khoản đầu tư đầu tiên sẽ được công bố tại hội nghị Choose France trong năm nay

📌 Thỏa thuận hợp tác Pháp-UAE trị giá lên đến 50 tỷ USD đánh dấu bước đột phá trong việc phát triển cơ sở hạ tầng AI tại châu Âu. Dự án trung tâm dữ liệu 1 gigawatt sẽ tạo nền tảng quan trọng giúp Pháp cạnh tranh với các cường quốc AI như Mỹ và Trung Quốc.

https://www.reuters.com/technology/artificial-intelligence/france-uae-agree-develop-1-gigawatt-ai-data-centre-2025-02-06/

- DeepSeek R1 là mô hình AI do đội ngũ phát triển Trung quốc tạo ra, có khả năng mở rộng từ 1,5 tỷ đến 671 tỷ tham số

- Yêu cầu cho mô hình nhỏ (1,5 tỷ tham số):

+ CPU không quá 10 năm tuổi

+ RAM tối thiểu 8GB

+ Không cần GPU riêng

- Mô hình trung bình (7-8 tỷ tham số):

+ Cần GPU với ít nhất 8GB VRAM để tăng hiệu suất

+ Vẫn có thể chạy trên CPU nhưng sẽ chậm hơn

- Mô hình trung cấp (14-32 tỷ tham số):

+ Mô hình 14B: GPU tối thiểu 12GB VRAM, khuyến nghị 16GB

+ Mô hình 32B: Cần 24GB VRAM để đạt hiệu suất tối ưu

+ Có thể chạy với VRAM thấp hơn nhưng sẽ phân tán tải trên GPU, CPU và RAM

- Mô hình lớn (70-671 tỷ tham số):

+ Mô hình 70B: Yêu cầu GPU 48GB VRAM

+ Mô hình 671B: Cần 480GB VRAM tổng cộng

+ Phải dùng hệ thống nhiều GPU:

* 20 card Nvidia RTX 3090 (24GB/card)

* Hoặc 10 card Nvidia RTX A6000 (48GB/card)

- Các yếu tố quan trọng khi triển khai:

+ Cần đảm bảo nguồn điện và hệ thống làm mát đầy đủ

+ Kiểm tra tính tương thích giữa các GPU

+ Tính toán chi phí tiêu thụ điện dài hạn

+ Khả năng mở rộng trong tương lai

📌 DeepSeek R1 cung cấp nhiều lựa chọn từ mô hình nhỏ 1,5 tỷ tham số chạy được trên CPU đến mô hình khổng lồ 671 tỷ tham số đòi hỏi 20 GPU RTX 3090. Việc chọn cấu hình phù hợp với nhu cầu và ngân sách là yếu tố quyết định thành công khi triển khai.

https://www.geeky-gadgets.com/hardware-requirements-for-deepseek-r1-ai-models/

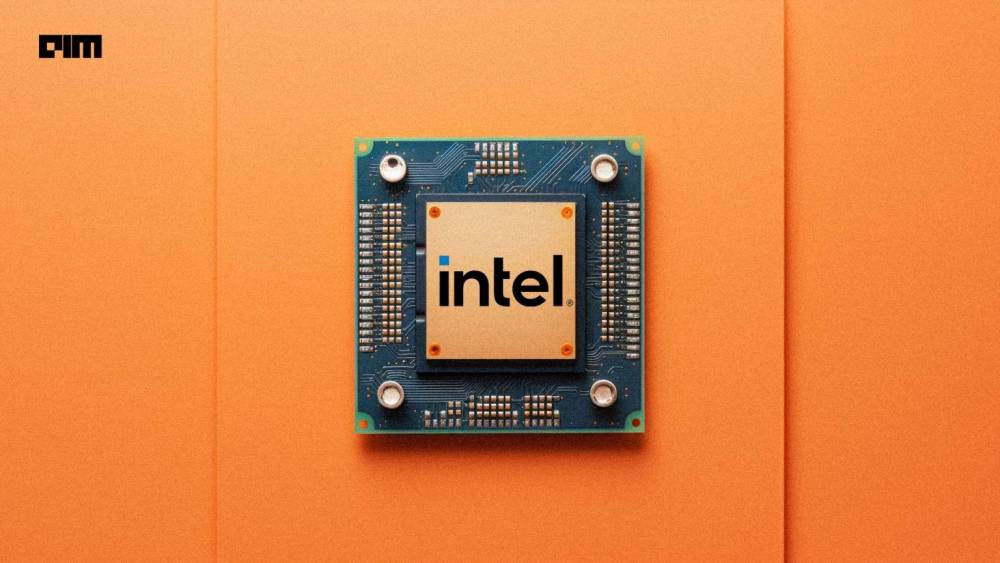

https://www.wsj.com/tech/intel-shows-why-nvidia-is-still-hard-to-beat-92344c34

#WSJ

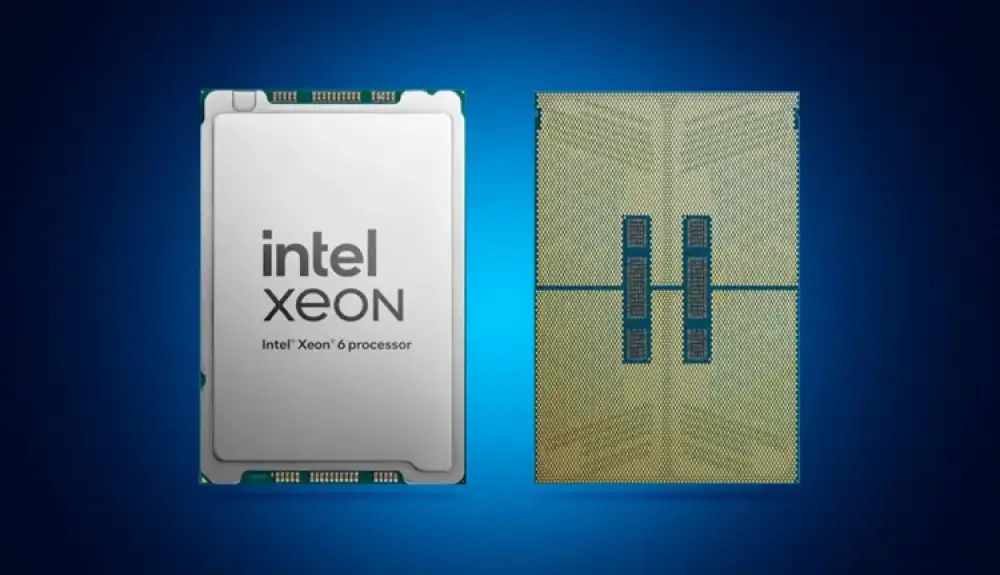

Intel cho thấy vì sao Nvidia vẫn khó bị đánh bại

Cổ phiếu Nvidia sụt giảm sau tin tức về DeepSeek, nhưng Intel ngày càng chật vật trong cuộc đua chip AI

Dan Gallagher

Ngày 3 tháng 2, 2025 – 5:30 sáng ET

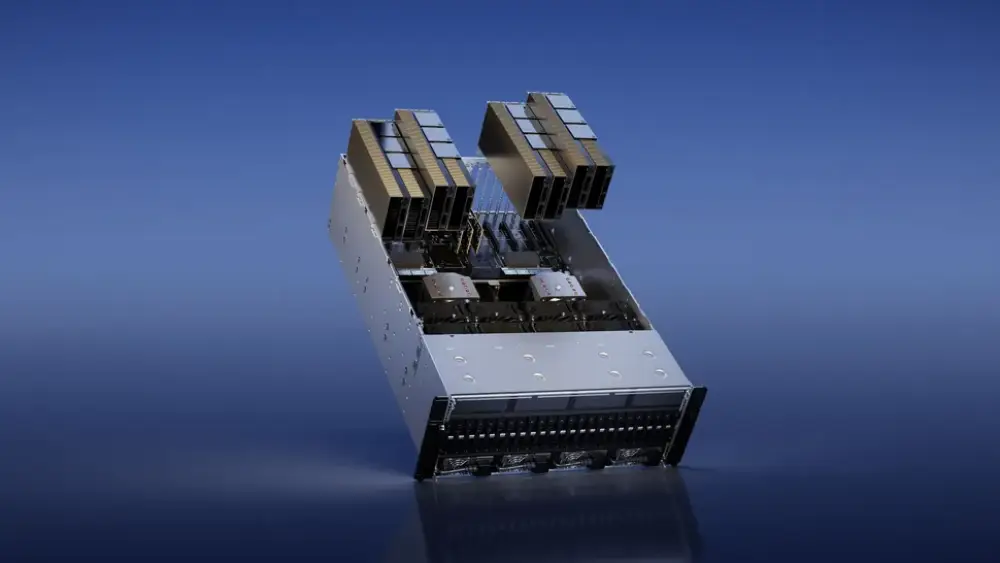

Intel đã quyết định không đưa chip Falcon Shores ra thị trường. Falcon Shores là loại chip tương tự đã giúp Nvidia trở thành thế lực trong lĩnh vực trí tuệ nhân tạo.

Nvidia có thể trông kém “bất khả chiến bại” hơn so với trước đây. Nhưng Intel vừa cho thấy rằng thách thức gã khổng lồ AI này vẫn là một nhiệm vụ không hề dễ dàng.

Báo cáo quý IV của Intel công bố vào tối thứ Năm diễn ra sau một tuần đầy biến động đối với Nvidia. Nhà thiết kế chip AI và hệ thống máy tính này đã mất hơn 18% giá trị vốn hóa thị trường sau khi thế giới biết đến những đột phá kỹ thuật của startup AI Trung Quốc DeepSeek. Những tiến bộ đó cho thấy có thể xây dựng các mô hình AI tiên tiến với chi phí tính toán tương đối thấp, điều mà nhiều người tin rằng có thể dẫn đến nhu cầu giảm đối với sản phẩm của Nvidia.

Tuy nhiên, viễn cảnh đó vẫn còn xa vời. Mark Zuckerberg, CEO của Meta Platforms và là một trong những khách hàng lớn nhất của Nvidia, đã nói trong cuộc họp báo cáo thu nhập tuần trước rằng “vẫn còn quá sớm” để biết liệu những tiến bộ của DeepSeek có làm giảm nhu cầu chi tiêu vốn (capex) cho AI hay không. Nhưng ông cũng nói rằng sức mạnh tính toán cao hơn vẫn sẽ dẫn đến hệ thống AI tốt hơn, vì vậy “đầu tư rất mạnh vào capex và cơ sở hạ tầng sẽ là lợi thế chiến lược theo thời gian.” Meta dự kiến chi tới 65 tỷ USD cho capex trong năm nay, so với mức chưa đến 40 tỷ USD của năm ngoái.

Tuy nhiên, Intel có thể không giành được nhiều lợi ích từ khoản chi tiêu đó. Trong cuộc họp báo cáo thu nhập quý IV tối thứ Năm, đồng CEO của Intel, Michelle Johnston Holthaus, cho biết công ty đã quyết định không đưa chip Falcon Shores ra thị trường. Trước đó, Intel có kế hoạch ra mắt bộ tăng tốc GPU—loại chip đã giúp Nvidia trở thành cái tên số một trong lĩnh vực AI—vào cuối năm nay. Nhưng Holthaus cho biết, dựa trên “phản hồi từ ngành,” công ty đã quyết định chỉ sử dụng Falcon Shores như một chip thử nghiệm nội bộ khi phát triển hệ thống AI dựa trên rack.

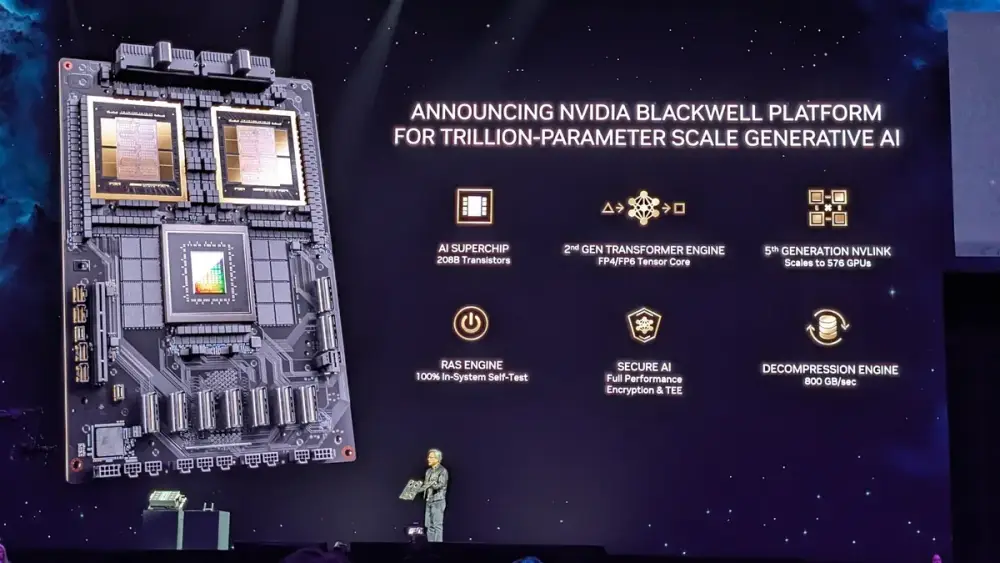

Điều này đồng nghĩa với việc Intel vẫn phải đối đầu với Nvidia ngay trên sân nhà của đối thủ. Dòng chip mới nhất của Nvidia, có tên Blackwell, cũng được thiết kế cho các hệ thống rack server, với một số phiên bản yêu cầu hệ thống làm mát bằng chất lỏng để vận hành trong các trung tâm dữ liệu. Nhưng nhu cầu đối với các sản phẩm này vẫn chưa hạ nhiệt. Theo Visible Alpha, các nhà phân tích dự đoán doanh thu từ dòng Blackwell có thể vượt 75 tỷ USD trong năm tài chính tới của Nvidia, kết thúc vào tháng 1 năm 2026. Trong cùng khoảng thời gian, tổng doanh thu của Intel được dự báo chỉ hơn 53 tỷ USD.

Falcon Shores không phải là thất bại đầu tiên của Intel trong nỗ lực cạnh tranh với Nvidia. Trong cuộc họp báo cáo quý III ba tháng trước, Intel cho biết phiên bản thứ ba của chip tăng tốc AI Gaudi đang có nhu cầu yếu và sẽ không đạt được mục tiêu doanh số khiêm tốn là 500 triệu USD vào năm 2024. Triển vọng của hệ thống AI rack-based sắp ra mắt mang tên Jaguar Shores cũng rất bấp bênh—đặc biệt là khi Nvidia sẽ xuất xưởng các hệ thống Blackwell với số lượng lớn trong 12 tháng tới. “Intel không có sự hiện diện đáng kể nào trong mảng AI trung tâm dữ liệu,” Rick Schafer của Oppenheimer viết trong một ghi chú gửi khách hàng vào thứ Sáu. “Chúng tôi không kỳ vọng điều đó sẽ thay đổi trước năm 2027.”

Intel sẽ trông như thế nào vào thời điểm đó vẫn là một dấu hỏi lớn. Gã khổng lồ chip từng rất giàu tiền mặt đã tiêu tốn gần 15,7 tỷ USD trong năm ngoái—năm thứ ba liên tiếp có dòng tiền tự do âm—khi theo đuổi kế hoạch tái cấu trúc đầy tham vọng để bắt kịp công nghệ sản xuất, xây dựng mảng xưởng đúc chip cho các công ty khác và ngăn chặn sự mất thị phần trước sự cạnh tranh mạnh mẽ từ Nvidia và Advanced Micro Devices.

“Cách dễ nhất để giải quyết những câu hỏi này là đưa ra các sản phẩm tốt hơn, nhưng rõ ràng điều đó sẽ cần thời gian,” Joseph Moore của Morgan Stanley viết vào thứ Sáu. Tuy nhiên, theo FactSet, các nhà phân tích dự đoán Intel sẽ tiếp tục đốt 9,9 tỷ USD trong năm nay. Cổ phiếu Intel cũng đã mất hơn một nửa giá trị trong năm qua và giảm gần 17% kể từ khi CEO Pat Gelsinger bất ngờ bị sa thải vào tháng 12. Thời gian không còn là thứ Intel có nhiều nữa.

Liên hệ với Dan Gallagher tại [email protected]

Intel Shows Why Nvidia Is Still Hard to Beat

Nvidia’s shares took a beating on the DeepSeek news, but Intel’s struggles to break into the AI chip market keep growing

By

Dan Gallagher

Feb. 3, 2025 5:30 am ET

Intel has decided against bringing its Falcon Shores chip to market. Falcon Shores is the same type of chip that has made Nvidia a force in artificial intelligence.

Nvidia might look a little less invincible these days. But Intel has just shown that challenging the AI powerhouse is still no easy task.

Intel’s fourth-quarter report late Thursday followed a bruising week for Nvidia. The designer of artificial-intelligence chips and computing systems shed more than 18% of its market value after the world caught wind of technical breakthroughs by Chinese AI startup DeepSeek. Those developments suggested it is possible to build advanced AI models on a relatively low computing cost, which many believed could lead to lower demand for Nvidia’s products.

That outcome is still far from certain. Mark Zuckerberg, chief executive of Meta Platforms and one of Nvidia’s largest customers, said during his own earnings call last week that “it’s way too early” to know whether DeepSeek’s developments will lead to lower capital-spending needs for AI. But he added that more powerful computing will still lead to better AI systems, so “investing very heavily in capex and infra is going to be a strategic advantage over time.” Meta plans to spend as much as $65 billion in capex this year, compared with just under $40 billion last year.

Intel might not be getting much of a piece of that, though. In the chip maker’s own fourth-quarter earnings call late Thursday, Intel Co-CEO Michelle Johnston Holthaus said the company has decided to not bring its Falcon Shores chip to market. Intel had been planning to launch the GPU accelerator—the same type of chip that has made Nvidia the name to beat in artificial intelligence—later this year. But citing “industry feedback,” Holthaus said the company has decided to use Falcon Shores as an internal test chip only, as it develops a rack-based system for AI computing.

That still puts Intel in the position of challenging Nvidia on the latter’s home turf. Nvidia’s latest chip family, known as Blackwell, is also available on server racks, some versions of which are so demanding that they require liquid-based cooling systems to be installed in the data centers that use them. That still isn’t cooling demand for those products; analysts expect revenue from the Blackwell family alone to surpass $75 billion in Nvidia’s next fiscal year, which ends in January 2026, according to Visible Alpha. Intel’s entire business is projected to generate just over $53 billion in revenue for roughly the same period.

Falcon Shores isn’t Intel’s first flameout in trying to go after Nvidia. In its third-quarter call three months ago, Intel said the third version of its Gaudi AI accelerator chip was seeing weak demand and would fall short of its modest sales target of $500 million for 2024. The outlook for its coming rack-based system called Jaguar Shores is also highly uncertain—especially because Nvidia will be shipping Blackwell systems in high volume over the next 12 months. “Intel has no meaningful [data center] AI presence,” Rick Schafer of Oppenheimer wrote in a note to clients on Friday. “We don’t expect that to change before 2027.”

What Intel even looks like as a company by that point is a big question mark. The once-flush chip giant burned nearly $15.7 billion in cash last year—its third straight year of negative free cash flow—as it pursues an ambitious turnaround plan to catch up its manufacturing technology, builds a foundry business that makes chips for other companies, and stems the market-share loss its own products have been experiencing because of robust competition from the likes of Nvidia and Advanced Micro Devices.

“The easiest way to address these questions is to see better products come to market, and that’s clearly going to take time,” wrote Joseph Moore of Morgan Stanley on Friday. But analysts are projecting a cash burn of $9.9 billion this year, according to FactSet. Intel’s stock also has lost more than half its value over the past year, and nearly 17% since the surprise push-out of CEO Pat Gelsinger in December. Time is something that Intel no longer has in abundance.

Write to Dan Gallagher at [email protected]

https://www.business-standard.com/technology/tech-news/global-tech-firms-nvidia-amd-hpe-in-talks-with-govt-for-indigenous-gpus-125020301433_1.html

Global tech giants collaborate with India on GPUs and AI development

India leads AI-driven workplace transformation, reportIndia emerges a key smartphone market amid Chinese dominanceBudget has been kind to IndiaAI mission, Semiconductor 2.0 shortchangedIndia’s electronics sector set to gain from US tariff on ChinaBSNL budget allocation cut by 59%, down to ₹33,757.58 crore in 2025Union Budget earmarks ₹9,000 crore for electronics PLI schemeUnion Budget-DoS gets ₹13,416.2 cr in budget, up from ₹11,725.7 crUnion Budget-Govt expects 33 pc lower revenue from telecom at Rs 82,443 cr in FY26Union Budget-Govt to expand broadband under BharatNetUnion Budget to enhance infra, electronics manufacturingUnion Budget 2025-26: Telecom & Enterprise Networks, Industry RespondsMHA mandates telcos test TCIL’s anti-spam solution for 90 daysIndia to launch its own safe & secure indigenous AI modelIndian industry warming up to DeepSeekEconomic Survey to be tabled in Parliament’s Budget Session, starts todayUnion Budget Expectations, Ambrane IndiaGovt to launch new PLI scheme for telecom equipment manufacturingNxtGen, E2E, and Jio emerge lowest bidders for IndiaAI mission GPUsBSNL going strong with TCSJio’s new voice and SMS plans receive backlash from usersTech firms may go to Court, as Govt readies for upper 6GHz band auctionVodafone makes world’s first satellite video call using standard smartphoneMicrosoft, Meta defend hefty AI spendingWith MTNL loans turning into NPAs, PSBs head for 20% haircutTake Control of Your Data- Data Privacy Day celebratedIndia takes ‘wait and watch’ approach to China’s AI disruptionTelangana govt to develop two new IT parks in Hyderabad suburbsIndia lacks funding, infrastructure to lead in AI, say VCsStarlink accepts govt terms for India satellite broadband licenseBSNL joins hands with Skypro & PlayboxTV launched ‘IFTV’ in IndiaAssam to become semiconductor hub, electronic city to rise in JagiroadOf 29 companies interested initially, 3 bid for BSNL’s 5G tenderIndia tops global app market with 25 billion downloadsMeitY calls for proposals to build India’s own AI foundation modelPre-budget recommendations, SEMIAdani, Ambani join legal battle against OpenAIPre-budget recommendations, NasscomA PLI scheme for non-electronic components in the offingTRAI seems keen to delay 2G upgradesDraft DPDP rules pave way for startup boom in consent managementSC, not the govt is authorised to waive off AGRAirtel set to compete with Starlink in satellite internet raceRandeep Sekhon appointed Non-Executive Director, Dialog Axiata PLCGovt revisiting AGR definition, might result in ₹82000cr relief for non telcosStargate initiative’s scale and scope present collateral opportunities for IndiaGujarat positions itself as IT hub with nearly ₹7,000 cr investmentReliance and Nvidia to build world’s largest data center in JamnagarIndia poised to take global lead in AI innovationHow Starlink’s arrival in Bangladesh may affect telecom market

Global tech giants collaborate with India on GPUs and AI development

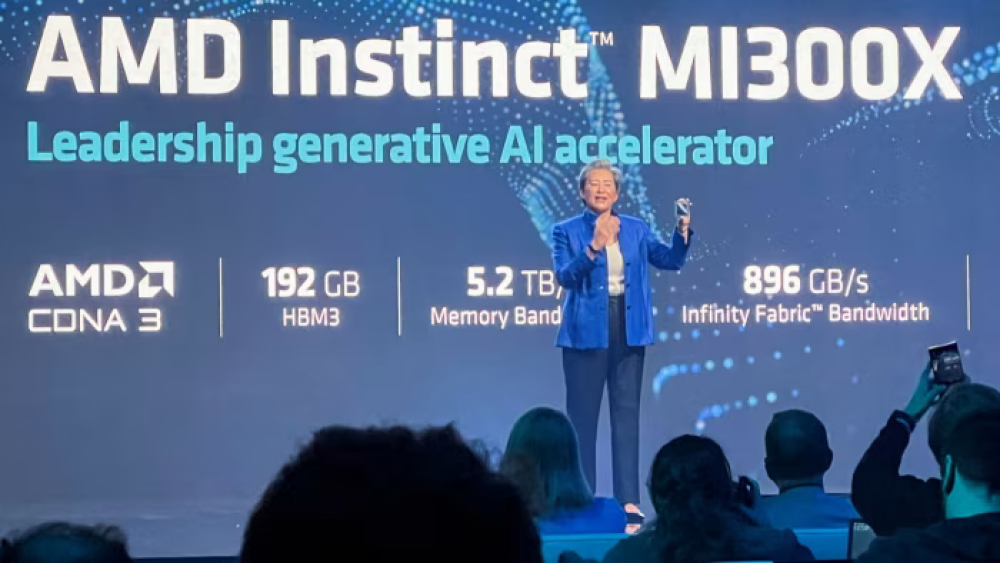

Three global technology players — Hewlett Packard Enterprise (HPE), Advanced Micro Devices (AMD), and Nvidia — are in discussions with the Indian government for a collaborative effort to help design and develop “indigenous” graphic processing units (GPUs), as well as in building the artificial intelligence (AI) ecosystem in the country.

Talks are ongoing, according to a senior government official, with an announcement on the final terms of collaboration expected soon. A spokesperson for Nvidia declined to comment, while HPE and AMD did not respond to queries.

In a recent interview with Business Standard, Minister for Electronics and Information Technology, Railways, and Information & Broadcasting Ashwini Vaishnaw stated that the government has begun consultations with the industry on India-designed GPUs and will support the initiative. He added that discussions have already taken place with the Centre for Development of Advanced Computing, as well as with global firms that could assist in the effort.

These discussions come as the Ministry of Electronics and Information Technology (Meity) finalises a list of companies empaneled to receive government support for procuring GPUs and developing computing infrastructure critical for AI. The government has received offers for more than 18,000 GPUs — nearly double its initial target of 10,000. For context, India’s largest supercomputer currently operates on 700 GPUs.

Industry applications, according to sources, include a range of GPUs, such as Nvidia’s H100, H200, A100, and L4; AMD’s MI 325X; and Intel’s Gaudi-2, among others.

Prices for on-demand computing start as low as Rs 64 per hour, according to industry sources. Vaishnaw has said the government aims to provide computing power to startups, research centers, and universities at roughly $1 per hour — one of the lowest rates globally.

While the proposed India-designed GPUs may not match the world’s most advanced processing power, sources familiar with the matter say they will offer a cost-effective solution with potential for innovation in AI applications. A similar approach has been seen in China, where the DeepSeek generative AI tool has developed a lower-cost model compared to ChatGPT, relying on less advanced GPUs with reduced processing power.

The Indian government is also considering asking proposals from startups and developers, offering incentives to create foundational AI models under its Rs 10,000 crore AI mission. Vaishnaw, in a recent press conference, stated that six developers are currently working on foundational AI models in the country.

Nvidia, for its part, has expressed interest in co-developing a chip in India by leveraging the country’s chip design capabilities. HPE plays a critical role in providing server infrastructure optimised for GPUs, enhancing AI-driven computational workloads. AMD, an old player in the GPU market since its 2006 acquisition of ATI Technologies, has advocated for a collaborative AI ecosystem, warning that monopolisation could stifle innovation and harm everyone. Business Standard

India leads AI-driven workplace transformation, report

We create rich business content, reach targeted business audiences, and provide valuable business information to our readers.

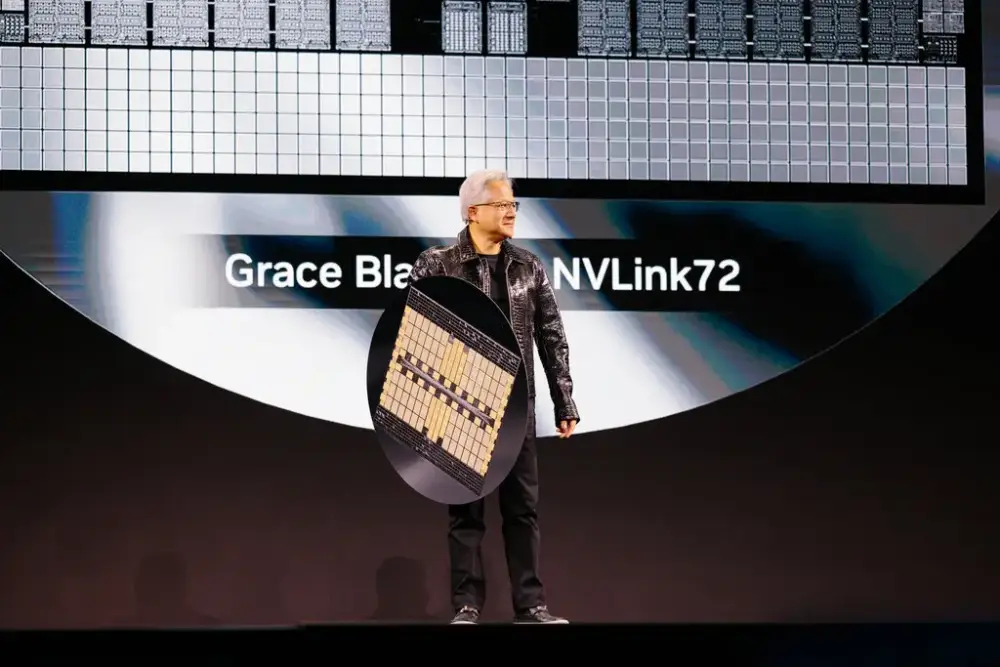

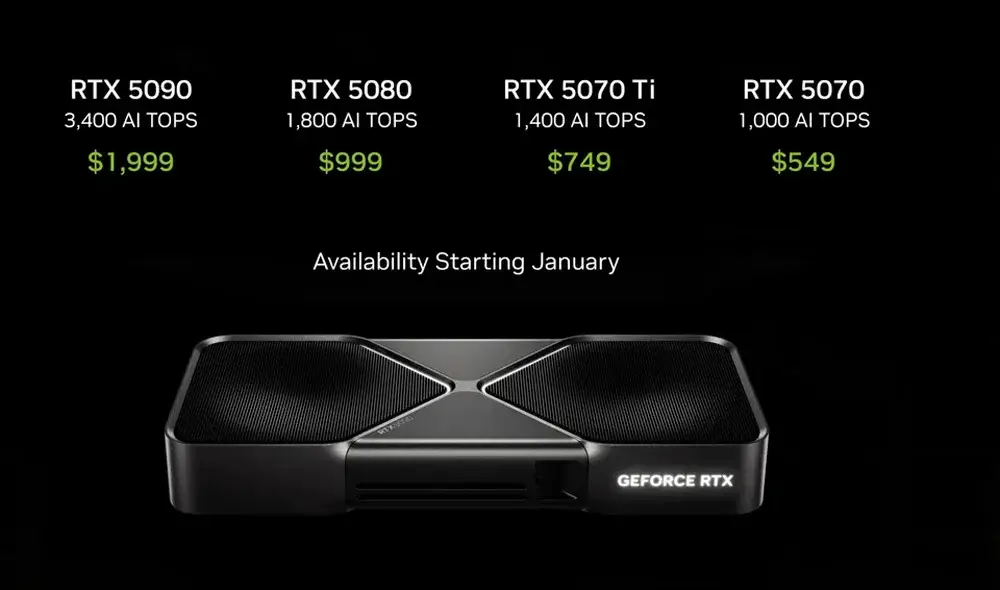

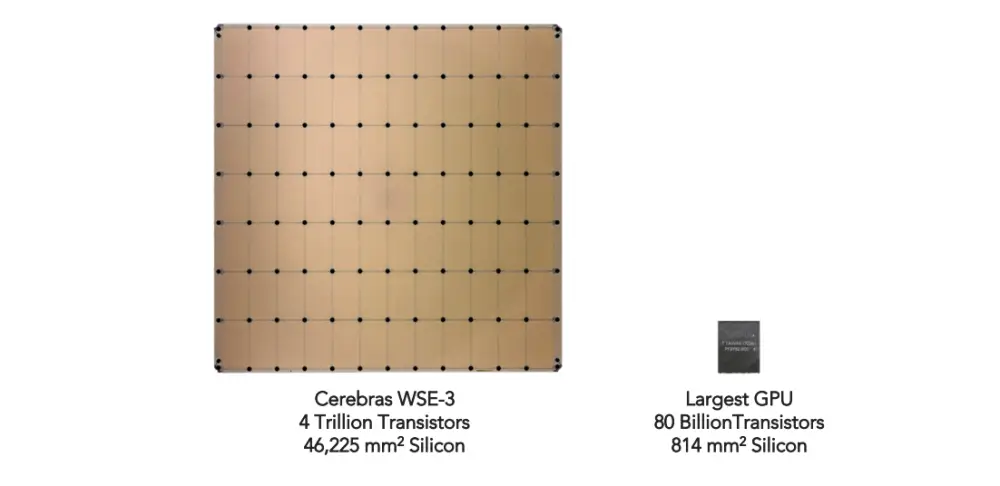

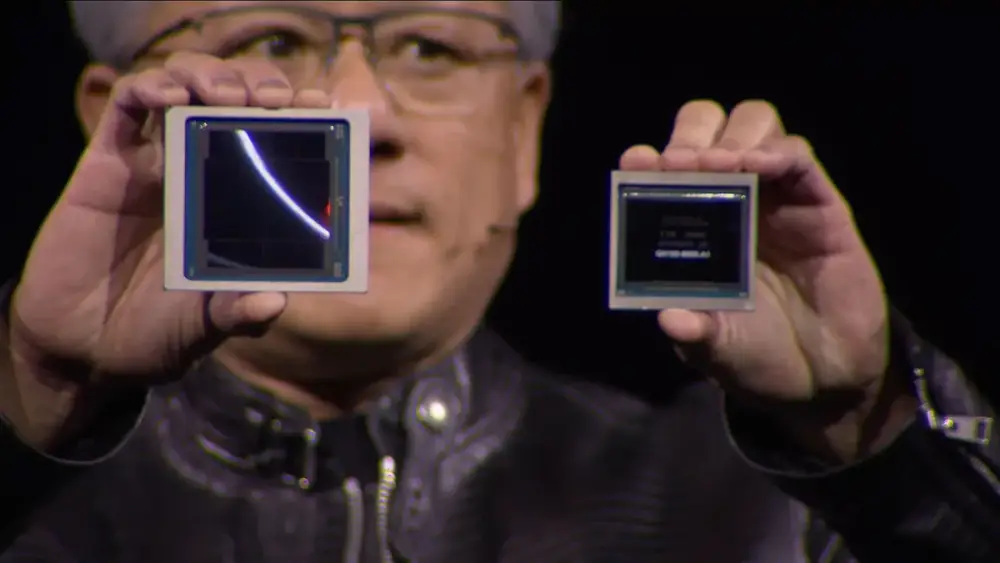

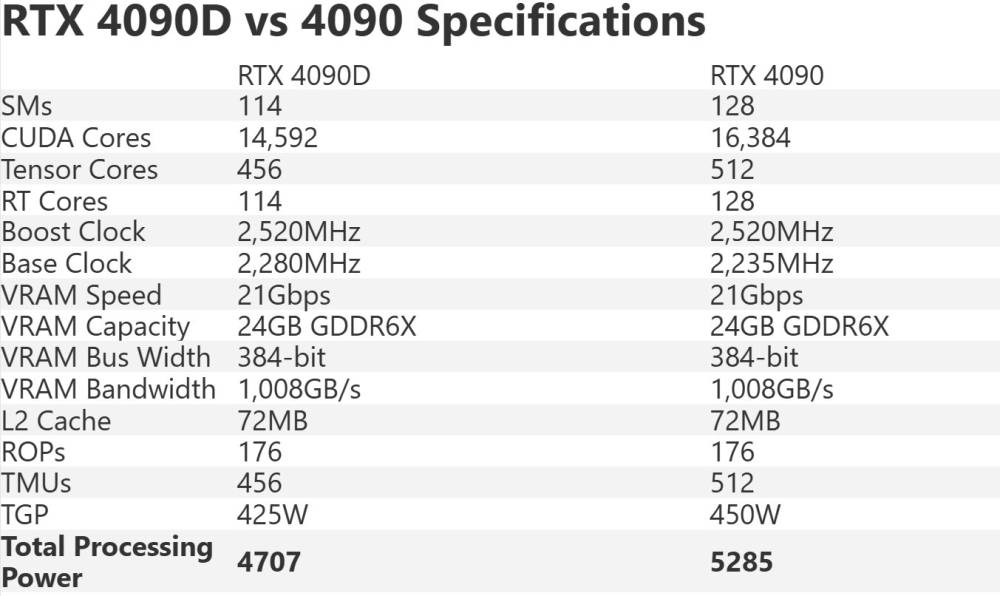

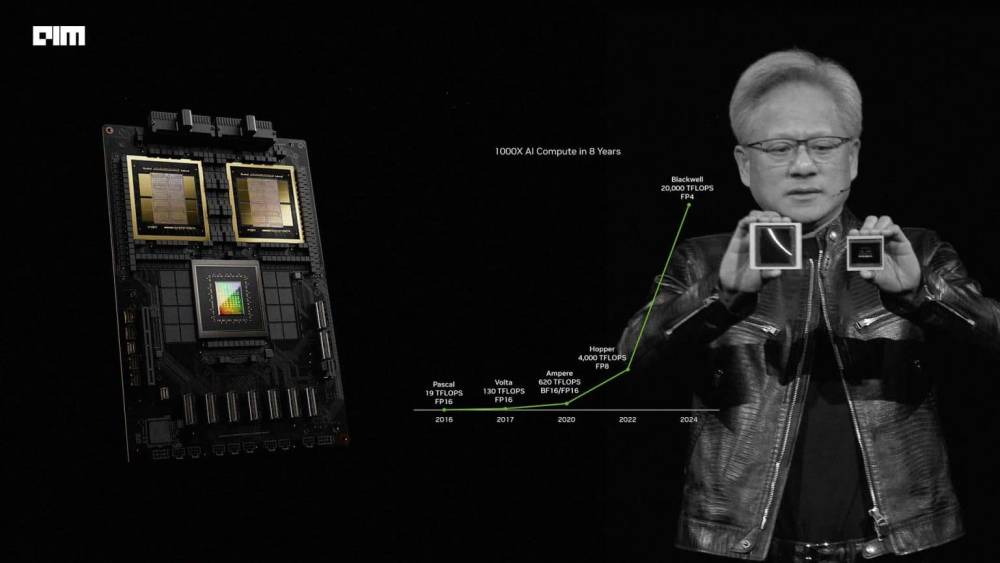

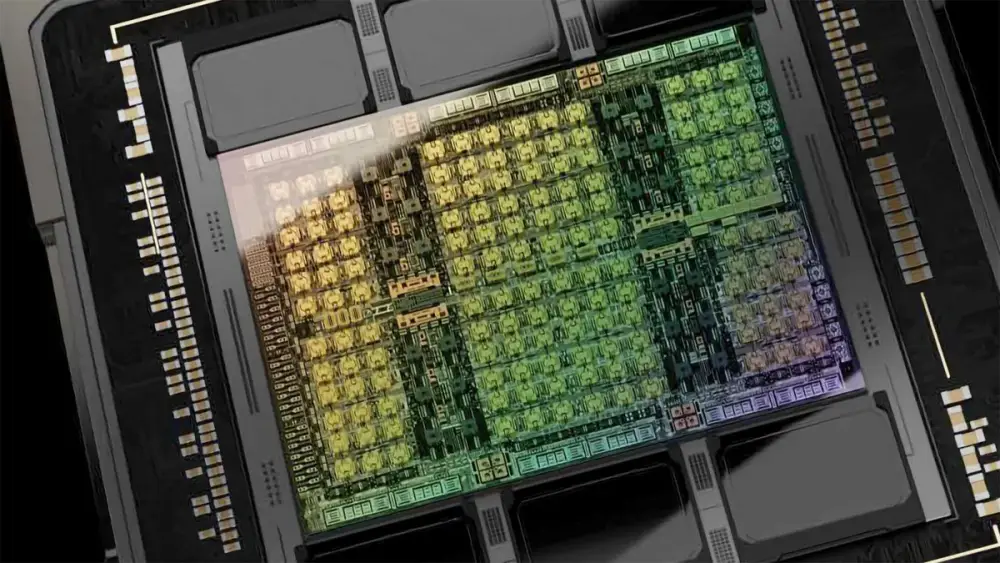

- Nvidia công bố dòng GPU RTX 50-series mới có thể chạy các mô hình DeepSeek nhanh nhất trên thị trường PC

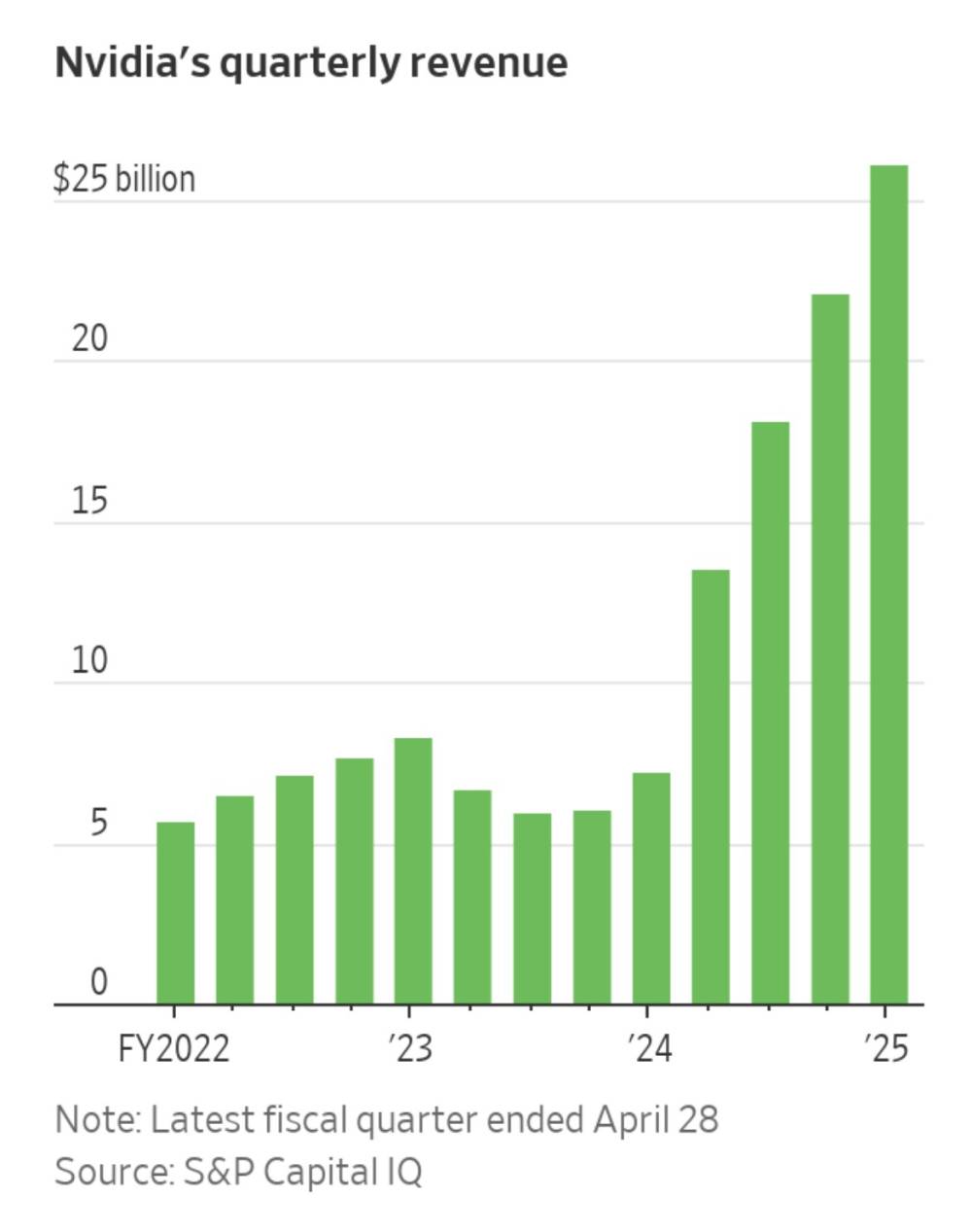

- Thị trường vốn hóa của Nvidia vừa chịu tổn thất một ngày lớn nhất trong lịch sử các công ty Mỹ, nguyên nhân chính đến từ DeepSeek

- DeepSeek chứng minh mô hình suy luận R1 của họ không cần phần cứng Nvidia mạnh mẽ vẫn đạt hiệu suất tương đương mô hình o1 của OpenAI

- Công ty Trung Quốc này đã tiết kiệm được chi phí đáng kể trong quá trình huấn luyện mô hình

- DeepSeek sử dụng GPU H800 yếu hơn của Nvidia - phiên bản được phép xuất khẩu sang Trung Quốc theo quy định của chính phủ Mỹ

- Nvidia khẳng định GPU RTX 50-series mới dựa trên kiến trúc Blackwell, cung cấp hiệu suất suy luận tối đa cho DeepSeek trên PC

- Trung Quốc chỉ nhận được phiên bản RTX 5090 ít mạnh mẽ hơn

- Các công ty công nghệ khác cũng đang tận dụng làn sóng DeepSeek: AWS và Microsoft đã tích hợp R1 vào nền tảng của họ

- Microsoft và OpenAI đang điều tra khả năng DeepSeek sử dụng dữ liệu của OpenAI theo báo cáo từ Bloomberg

📌 Thành công của DeepSeek với mô hình R1 đã gây ra cú sốc lớn cho Nvidia khi chứng minh không cần GPU cao cấp vẫn có thể phát triển AI hiệu quả. Điều này khiến Nvidia mất giá trị vốn hóa kỷ lục trong một ngày và có thể ảnh hưởng đến vị thế độc quyền của công ty trong tương lai.

https://www.theverge.com/news/604412/nvidia-rtx-50-series-gpus-deepseek

- DeepSeek trở thành chủ đề nóng trong tuần khi công bố chi phí đào tạo mô hình AI chỉ 5,576 triệu USD, dựa trên giá thuê GPU của Nvidia

- Ứng dụng DeepSeek Assistant vượt qua ChatGPT để đứng đầu bảng xếp hạng ứng dụng miễn phí trên App Store của Apple tại Mỹ