AI edge

View All

• Mô hình ngôn ngữ lớn (LLM) như GPT-4, Claude, PaLM và Llama đang thống trị lĩnh vực AI nhưng đòi hỏi tài nguyên tính toán và cơ sở hạ tầng lớn

• Mô hình ngôn ngữ nhỏ (SLM) là giải pháp thay thế với số lượng tham số từ vài triệu đến vài tỷ, phù hợp cho thiết bị có tài nguyên hạn chế

• Ưu điểm của SLM trên thiết bị biên:

- Xử lý thời gian thực không có độ trễ

- Tiết kiệm năng lượng

- Bảo mật dữ liệu tốt hơn nhờ xử lý cục bộ

• Thách thức chính khi triển khai SLM:

- Tài nguyên tính toán hạn chế

- Bộ nhớ và lưu trữ giới hạn

- Thời lượng pin ngắn

• Chiến lược tối ưu hóa SLM:

- Nén mô hình và lượng tử hóa để giảm kích thước

- Chưng cất tri thức từ mô hình lớn sang nhỏ

- Học liên hợp trực tiếp trên thiết bị

• Công cụ và framework hỗ trợ:

- TensorFlow Lite (LiteRT)

- ONNX Runtime

- MediaPipe của Google

• Ứng dụng thực tế:

- Dịch ngôn ngữ thời gian thực

- Nhận dạng giọng nói

- IoT công nghiệp

- Thiết bị y tế

- Hệ thống an ninh thông minh

📌 SLM mở ra kỷ nguyên mới cho AI trên thiết bị biên với ưu điểm về hiệu quả, bảo mật và xử lý thời gian thực. Mô hình này chỉ yêu cầu từ vài triệu đến vài tỷ tham số, phù hợp triển khai trên smartphone, thiết bị đeo và IoT mà không cần kết nối cloud.

https://www.forbes.com/councils/forbestechcouncil/2024/11/15/scaling-small-language-models-slms-for-edge-devices-a-new-frontier-in-ai/

- Focais Meet One là thiết bị ghi âm thông minh tích hợp AI, hỗ trợ ghi âm, phiên âm và dịch thuật tự động

- Thiết bị hỗ trợ hơn 120 ngôn ngữ, phù hợp với môi trường đa ngôn ngữ và giao tiếp quốc tế

- Kích thước nhỏ gọn 2,4 x 2,4 x 0,3 inch (khoảng 6 x 6 x 0,76 cm), trọng lượng chỉ 0,27 kg

- Pin sử dụng liên tục 20 giờ sau mỗi lần sạc đầy

- Tính năng từ tính cho phép gắn thiết bị lên bề mặt kim loại

- Tự động tóm tắt các cuộc hội thoại dài thành nội dung ngắn gọn, súc tích

- Đồng bộ hóa với ứng dụng di động để quản lý transcription, dịch thuật và tóm tắt trong một nơi

- Giá bán ưu đãi 99,99 USD (giảm 32% so với giá gốc 149 USD)

- Phù hợp với nhiều đối tượng: người làm văn phòng, sinh viên, người thường xuyên tham gia họp và gọi điện

- Vượt trội hơn ứng dụng Voice Memos trên iPhone với các tính năng chuyên biệt cho ghi âm

📌 Focais Meet One là thiết bị ghi âm AI đa năng với khả năng hỗ trợ 120 ngôn ngữ, pin 20 giờ, tự động phiên âm và tóm tắt nội dung. Giá ưu đãi 99,99 USD (giảm 32%), phù hợp cho người dùng đa ngôn ngữ và môi trường làm việc quốc tế.

https://www.cultofmac.com/daily-deals/focais-meet-one-ai-voice-recorder

• AMD vừa công bố OLMo, dòng mô hình ngôn ngữ lớn (LLM) 1 tỷ tham số đầu tiên được công ty phát triển và đào tạo nội bộ

• OLMo được đào tạo trên hàng nghìn tỷ token sử dụng cụm GPU Instinct MI250 của AMD

• Đây là LLM thứ hai AMD tự phát triển, sau mô hình nhỏ AMD-135M ra mắt tháng 9/2024

• OLMo dựa trên mô hình cùng tên do AI2 (trước đây là Viện Allen về Trí tuệ nhân tạo) phát triển ban đầu

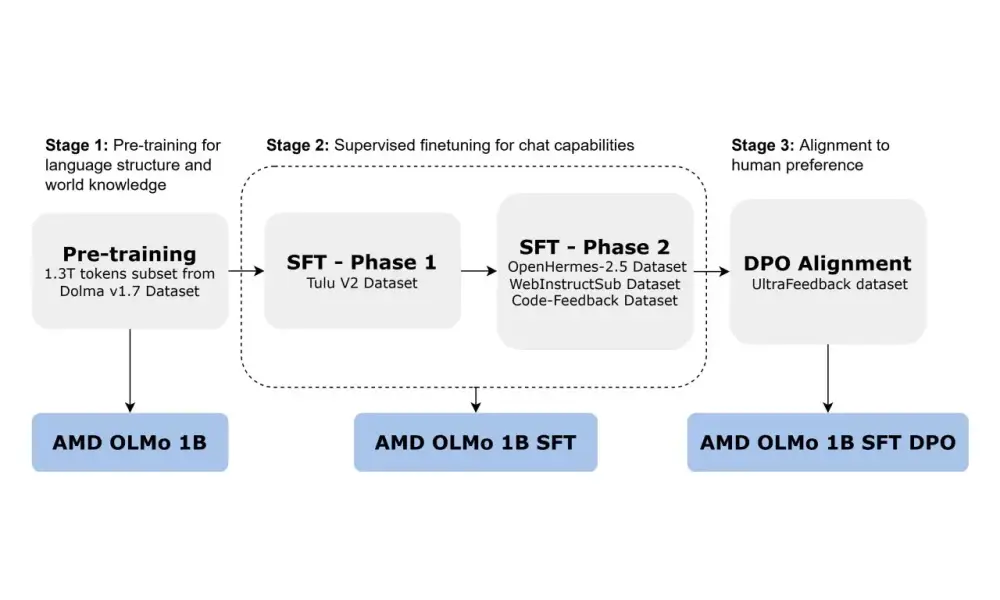

• AMD OLMo có 3 biến thể:

- OLMo 1B: Được tiền đào tạo trên 1,3 nghìn tỷ token từ tập dữ liệu Dolma v1.7

- OLMo 1B SFT: Được tinh chỉnh có giám sát trên các bộ dữ liệu Tulu V2, OpenHermes-2.5, WebInstructSub và Code-Feedback

- OLMo 1B SFT DPO: Được tinh chỉnh thêm để phản ánh tốt hơn sở thích của con người thông qua tối ưu hóa ưu tiên trực tiếp

• Các mô hình này sử dụng kiến trúc transformer chỉ giải mã, phù hợp cho ứng dụng chatbot

• So với các mô hình nguồn mở cùng kích thước:

- OLMo 1B đạt độ chính xác trung bình 48,77% trên các tác vụ suy luận tổng quát, tương đương OLMo-0724-hf (49,3%) nhưng với chi phí đào tạo chỉ bằng một nửa

- Cải thiện độ chính xác trên ARC-Easy (+6,36%), ARC-Challenge (+1,02%) và SciQ (+0,50%)

• So với các mô hình cơ sở được tinh chỉnh theo hướng dẫn:

- OLMo 1B SFT cải thiện đáng kể độ chính xác trên MMLU (+5,09%) và GSM8k (+15,32%)

- Hiệu suất trên GSM8k (18,2%) vượt trội so với mô hình cơ sở tốt nhất tiếp theo (TinyLlama-1.1B-Chat-v1.0 ở mức 2,81%)

• AMD mở mã nguồn toàn bộ dữ liệu, trọng số, công thức đào tạo và mã của OLMo nhằm thúc đẩy sự đổi mới trong cộng đồng

• Động thái này cũng nhằm quảng bá sức mạnh của bộ xử lý AMD so với các đối thủ như Nvidia và Intel trong lĩnh vực AI

📌 AMD ra mắt OLMo - dòng LLM 1 tỷ tham số nguồn mở đầu tiên, đạt hiệu suất vượt trội so với các mô hình cùng phân khúc trên nhiều tiêu chuẩn đánh giá. Với 3 biến thể và quá trình đào tạo 3 giai đoạn, OLMo thể hiện khả năng suy luận và tuân theo hướng dẫn tốt hơn, đồng thời quảng bá sức mạnh GPU Instinct của AMD trong lĩnh vực AI.

https://thelettertwo.com/2024/11/03/amd-unveils-olmo-its-first-fully-open-1b-parameter-llm-series/

• Mistral, startup AI của Pháp, vừa công bố dòng mô hình AI tạo sinh đầu tiên được thiết kế để chạy trên các thiết bị biên như laptop và điện thoại.

• Dòng mô hình mới có tên "Les Ministraux", bao gồm 2 mô hình: Ministral 3B và Ministral 8B.

• Cả hai mô hình đều có cửa sổ ngữ cảnh 128.000 token, tương đương với khả năng xử lý nội dung dài khoảng 50 trang sách.

• Les Ministraux được phát triển nhằm đáp ứng nhu cầu suy luận cục bộ, đảm bảo quyền riêng tư cho các ứng dụng quan trọng như dịch thuật trên thiết bị, trợ lý thông minh không cần internet, phân tích cục bộ và robot tự hành.

• Ministral 8B đã có sẵn để tải về, nhưng chỉ dành cho mục đích nghiên cứu. Các nhà phát triển và doanh nghiệp muốn triển khai Ministral 8B hoặc Ministral 3B cần liên hệ Mistral để được cấp giấy phép thương mại.

• Các nhà phát triển có thể sử dụng Ministral 3B và Ministral 8B thông qua nền tảng đám mây Le Platforme của Mistral và các đám mây đối tác khác trong những tuần tới.

• Giá sử dụng: Ministral 8B có giá 10 cent cho mỗi triệu token đầu ra/đầu vào (khoảng 750.000 từ), trong khi Ministral 3B có giá 4 cent cho mỗi triệu token.

• Xu hướng hướng tới các mô hình nhỏ gọn đang gia tăng, với các ưu điểm như chi phí thấp hơn, nhanh hơn trong việc huấn luyện, tinh chỉnh và chạy so với các mô hình lớn hơn.

• Mistral tuyên bố Ministral 3B và Ministral 8B vượt trội hơn các mô hình Llama và Gemma tương đương, cũng như mô hình Mistral 7B của chính họ, trong nhiều bài kiểm tra AI đánh giá khả năng tuân theo hướng dẫn và giải quyết vấn đề.

• Mistral, có trụ sở tại Paris, gần đây đã huy động được 640 triệu USD vốn đầu tư mạo hiểm và đang dần mở rộng danh mục sản phẩm AI của mình.

• Trong vài tháng qua, công ty đã ra mắt dịch vụ miễn phí cho các nhà phát triển để thử nghiệm mô hình, SDK cho phép khách hàng tinh chỉnh các mô hình đó, và các mô hình mới bao gồm mô hình tạo sinh cho mã có tên Codestral.

• Mistral được đồng sáng lập bởi các cựu nhân viên của Meta và DeepMind của Google, với sứ mệnh tạo ra các mô hình hàng đầu có thể cạnh tranh với các mô hình hiệu suất cao nhất hiện nay như GPT-4 của OpenAI và Claude của Anthropic.

• Mặc dù việc kiếm tiền vẫn còn là thách thức, Mistral được cho là đã bắt đầu tạo ra doanh thu vào mùa hè này.

📌 Mistral ra mắt Les Ministraux - mô hình AI nhỏ gọn cho thiết bị cạnh, với 2 phiên bản 3B và 8B. Mô hình có cửa sổ ngữ cảnh 128.000 token, giá từ 4-10 cent/triệu token, vượt trội so với đối thủ trong các bài kiểm tra AI. Mistral tiếp tục mở rộng danh mục sản phẩm sau khi huy động 640 triệu USD vốn.

https://techcrunch.com/2024/10/16/mistral-releases-new-ai-models-optimized-for-edge-devices/

• Tầm quan trọng của hiệu quả năng lượng trong suy luận AI:

- Góp phần vào tính bền vững và giảm tác động môi trường

- Tăng hiệu quả chi phí bằng cách giảm chi phí vận hành

- Kéo dài tuổi thọ thiết bị edge, đặc biệt là các thiết bị chạy bằng pin

• Các kỹ thuật để suy luận AI tiết kiệm năng lượng:

- Nén mô hình: cắt tỉa, lượng tử hóa và chưng cất kiến thức để tối ưu hóa mô hình AI

- Tăng tốc phần cứng: sử dụng GPU, TPU và bộ xử lý tiết kiệm năng lượng chuyên dụng

- Hợp tác edge-cloud: cân bằng giữa tính toán trên thiết bị edge và đám mây

• Thách thức trong việc đạt được hiệu quả năng lượng:

- Hạn chế về tài nguyên trên các thiết bị edge

- Cân bằng giữa độ chính xác, hiệu suất và tiêu thụ năng lượng

• Đổi mới trong AI tiết kiệm năng lượng:

- Chip AI tiêu thụ điện năng thấp: hiệu suất cao với mức tiêu thụ điện năng tối thiểu

- Khung edge AI: tối ưu hóa việc triển khai mô hình AI trên thiết bị edge

• Tương lai của AI trên edge:

- Điện toán thần kinh: mô phỏng kiến trúc não người để tăng hiệu quả năng lượng

- Học liên kết: đào tạo mô hình AI cộng tác trên nhiều thiết bị edge

• Lợi ích của việc tập trung vào hiệu quả năng lượng:

- Kéo dài tuổi thọ thiết bị edge

- Giảm chi phí vận hành

- Đóng góp vào tương lai bền vững hơn cho việc triển khai AI

📌 AI trên edge đang phát triển với các giải pháp tiết kiệm năng lượng như chip AI công suất thấp và khung edge AI. Điện toán thần kinh và học liên kết hứa hẹn tương lai bền vững hơn cho AI, cân bằng hiệu suất và tiêu thụ năng lượng trên thiết bị edge.

https://www.forbes.com/councils/forbestechcouncil/2024/09/25/ai-on-edge-achieving-energy-efficiency-in-inference-processes/

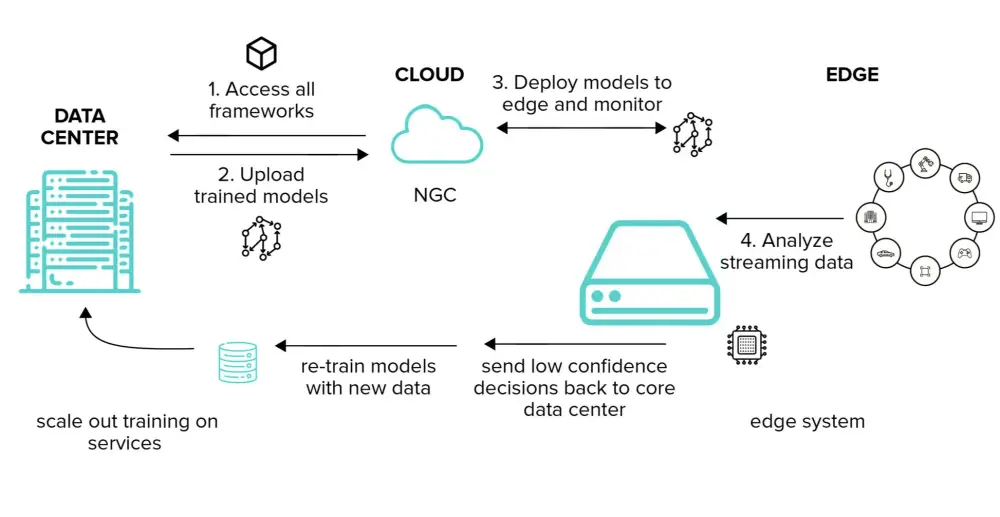

• Điện toán đám mây cung cấp nền tảng tính toán và khả năng mở rộng để huấn luyện mô hình AI và lưu trữ dữ liệu lớn. AI biên cho phép chạy các mô hình này trên thiết bị cục bộ, giảm độ trễ và tăng hiệu quả.

• Điện toán đám mây có 3 ưu điểm chính trong AI: lưu trữ dữ liệu lớn, huấn luyện mô hình nhanh chóng nhờ xử lý phân tán, và suy luận AI tập trung cho các bộ dữ liệu phức tạp.

• AI biên xử lý dữ liệu cục bộ trên thiết bị, mang lại độ trễ thấp, tiết kiệm băng thông, bảo mật dữ liệu và khả năng hoạt động ngoại tuyến. Tuy nhiên, thiết bị biên có sức mạnh xử lý hạn chế.

• Sự kết hợp giữa đám mây và biên tạo ra hệ thống AI lai hiệu quả hơn. Mô hình được huấn luyện trên đám mây và triển khai trên thiết bị biên để suy luận. Xử lý kết hợp giữa biên và đám mây cũng được áp dụng.

• Học liên kết là phương pháp mới, huấn luyện mô hình cục bộ trên thiết bị biên và chỉ gửi cập nhật lên đám mây, tăng cường bảo mật.

• Các ứng dụng tiêu biểu bao gồm: xe tự lái, thành phố thông minh, chăm sóc sức khỏe và IoT công nghiệp. Ví dụ xe tự lái sử dụng AI biên để ra quyết định thời gian thực và đám mây để lưu trữ dữ liệu lái xe.

• Trong tương lai, mạng 5G sẽ cải thiện giao tiếp giữa đám mây và biên. Học liên kết sẽ phát triển để tăng cường bảo mật. Phần cứng tính toán biên tiên tiến sẽ cho phép xử lý AI phức tạp hơn ở biên.

📌 Sự kết hợp giữa điện toán đám mây và AI biên đang mở ra những khả năng mới trong ứng dụng AI. Với ưu điểm bổ sung cho nhau, chúng tạo ra hệ thống AI hiệu quả, phản hồi nhanh và có khả năng mở rộng cao, ứng dụng trong nhiều lĩnh vực từ xe tự lái đến chăm sóc sức khỏe. Các công nghệ như 5G và học liên kết sẽ thúc đẩy sự phát triển này trong tương lai.

https://www.geeky-gadgets.com/cloud-computing-role-edge-ai/

• Edge AI là khái niệm về việc thực hiện các quy trình AI cục bộ trên thiết bị, thay vì trên đám mây hoặc trung tâm dữ liệu tập trung. Đây là sự đảo ngược so với xu hướng chuyển lên đám mây trong 15 năm qua.

• Lợi ích của Edge AI bao gồm khả năng mở rộng, độ trễ thấp hơn, bảo mật và quyền riêng tư tốt hơn. Nó phù hợp cho các quy trình cần xử lý nhiều tài nguyên mà việc liên tục gửi dữ liệu qua lại sẽ tốn kém.

• Các chuyên gia ước tính có khoảng 300 triệu AI PC đang hoạt động độc lập. Điều này tạo ra nhu cầu về kiến trúc và phần cứng mới, trong đó CPU trở thành GPU và GPU trở thành NPU để xử lý các hoạt động mạng neural.

• Edge AI đang được ứng dụng trong xe tự lái, chẩn đoán AI tại bệnh viện và nông nghiệp. Nó giúp các ứng dụng này hiệu quả hơn.

• IBM định nghĩa edge computing là một framework điện toán phân tán đưa các ứng dụng doanh nghiệp đến gần hơn với nguồn dữ liệu như thiết bị IoT hoặc máy chủ cạnh cục bộ.

• Việc xử lý gần nguồn dữ liệu mang lại lợi ích kinh doanh như thông tin chi tiết nhanh hơn, thời gian phản hồi cải thiện và băng thông tốt hơn.

• Edge AI đang được nghiên cứu và phát triển tại các trường đại học hàng đầu như MIT.

• Xu hướng này đánh dấu sự chuyển dịch từ đám mây về thiết bị cục bộ trong thời đại AI, chú trọng hơn vào chất lượng thay vì chỉ cắt giảm chi phí như trước đây.

• Các nhà điều hành và doanh nghiệp đang quan tâm đến Edge AI như một công nghệ tự động hóa mới đầy tiềm năng.

📌 Edge AI đang thay đổi cách xử lý AI, chuyển từ đám mây về thiết bị cục bộ để tăng hiệu quả và bảo mật. Với 300 triệu AI PC ước tính, xu hướng này mở ra cơ hội cho kiến trúc phần cứng mới và ứng dụng trong nhiều lĩnh vực như xe tự lái, y tế, nông nghiệp.

https://www.forbes.com/sites/johnwerner/2024/09/09/what-about-edge-ai/

- Baidu khẳng định vị thế dẫn đầu về AI tại Trung Quốc, cho rằng công ty đang ở vị thế tốt để vượt qua thị trường cạnh tranh ngày càng gay gắt, bất chấp doanh thu quý giảm.

- Tuyên bố của Baidu đến giữa cuộc chiến giá AI tại Trung Quốc, nơi các công ty đã cắt giảm giá các mô hình ngôn ngữ lớn được sử dụng để cung cấp các sản phẩm AI tạo sinh.

- CEO Robin Li cho biết: "Cạnh tranh sẽ rất khốc liệt trong 2 đến 3 năm tới" trong cuộc gọi thu nhập sau khi công ty công bố kết quả quý II.

- Li cho biết nền tảng Ernie của công ty xử lý hơn 600 triệu yêu cầu đến hệ thống AI hàng ngày, cao nhất trong các công ty Trung Quốc.

- Baidu, công cụ tìm kiếm hàng đầu của Trung Quốc, thu được phần lớn doanh thu từ quảng cáo. Trong những năm gần đây, công ty đã tăng đầu tư vào AI như một phần của việc chuyển đổi thành "công ty AI".

- Trong ba tháng tính đến tháng 6, doanh thu giảm 0,4% xuống còn 33,93 tỷ nhân dân tệ (4,67 tỷ USD), so với ước tính trung bình của các nhà phân tích là 33,55 tỷ nhân dân tệ (4,57 tỷ USD), theo dữ liệu LSEG.

- Doanh thu từ kinh doanh trực tuyến, chiếm phần lớn doanh thu của công ty, giảm 2% xuống còn 19,2 tỷ nhân dân tệ (2,66 tỷ USD).

- Sự suy giảm phản ánh nền kinh tế Trung Quốc đang phục hồi chậm chạp từ đợt suy thoái thị trường bất động sản, khiến các nhà quảng cáo thắt chặt ngân sách.

- Ernie, nền tảng mô hình ngôn ngữ lớn của Baidu được ca ngợi là đối thủ của GPT của OpenAI, đã được nhúng vào các dịch vụ ứng dụng khác nhau, nhằm cải thiện trải nghiệm người dùng.

- Công ty cũng đã ra mắt phiên bản trả phí của chatbot do Ernie cung cấp cho công chúng sử dụng, đồng thời bán dịch vụ API do Ernie cung cấp cho các nhà phát triển thông qua các dịch vụ điện toán đám mây của mình.

- Li cho biết AI tạo sinh đóng góp 9% vào doanh thu điện toán đám mây 5,1 tỷ nhân dân tệ (0,71 tỷ USD) của Baidu trong quý II, tăng từ 6,9% trong quý I.

- Như một phần của việc đẩy mạnh AI, Baidu cũng đã tăng cường đầu tư vào xe tự hành. Robotaxi Apollo Go của họ hiện đang hoạt động tại nhiều thành phố Trung Quốc, với đội xe lớn nhất 500 xe chạy tại Vũ Hán.

- Trong khi lĩnh vực này vẫn chưa đóng góp đáng kể vào doanh thu, Baidu đã cho biết hoạt động Apollo Go tại Vũ Hán dự kiến sẽ đạt điểm hòa vốn vào cuối năm nay.

- Lợi nhuận ròng điều chỉnh giảm 8% xuống còn 7,4 tỷ nhân dân tệ (1,03 tỷ USD) nhưng vượt mức 6,45 tỷ nhân dân tệ (0,91 tỷ USD) mà các nhà phân tích dự kiến.

- Cổ phiếu niêm yết tại Mỹ của Baidu giảm 3,3% trong giao dịch sớm.

📌 Baidu khẳng định vị thế dẫn đầu về AI tại Trung Quốc giữa cuộc chiến giá AI gay gắt, với nền tảng Ernie xử lý hơn 600 triệu yêu cầu AI hàng ngày. Tuy doanh thu quảng cáo giảm 2% xuống 19,2 tỷ nhân dân tệ (2,66 tỷ USD), nhưng AI tạo sinh đóng góp 9% doanh thu điện toán đám mây 5,1 tỷ nhân dân tệ (0,71 tỷ USD).

https://brandequity.economictimes.indiatimes.com/news/digital/baidu-touts-ai-edge-as-ad-revenue-stalls/112736004

• Theo nghiên cứu gần đây của IDC, gần 80% tổ chức hiện phân loại 3/4 khối lượng công việc edge của họ là quan trọng đối với doanh nghiệp. Sự phát triển này đang thúc đẩy các kết quả kinh doanh, nhưng cũng làm tăng mức độ quan trọng của việc phát triển AI inferencing tốt hơn tại network edge để đảm bảo tính linh hoạt, hiệu quả và an ninh trong hoạt động.

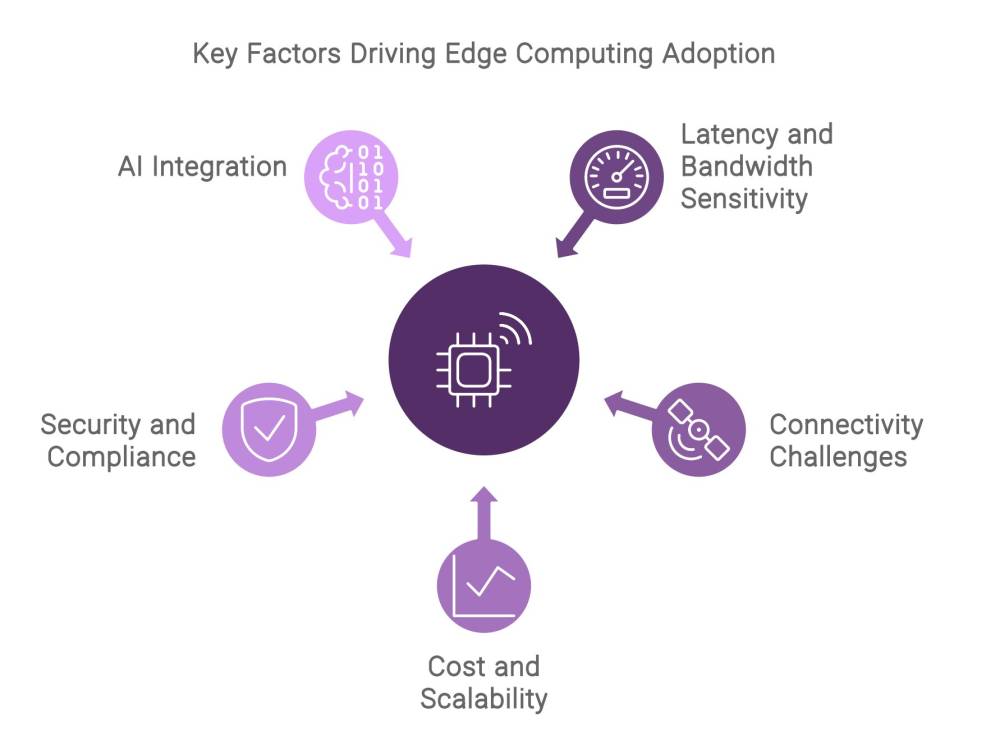

• Các yếu tố chính thúc đẩy việc áp dụng edge computing bao gồm:

- Độ trễ thấp và băng thông cao: Các ứng dụng như xe tự hành và sản xuất thông minh yêu cầu xử lý dữ liệu gần như tức thời, điều này đòi hỏi khả năng độ trễ thấp và băng thông cao. Edge computing đáp ứng được yêu cầu này bằng cách xử lý dữ liệu gần nguồn hơn, giảm độ trễ khi truyền dữ liệu đến trung tâm dữ liệu tập trung.

- Thách thức về kết nối: Kết nối gián đoạn có thể gây ra những rủi ro hoạt động đáng kể cho thiết bị và thiết bị di động hoặc những thiết bị ở các vị trí xa xôi. Edge computing giảm thiểu những rủi ro này bằng cách cho phép xử lý dữ liệu cục bộ, đảm bảo hoạt động liên tục ngay cả trong các khu vực có kết nối hạn chế.

- Chi phí và khả năng mở rộng: Khi lượng dữ liệu được tạo ra tăng lên, chi phí truyền thông tin đến các kho dữ liệu trung tâm cũng tăng lên. Edge computing giảm các chi phí này bằng cách xử lý dữ liệu cục bộ. Ngoài ra, edge computing hỗ trợ khả năng mở rộng, cho phép các tổ chức quản lý lượng dữ liệu ùa về mà không làm quá tải cơ sở hạ tầng hiện có.

- Bảo mật và tuân thủ: Xử lý dữ liệu cục bộ tại edge nâng cao tính bảo mật bằng cách giảm thiểu phơi nhiễm với các mối đe dọa bên ngoài. Ngoài ra, edge computing giúp các doanh nghiệp tuân thủ các quy định về dữ liệu bằng cách giữ dữ liệu nhạy cảm trong các thẩm quyền cục bộ.

• Báo cáo khuyên các nhà lãnh đạo doanh nghiệp và CNTT đầu tư vào các nền tảng edge computing phù hợp với các trường hợp sử dụng cụ thể của họ. Các nền tảng này, dù là hệ thống cấp doanh nghiệp hay các cổng IoT cấp nhúng, nên được lựa chọn dựa trên khối lượng và tốc độ dữ liệu mà chúng dự kiến sẽ xử lý.

• Bằng cách áp dụng phương pháp tiếp cận cloud hybrid và tận dụng các máy chủ hiện đại như HPE ProLiant Gen11 được cung cấp bởi bộ vi xử lý Intel Xeon Scalable, các cơ quan có thể đạt được nhiều lợi ích đáng kể, bao gồm:

- Tính linh hoạt và khả năng mở rộng được cải thiện - thông qua cơ sở hạ tầng dịch vụ.

- Bảo mật đáng tin cậy được thiết kế sẵn - từ edge đến trung tâm dữ liệu đến cloud.

- Hiệu suất được tối ưu hóa cho các workload cụ thể - cung cấp năng lực đồ họa và tính toán khác nhau.

📌 Kết hợp edge computing và AI là then chốt để duy trì lợi thế cạnh tranh và thúc đẩy tăng trưởng, khi các tổ chức tiếp tục đầu tư vào các công nghệ edge. Với cơ sở hạ tầng và các khoản đầu tư chiến lược phù hợp, các tổ chức có thể khai thác trọn vẹn tiềm năng của edge computing để chuyển đổi hoạt động và trải nghiệm khách hàng của họ.

https://fedscoop.com/why-combining-edge-computing-and-ai-is-crucial-for-resiliency-and-innovation/

• Lịch sử công nghệ doanh nghiệp thường xoay quanh sự luân phiên giữa tập trung hóa và phân tán hóa.

• Tập trung hóa thúc đẩy phát triển ban đầu của các công nghệ đổi mới, với nguồn lực tập trung vào một số ít địa điểm.

• Phân tán hóa bắt đầu khi công nghệ đi vào thị trường, với các ứng dụng thực tế khác nhau trong các ngành và khu vực địa lý.

• AI đang trải qua quá trình chuyển đổi tương tự, chỉ trong vòng 20 tháng kể từ khi ChatGPT đưa AI vào tâm điểm chú ý.

• Có sự chuyển dịch từ cách tiếp cận tập trung sang phân tán hơn đối với AI, do sự phát triển từ AI tạo sinh sang AI suy luận.

• AI tạo sinh tạo ra nội dung mới như văn bản, hình ảnh, âm nhạc. AI suy luận đưa ra dự đoán dựa trên dữ liệu hiện có.

• AI tạo sinh ưu tiên tài nguyên tập trung, quy mô lớn về dữ liệu và xử lý.

• AI suy luận ưu tiên cách tiếp cận phân tán hơn, đòi hỏi phải gần nguồn dữ liệu để phân tích thời gian thực.

• Tốc độ nhanh đòi hỏi độ trễ thấp, cần đặt AI suy luận gần nguồn dữ liệu, ưu tiên kiến trúc biên khu vực.

• Doanh nghiệp nhỏ và vừa kỳ vọng AI là một phần của các bản nâng cấp phần mềm họ đang sử dụng.

• Các đối tác cơ sở hạ tầng số cần cung cấp khả năng truyền tải dữ liệu nhanh chóng, an toàn đến các trung tâm xử lý tập trung và khả năng chuyên dụng khu vực.

• Sự phát triển của AI cho thấy nó sẽ đi theo con đường từ đổi mới tập trung đến sử dụng phân tán.

• Doanh nghiệp đang tìm kiếm các trường hợp sử dụng và ứng dụng AI có thể mang lại lợi thế cạnh tranh nhanh hơn.

📌 AI đang chuyển từ tập trung sang phân tán, với AI tạo sinh ưu tiên tài nguyên tập trung và AI suy luận hướng tới kiến trúc biên. Doanh nghiệp cần đối tác cơ sở hạ tầng số linh hoạt để tận dụng cả hai loại AI, tìm kiếm ứng dụng mang lại lợi thế cạnh tranh nhanh chóng.

https://www.datacenterdynamics.com/en/opinions/from-the-center-to-the-edge-and-back-again-the-path-of-ai/

• AI suy luận tại biên là việc chạy các mô hình máy học đã được huấn luyện gần với người dùng cuối hơn so với suy luận AI trên đám mây truyền thống. Nó giúp tăng tốc thời gian phản hồi của mô hình ML, cho phép các ứng dụng AI thời gian thực trong các ngành như game, chăm sóc sức khỏe và bán lẻ.

• Suy luận AI tại biên xảy ra khi mô hình ML chạy trên máy chủ gần người dùng cuối, ví dụ như cùng khu vực hoặc thậm chí cùng thành phố. Điều này giúp giảm độ trễ xuống còn vài mili giây để có phản hồi mô hình nhanh hơn.

• Suy luận tại biên khác với suy luận trên đám mây ở hai điểm: suy luận xảy ra gần người dùng cuối hơn và độ trễ thấp hơn. Độ trễ của đám mây có thể từ vài trăm mili giây đến vài giây.

• AI suy luận tại biên dựa vào cơ sở hạ tầng IT với hai thành phần kiến trúc chính: mạng có độ trễ thấp và máy chủ được trang bị chip AI. Nếu cần khả năng mở rộng để xử lý tăng đột biến tải, cũng cần dịch vụ điều phối container như Kubernetes.

• Lợi ích chính của AI suy luận tại biên bao gồm: độ trễ thấp (dưới 50ms), bảo mật và chủ quyền dữ liệu tốt hơn, hiệu quả chi phí cao hơn.

• Các ngành hưởng lợi từ AI suy luận tại biên bao gồm: công nghệ (ứng dụng AI tạo sinh, chatbot), game (tạo nội dung và bản đồ AI), bán lẻ (tự thanh toán thông minh, thử đồ ảo), sản xuất (phát hiện lỗi thời gian thực), truyền thông giải trí (phân tích nội dung, dịch thời gian thực), ô tô (phản hồi nhanh cho xe tự lái).

• AI suy luận tại biên phù hợp với các tổ chức cần độ trễ thấp cho ứng dụng, có người dùng trải rộng nhiều khu vực địa lý, muốn giữ dữ liệu cục bộ, không muốn tự bảo trì cơ sở hạ tầng.

• Chỉ một số ít nhà cung cấp có cơ sở hạ tầng để cung cấp AI suy luận tại biên toàn cầu đáp ứng các yêu cầu về mạng độ trễ thấp, máy chủ với bộ tăng tốc AI và điều phối container.

📌 AI suy luận tại biên là công nghệ quan trọng cho các ứng dụng thời gian thực, giúp giảm độ trễ xuống dưới 50ms, tăng cường bảo mật dữ liệu và tiết kiệm chi phí. Nó đang thúc đẩy đổi mới AI/ML trong nhiều ngành như công nghệ, game, bán lẻ, sản xuất và ô tô.

https://www.techradar.com/pro/what-is-ai-inference-at-the-edge-and-why-is-it-important-for-businesses

• NTT Data, công ty cơ sở hạ tầng và dịch vụ CNTT thuộc sở hữu của NTT Nhật Bản, đã ra mắt nền tảng Edge AI mới để đẩy nhanh quá trình xử lý AI tại biên.

• Nền tảng này xử lý dữ liệu ngay tại nơi nó được tạo ra và thống nhất các thiết bị, hệ thống và dữ liệu Internet of Things đa dạng, cho phép ra quyết định thời gian thực, nâng cao hiệu quả hoạt động và triển khai ứng dụng AI an toàn trên nhiều ngành công nghiệp.

• Công nghệ này nhắm đến các thiết bị IoT, sản xuất và ứng dụng công nghiệp. Nó giải quyết thách thức của các ngành đòi hỏi ra quyết định thời gian thực và cục bộ bằng cách xử lý các bộ dữ liệu lớn trên các nền tảng điện toán nhỏ gọn.

• Edge AI của NTT Data là một nền tảng dịch vụ được quản lý toàn diện bao gồm tất cả các hệ thống, công cụ và khả năng cần thiết cho AI tại biên. Nó giải quyết việc khám phá, thu thập, tích hợp dữ liệu, sức mạnh tính toán, kết nối liền mạch và quản lý mô hình AI.

• Nền tảng này có thể hỗ trợ các yêu cầu cụ thể của từng ngành, sử dụng các mô hình AI nhẹ hơn và tiết kiệm chi phí, cho phép chạy trong một hộp tính toán nhỏ.

• Trong sản xuất, Edge AI có thể cải thiện bảo trì dự đoán bằng cách truy cập dữ liệu IT/OT từ cảm biến, máy móc, camera và ứng dụng để lập kế hoạch và xử lý sự cố. Nó cũng có thể giám sát và tối ưu hóa tiêu thụ năng lượng theo thời gian thực.

• Theo IDC, chi tiêu toàn cầu cho điện toán biên dự kiến sẽ đạt 232 tỷ USD vào năm 2024, tăng 15% so với năm 2023. NTT Data đang sẵn sàng chiếm thị phần đáng kể thông qua doanh nghiệp tư vấn và dịch vụ IoT chuyên dụng.

• NTT Data cung cấp dịch vụ khám phá và chẩn đoán miễn phí 30 ngày cho môi trường IT và OT của khách hàng. Phần mềm tự động khám phá tài sản với thư viện giao diện OT được xây dựng sẵn rộng lớn.

• Dịch vụ được quản lý của NTT Data cho Edge AI cung cấp cái nhìn thống nhất và quản lý các thiết bị, cảm biến và tài sản. Nó giúp doanh nghiệp đơn giản hóa các quy trình phức tạp, tiết kiệm chi phí và đẩy nhanh quá trình chuyển đổi số.

• Edge AI hoạt động như nền tảng hội tụ IT/OT được quản lý đầy đủ đầu tiên trong ngành, chuyển đổi tài sản vật lý thành tài sản phần mềm để có thông tin chi tiết dựa trên dữ liệu.

📌 NTT Data ra mắt nền tảng Edge AI siêu nhẹ, xử lý dữ liệu tại nguồn cho IoT và sản xuất. Dự kiến thị trường điện toán biên đạt 232 tỷ USD vào 2024. Nền tảng này giúp ra quyết định thời gian thực, tăng hiệu quả và triển khai AI an toàn trong nhiều ngành công nghiệp.

https://venturebeat.com/ai/ntt-data-unveils-ultralight-edge-ai-platform-for-internet-of-things-and-manufacturing/

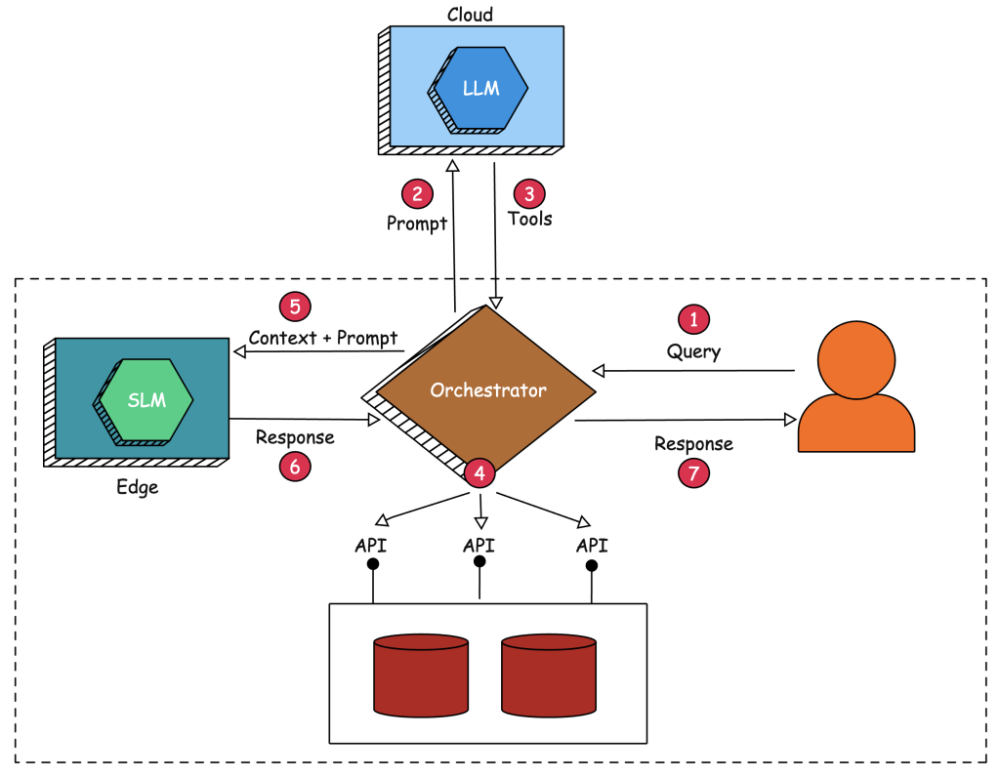

• Federated Language Models là ý tưởng tận dụng 2 xu hướng AI: mô hình ngôn ngữ nhỏ (SLM) có thể chạy trên thiết bị và khả năng ngày càng tăng của mô hình ngôn ngữ lớn (LLM) chạy trên cloud.

• Kiến trúc này sử dụng SLM ở edge chủ yếu để tạo sinh, trong khi LLM trên cloud được dùng để ánh xạ prompt thành các công cụ và tham số liên quan.

• Mục tiêu là triển khai một agent tạo sinh được tăng cường bởi truy xuất dữ liệu ngoài (RAG) mà không cần gửi ngữ cảnh nhạy cảm đến LLM chạy trong môi trường công cộng.

• LLM có khả năng được sử dụng để ánh xạ prompt thành các công cụ thích hợp có quyền truy cập vào dữ liệu và ứng dụng nội bộ nhạy cảm.

• Ứng dụng điều phối các cuộc gọi đến mô hình ngôn ngữ thực thi các công cụ do LLM xác định để trích xuất ngữ cảnh, sau đó được gửi đến SLM ít khả năng hơn chạy cục bộ trên thiết bị edge giá rẻ.

• Kiến trúc này che giấu dữ liệu nhạy cảm khỏi LLM bằng cách ủy thác việc tạo sinh thực tế cho SLM.

• Các xu hướng gần đây trong lĩnh vực mô hình ngôn ngữ bao gồm: SLM ngày càng có khả năng và trưởng thành hơn; chức năng gọi hàm và công cụ vẫn bị giới hạn ở LLM; LLM không thể triển khai trên thiết bị edge như Nvidia Jetson; phần lớn dữ liệu nhạy cảm cần cho RAG nằm trong trung tâm dữ liệu; quy trình làm việc của agent dựa vào nhiều hơn một mô hình ngôn ngữ.

• Quy trình triển khai Federated Language Models gồm 7 bước, từ việc người dùng gửi prompt đến việc SLM ở edge tạo ra phản hồi cuối cùng dựa trên ngữ cảnh được tổng hợp.

• Thách thức trong việc triển khai bao gồm: cần quản lý cẩn thận sự phối hợp giữa SLM ở edge và LLM trên cloud; hiệu suất của SLM cho các tác vụ tạo sinh có thể không bằng LLM; có thể gây độ trễ do giao tiếp qua lại giữa edge và cloud.

• Tác giả đã triển khai bằng chứng về khái niệm này dựa trên Microsoft Phi-3 chạy cục bộ trên Jetson Orin, cơ sở dữ liệu MongoDB được hiển thị dưới dạng API và GPT-4o từ OpenAI.

📌 Federated Language Models kết hợp SLM ở edge và LLM trên cloud để cân bằng khả năng AI tiên tiến với bảo mật dữ liệu. Phương pháp này giải quyết các thách thức về quyền riêng tư trong ứng dụng AI doanh nghiệp, mặc dù vẫn còn một số thách thức về hiệu suất và độ trễ cần khắc phục.

https://thenewstack.io/federated-language-models-slms-at-the-edge-plus-cloud-llms/

- Edge AI là sự kết hợp giữa trí tuệ nhân tạo (AI) và điện toán biên (edge computing), cho phép xử lý dữ liệu và đưa ra quyết định ngay tại nguồn (thiết bị biên) thay vì gửi dữ liệu lên cloud.

- Lợi ích của Edge AI bao gồm giảm độ trễ, tiết kiệm băng thông, bảo vệ dữ liệu nhạy cảm, hoạt động ổn định khi mất kết nối mạng và mở rộng khả năng của các thiết bị biên.

- Các ứng dụng của Edge AI rất đa dạng như điều khiển xe tự lái, giám sát an ninh, bảo trì dự đoán trong sản xuất, chăm sóc sức khỏe, nông nghiệp thông minh, hệ thống nhà thông minh...

- Để triển khai Edge AI cần phần cứng chuyên dụng như chip AI, cảm biến, thiết bị biên có khả năng tính toán cao. Đồng thời cũng đòi hỏi nền tảng phần mềm, mô hình AI tối ưu, kỹ năng phát triển và bảo mật dữ liệu.

- Một số thách thức của Edge AI là nguồn lực hạn chế của thiết bị biên, khó khăn trong việc cập nhật mô hình, đảm bảo chất lượng dữ liệu huấn luyện, bảo mật và vấn đề quyền riêng tư.

- Thị trường Edge AI được dự báo tăng trưởng mạnh mẽ từ 1,18 tỷ USD năm 2020 lên 8,03 tỷ USD vào năm 2027, với tốc độ tăng trưởng hàng năm là 32,1%.

📌 Edge AI mang lại nhiều lợi ích như xử lý dữ liệu nhanh, bảo mật, tiết kiệm băng thông và mở rộng khả năng cho thiết bị biên. Tuy nhiên, việc triển khai còn gặp thách thức về phần cứng, phần mềm, kỹ năng và bảo mật. Thị trường Edge AI được dự báo tăng trưởng 32,1%/năm, đạt 8,03 tỷ USD vào 2027.

Citations:

[1] https://www.computerweekly.com/news/366581516/Edge-AI-explained-Everything-you-need-to-know

- Sự phát triển của AI tạo sinh đang thúc đẩy nhu cầu về năng lượng tính toán, dẫn đến gia tăng tiêu thụ điện năng và phát thải carbon.

- Các mô hình ngôn ngữ lớn như GPT-3 tiêu tốn 190.000 kWh điện và thải ra 78.000 kg CO2 trong quá trình đào tạo.

- Việc triển khai AI tạo sinh trên các thiết bị biên có thể giúp giảm đáng kể lượng điện năng tiêu thụ và lượng khí thải carbon.

- Các thiết bị biên chỉ tiêu thụ 1-2W điện, thấp hơn nhiều so với 150-300W của các máy chủ đám mây.

- Xử lý dữ liệu tại chỗ trên thiết bị biên giúp giảm băng thông mạng cần thiết, tiết kiệm năng lượng truyền dữ liệu.

- Bằng cách giữ dữ liệu cục bộ, các thiết bị biên còn giúp tăng cường bảo mật và quyền riêng tư của người dùng.

- Các công ty như Kneron đang phát triển giải pháp AI tạo sinh trên thiết bị biên, hứa hẹn hiệu suất cao với mức tiêu thụ điện năng tối thiểu.

📌 Triển khai AI tạo sinh trên các thiết bị biên có thể giúp giảm đáng kể tác động môi trường, với mức tiêu thụ điện chỉ 1-2W, thấp hơn nhiều so với 150-300W của máy chủ đám mây. Giải pháp này không chỉ tiết kiệm năng lượng mà còn tăng cường bảo mật dữ liệu người dùng.

Citations:

[1] https://www.csrwire.com/press_releases/801531-how-edge-devices-can-help-mitigate-global-environmental-cost-generative-ai

- Edge AI là việc triển khai thuật toán và mô hình AI trên các thiết bị cục bộ như cảm biến hoặc thiết bị IoT tại rìa mạng, cho phép xử lý và phân tích dữ liệu ngay lập tức, giảm sự phụ thuộc vào cơ sở hạ tầng đám mây.

- Các thiết bị có thể đưa ra quyết định thông minh một cách nhanh chóng và tự động mà không cần dữ liệu từ máy chủ xa hoặc hệ thống đám mây, nhờ vào việc triển khai mô hình AI trực tiếp trên thiết bị rìa.

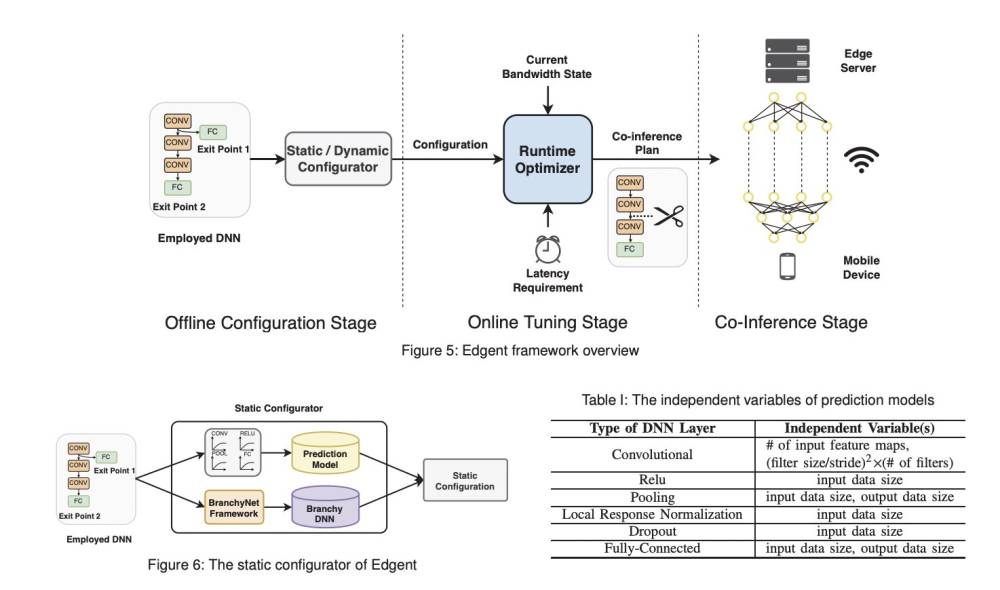

- Mạng lưới DNN (Deep Neural Networks) đóng vai trò quan trọng trong các ứng dụng AI ở kỷ nguyên 5G, nhưng việc chạy các tác vụ dựa trên DNN trên thiết bị di động đòi hỏi nhiều tài nguyên tính toán hơn.

- Edge AI giảm thiểu độ trễ mạng rộng lớn và nhu cầu băng thông, cải thiện hiệu suất thời gian thực và trải nghiệm người dùng.

- Các khung làm việc Edge AI như PyTorch Mobile và TensorFlow Lite cho phép tổ chức tận dụng sức mạnh của AI tại rìa để thúc đẩy hiệu quả, tự động hóa và đổi mới trong hoạt động của họ.

- Edge AI hỗ trợ quyết định tại chỗ, giảm sự phụ thuộc vào việc truyền dữ liệu đến các địa điểm trung tâm, nhưng việc triển khai trên các địa điểm đa dạng đặt ra thách thức như trọng lực dữ liệu và hạn chế tài nguyên.

- Ứng dụng của Edge AI bao gồm điện thoại thông minh, phụ kiện theo dõi sức khỏe có thể đeo như đồng hồ thông minh và cập nhật giao thông thời gian thực cho xe tự lái.

- Các ngành công nghiệp áp dụng Edge AI để giảm chi phí, tự động hóa quy trình và tăng cường quyết định, tối ưu hóa hoạt động trong nhiều lĩnh vực, thúc đẩy hiệu quả và đổi mới.

📌 Edge AI đại diện cho sự chuyển đổi mạnh mẽ trong việc triển khai AI, cho phép xử lý và phân tích dữ liệu thời gian thực trên các thiết bị cục bộ. Với các lợi ích như giảm độ trễ, cải thiện bảo mật và giảm chi phí, Edge AI đang cách mạng hóa nhiều ngành công nghiệp, từ y tế đến giao thông, thông qua việc sử dụng các framework như PyTorch Mobile và TensorFlow Lite.

Citations:

[1] https://www.marktechpost.com/2024/04/30/edge-ai-and-its-advantages-over-traditional-ai/

- BitNet 1.58 là mô hình ngôn ngữ lớn (LLM) 1 bit đột phá được phát triển bởi Microsoft Research.

- Mô hình sử dụng hệ thống tham số tam phân, cho phép mỗi tham số có giá trị -1, 0 hoặc 1.

- BitNet 1.58 có hiệu suất tương đương với các mô hình transformer chính xác đầy đủ trong khi giảm đáng kể độ trễ, sử dụng bộ nhớ và tiêu thụ năng lượng.

- Khả năng hoạt động hiệu quả với ít bit cho mỗi tham số hơn thách thức quan niệm rằng cần tính toán chính xác cao để mô hình hóa ngôn ngữ chính xác.

- BitNet 1.58 mở đường cho các phương pháp phát triển và triển khai LLM hiệu quả hơn.

- Mô hình có khả năng thích ứng và triển khai tại chỗ, giúp đơn giản hóa việc áp dụng LLM trong các tình huống thực tế.

📌 BitNet 1.58 của Microsoft Research là bước tiến quan trọng trong công nghệ LLM với hệ thống tam phân hiệu quả, hiệu suất tương đương transformer chính xác đầy đủ, tiềm năng triển khai tại chỗ, mở ra hướng đi mới cho phát triển LLM hiệu quả và khả thi hơn.

Citations:

[1] https://www.geeky-gadgets.com/1-bit-large-language-models/

- Edge AI là mô hình tính toán nơi dữ liệu được xử lý ngay tại hoặc gần nguồn, thay vì gửi đến đám mây để xử lý.

- Việc xử lý dữ liệu tại biên giúp giảm nhu cầu về băng thông và năng lượng, giúp tiết kiệm chi phí và giảm lượng khí thải carbon.

- Edge AI cũng cải thiện tính riêng tư và an ninh mạng bằng cách giữ dữ liệu nhạy cảm tại chỗ thay vì truyền qua mạng.

- Các ứng dụng của Edge AI bao gồm các thiết bị IoT, xe tự lái, hệ thống giám sát và chẩn đoán y tế từ xa.

- Sự phát triển của 5G và IoT sẽ thúc đẩy sự tăng trưởng của Edge AI, với dự báo thị trường đạt 1.12 tỷ USD vào năm 2023.

- Các thách thức đối với Edge AI bao gồm năng lực phần cứng hạn chế, quản lý thiết bị và cập nhật phần mềm, nhưng các giải pháp đang được phát triển.

📌 Edge AI mang lại tương lai bền vững và dễ tiếp cận hơn cho trí tuệ nhân tạo bằng cách xử lý dữ liệu tại nguồn, giảm nhu cầu về băng thông và năng lượng đến 90%. Mô hình này cũng cải thiện đáng kể tính riêng tư và an ninh mạng. Với sự bùng nổ của 5G và IoT, thị trường Edge AI dự kiến đạt 1.12 tỷ USD vào năm 2023, mở ra tiềm năng to lớn cho các ứng dụng như IoT, xe tự lái và y tế từ xa.

Citations:

[1] https://venturebeat.com/ai/edge-ai-the-accessible-sustainable-future-of-ai/

- Xu hướng chuyển dịch sang điện toán biên do sự phát triển nhanh chóng của AI tạo sinh (GenAI) và khối lượng công việc AI truyền thống.

- Các tổ chức đang chuyển sang điện toán biên để khắc phục các hạn chế của AI dựa trên đám mây như bảo mật dữ liệu, chủ quyền và kết nối mạng.

- AI biên hứa hẹn xử lý nhanh hơn với độ trễ gần bằng không, có thể thay đổi đáng kể các ứng dụng mới nổi.

- Các vấn đề như độ trễ mạng có thể làm chậm việc đưa ra thông tin chi tiết và lập luận trong đám mây, dẫn đến sự chậm trễ và tăng chi phí liên quan đến truyền dữ liệu giữa đám mây và môi trường biên.

- Gartner dự đoán hơn 55% tất cả các phân tích dữ liệu bằng mạng nơ-ron sâu sẽ xảy ra tại điểm thu thập trong hệ thống biên vào năm 2025, tăng từ dưới 10% vào năm 2021.

- Các kỹ thuật như cắt tỉa mô hình và lượng tử hóa rất quan trọng để giảm kích thước của các mô hình AI mà không ảnh hưởng đáng kể đến độ chính xác của chúng.

- Sự phát triển của các khung và thư viện AI được thiết kế đặc biệt cho điện toán biên có thể đơn giản hóa quá trình triển khai khối lượng công việc AI biên.

- Cơ sở dữ liệu với các khả năng như tìm kiếm vector và phân tích thời gian thực, giúp đáp ứng các yêu cầu hoạt động của biên và hỗ trợ xử lý dữ liệu cục bộ, xử lý các loại dữ liệu khác nhau, chẳng hạn như âm thanh, hình ảnh và dữ liệu cảm biến.

- Suy luận phân tán đặt các mô hình hoặc khối lượng công việc trên nhiều thiết bị biên với các mẫu dữ liệu cục bộ mà không cần trao đổi dữ liệu thực tế có thể giảm thiểu các vấn đề tiềm ẩn về tuân thủ và quyền riêng tư dữ liệu.

📌 Tìm sự cân bằng giữa xử lý AI ở biên và đám mây sẽ rất quan trọng để thúc đẩy các sáng kiến AI. Việc thu thập, phân tích và nhanh chóng đạt được thông tin chi tiết ở biên sẽ ngày càng quan trọng. Khi các tổ chức phát triển việc sử dụng AI, việc triển khai lượng tử hóa mô hình, khả năng đa phương thức, nền tảng dữ liệu và các chiến lược biên khác sẽ giúp mang lại kết quả kinh doanh có ý nghĩa trong thời gian thực.

https://www.kdnuggets.com/the-promise-of-edge-ai-and-approaches-for-effective-adoption

- Morgan Stanley đánh giá cao triển vọng AI iPhone của Apple, coi đó là cơ hội lớn cho nhà đầu tư.

- Chuyên gia phân tích Erik Woodring của Morgan Stanley lạc quan về cổ phiếu Apple (NASDAQ:AAPL), ví von như một bông hoa đang nở rộ với khả năng tăng trưởng không ngừng.

- Woodring chia sẻ niềm tin vào tiềm năng chưa được khai thác trong lĩnh vực trí tuệ nhân tạo (AI), điều này cũng được nhà đầu tư và chuyên gia ngành công nghệ đồng tình.

- Ông nhấn mạnh sự xuất hiện của "Edge AI" như một cơ hội lớn đối với các thiết bị của Apple.

- Mặc dù có những lo ngại về nhu cầu sản phẩm ngắn hạn và những kiểm tra hỗn hợp về chuỗi cung ứng đầu năm, Woodring lại thấy một bức tranh khác.

- Doanh số iPhone tháng 12 vượt qua kỳ vọng, có thể vượt quá ước tính 72.5 triệu đơn vị được giao. Doanh thu từ dịch vụ được dự đoán tăng 10% so với cùng kỳ năm trước trong Q4.

- Woodring khuyên nhà đầu tư dài hạn không nên chỉ chú trọng vào số liệu bán hàng ngắn hạn, mà cần nhìn nhận tiềm năng chưa được đánh giá đúng mức của Apple trong lĩnh vực AI.

- Theo phân tích của Woodring, Apple có thể giới thiệu "AI iPhone" vào mùa thu năm 2024. Thiết bị này sẽ sử dụng bộ nhớ flash NAND để kích hoạt các mô hình ngôn ngữ mạnh mẽ ngay trên iPhone, với phản hồi nhanh gấp 20-25 lần.

- Siri, trợ lý ảo của Apple, sẽ được hưởng lợi đáng kể từ bước tiến công nghệ này.

- Sự ra mắt của iPhone hỗ trợ AI có thể thay đổi hành vi tiêu dùng. Thay vì giữ iPhone trong thời gian dài, người tiêu dùng có thể sẽ nhanh chóng nâng cấp lên phiên bản mới hơn với trang bị AI, từ đó thúc đẩy nhu cầu và tăng doanh thu cho Apple.

- Với triển vọng tích cực này, Woodring khuyến nghị nhà đầu tư mua cổ phiếu Apple ngay bây giờ để định vị cho những lợi ích tiềm năng khi AI iPhone làm thay đổi thị trường. Mục tiêu giá của ông là $220, tương đương với tiềm năng tăng giá 18% trong 12 tháng tới.

- Các nhà phân tích khác đều đồng tình với quan điểm lạc quan của Woodring. Trong số 33 nhà phân tích theo dõi AAPL, 23 người khuyến nghị mua cổ phiếu, 9 người khuyến nghị giữ và chỉ 1 người khuyến nghị bán. Sự đồng thuận này mang lại một đánh giá "Mua Ôn Hòa".

- Hiện tại, cổ phiếu Apple đang giao dịch ở mức $185.92. Mục tiêu giá trung bình của các nhà phân tích là $203.35, cho thấy tiềm năng tăng khoảng 8% từ mức hiện tại.

📌 Theo Morgan Stanley, AI iPhone của Apple có khả năng là một yếu tố thay đổi cuộc chơi đối với nhà đầu tư, với dự đoán cổ phiếu Apple sẽ tăng trưởng. Chuyên gia phân tích Erik Woodring nhận định "Edge AI" là cơ hội lớn cho các thiết bị của Apple, kỳ vọng "AI iPhone" sẽ ra mắt vào mùa thu 2024. Siri sẽ được cải thiện đáng kể, và người tiêu dùng có thể thay đổi thói quen nâng cấp điện thoại thường xuyên hơn. Mục tiêu giá cổ phiếu Apple theo khuyến nghị của Woodring là 220 USD, hứa hẹn một sự tăng giá 18% trong 12 tháng tới. Cổ phiếu Apple hiện giao dịch ở 185,92 USD với tiềm năng tăng khoảng 8% theo đánh giá của các nhà phân tích khác.

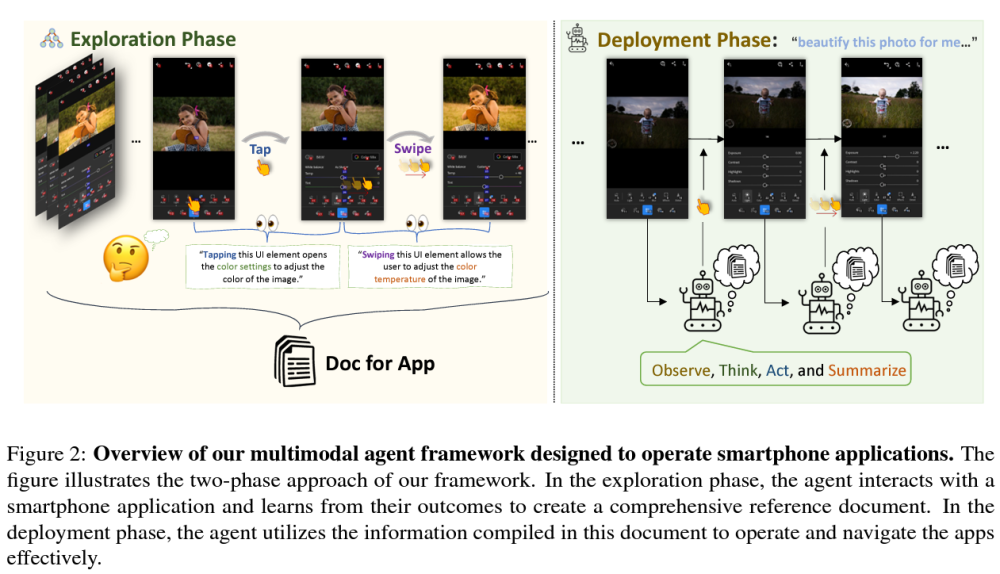

- Bài viết trên MarkTechPost giới thiệu về AppAgent, một khung (framework) agent mới dựa trên LLM (Mô hình Ngôn ngữ Lớn) và multimodal được phát triển bởi các nhà nghiên cứu tại Tencent.

- AppAgent được thiết kế để vận hành các ứng dụng điện thoại thông minh, kết hợp khả năng hiểu ngôn ngữ tự nhiên và xử lý hình ảnh để tương tác với các ứng dụng một cách hiệu quả.

- Framework này cho phép tự động hóa các tác vụ phức tạp trên smartphone, như đặt hàng trực tuyến hoặc quản lý lịch trình, thông qua chỉ thị bằng lời nói hoặc văn bản.

- AppAgent sử dụng công nghệ AI để hiểu và thực hiện các yêu cầu của người dùng, tạo ra một giao diện tương tác người-máy tự nhiên và trực quan.

- Bài viết nhấn mạnh tầm quan trọng của việc kết hợp nhiều modalities như ngôn ngữ và hình ảnh trong việc tạo ra agent thông minh, có khả năng tương tác với môi trường số phức tạp.

- Đây là một bước tiến trong việc tích hợp AI vào cuộc sống hàng ngày, giúp người dùng dễ dàng tương tác và sử dụng các ứng dụng thông minh mà không cần kỹ năng kỹ thuật phức tạp.

- Bài báo kết luận rằng AppAgent mở ra triển vọng mới trong việc phát triển các ứng dụng thông minh hơn và thân thiện với người dùng, thông qua việc áp dụng công nghệ AI tiên tiến.

📌 Sự ra đời của AppAgent, một framework agent dựa trên LLM và multimodal của Tencent, là một minh chứng cho sự tiến bộ trong công nghệ AI, hứa hẹn mang lại sự tiện lợi và trải nghiệm người dùng tốt hơn trong việc tương tác với ứng dụng smartphone.

- Công ty khởi nghiệp Humane do Sam Altman hậu thuẫn thông báo sẽ bắt đầu giao hàng Ai Pin được trang bị công nghệ ChatGPT từ tháng 3 năm 2024.

- Ai Pin là máy tính đeo được đầu tiên trên thế giới sử dụng AI, nhằm giảm thiểu thời gian tương tác của người dùng.

- Thiết bị cho phép giao tiếp với chatbot AI qua công nghệ giọng nói và mực laser, một phương pháp tiếp cận độc đáo so với sản phẩm công nghệ tiêu dùng thông thường.

- Humane cũng tiết lộ kế hoạch ưu tiên giao hàng cho khách hàng đặt trước.

- Ai Pin sẽ được giao theo thứ tự đặt hàng, với giá $699, bao gồm cả bộ tăng cường pin.

- Có phí hàng tháng $24 cho dịch vụ đăng ký Humane, bao gồm kết nối di động, số điện thoại riêng và phủ sóng dữ liệu, thông qua T-Mobile ở Mỹ.

- Ai Pin nặng khoảng 34 gram, còn "bộ tăng cường pin" thêm 20 gram. Camera tích hợp chụp ảnh 13 megapixel và sẽ quay video sau khi cập nhật phần mềm.

📌 Ai Pin của Humane, được hỗ trợ bởi ChatGPT, đánh dấu bước tiến trong công nghệ đeo được với khả năng giao tiếp AI tiên tiến, giảm thiểu thời gian tương tác người dùng và mở ra triển vọng mới cho sản phẩm công nghệ cá nhân với chi phí khởi điểm $699 và các dịch vụ đăng ký thêm.

- Nhóm nghiên cứu từ Apple đã phát triển phương pháp mới cho phép các mô hình ngôn ngữ lớn (LLMs) hoạt động hiệu quả trên thiết bị có bộ nhớ DRAM hạn chế.

- Cách tiếp cận này bao gồm việc lưu trữ tham số LLM trên bộ nhớ flash và chuyển động đến DRAM khi cần thiết trong quá trình suy luận.

- Cải tiến tập trung vào việc giảm lượng dữ liệu chuyển từ flash và đọc dữ liệu theo khối lớn, liên tục hơn.

- Kỹ thuật "windowing" giảm lượng dữ liệu chuyển bằng cách tái sử dụng neuron đã kích hoạt trước đó.

- Kỹ thuật "row-column bundling" tận dụng ưu điểm của bộ nhớ flash trong việc truy cập dữ liệu tuần tự.

- Kết quả nghiên cứu cho thấy khả năng chạy LLM lớn gấp đôi DRAM có sẵn, tăng tốc độ suy luận 4-5 lần trên CPU và 20-25 lần trên GPU so với phương pháp tải thông thường.

- Phương pháp này quan trọng trong việc vượt qua thách thức tải và chạy mô hình lớn trên thiết bị có hạn chế về tài nguyên.

📌 Nghiên cứu của Apple cho thấy khả năng chạy LLM lớn gấp đôi DRAM có sẵn, tăng tốc độ suy luận 4-5 lần trên CPU và 20-25 lần trên GPU so với phương pháp tải thông thường. Điều này mở ra giải pháp mới cho việc chạy LLMs trên thiết bị có bộ nhớ hạn chế, điều này có thể áp dụng cho các thiết bị di động và IoT, nâng cao khả năng tiếp cận AI đối với nhiều người dùng hơn.

- Nhóm nghiên cứu của Apple đã công bố một phát kiến đột phá có thể giúp chạy mô hình trí tuệ nhân tạo (AI) trên iPhone một cách dễ dàng và nhanh chóng.

- Phát triển này có thể giúp Siri được nâng cấp lớn trong tương lai, bao gồm khả năng đàm thoại đầy đủ như ChatGPT với hiệu suất cao trên thiết bị có bộ nhớ hạn chế.

- Google có kế hoạch đưa chatbot Bard AI của mình lên Assistant vào năm sau, nhưng điều này có thể yêu cầu việc gửi cuộc trò chuyện đi xử lý bên ngoài.

- Apple đã tìm ra cách sử dụng bộ nhớ flash thay vì RAM hạn chế, cho phép AI chạy nhanh hơn 4-5 lần, giảm độ trễ phản hồi.

- Siri hiện trả lời dựa vào khả năng đã lập trình sẵn, nhưng với mô hình ngôn ngữ lớn (LLM) sẽ giúp Siri có thể thực hiện cuộc trò chuyện tự nhiên hơn.

- Nâng cấp LLM cho Siri cũng cho phép tích hợp sâu hơn với iPhone, xử lý truy vấn phức tạp và thậm chí có thể tích hợp trong ứng dụng Tin nhắn.

- Việc này sẽ tạo ra môi trường bảo mật hơn, nơi dữ liệu không cần phải rời khỏi thiết bị, đồng thời cho phép Apple cạnh tranh với Gemini Nano của Google.

📌 Apple đã công bố một phát kiến đột phá có thể giúp chạy mô hình trí tuệ nhân tạo (AI) trên iPhone một cách dễ dàng và nhanh chóng. Apple không chỉ nâng cấp Siri mà còn mang lại khả năng xử lý dữ liệu mạnh mẽ ngay trên thiết bị, giảm phụ thuộc vào đám mây và tăng cường quyền riêng tư.

- Bài viết trên Android Police báo cáo về dự án mới của Mozilla với AI, tập trung vào việc lưu trữ dữ liệu AI trên đám mây cục bộ.

- Mozilla phát triển hệ thống cho phép người dùng tận dụng AI mà không cần chia sẻ dữ liệu cá nhân lên đám mây công cộng.

- Dự án này nhằm tăng cường quyền riêng tư và an toàn dữ liệu cho người dùng khi sử dụng các dịch vụ AI.

- Hệ thống của Mozilla cho phép xử lý và phân tích dữ liệu ngay tại thiết bị của người dùng, giảm thiểu rủi ro về an ninh mạng.

- Điều này cũng giúp giảm sự phụ thuộc vào các máy chủ trung tâm và cung cấp giải pháp an toàn hơn cho dữ liệu nhạy cảm.

- Bài viết cũng nhấn mạnh sự cần thiết của việc phát triển các công nghệ AI tôn trọng quyền riêng tư của người dùng.

- Mozilla đang nỗ lực tạo ra một mô hình AI có khả năng tự học và cải thiện mà không cần truy cập vào dữ liệu lớn từ máy chủ.

Bài viết từ Android Police giới thiệu dự án của Mozilla về lưu trữ dữ liệu AI trên đám mây cục bộ, nhằm tăng cường quyền riêng tư và an ninh dữ liệu, giảm sự phụ thuộc vào đám mây công cộng và phát triển công nghệ AI tôn trọng quyền riêng tư người dùng.

- Intel khởi xướng chương trình AI PC Acceleration, tích hợp AI vào trải nghiệm hàng ngày.

- Chip Intel Core Ultra có NPU chuyên biệt, tăng tốc công việc AI, hiệu năng cao và tiết kiệm năng lượng.

- Người sáng tạo nội dung dùng AI để chỉnh sửa video, sáng tác nhạc, chỉnh sửa ảnh với công cụ như DeepRender và Wondershare Filmora.

- Game thủ trải nghiệm môi trường game siêu thực với đồ họa AI và tối ưu hóa thời gian thực.

- Công cụ như XSplit VCam và Webex cải thiện họp trực tuyến, CyberLink hỗ trợ nhận diện khuôn mặt và phát hiện bất thường.

- Chương trình hợp tác với các ISV như Audacity, Blackmagic Design, Topaz Labs để phát triển công cụ mới.

- AI PC hứa hẹn đem lại cơ hội tiếp cận công nghệ tiên tiến, nâng cao sáng tạo và năng suất làm việc.

Chương trình AI PC Acceleration của Intel mở ra kỷ nguyên mới cho máy tính cá nhân với việc tích hợp AI vào từng khía cạnh của trải nghiệm người dùng, từ sáng tạo nội dung đến an ninh mạng, đề xuất một tương lai nơi AI hòa mình vào đời sống hàng ngày, cải thiện đáng kể khả năng sáng tạo và năng suất làm việc.

Follow Us

Tin phổ biến