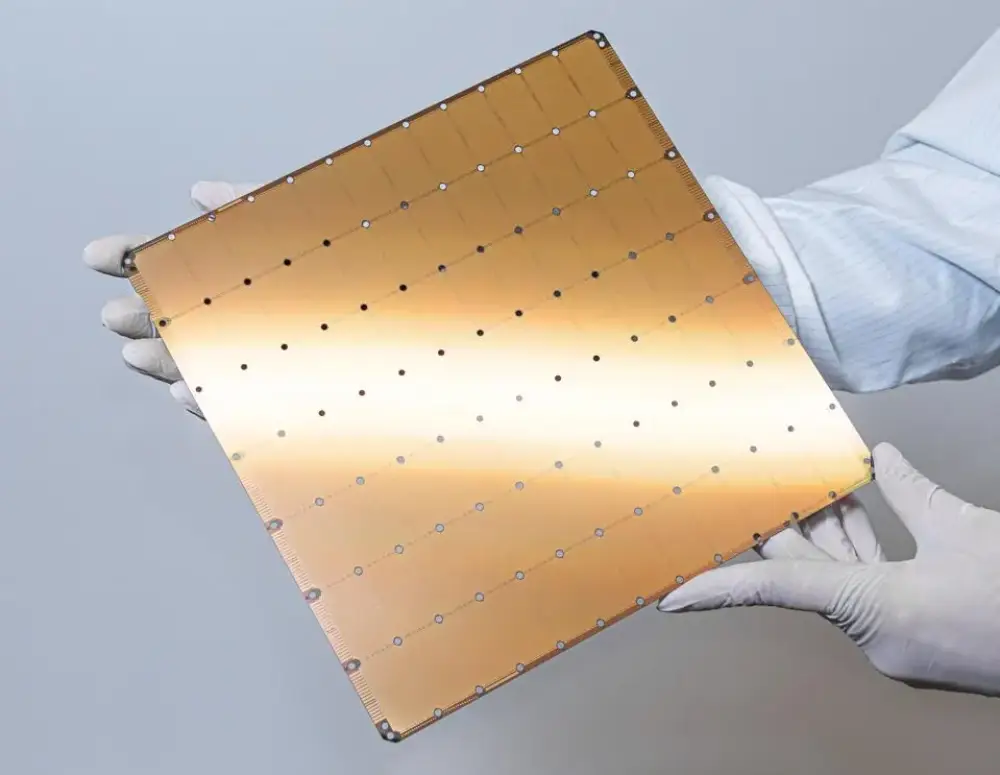

Cerebras phá vỡ kỷ lục thế giới: Tốc độ xử lý AI nhanh hơn 700 lần so với siêu máy tính mạnh nhất

- Cerebras đã đạt được thành tích vượt trội trong việc xử lý suy luận mô hình Llama-3.1 405B, tạo ra 970 token mỗi giây

- Hiệu năng của Cerebras cao hơn:

+ 12 lần so với GPU nhanh nhất

+ 6 lần so với đối thủ SambaNova

+ Gấp đôi tốc độ của GPU cloud khi chạy mô hình 1B

- Chi phí xử lý:

+ 6 USD/triệu token đầu vào

+ 12 USD/triệu token đầu ra

+ Giá một hệ thống CS3: 2-3 triệu USD

- Ưu điểm công nghệ:

+ Sử dụng bộ nhớ SRAM trên chip

+ Băng thông bộ nhớ cao hơn 7.000 lần so với Nvidia H100

+ Độ trễ token đầu tiên chỉ bằng 1/2 so với Google Vertex

- Trong lĩnh vực mô phỏng động học phân tử:

+ Đạt 1,2 triệu bước mô phỏng/giây

+ Nhanh hơn 700 lần so với siêu máy tính Frontier

+ Rút ngắn thời gian mô phỏng từ 2 năm xuống còn 1 ngày

📌 Cerebras đã tạo ra bước đột phá với tốc độ xử lý 970 token/giây cho mô hình Llama-3.1 405B, nhanh hơn 12 lần so với GPU và 700 lần so với siêu máy tính Frontier trong mô phỏng động học phân tử. Công nghệ này mở ra tiềm năng mới cho AI đa tác vụ và suy luận chuỗi.

https://www.forbes.com/sites/karlfreund/2024/11/18/cerebras-now-the-fastest-llm-inference-processor--its-not-even-close

Thảo luận

Follow Us

Tin phổ biến