AI detect-test

View All

- Apple sẽ cập nhật phần mềm để cải thiện việc đánh dấu nội dung do AI tạo ra sau phản ứng dữ dội về tình trạng thông tin tóm tắt sai lệch.

- Bộ công cụ AI của Apple, Apple Intelligence, được ra mắt cùng với iOS 18.1 vào tháng 10, bao gồm thông báo thông minh, tóm tắt trang web, ghi chú bằng giọng nói và phiên bản AI của Siri.

- Những thông tin tóm tắt đã gây ra nhiều tranh cãi với cáo buộc về độ chính xác thấp, thậm chí có những trường hợp xuyên tạc nghiêm trọng, chẳng hạn như một thông báo sai về vụ tự sát của Luigi Mangione.

- BBC đã gửi đơn khiếu nại tới Apple, nhấn mạnh rằng thông tin tóm tắt không phản ánh chính xác nội dung gốc, làm giảm lòng tin vào nguồn tin này.

- Apple cho biết bản cập nhật dự kiến trong vài tuần tới sẽ giúp người dùng nhận biết thông tin nào được tóm tắt từ Apple Intelligence, khuyến khích sự thận trọng hơn từ phía người dùng.

- Apple khẳng định các tính năng AI vẫn đang trong giai đoạn thử nghiệm và sẽ tiếp tục cải thiện nhờ phản hồi từ người dùng.

- Một số thông tin tóm tắt gây hiểu lầm khác bao gồm việc công bố người chiến thắng Giải vô địch bi da thế giới PDC trước khi giải đấu bắt đầu và thông tin sai lệch về việc Rafael Nadal công khai giới tính.

- Những sai sót còn ảnh hưởng đến các cơ quan truyền thông khác như New York Times, khi có thông tin sai về việc Thủ tướng Israel Benjamin Netanyahu bị bắt giữ.

- Dù bản cập nhật có thể giúp nhận diện thông tin do AI tạo ra tốt hơn, nhưng sự chính xác của các tóm tắt vẫn phụ thuộc vào quá trình đào tạo các mô hình ngôn ngữ lớn (LLMs).

- Một số người chỉ trích, như cựu biên tập viên của The Guardian, cho rằng Apple Intelligence chưa sẵn sàng cho việc sử dụng rộng rãi và lo ngại về độ tin cậy của tin tức trong bối cảnh này.

📌 Apple hứa hẹn cập nhật phần mềm để đánh dấu nội dung AI tốt hơn, nhưng nhiều sai sót trong tóm tắt vẫn gây lo ngại về độ chính xác. Sự thiếu sót này ảnh hưởng đến lòng tin của người dùng và có thể gây khó khăn cho các cơ quan truyền thông.

https://tech.co/news/apple-promises-improve-ai-news-labelling-complaints

- Writer, startup AI doanh nghiệp được định giá 1,9 tỷ USD, vừa ra mắt mô hình Palmyra Creative nhằm thay đổi cách doanh nghiệp xử lý các tác vụ sáng tạo.

- Mô hình sử dụng phương pháp tiếp cận mới về kiến trúc AI:

* Sử dụng kỹ thuật hợp nhất và lớp mô hình thích ứng

* Chi phí đào tạo chỉ 700.000 USD, thấp hơn nhiều so với 4,6 triệu USD của OpenAI

* Đào tạo 3 mô hình khác nhau với 3 bộ dữ liệu riêng biệt

- Hệ thống phát hiện tuyên bố mới được tích hợp để:

* Đảm bảo độ chính xác và tin cậy cao

* Kiểm tra sự phù hợp giữa đầu ra sáng tạo và thực tế

* Tương thích với các mô hình chuyên ngành như Palmyra Med (y tế) và Palmyra Fin (tài chính)

- Writer phát triển framework đánh giá mới:

* Sử dụng 20 nhà ngôn ngữ học phân tích trong 3 tuần

* Đo lường tính độc đáo của token qua nhiều lần tạo nội dung

* Dự kiến công bố công cụ nguồn mở vào tháng 1/2025

- Công ty vừa huy động được 200 triệu USD trong vòng gọi vốn Series C với sự dẫn dắt của Premji Invest, Radical Ventures và ICONIQ Growth

- Khách hàng lớn bao gồm Salesforce, Uber, L'Oréal và Accenture

- Palmyra Creative được đóng gói dưới dạng microservice NVIDIA NIM, cho phép triển khai trên cloud, trung tâm dữ liệu và môi trường biên

📌 Writer đang định vị mình trong thị trường AI tạo sinh trị giá 1 nghìn tỷ USD với mô hình Palmyra Creative độc đáo. Với chi phí đào tạo chỉ 700.000 USD, mô hình sử dụng kiến trúc đặc biệt và hệ thống phát hiện tuyên bố để tạo nội dung sáng tạo, đáng tin cậy cho doanh nghiệp.

https://venturebeat.com/ai/writer-new-ai-model-aims-to-fix-the-sameness-problem-in-generative-content/

- Sau 2 năm ChatGPT ra mắt, việc sử dụng AI để làm bài tập và bài thi đang trở thành vấn nạn nghiêm trọng trong giáo dục

- Nghiên cứu mới từ đại học Reading (Anh) cho thấy:

+ 94% bài viết do AI tạo ra không bị giáo viên phát hiện

+ 97% trường hợp không bị đánh dấu là nghi ngờ sử dụng AI

+ 83,4% bài viết do AI tạo ra đạt điểm cao hơn bài viết của sinh viên thật

- Các nghiên cứu trước đây cũng khẳng định:

+ Các chuyên gia ngôn ngữ không thể phân biệt được văn bản do AI hay người viết

+ Hệ thống Turnitin phát hiện được 91% bài viết có nội dung do AI tạo ra

+ Giáo viên chỉ phát hiện được 54,5% trường hợp gian lận dù đã được cảnh báo trước

- Vấn đề nghiêm trọng hơn trong môi trường học trực tuyến:

+ Giáo viên không thể biết sinh viên thật hay ảo

+ Khó giám sát quá trình làm bài

+ Nhiều trường không sử dụng công nghệ phát hiện AI và giám sát thi cử

- Hậu quả:

+ Giá trị bằng cấp bị giảm sút

+ Sinh viên tốt nghiệp thiếu kiến thức thực tế

+ Nguy cơ ảnh hưởng nghiêm trọng đến các ngành nghề như y tá, kỹ sư, lính cứu hỏa

📌 Sau 2 năm ChatGPT xuất hiện, 94% bài viết do AI tạo ra không bị phát hiện và 83,4% đạt điểm cao hơn bài của sinh viên thật. Các trường học thiếu công cụ phát hiện AI hiệu quả, đặc biệt trong môi trường trực tuyến, dẫn đến nguy cơ suy giảm nghiêm trọng chất lượng giáo dục.

https://www.forbes.com/sites/dereknewton/2024/11/30/study-94-of-ai-generated-college-writing-is-undetected-by-teachers/

- Sau 2 năm ChatGPT ra mắt, các công ty AI vẫn đang tìm cách giúp người dùng phân biệt nội dung do con người hay máy tạo ra

- OpenAI đã phát triển hệ thống thủy vân cho văn bản AI từ tháng 8/2024 nhưng chưa phát hành vì:

• Công nghệ dễ bị phá vỡ bởi người dùng xấu

• Có thể ảnh hưởng tiêu cực đến người không nói tiếng Anh bản ngữ

- Google tiếp cận khác với thuật toán SynthID Text:

• Cho phép nhà phát triển AI thêm thủy vân số vào văn bản

• Tạo mẫu thống kê để AI detector của Google có thể phát hiện

• Hiệu quả giảm khi văn bản bị chỉnh sửa nhiều

• Khó phát hiện trong đoạn văn ngắn

- Thách thức không chỉ với văn bản mà còn với hình ảnh và video AI:

• Nhiều công cụ trực tuyến có thể gỡ bỏ thủy vân

• Cần áp dụng thêm chữ ký mật mã và thông tin nguồn gốc

• Liên minh C2PA đang phát triển tiêu chuẩn chung về thông tin nguồn gốc nội dung

- TrueMedia.org, tổ chức phi lợi nhuận kết hợp nhiều phương pháp phát hiện AI:

• Thu hút nhiều nền tảng trực tuyến lớn tham gia

• Giúp lọc nội dung tổng hợp từ AI trong bộ dữ liệu huấn luyện

📌 Sau 2 năm ChatGPT ra đời, các công ty công nghệ lớn vẫn chưa có giải pháp hoàn hảo để phát hiện nội dung AI. Công nghệ thủy vân hiện tại dễ bị phá vỡ, trong khi nhu cầu kiểm soát nội dung AI ngày càng cấp thiết với văn bản, hình ảnh và video.

https://www.bloomberg.com/news/newsletters/2024-11-26/google-openai-haven-t-found-silver-bullet-to-flag-ai-content

- Các nhà khoa học dữ liệu đang sử dụng mô hình ngôn ngữ lớn (LLM) để phát triển công cụ phát hiện tin giả, nhằm cảnh báo và đối phó với deepfake, tuyên truyền và thuyết âm mưu

- Nghiên cứu thần kinh học cho thấy con người không phải lúc nào cũng nhận biết được tin giả một cách có ý thức. Các chỉ số sinh học như nhịp tim, chuyển động mắt và hoạt động não bộ có thể thay đổi tinh tế khi tiếp xúc với nội dung thật và giả

- Khi nhìn khuôn mặt, dữ liệu theo dõi mắt cho thấy con người quét tìm tốc độ chớp mắt và thay đổi màu da do lưu lượng máu. Điều này giúp phát hiện deepfake

- Hệ thống AI có thể được cá nhân hóa dựa trên sở thích, tính cách và phản ứng cảm xúc của người dùng để phát hiện nội dung gây tác động mạnh nhất

- Các biện pháp đối phó bao gồm: nhãn cảnh báo, liên kết đến nội dung được xác thực và khuyến khích xem xét nhiều góc nhìn khác nhau

- Thách thức chính là xác định chính xác thế nào là tin giả. Nghiên cứu cho thấy hoạt động thần kinh thường giống nhau khi tiếp xúc với tin thật và tin giả

- Dữ liệu theo dõi mắt cũng cho kết quả không nhất quán: một số nghiên cứu cho thấy người dùng tập trung hơn khi xem nội dung sai lệch, trong khi các nghiên cứu khác cho thấy điều ngược lại

📌 AI phát hiện tin giả đang được phát triển với sự kết hợp của khoa học hành vi, nhưng vẫn còn nhiều thách thức về độ chính xác. Việc cá nhân hóa hệ thống dựa trên dữ liệu sinh trắc học và hành vi người dùng là hướng đi tiềm năng, tuy nhiên cần thêm nghiên cứu để đánh giá hiệu quả thực tế.

https://theconversation.com/how-close-are-we-to-an-accurate-ai-fake-news-detector-242309

- SynthID, công cụ xác thực nội dung AI, hiện đã mở cho tất cả người dùng thử nghiệm, theo thông báo của Google trên X (trước đây là Twitter) ngày 23/10/2024.

- Công cụ này tạo thủy vân không thể nhận biết cho nội dung do AI tạo ra, bao gồm hình ảnh, video và văn bản, giúp người dùng xác minh nội dung có phải do con người hay máy móc tạo ra.

- SynthID đã ra mắt lần đầu vào năm 2023 và được tích hợp vào Imagen; từ tháng 5/2024, SynthID cũng được tích hợp vào chatbot Gemini của Google.

- Google tuyên bố đã mã nguồn mở SynthID Text trên nền tảng Hugging Face, giúp các nhà phát triển và doanh nghiệp sử dụng miễn phí công cụ này để kiểm tra và xác định nội dung AI.

- SynthID mã hóa thủy vân vào nội dung bằng cách điều chỉnh xác suất xuất hiện của các token trong quá trình sinh nội dung mà không ảnh hưởng đến độ chính xác, chất lượng hoặc tốc độ phản hồi.

- Theo Google, công cụ này có khả năng nhận diện thủy vân ngay cả khi nội dung đã qua chỉnh sửa hoặc cắt ghép, vượt trội so với metadata truyền thống vốn dễ bị xóa bỏ.

- Tuy nhiên, SynthID gặp khó khăn khi kiểm tra các đoạn văn bản ngắn hoặc nội dung có tính tất yếu cao như câu trả lời cho câu hỏi “Thủ đô của Pháp là gì?” vì cả AI và con người đều trả lời giống nhau.

- Dù SynthID đã được thiết kế chống lại việc can thiệp, thủy vân của nó vẫn có thể bị xóa nếu văn bản được dịch sang ngôn ngữ khác hoặc viết lại hoàn toàn.

- SynthID được đánh giá cao bởi cộng đồng vì tính minh bạch và khả năng nguồn mở, cho phép kiểm tra độ tin cậy trong nhiều kịch bản khác nhau.

📌 Google đã chính thức mã nguồn mở SynthID, công cụ thủy vân AI, giúp phát hiện nội dung do AI tạo ra qua nhiều định dạng. Dù có khả năng chịu chỉnh sửa mạnh, công cụ này gặp giới hạn trong văn bản ngắn và nội dung có tính chính xác tuyệt đối. Người dùng có thể tải về từ Hugging Face để trải nghiệm trực tiếp.

https://www.digitaltrends.com/computing/google-synthid-now-available-public/

• GPTZero, công ty khởi nghiệp chuyên phát hiện văn bản AI, vừa công bố ra mắt công cụ mới theo dõi mức độ đóng góp của AI trong một tài liệu.

• Mục tiêu là hướng tới cách tiếp cận tinh tế hơn về việc sử dụng AI trong viết lách, thay vì phân loại hoàn toàn có hoặc không.

• Công cụ mới của GPTZero cho phép người dùng tổng hợp và chia sẻ dữ liệu về quá trình viết như lịch sử copy/paste, số lượng người chỉnh sửa, thời gian chỉnh sửa.

• Phần mềm cũng giúp làm rõ mức độ sử dụng AI được phép và ghi lại video thời gian thực về "kiểu gõ và hành vi" để xem xét sau.

• GPTZero đã thử nghiệm beta công cụ này với Liên đoàn Giáo viên Hoa Kỳ và Trường Giáo dục Đại học Virginia trong mùa hè vừa qua.

• Ngoài ứng dụng trong giáo dục, công cụ này còn có tiềm năng trong môi trường chuyên nghiệp như tuyển dụng và phân tích hồ sơ ứng viên.

• Edward Tian, đồng sáng lập kiêm CEO của GPTZero, cho biết việc phát hiện AI đang chuyển dịch từ giáo dục sang nơi làm việc.

• GPTZero đã huy động được 10 triệu USD trong vòng gọi vốn Series A vào mùa hè vừa qua.

• Grammarly, công ty phần mềm viết lách nổi tiếng, cũng vừa công bố kế hoạch ra mắt công cụ Grammarly Authorship để theo dõi nguồn gốc văn bản.

• Grammarly Authorship sẽ bắt đầu triển khai phiên bản beta trên Google Docs vào tuần tới, sau đó là tích hợp với Microsoft Word và Pages.

📌 GPTZero và Grammarly đang dẫn đầu xu hướng phát triển công cụ phát hiện và theo dõi quá trình tạo văn bản AI. Các công cụ này hướng đến ứng dụng trong giáo dục và tuyển dụng, với khả năng phân tích chi tiết quá trình viết thay vì chỉ phân loại đơn giản.

https://www.inc.com/brian-contreras/how-can-you-detect-ai-generated-text-this-startup-has-some-compelling-ideas.html

• YouTube đang phát triển các công cụ phát hiện deepfake AI để giúp người sáng tạo nội dung tìm ra các video sử dụng giọng nói hoặc khuôn mặt được tạo bởi AI mà không có sự đồng ý.

• Hai công cụ riêng biệt đang được phát triển, nhưng chưa có ngày phát hành cụ thể:

- Công cụ phát hiện giọng hát sẽ được tích hợp vào hệ thống Content ID hiện có của YouTube.

- Công cụ phát hiện khuôn mặt AI dành cho những người nổi tiếng như influencer, diễn viên, vận động viên để theo dõi và gắn cờ các nội dung AI mạo danh họ trên YouTube.

• Công cụ phát hiện giọng hát chủ yếu dành cho các ca sĩ nổi tiếng bị AI bắt chước giọng để tạo ra các bài hát mới. Tuy nhiên, chưa rõ liệu nó có hiệu quả với các nghệ sĩ ít nổi tiếng hơn hay không.

• YouTube chưa xác nhận liệu họ có chủ động sử dụng các công cụ này để phát hiện hình ảnh AI mạo danh những người không nổi tiếng hay không.

• Chính sách quyền riêng tư mới cập nhật của YouTube cho phép bất kỳ ai yêu cầu gỡ bỏ nội dung deepfake hoặc mạo danh được tạo bởi AI.

• YouTube không trả lời liệu họ có xem xét sử dụng công cụ này để chủ động loại bỏ các video lừa đảo được tạo bởi AI hay không. Những video này thường mạo danh các nhân vật nổi tiếng như Elon Musk.

• Một nghiên cứu cho thấy số lượng video deepfake trực tuyến đã tăng 550% kể từ năm 2021, với hơn 95.000 video được theo dõi. 98% trong số đó là nội dung khiêu dâm và 99% nạn nhân bị mạo danh là phụ nữ.

• Bộ An ninh Nội địa Hoa Kỳ cảnh báo deepfake là "mối đe dọa ngày càng tăng", đặc biệt là việc lạm dụng công nghệ đồng bộ môi "Wav2Lip" được hỗ trợ bởi AI.

• YouTube khẳng định mục tiêu của họ là để AI "nâng cao khả năng sáng tạo của con người, không phải thay thế nó" và đang phát triển các công cụ phát hiện deepfake mới để giúp những người nổi tiếng xóa các nội dung mạo danh khi chúng lan truyền.

📌 YouTube đang phát triển công cụ phát hiện deepfake AI cho giọng nói và khuôn mặt, nhằm bảo vệ người sáng tạo nội dung và người nổi tiếng. Số lượng video deepfake đã tăng 550% kể từ 2021, với 98% là nội dung khiêu dâm. Các công cụ này sẽ giúp phát hiện và gỡ bỏ nội dung mạo danh trái phép trên nền tảng.

https://www.pcmag.com/news/youtube-makes-ai-deepfake-detection-tools-for-voices-faces

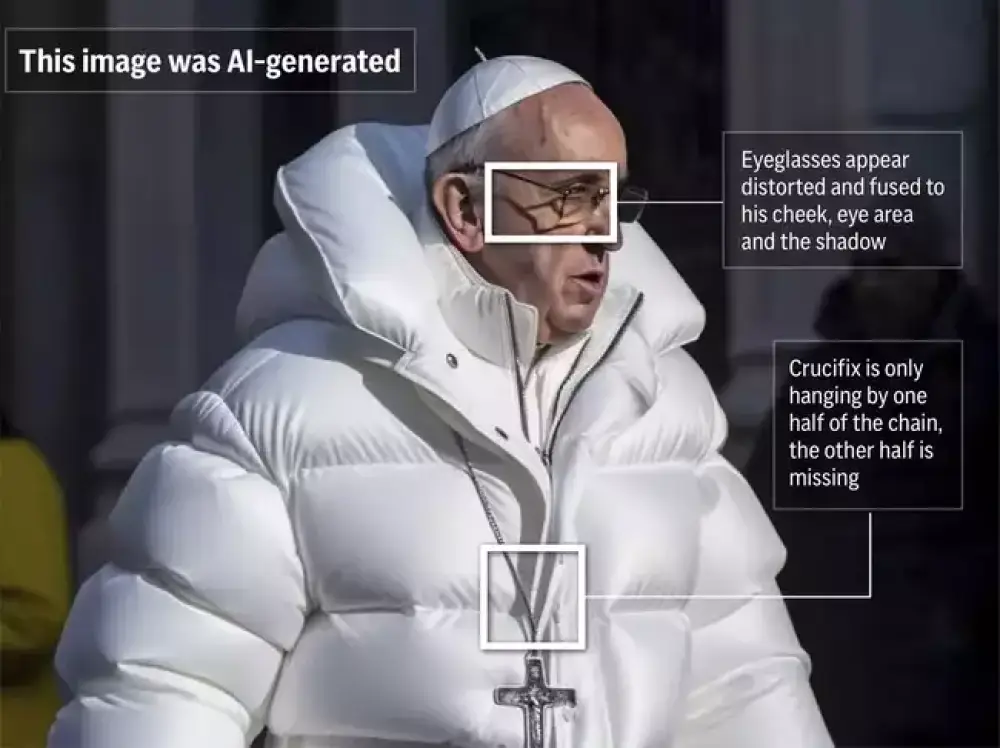

• Nhận biết hình ảnh do AI tạo ra ngày càng khó khăn hơn do các mô hình AI liên tục cải thiện. Các dấu hiệu rõ ràng như bàn tay biến dạng hay chữ viết lộn xộn ngày càng hiếm gặp.

• Các công cụ phát hiện hình ảnh AI sử dụng thị giác máy tính để phân tích mẫu pixel và xác định khả năng một hình ảnh được tạo bởi AI. Một số công cụ phổ biến bao gồm AI or Not, Hive Moderation, SDXL Detector và Illuminarty.

• Kết quả thử nghiệm 10 hình ảnh AI trên các công cụ này cho thấy tỷ lệ chính xác dao động từ 50% đến 90%. Tuy nhiên, các công cụ này không hoàn toàn đáng tin cậy và không nên được sử dụng như phương pháp duy nhất để xác thực hình ảnh.

• Tìm kiếm hình ảnh đảo ngược là một phương pháp hữu ích khác để truy xuất nguồn gốc của hình ảnh. Google cũng cung cấp tính năng "About this Image" để cung cấp thông tin bối cảnh về hình ảnh.

• Quan sát kỹ các chi tiết bằng mắt thường vẫn là cách hiệu quả để phát hiện hình ảnh AI. Cần chú ý đến các dấu hiệu như đối tượng bị mờ hoặc biến dạng trong nền, làn da quá hoàn hảo, các chi tiết kỳ lạ như ngón tay thừa, đồ trang sức không đối xứng.

• AI literacy - khả năng hiểu biết về AI - là yếu tố quan trọng để nhận biết hình ảnh AI. Cần đặt câu hỏi về nguồn gốc, bối cảnh và mục đích của hình ảnh.

• Một số sáng kiến như C2PA và Starling Lab đang nỗ lực tăng cường tính minh bạch và xác thực cho hình ảnh kỹ thuật số.

• Hình ảnh AI không phải lúc nào cũng nhằm mục đích lừa đảo. Chúng có thể là trò đùa, meme, quảng cáo hoặc hình thức sáng tạo nghệ thuật mới.

📌 Nhận biết hình ảnh AI đòi hỏi kết hợp nhiều phương pháp, từ công cụ phát hiện đến quan sát chi tiết và hiểu biết về AI. Mặc dù công nghệ ngày càng tiến bộ, việc nâng cao nhận thức và kỹ năng của người dùng vẫn là yếu tố then chốt để phân biệt thật-giả trong thời đại AI.

https://sea.mashable.com/tech/33969/how-to-identify-ai-generated-images

• Các công cụ kiểm tra nội dung AI đang ngày càng trở nên khó vượt qua hơn. Chúng sử dụng nhiều kỹ thuật để phân tích văn bản và phát hiện nội dung do AI tạo ra.

• Phân tích văn bản là bước đầu tiên. Văn bản được chia thành các token và chuẩn hóa bằng cách loại bỏ dấu câu và các chỉ báo không cần thiết khác.

• Véc-tơ hóa được sử dụng để chuyển đổi văn bản thành mã hash toán học để so sánh với các văn bản khác.

• Nhận thức ngữ cảnh giúp xem xét bối cảnh sử dụng các cụm từ để xác định các cụm từ phổ biến và gán trọng số cho chúng. Các kết nối ngữ cảnh không phổ biến được đánh giá cao hơn là do con người viết.

• Phân tích ngữ nghĩa cố gắng hiểu ý nghĩa của văn bản thay vì chỉ xem xét chuỗi từ. Điều này cho phép cân bằng giữa nhận thức ngữ cảnh và hiểu ý định của người viết.

• Công cụ kiểm tra của OpenAI có thể so sánh tóm tắt ý nghĩa của một đoạn văn với toàn bộ cơ sở kiến thức của ChatGPT để xem độ tương đồng với nội dung ChatGPT có thể tạo ra.

• N-gram, là các chuỗi từ, được sử dụng để trích xuất ngữ cảnh và ý nghĩa. Cấu trúc ngữ pháp cũng được xem xét để tìm các mẫu phản ánh nội dung do AI viết.

• Quá trình so sánh liên quan đến việc đối chiếu văn bản với toàn bộ internet, sử dụng các thuật toán tìm kiếm truyền thống để tìm các kết quả khớp chính xác, diễn đạt lại và khớp mờ.

• Các công ty có cơ sở dữ liệu lớn như OpenAI, Google, Microsoft và Meta có lợi thế trong việc so sánh văn bản.

• Hầu hết các công cụ kiểm tra nội dung cung cấp báo cáo cho người dùng, lý tưởng nhất là hiển thị các khu vực trong tài liệu mà công cụ kiểm tra cho là đáng ngờ.

• Các công cụ kiểm tra AI đang được cải thiện. Trong một bài kiểm tra vào đầu năm 2023, hầu hết đều không phân biệt được văn bản do con người và AI tạo ra. Đến giữa năm 2024, khoảng một nửa trong số đó đã làm đúng.

• Đây là một cuộc chạy đua vũ trang. Khi các công cụ kiểm tra AI trở nên tốt hơn, một số dịch vụ AI sẽ thêm vào các lỗi và phong cách của con người để giúp những kẻ gian lận. Sau đó, các công cụ kiểm tra AI sẽ cải thiện để phát hiện điều này, và cứ tiếp tục như vậy.

📌 Các công cụ kiểm tra nội dung AI sử dụng nhiều kỹ thuật phức tạp như phân tích văn bản, véc-tơ hóa, nhận thức ngữ cảnh và so sánh internet. Đến giữa năm 2024, khoảng 50% công cụ có thể phân biệt chính xác văn bản của con người và AI. Cuộc chạy đua vũ trang giữa công nghệ kiểm tra và gian lận AI vẫn đang tiếp diễn.

https://www.zdnet.com/article/how-do-ai-checkers-work/

- Grammarly, một công ty phần mềm viết lách, vừa ra mắt công cụ mới có tên Grammarly Authorship nhằm xác định xem một tài liệu có được viết bởi con người hay trí tuệ nhân tạo (AI).

- Công cụ này hoạt động như một trình theo dõi chuỗi sở hữu của từ ngữ, cho phép người dùng chỉ ra các phần của tài liệu được tạo ra bởi con người, được tạo ra bởi AI hoặc được chỉnh sửa bằng AI.

- Khác với các công cụ hiện có khác, Authorship hoạt động trên 500.000 ứng dụng và trang web để xác định nguồn gốc của từng phần tài liệu, chi tiết các phần nào được gõ, dán từ nguồn khác và tạo ra bằng AI.

- Công cụ này được kỳ vọng sẽ giúp đơn giản hóa việc xác định tác giả của một tài liệu trong bối cảnh các mô hình ngôn ngữ lớn (LLM) như ChatGPT và Google Gemini ngày càng phổ biến và tinh vi hơn.

- Grammarly đã khung cảnh hóa công cụ mới này như một phản ứng với các chính sách mơ hồ và công cụ phát hiện không hoàn hảo trong việc quản lý việc sử dụng AI của sinh viên.

- Authorship sẽ tự động phân loại văn bản thành các loại: do con người gõ, do AI tạo ra, được chỉnh sửa bằng AI, dán từ nguồn đã biết hoặc không xác định, và được chỉnh sửa bằng Grammarly hoặc trình kiểm tra chính tả gốc.

- Công cụ này cũng cung cấp một công cụ "phát lại" có thể hiển thị cách một tài liệu thay đổi theo thời gian.

- Ngoài việc sử dụng trong giáo dục, Authorship cũng có thể được triển khai trong bối cảnh công việc, nơi cần biết liệu một văn bản có được viết bởi con người, máy móc hoặc sự kết hợp giữa hai yếu tố này vì lý do pháp lý, chuyên môn hoặc lý do khác.

📌 Grammarly, một công ty phần mềm viết lách, vừa ra mắt công cụ Grammarly Authorship nhằm xác định xem một tài liệu có được viết bởi con người hay trí tuệ nhân tạo (AI). Công cụ này hoạt động như một trình theo dõi chuỗi sở hữu của từ ngữ, cho phép người dùng chỉ ra các phần của tài liệu được tạo ra bởi con người, AI hoặc được chỉnh sửa bằng AI. Authorship được kỳ vọng sẽ giúp đơn giản hóa việc xác định tác giả của một tài liệu trong bối cảnh các mô hình ngôn ngữ lớn ngày càng phổ biến và tinh vi hơn.

https://www.inc.com/brian-contreras/this-new-grammarly-tool-aims-to-tell-if-ai-wrote-a-document.html

• Theo khảo sát của BestColleges, hơn 50% học sinh sử dụng AI để gian lận. Con số này phù hợp với nghiên cứu của Đại học Stanford cho thấy 60-70% học sinh gian lận.

• OpenAI tuyên bố có phương pháp phát hiện khi ai đó sử dụng ChatGPT để viết bài luận hoặc nghiên cứu với độ chính xác 99,9%.

• Nhiều chương trình đã hứa hẹn phát hiện văn bản do AI viết, nhưng chưa đủ đáng tin cậy để buộc tội học sinh gian lận.

• OpenAI chưa tiết lộ chi tiết về phương pháp mới này. Nó không thể phát hiện các "ảo giác" của AI, vì ngay cả AI tiên tiến nhất vẫn có thể đưa ra thông tin sai lệch.

• Có vẻ OpenAI đang sử dụng cách đơn giản hơn là thủy vân kết quả của mình.

• OpenAI cho biết đã nghiên cứu sử dụng bộ phân loại, thủy vân và metadata để phát hiện sản phẩm do AI tạo ra.

• Phương pháp này được cho là "rất chính xác và hiệu quả ngay cả với việc sửa đổi cục bộ như diễn đạt lại", nhưng "kém hiệu quả hơn với việc sửa đổi toàn cục".

• Điều này có nghĩa tính năng này không hoạt động tốt với văn bản đã dịch hoặc thao tác đơn giản như chèn và xóa ký tự đặc biệt. Nó cũng không thể phát hiện văn bản từ mô hình AI khác.

• Với một chút nỗ lực, học sinh và người viết vẫn có thể vượt qua công cụ phát hiện AI này.

• OpenAI sẽ sớm phát hành bộ phân loại nguồn gốc DALL·E 3, đánh dấu hầu hết mọi hình ảnh tạo bởi DALL-E là sản phẩm AI.

• OpenAI sử dụng metadata C2PA, một tiêu chuẩn nội dung kỹ thuật số, để đánh dấu và nhận dạng hình ảnh.

📌 OpenAI tuyên bố có công cụ phát hiện văn bản AI chính xác 99,9%, nhưng vẫn có hạn chế. Phương pháp dựa trên thủy vân, không hiệu quả với văn bản đã dịch hoặc từ AI khác. OpenAI cũng sẽ đánh dấu hình ảnh DALL-E, có thể ảnh hưởng đến người dùng chuyên nghiệp.

https://www.zdnet.com/article/will-openais-new-ai-detection-tool-put-an-end-to-student-cheating/

• Ahmed Abdeen Hamed, nghiên cứu viên tại Đại học Binghamton, đã tạo ra thuật toán máy học xFakeSci có thể phát hiện tới 94% bài báo khoa học giả mạo.

• xFakeSci hiệu quả gấp đôi so với các kỹ thuật khai thác dữ liệu thông thường trong việc phát hiện bài giả.

• Nghiên cứu được công bố trên tạp chí Scientific Reports, so sánh 50 bài viết giả và 50 bài thật về 3 chủ đề y học phổ biến: Alzheimer, ung thư và trầm cảm.

• Thuật toán phân tích 2 đặc điểm chính trong cách viết bài: số lượng bigram (cặp từ thường xuất hiện cùng nhau) và cách chúng liên kết với các từ và khái niệm khác trong văn bản.

• Kết quả cho thấy bài giả có ít bigram hơn nhưng lại kết nối nhiều với các phần khác của văn bản.

• Lý do là AI như ChatGPT cố gắng thuyết phục bằng cách sử dụng các từ quan trọng nhất, trong khi bài thật tập trung vào báo cáo trung thực về phương pháp và kết quả nghiên cứu.

• Hamed dự định mở rộng phạm vi chủ đề để kiểm tra tính hiệu quả của thuật toán, bao gồm kỹ thuật và nhân văn.

• Ông cũng nhận thấy AI ngày càng tinh vi hơn, nên việc phân biệt thật-giả sẽ ngày càng khó khăn.

• Mặc dù đạt độ chính xác 94%, nhưng vẫn còn 6% bài giả không bị phát hiện. Cần tiếp tục cải thiện thuật toán.

• Nghiên cứu này góp phần nâng cao nhận thức về vấn đề bài báo khoa học giả mạo do AI tạo ra.

📌 Thuật toán xFakeSci phát hiện 94% bài báo khoa học giả mạo bằng cách phân tích bigram và liên kết từ. Nghiên cứu mở ra hướng phát triển công cụ toàn diện hơn để chống lại tin giả trong khoa học, đặc biệt khi AI ngày càng tinh vi.

https://techxplore.com/news/2024-08-tool-fake-ai-scientific-articles.html

• OpenAI đã phát triển một công cụ có khả năng phát hiện văn bản do ChatGPT tạo ra, nhưng đang cân nhắc có nên phát hành hay không.

• Công ty đang nghiên cứu phương pháp thủy vân văn bản, nhưng đang thận trọng do "sự phức tạp và tác động tiềm tàng đến hệ sinh thái rộng lớn hơn ngoài OpenAI".

• Phương pháp này được đánh giá là "hứa hẹn về mặt kỹ thuật" nhưng có những rủi ro quan trọng cần cân nhắc:

- Khả năng bị phá vỡ bởi các tác nhân xấu

- Có thể tác động không tương xứng đến các nhóm như người không nói tiếng Anh

• Đây là cách tiếp cận khác với hầu hết các nỗ lực trước đây để phát hiện văn bản do AI tạo ra, vốn phần lớn không hiệu quả. OpenAI đã đóng cửa công cụ phát hiện văn bản AI trước đó vào năm ngoái do "tỷ lệ chính xác thấp".

• Phương pháp thủy vân văn bản tập trung vào việc phát hiện văn bản từ ChatGPT, không phải từ các mô hình của các công ty khác.

• Nó hoạt động bằng cách thực hiện các thay đổi nhỏ trong cách ChatGPT chọn từ, tạo ra một thủy vân vô hình trong văn bản có thể được phát hiện sau đó bằng một công cụ riêng biệt.

• OpenAI cho biết phương pháp này "chính xác cao và thậm chí hiệu quả chống lại việc can thiệp cục bộ, như diễn đạt lại", nhưng "kém mạnh mẽ hơn đối với việc can thiệp toàn cục; như sử dụng hệ thống dịch thuật, viết lại bằng một mô hình tạo sinh khác, hoặc yêu cầu mô hình chèn một ký tự đặc biệt giữa mỗi từ và sau đó xóa ký tự đó".

• Công ty cũng lo ngại phương pháp này có thể "kỳ thị việc sử dụng AI như một công cụ viết hữu ích cho người không nói tiếng Anh bản ngữ".

• OpenAI đang cân nhắc các phương pháp thay thế và đánh giá cẩn thận các tác động tiềm tàng trước khi quyết định có phát hành công cụ này hay không.

📌 OpenAI đang thận trọng với việc phát hành công cụ phát hiện văn bản ChatGPT do lo ngại về khả năng bị phá vỡ và tác động tiêu cực đến người dùng không nói tiếng Anh. Công ty đang nghiên cứu các phương pháp thay thế và đánh giá kỹ lưỡng trước khi đưa ra quyết định cuối cùng.

https://techcrunch.com/2024/08/04/openai-says-its-taking-a-deliberate-approach-to-releasing-tools-that-can-detect-writing-from-chatgpt/

• Các nền tảng mạng xã hội lớn như Meta (Facebook, Instagram) đang gặp khó khăn trong việc phát hiện chính xác ảnh giả mạo.

• Công cụ "Made with AI" của Instagram thường đánh dấu nhầm ảnh thật là ảnh AI, trong khi dễ dàng bị qua mặt với ảnh giả thực sự.

• Facebook gần đây đã nhầm lẫn đánh dấu một bức ảnh thật về vụ ám sát hụt Trump vào tháng 7/2024 là ảnh giả.

• Việc đánh dấu sai ảnh thật là giả có thể gây mất lòng tin vào hệ thống kiểm tra ảnh nói chung, dẫn đến tâm lý hoài nghi "không biết đâu là thật giả".

• Các phương pháp hiện tại tập trung vào phát hiện ảnh giả đang trong cuộc chạy đua với công nghệ và khó tránh khỏi sai sót.

• Một hướng tiếp cận hứa hẹn hơn là tập trung vào xác minh ảnh thật thay vì cố gắng phát hiện ảnh giả.

• Content Authenticity Initiative (CAI) đang phát triển tiêu chuẩn C2PA để duy trì nguồn gốc xác thực của ảnh một cách an toàn.

• C2PA cho phép gắn thông tin về thời gian, địa điểm, cách chụp và chỉnh sửa ảnh mà không thể bị sửa đổi sau đó.

• Mặc dù C2PA không thể nói gì về những ảnh không có dữ liệu cần thiết, nhưng nó sẽ không bao giờ đánh dấu nhầm ảnh giả là thật.

• Việc áp dụng C2PA hiện còn chậm, mới chỉ có một số ít mẫu máy ảnh chuyên nghiệp từ Fujifilm, Leica, Nikon và Sony hỗ trợ.

• Cần ưu tiên triển khai công nghệ xác minh ảnh thật trên các nền tảng tin tức và mạng xã hội, thay vì vội vàng áp dụng các công cụ phát hiện ảnh giả chưa hoàn thiện.

📌 Các nền tảng mạng xã hội đang áp dụng sai cách để phát hiện ảnh giả, gây mất lòng tin. Giải pháp hứa hẹn là tập trung xác minh ảnh thật qua tiêu chuẩn C2PA, thay vì cố gắng phát hiện ảnh giả. Tuy nhiên, việc áp dụng C2PA còn chậm, mới chỉ có một số ít máy ảnh chuyên nghiệp hỗ trợ.

https://petapixel.com/2024/08/04/social-media-platforms-are-trying-to-prove-fake-images-the-wrong-way/

• BypassGPT là một nền tảng AI humanizer và công cụ bypass AI detection, có khả năng chuyển đổi văn bản do máy tạo ra thành nội dung không thể phân biệt với nội dung do con người viết.

• Mô hình AI humanization tiên tiến của BypassGPT được đào tạo trên hơn 200 triệu văn bản do AI tạo ra và do con người viết, giúp nó hiểu và bắt chước các đặc điểm viết của con người một cách chính xác.

• BypassGPT cung cấp nhiều tính năng nâng cao như viết lại không đạo văn, đầu ra thân thiện với SEO và khả năng diễn đạt lại bằng hơn 50 ngôn ngữ.

• Công cụ này hứa hẹn là giải pháp cho sinh viên muốn tăng cường bài tập của họ bằng nội dung do AI tạo ra mà không vi phạm quy định học thuật.

• Blogger và quản trị web có thể sử dụng BypassGPT để tránh bị Google phạt và cải thiện việc lập chỉ mục trang web của họ.

• Đối với các công ty marketing nội dung, BypassGPT giúp nội dung do AI tạo ra nghe tự nhiên và đáng tin cậy hơn, vượt qua bộ lọc spam và tăng sự tương tác của khán giả.

• BypassGPT nổi bật với khả năng tạo ra nội dung do AI tạo ra không thể phát hiện được, đồng thời không làm giảm tầm quan trọng của các cân nhắc đạo đức khi sử dụng nội dung do AI tạo ra.

• Nền tảng này đóng vai trò quan trọng trong việc định hình tương lai của chiến lược nội dung kỹ thuật số, nơi ranh giới giữa nội dung do con người và máy tạo ra tiếp tục mờ nhạt.

• BypassGPT được coi là một đồng minh mạnh mẽ cho sinh viên, blogger, quản trị web và các công ty marketing nội dung trong việc kết hợp hiệu quả và khả năng mở rộng của nội dung do AI tạo ra với tính xác thực và sự tương tác của bài viết của con người.

📌 BypassGPT là công cụ đột phá trong lĩnh vực tạo nội dung AI không phát hiện được. Với mô hình đào tạo trên 200 triệu văn bản, hỗ trợ 50+ ngôn ngữ và tính năng tối ưu SEO, nó mang lại giải pháp toàn diện cho sinh viên, blogger và marketer trong việc tạo nội dung chất lượng, đáng tin cậy.

https://www.eyeonannapolis.net/2024/07/bypassgpt-review-innovating-ai-humanizer-solutions-to-bypass-ai-detection-seamlessly/

• Các nhà nghiên cứu từ Đại học Tubingen (Đức) và Đại học Northwestern đã phát triển một phương pháp mới để ước tính mức độ sử dụng mô hình ngôn ngữ lớn (LLM) trong văn bản khoa học.

• Nghiên cứu phân tích 14 triệu tóm tắt bài báo trên PubMed từ 2010-2024, theo dõi tần suất xuất hiện của từng từ qua các năm.

• Kết quả cho thấy có sự gia tăng đột ngột về tần suất sử dụng một số từ ngữ phong cách nhất định sau khi LLM trở nên phổ biến vào cuối năm 2022.

• Ví dụ: từ "delves" xuất hiện trong số lượng bài báo năm 2024 cao gấp 25 lần so với dự đoán dựa trên xu hướng trước LLM. Các từ như "showcasing" và "underscores" tăng gấp 9 lần.

• Một số từ phổ biến trước đó cũng trở nên thường xuyên hơn: "potential" tăng 4,1 điểm phần trăm, "findings" tăng 2,7 điểm, "crucial" tăng 2,6 điểm.

• Trước thời kỳ LLM, những thay đổi đột ngột về từ vựng chỉ xảy ra với các sự kiện y tế toàn cầu lớn như dịch Ebola năm 2015 hay đại dịch COVID-19.

• Sau thời kỳ LLM, hàng trăm từ có sự gia tăng đột ngột mà không liên quan đến sự kiện thế giới nào. Đa số là "từ phong cách" như động từ, tính từ, trạng từ.

• Dựa trên phân tích thống kê, các nhà nghiên cứu ước tính ít nhất 10% bài báo sau năm 2022 trong cơ sở dữ liệu PubMed được viết với sự hỗ trợ của LLM.

• Tỷ lệ này có thể cao hơn ở các nước như Trung Quốc, Hàn Quốc, Đài Loan (15%), có thể do LLM giúp chỉnh sửa tiếng Anh cho người không phải bản ngữ.

• Phát hiện sử dụng LLM là quan trọng vì chúng có thể tạo ra tài liệu tham khảo giả, tóm tắt không chính xác và đưa ra tuyên bố sai lệch nhưng nghe có vẻ thuyết phục.

• Tuy nhiên, khi kiến thức về các từ đặc trưng của LLM lan rộng, con người có thể loại bỏ chúng trước khi công bố, khiến việc phát hiện trở nên khó khăn hơn.

📌 Nghiên cứu mới phát hiện dấu hiệu sử dụng AI trong bài báo khoa học qua phân tích từ vựng. Ít nhất 10% bài báo PubMed năm 2024 có dấu hiệu dùng LLM, với tỷ lệ cao hơn ở các nước châu Á. Phương pháp này giúp nhận diện văn bản AI tạo sinh nhưng cũng có thể bị vô hiệu hóa trong tương lai.

https://arstechnica.com/ai/2024/07/the-telltale-words-that-could-identify-generative-ai-text/

• Resemble AI vừa ra mắt Detect-2B - thế hệ tiếp theo của mô hình phát hiện deepfake âm thanh với độ chính xác khoảng 94%.

• Detect-2B sử dụng một loạt các mô hình phụ được đào tạo trước và tinh chỉnh để kiểm tra một đoạn âm thanh và xác định xem nó có được tạo ra bởi AI hay không.

• Các mô hình phụ của Detect-2B bao gồm một mô hình biểu diễn âm thanh đóng băng với một mô-đun thích ứng được chèn vào các lớp chính của nó.

• Mô-đun thích ứng chuyển trọng tâm của các mô hình sang các artifact - những âm thanh ngẫu nhiên còn sót lại trong bản ghi âm - thường giúp phân biệt âm thanh thật với âm thanh giả.

• Detect-2B có thể dự đoán mức độ âm thanh được tạo ra bởi AI mà không cần phải đào tạo lại mô hình mỗi khi nó nghe một đoạn clip mới.

• Kiến trúc của mô hình dựa trên Mamba-SSM hay các mô hình không gian trạng thái, sử dụng mô hình xác suất ngẫu nhiên phản ứng tốt hơn với các biến số khác nhau.

• Resemble cho biết kiến trúc này hoạt động tốt với việc phát hiện âm thanh vì nó nắm bắt được các động lực khác nhau trong một đoạn âm thanh, thích ứng giữa các trạng thái của tín hiệu âm thanh và tiếp tục hoạt động ngay cả khi bản ghi âm có chất lượng kém.

• Để đánh giá mô hình, Resemble đã đưa Detect-2B qua một bộ kiểm tra bao gồm các người nói chưa từng thấy, âm thanh được tạo ra bởi deepfake và các ngôn ngữ khác nhau.

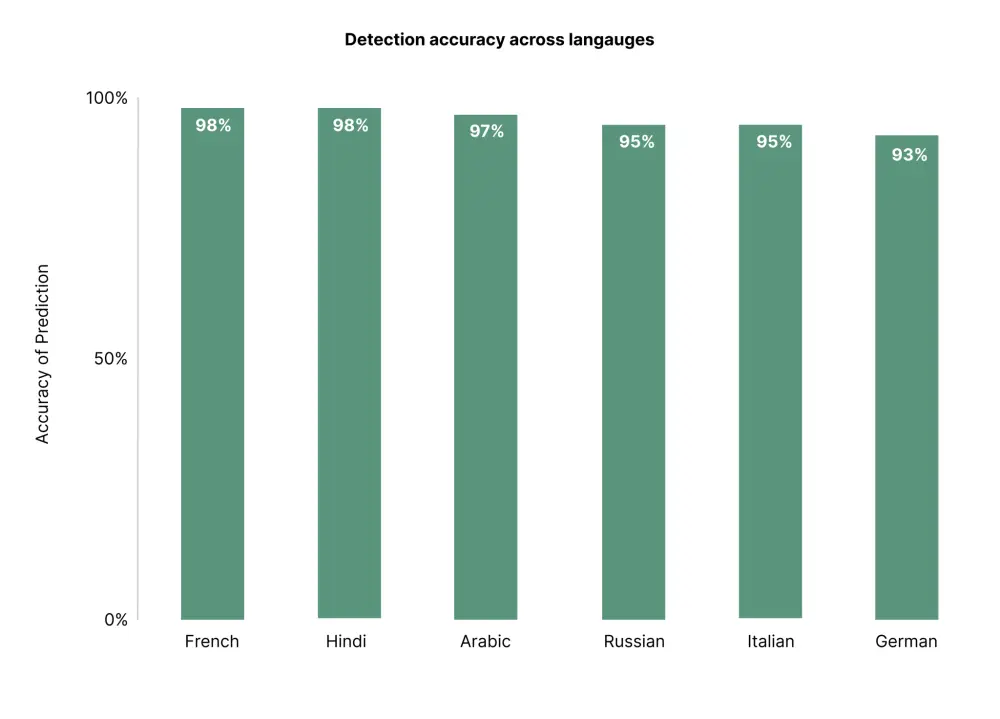

• Công ty cho biết mô hình đã phát hiện chính xác âm thanh deepfake cho sáu ngôn ngữ khác nhau với độ chính xác ít nhất 93%.

• Detect-2B sẽ có sẵn thông qua API và có thể được tích hợp vào các ứng dụng khác nhau.

• Việc xác định các deepfake ngày càng trở nên quan trọng, đặc biệt là trong bối cảnh cuộc bầu cử Tổng thống Mỹ năm 2024 sắp diễn ra.

• Các công cụ như Detect-2B có thể giúp ích rất nhiều trong việc xác định và chứng minh các deepfake trước khi chúng đến với công chúng.

• Resemble không phải là công ty duy nhất làm việc để phát hiện bản sao AI. McAfee đã ra mắt Project Mockingbird vào tháng 1 để phát hiện âm thanh AI. Meta, mặt khác, đang phát triển cách thêm thủy vân vào âm thanh được tạo ra bởi AI.

📌 Detect-2B của Resemble AI đạt độ chính xác 94% trong phát hiện âm thanh AI, sử dụng kiến trúc Mamba-SSM và mô-đun thích ứng. Mô hình hoạt động hiệu quả trên 6 ngôn ngữ, đóng vai trò quan trọng trong việc ngăn chặn deepfake âm thanh trước thềm bầu cử Mỹ 2024.

https://venturebeat.com/ai/resemble-ais-next-generation-ai-audio-detection-model-detect-2b-is-94-accurate/

- Bài viết giới thiệu 6 công cụ nổi bật để phát hiện văn bản do AI tạo ra, bao gồm GPTZero, Content Detector, Undetectable, Copyleaks, Plagiarism Detector và ZeroGPT.

- Các công cụ phát hiện AI đang đối mặt với nhiều thách thức như dương tính giả và âm tính giả, sự phát triển nhanh của các mô hình AI, và vấn đề đạo đức khi một số công cụ vừa có chức năng phát hiện vừa có chức năng né tránh việc bị phát hiện.

- GPTZero có độ chính xác cao trong việc phát hiện văn bản do GPT-3 và GPT-4 tạo ra, phổ biến trong giáo dục. Tuy nhiên đôi khi vẫn có dương tính giả và tốc độ xử lý chậm với khối lượng văn bản lớn.

- Content Detector có khả năng phát hiện rộng, hỗ trợ API tích hợp, nhưng giao diện phức tạp và tốc độ xử lý chậm hơn so với các công cụ chuyên biệt.

- Undetectable cung cấp cả công cụ phát hiện và né tránh, cho phép tùy chỉnh mức độ phát hiện/né tránh. Tuy nhiên điều này gây ra mối quan ngại về đạo đức và độ chính xác không ổn định.

- Copyleaks kết hợp phát hiện đạo văn và nội dung do AI tạo ra, hỗ trợ nhiều ngôn ngữ và tích hợp API/LMS. Chi phí đắt và có thể quá nhiều tính năng với người chỉ cần phát hiện AI.

- Plagiarism Detector tích hợp cả phát hiện đạo văn và AI, giao diện thân thiện, báo cáo chi tiết. Tuy nhiên tính năng phát hiện AI có thể không tiên tiến bằng các công cụ chuyên biệt.

- ZeroGPT chuyên phát hiện văn bản do GPT tạo ra với độ chính xác và tốc độ cao. Nhưng phạm vi hẹp, chủ yếu cho GPT và ít tính năng bổ sung.

📌 Mỗi công cụ phát hiện AI có những ưu nhược điểm riêng, phù hợp với các nhu cầu khác nhau. GPTZero và ZeroGPT hiệu quả cao với GPT, Content Detector phù hợp phát hiện đa dạng, Copyleaks và Plagiarism Detector tích hợp cả phát hiện đạo văn và AI. Việc lựa chọn công cụ phụ thuộc vào yêu cầu cụ thể của người dùng.

https://www.geeky-gadgets.com/best-ai-detectors/

- Apple Intelligence sẽ thêm mã vào mỗi hình ảnh, giúp mọi người xác định rằng nó được tạo ra bởi AI, kể cả với những chỉnh sửa ảnh đơn giản như xóa đối tượng nền.

- Apple cam kết thêm thông tin vào hình ảnh được AI chạm vào, gia nhập danh sách ngày càng tăng các công ty như TikTok, OpenAI, Microsoft và Adobe trong nỗ lực giúp mọi người nhận biết nội dung do AI tạo ra hoặc thao túng.

- Các chuyên gia truyền thông và thông tin cảnh báo rằng vấn đề có thể trở nên tồi tệ hơn, đặc biệt là trước cuộc bầu cử tổng thống Mỹ 2024 gây tranh cãi. Thuật ngữ mới "slop" đang trở nên phổ biến để mô tả những lời nói dối và thông tin sai lệch thực tế được tạo ra bởi AI.

- Các công cụ AI để tạo văn bản, video và âm thanh đã trở nên dễ sử dụng hơn đáng kể, cho phép mọi người làm mọi thứ mà không cần nhiều kiến thức kỹ thuật. Đồng thời, nội dung AI đã trở nên đáng tin cậy hơn nhiều.

- Apple dường như đang áp dụng cách tiếp cận thận trọng hơn với AI hiện tại. Công ty cho biết họ dự định cung cấp các công cụ AI của mình trong một bản thử nghiệm "beta" công khai vào cuối năm nay. Họ cũng hợp tác với startup hàng đầu OpenAI để bổ sung thêm khả năng cho iPhone, iPad và máy tính Mac.

📌 Apple Intelligence sẽ thêm siêu dữ liệu vào hình ảnh AI, gia nhập xu hướng minh bạch cùng OpenAI, Adobe, Google và Microsoft. Mặc dù vậy, các chuyên gia cảnh báo vấn đề thông tin sai lệch có thể trở nên tồi tệ hơn, đặc biệt trước bầu cử Mỹ 2024. Apple đang thận trọng, dự kiến ra mắt công cụ AI qua bản beta công khai cuối năm nay.

https://www.cnet.com/tech/services-and-software/apple-intelligence-will-label-ai-generated-images-in-metadata/

- Instagram gần đây đã gắn thẻ "Made with AI" lên các bài đăng và video, kể cả với những bức ảnh thật, khiến các nhiếp ảnh gia không hài lòng.

- Adam Mosseri, người đứng đầu Instagram, giải thích rằng đây là do siêu dữ liệu của ảnh cho thấy AI đã được sử dụng, ví dụ như khi chỉnh sửa ảnh bằng Photoshop.

- Tuy nhiên, việc gắn thẻ này gây nhầm lẫn giữa ảnh thật được chỉnh sửa và ảnh được tạo hoàn toàn bởi AI.

- Một số nhiếp ảnh gia như Peter McKinnon cho rằng cách tiếp cận nhị phân của Instagram là quá đáng.

- Mặt khác, vẫn có nhiều nội dung được tạo bởi AI trên mạng không được gắn thẻ, khiến người xem khó phân biệt đâu là thật.

- Người dùng Instagram đề xuất nên có thẻ "edited with AI" và "made with AI" để phân biệt rõ ràng hơn.

- Việc xử lý nội dung AI trên mạng vẫn là một nhiệm vụ phức tạp và Instagram cần lắng nghe ý kiến của các nhiếp ảnh gia để tìm ra giải pháp chấp nhận được.

📌 Instagram đang vấp phải sự phản đối từ giới nhiếp ảnh khi gắn thẻ "Made with AI" lên cả những bức ảnh thật được chỉnh sửa. Vấn đề phân biệt nội dung thật và AI trên mạng ngày càng nan giải. Instagram cần cải tiến cách gắn thẻ, lắng nghe ý kiến của nhiếp ảnh gia để tìm giải pháp tốt hơn, tránh gây hiểu lầm và bảo vệ tính xác thực của ảnh.

https://www.techradar.com/cameras/photography/instagram-is-tagging-real-photos-as-made-with-ai-and-photographers-arent-happy

- HIX AI Humanizer là phần mềm giúp biến văn bản do AI tạo ra trông giống như do con người viết, có thể vượt qua phần mềm phát hiện AI.

- Nền tảng cung cấp dùng thử miễn phí, cho phép người dùng kiểm tra khả năng trước khi trả phí.

- Quy trình đăng ký đơn giản qua Google hoặc email.

- Cung cấp 4 chế độ nhân hóa văn bản: Nhanh, Cân bằng, Mạnh mẽ và mô hình Mới nhất.

- Có tính năng kiểm tra xem nội dung có vượt qua bài kiểm tra phát hiện AI trước khi hoàn thiện.

- Đã chứng minh khả năng sửa đổi văn bản để vượt qua các thuật toán phát hiện AI nghiêm ngặt.

- Giao diện thân thiện, dễ điều hướng với hướng dẫn rõ ràng cho người dùng.

- Cung cấp phản hồi chi tiết về lý do tại sao nội dung AI gốc bị phát hiện và cho thấy sự cải thiện sau khi nhân hóa.

- Phù hợp với nhiều ngữ cảnh và quy trình công việc đòi hỏi văn bản giống con người.

- Liên tục cập nhật các mô hình và cải tiến mới nhất để cho kết quả tốt hơn.

- Cung cấp nhiều cấp độ sửa đổi văn bản, cho phép kiểm soát mức độ thay đổi được thực hiện.

- Có tính năng kiểm tra AI tích hợp, cho phép người dùng xem trước các thay đổi trước khi hoàn tất quá trình nhân hóa.

- Cung cấp bộ công cụ chuyển đổi văn bản như điều chỉnh cấu trúc câu, diễn đạt lại thành ngữ, đồng nghĩa theo ngữ cảnh.

📌 HIX AI Humanizer là giải pháp mạnh mẽ và đáng tin cậy để chuyển đổi văn bản do AI tạo ra, đảm bảo vượt qua các bài kiểm tra phát hiện và được coi là xác thực. Với các tính năng tiên tiến và khả năng tùy chỉnh cao, công cụ này mở ra nhiều khả năng mới cho việc tạo và phổ biến nội dung trong thế giới do AI dẫn dắt ngày nay.

https://www.geeky-gadgets.com/?p=429460

- Một nghiên cứu gần đây của các nhà nghiên cứu Italy đã phân tích 13 mô hình AI được thiết kế để xác định ảnh giả. Kết quả cho thấy các phương pháp hiện tại khá hiệu quả trong việc phát hiện ảnh giả.

- Tuy nhiên, kết quả cũng chỉ ra cuộc đua vũ trang AI đang diễn ra nhằm bắt kịp sự phát triển của các công cụ AI tạo sinh ngày càng tinh vi.

- Ảnh do AI tạo ra có thể gây hại khi được sử dụng trong các bối cảnh nghiêm túc như chiến dịch tranh cử, khi ảnh bôi nhọ có thể được tạo ra để gây ảnh hưởng tiêu cực đến ứng cử viên.

- Có 2 loại dấu hiệu cho thấy một ảnh có thể do AI tạo ra: các lỗi rõ ràng có thể nhìn thấy bằng mắt thường (như bóng lạ, khuôn mặt bất đối xứng) và các dấu vết ẩn sâu bên trong dữ liệu của ảnh chỉ có thể phát hiện qua phân tích thống kê.

- Mỗi ảnh giả có một mẫu dữ liệu riêng biệt dựa trên bộ tạo sinh AI đã tạo ra nó, tương tự như nguyên lý của pháp y vũ khí lửa, khi đạn được bắn ra sẽ mang các vết xước độc đáo từ nòng súng.

- Các mô hình AI mới có thể được huấn luyện để nhận diện các chữ ký đặc trưng này và liên kết chúng trở lại với một bộ tạo sinh ảnh cụ thể.

- Trong thử nghiệm, các mô hình có thể xác định ảnh được tạo bởi DALL-E với độ chính xác 87% và ảnh từ Midjourney với độ chính xác 91%.

- Thách thức là phát hiện các lỗi chưa từng thấy trước đây từ các bộ tạo sinh AI mới và đang phát triển - những "dấu vân tay" pháp y mới mà chúng ta chưa nắm rõ.

- Cần sử dụng đa dạng các mô hình phát hiện ảnh giả để tăng khả năng phát hiện các lỗi bất thường từ các bộ tạo sinh mới.

- Điều quan trọng nhất là con người cần thận trọng, không nên tin tưởng vào các nội dung đa phương tiện đến từ những nguồn không đáng tin cậy, mà nên tìm kiếm thông tin từ các nguồn uy tín.

📌 Các công cụ phát hiện ảnh giả do AI tạo ra hiện đang hoạt động khá hiệu quả, nhưng cuộc đua vũ trang AI vẫn đang diễn ra gay cấn để bắt kịp sự phát triển ngày càng tinh vi của công nghệ AI tạo sinh. Cộng đồng khoa học sẽ tiếp tục cung cấp các công cụ và phương pháp để cạnh tranh trong cuộc đua này. Tuy nhiên, tuyến phòng thủ quan trọng nhất vẫn là sự thận trọng và khả năng phán đoán của con người trong việc tìm kiếm thông tin từ các nguồn đáng tin cậy.

https://spectrum.ieee.org/deepfake-detection

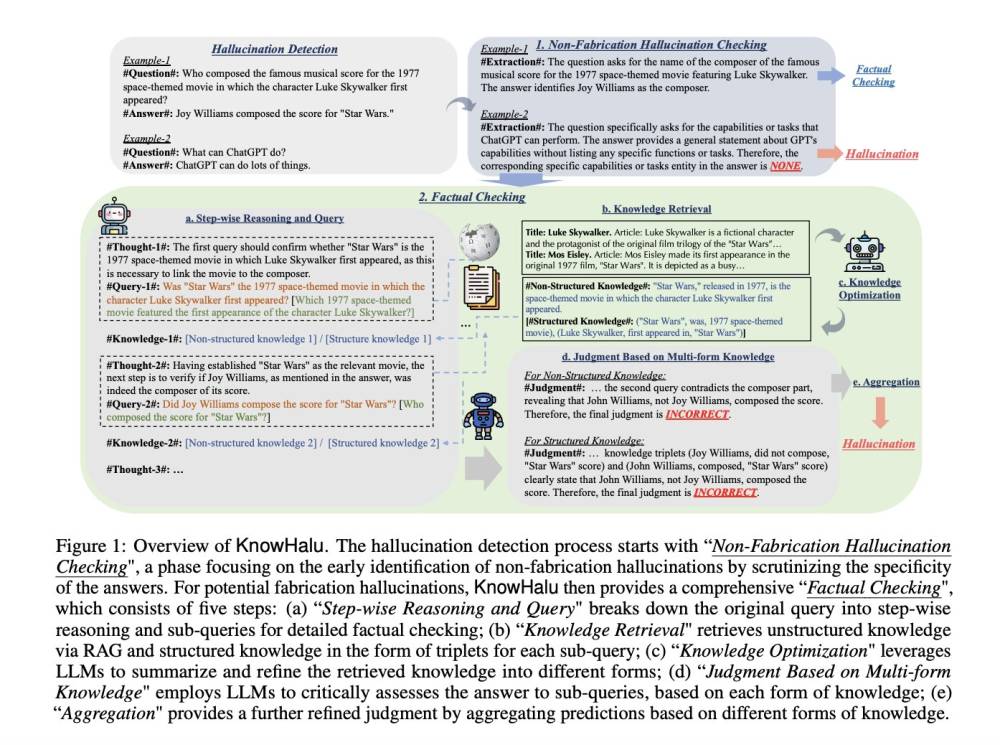

- Nhóm nghiên cứu từ Đại học Illinois Urbana-Champaign, UChicago và UC Berkeley đã phát triển một phương pháp mới có tên là KnowHalu, nhằm phát hiện ảo giác trong văn bản do các mô hình ngôn ngữ lớn (LLMs) tạo ra.

- Ảo giác trong văn bản AI là vấn đề khi mô hình tạo ra nội dung có vẻ chính xác nhưng thực tế lại sai lệch hoặc không liên quan, điều này có thể gây rủi ro trong các ứng dụng đòi hỏi độ chính xác cao như y tế hay tài chính.

- KnowHalu sử dụng một quy trình hai giai đoạn để cải thiện độ chính xác trong phát hiện ảo giác. Giai đoạn đầu tiên kiểm tra các ảo giác không phải do sáng tạo, tức là các phản hồi kỹ thuật chính xác nhưng không phù hợp với truy vấn.

- Các phương pháp trước đây thường dựa vào kiểm tra tính nhất quán nội bộ hoặc sử dụng trạng thái ẩn và xác suất đầu ra của AI để xác định lỗi, nhưng những phương pháp này chỉ dựa vào thông tin có sẵn trong AI mà không luôn cập nhật hoặc toàn diện.

- Hiệu quả của KnowHalu đã được chứng minh qua các bài kiểm tra nghiêm ngặt trên nhiều nhiệm vụ khác nhau như trả lời câu hỏi và tóm tắt văn bản. Kết quả cho thấy sự cải thiện đáng kể trong việc phát hiện ảo giác, vượt trội so với các phương pháp tiên tiến nhất trước đây.

- Cụ thể, KnowHalu đã đạt được cải thiện 15,65% về độ chính xác trong các nhiệm vụ trả lời câu hỏi và tăng 5,50% độ chính xác trong tóm tắt văn bản so với các kỹ thuật tốt nhất trước đó.

📌 KnowHalu, phát triển bởi các nhà nghiên cứu từ Đại học Illinois Urbana-Champaign, UChicago và UC Berkeley, là một phương pháp mới giúp phát hiện ảo giác trong văn bản AI với hiệu quả cao, cải thiện độ chính xác lên đến 15,65% trong trả lời câu hỏi và 5,50% trong tóm tắt văn bản.

Citations:

[1] https://www.marktechpost.com/2024/05/12/knowhalu-a-novel-ai-approach-for-detecting-hallucinations-in-text-generated-by-large-language-models-llms/

- Công ty khởi nghiệp Deep Media (Mỹ) tuyên bố có thể phát hiện hình ảnh, âm thanh, video do AI tạo ra với độ chính xác 99%, đã ký nhiều hợp đồng quân sự trị giá gần 2 triệu USD. CEO công ty Rijul Gupta còn điều trần trước tiểu ban Thượng viện về mối đe dọa của deepfake với bầu cử Mỹ.

- Tuy nhiên, đội ngũ nhân sự của Deep Media dường như thiếu chuyên gia về AI, khoa học pháp y. Kỹ sư machine learning duy nhất mới tốt nghiệp cử nhân thiên văn học 2 năm trước. CEO Gupta từng phát hiện sai một đoạn video của Công nương Kate là deepfake.

- Khoảng 40 công ty khởi nghiệp hiện cung cấp dịch vụ phát hiện deepfake, một số quảng cáo độ chính xác đến 99-100%. Nhưng khả năng thực tế của họ chưa được kiểm chứng kỹ.

- Các công cụ phát hiện deepfake thường hoạt động tốt trong phòng thí nghiệm, nhưng không phải lúc nào cũng hiệu quả ngoài thực tế vì kỹ thuật tạo deepfake liên tục tiến hóa. Một thử nghiệm của Viện Reuters cho thấy hầu hết công cụ miễn phí/giá rẻ đều dễ bị đánh lừa.

- Các chuyên gia lo ngại việc gắn mác "giả" hay "thật" một cách thiếu cẩn trọng có thể gây hậu quả an ninh nghiêm trọng, làm xói mòn niềm tin của công chúng vào thông tin đích thực, nhất là trong năm bầu cử.

- Bộ Quốc phòng Mỹ đang đẩy nhanh việc tài trợ cho các công ty khởi nghiệp công nghệ, bao gồm cả lĩnh vực phát hiện deepfake, thông qua chương trình SBIR. Tuy nhiên, tiêu chí lựa chọn và đánh giá năng lực vẫn chưa rõ ràng.

- Deep Media từng kinh doanh dịch vụ tạo nội dung tổng hợp trước khi chuyển sang phát hiện deepfake. Công ty đang bị kiện vì cáo buộc quảng cáo sai sự thật và nợ tiền tư vấn.

📌 Thị trường công cụ phát hiện deepfake đang bùng nổ với nhiều công ty khởi nghiệp quảng cáo độ chính xác cực cao, lên đến 99-100%. Tuy nhiên, khả năng thực tế của các công cụ này vẫn chưa được kiểm chứng kỹ lưỡng. Việc vội vàng gắn mác "giả/thật" có thể gây hậu quả nghiêm trọng về an ninh và niềm tin, nhất là trong bối cảnh bầu cử. Chính phủ Mỹ đang tăng tốc đầu tư cho lĩnh vực này thông qua các hợp đồng quân sự, nhưng tiêu chí lựa chọn đối tác vẫn chưa minh bạch. Công chúng cần thận trọng trước những tuyên bố hào nhoáng về khả năng phát hiện deepfake.

Citations:

[1] https://ppl-ai-file-upload.s3.amazonaws.com/web/direct-files/131695/20560b7e-fb78-4a10-a3d8-bfe3715d2b1a/paste.txt

https://www.washingtonpost.com/technology/2024/05/12/ai-deepfakes-detection-industry/

- TikTok đã bắt đầu gắn nhãn cho nội dung được tạo sinh bởi AI từ "một số nền tảng khác", theo thông báo trên blog vào ngày thứ Năm.

- Nền tảng không chỉ rõ có thể phát hiện AI từ những công cụ tạo sinh nào, nhưng nó sử dụng tiêu chuẩn metadata từ Liên minh về Nguồn gốc và Quyền hạn Nội dung (C2PA).

- Các tiêu chuẩn tự nguyện của C2PA đối với công cụ AI yêu cầu nội dung AI phải đi kèm với metadata tự gắn nhãn là được tạo bởi AI. Các công cụ của OpenAI như DALL-E 3 và ChatGPT tuân thủ C2PA, và Google, Microsoft, Adobe, Midjourney, và Shutterstock cũng đã hứa hẹn sẽ triển khai công cụ phát hiện C2PA.

- TikTok đã triển khai phát hiện metadata AI cho hình ảnh và video vào thứ Năm, và thông báo rằng phát hiện metadata cho tệp âm thanh sẽ sớm được triển khai.

- Tuy nhiên, điều này không có nghĩa là TikTok có thể phát hiện tất cả nội dung AI, vì vậy các video giả mạo vẫn có thể lan truyền trước khi được phát hiện và gắn nhãn.

- Có nhiều công cụ tạo sinh hình ảnh và video AI không tuân thủ tiêu chuẩn C2PA, và việc loại bỏ metadata từ nội dung AI khá đơn giản, bao gồm chụp màn hình, ghi màn hình hoặc tải lên video và xuất lại qua một ứng dụng khác.

- Ngay cả OpenAI cũng thừa nhận rằng việc xóa metadata AI là dễ dàng. Trang web của họ nêu rõ: "Metadata như C2PA không phải là giải pháp hoàn hảo để giải quyết vấn đề nguồn gốc. Nó có thể dễ dàng bị loại bỏ một cách tình cờ hoặc cố ý."

- Các bước đầu tiên này từ TikTok không giải quyết vấn đề về AI deepfakes, những người sáng tạo có thể có ý đồ xấu và loại bỏ metadata để nội dung của họ không kích hoạt nhãn AI.

📌 TikTok đã bắt đầu gắn nhãn cho nội dung AI từ các nền tảng khác nhưng không chỉ rõ được tất cả. Các tiêu chuẩn C2PA được áp dụng bởi các công ty lớn như OpenAI và Microsoft, nhưng việc loại bỏ metadata đơn giản khiến việc phát hiện deepfake khó khăn, với các video giả mạo vẫn có thể lan truyền.

https://www.pcmag.com/news/tiktok-starts-labeling-ai-generated-content-but-wont-catch-everything

- OpenAI đã tham gia vào ủy ban điều hành của nhóm thương mại Coalition for Content Provenance and Authenticity (C2PA), được thành lập vào tháng 2 năm 2021 bởi Microsoft và Adobe.

- C2PA là một sáng kiến nhằm phát triển công nghệ giúp người dùng xác minh các công cụ được sử dụng để tạo hoặc chỉnh sửa nội dung số như hình ảnh, video.

- OpenAI cam kết tích hợp metadata C2PA vào các video do AI tạo ra, bao gồm cả mô hình tạo video ấn tượng Sora, dù sản phẩm này chưa được công bố rộng rãi cho công chúng.

- Sora đã được sử dụng bởi các đối tác tin cậy của OpenAI để tạo ra video âm nhạc đầu tiên trên thế giới được tạo bởi AI tuần trước.

- OpenAI cũng đã ra mắt Chương trình Truy cập Nghiên cứu Phân loại Phát hiện DALL-E, nhằm phát triển công nghệ nhận diện nội dung do AI tạo ra.

- C2PA cũng cho phép tích hợp kiến trúc vào metadata của hình ảnh, video khi được lưu trữ, giúp người dùng có thể xác minh ngay cả khi xem ngoại tuyến trên các thiết bị khác.

- Anna Makanju, Phó Chủ tịch toàn cầu của OpenAI, nhấn mạnh tầm quan trọng của việc phát triển các tiêu chuẩn chung cho nguồn gốc số, góp phần xây dựng niềm tin vào tính xác thực của nội dung trực tuyến.

📌 OpenAI đã gia nhập ủy ban điều hành của C2PA để phát triển công nghệ nhận diện và xác thực nội dung số, đặc biệt là các sản phẩm do AI tạo ra như video Sora và hình ảnh từ DALL-E 3. Việc tích hợp metadata C2PA giúp người dùng có thể xác minh nguồn gốc của nội dung, kể cả khi xem ngoại tuyến.

Citations:

[1] https://venturebeat.com/ai/openai-to-steer-content-authentication-group-c2pa-pledges-to-label-sora-videos-as-ai/

- OpenAI giới thiệu các phương pháp sáng tạo để xác định nguồn gốc nội dung được tạo bởi các mô hình AI của họ, cụ thể là DALL-E và Voice Engine.

- Công ty đang phát triển bộ phân loại hình ảnh dựa trên AI để xác định xem một hình ảnh có được tạo bởi DALL-E 3 hay không. Bộ phân loại này duy trì độ chính xác cao ngay cả khi hình ảnh bị cắt xén, nén hoặc thay đổi độ bão hòa.

- Tuy nhiên, khả năng phân biệt hình ảnh do DALL-E 3 tạo ra với hình ảnh từ các mô hình AI khác như Midjourney chưa thực sự ấn tượng, chỉ nhận diện được 5-10% hình ảnh.

- Trước đây, OpenAI đã thêm các thủy vân siêu dữ liệu vào hình ảnh, bao gồm thông tin về quyền sở hữu và quá trình tạo nội dung.

- OpenAI là thành viên của Liên minh vì Nguồn gốc và Thẩm quyền Nội dung (C2PA) cùng với các công ty như Microsoft và Adobe. Tháng này, OpenAI đã tham gia ủy ban chỉ đạo của C2PA.

- OpenAI cũng bắt đầu tích hợp thủy vân vào các clip được tạo bởi Voice Engine, nền tảng chuyển văn bản thành giọng nói hiện đang trong giai đoạn xem trước hạn chế.

- Cả bộ phân loại hình ảnh và tín hiệu thủy vân âm thanh vẫn đang được tinh chỉnh. OpenAI đang thu thập phản hồi từ người dùng để đánh giá hiệu quả của chúng.

- Các nhà nghiên cứu và nhóm báo chí phi lợi nhuận có thể đánh giá bộ phân loại hình ảnh bằng cách áp dụng nó vào nền tảng truy cập nghiên cứu của OpenAI.

📌 OpenAI đang phát triển các công cụ mới để phát hiện và xác minh nguồn gốc nội dung do AI tạo ra, bao gồm bộ phân loại hình ảnh với độ chính xác cao và thủy vân âm thanh. Tuy nhiên, khả năng phân biệt hình ảnh từ các mô hình AI khác nhau vẫn cần cải thiện. OpenAI cũng hợp tác với C2PA để thúc đẩy tính minh bạch trong việc tạo nội dung AI.

Citations:

[1] https://www.theverge.com/2024/5/7/24151482/openai-image-detection-ai-watermarking-audio

- Phân biệt văn bản do công cụ như ChatGPT tạo ra với nội dung do con người viết là một thách thức lớn.

- Các công cụ phát hiện AI như GPTZero có thể hỗ trợ phần nào, nhưng không hoàn hảo và có thể cho kết quả dương tính giả.

- Bài báo "Làm thế nào để phát hiện văn bản do AI tạo ra, theo các nhà nghiên cứu" (2/2023) của Reece Rogers đi sâu vào sự phức tạp của việc phát hiện văn bản AI.

- Bài viết "Cuộc đua vũ trang phát hiện AI đã bắt đầu" (9/2023) của Christopher Beam cho thấy cách Edward Tian mở rộng phạm vi và khả năng phát hiện của GPTZero, tập trung vào tác động của AI đối với bài tập ở trường.

- Giáo viên có thể từ bỏ việc giao bài luận do học sinh sử dụng chatbot để hoàn thành bài tập về nhà. Một số học sinh có thể dùng AI tạo sinh như công cụ lên ý tưởng, nhưng số khác lại bịa đặt toàn bộ bài tập.

- Bài báo "Các startup phát hiện AI nói Amazon có thể gắn cờ sách AI. Nhưng không phải vậy" (9/2023) của Kate Knibbs điều tra cuộc tranh luận xung quanh trách nhiệm của các công ty trong việc gắn cờ sách do AI tạo ra có khả năng vi phạm bản quyền trên các nền tảng như Amazon.

📌 Việc phát hiện văn bản do AI tạo ra đang là một thách thức lớn. Các công cụ hỗ trợ vẫn chưa hoàn hảo và có thể cho kết quả sai. Tác động của AI lên giáo dục đang là mối quan tâm hàng đầu, buộc giáo viên phải thay đổi cách ra bài tập. Trách nhiệm của các nền tảng trong việc kiểm soát nội dung AI cũng đang gây tranh cãi.

Citations:

[1] https://www.wired.com/story/ai-detector-chatgpt/

- Deepfake ngày càng tinh vi và khó phát hiện, gây ra nhiều hậu quả tiêu cực như lan truyền thông tin sai lệch.

- Các công ty đã phát triển công cụ phát hiện deepfake, nhưng nghiên cứu cho thấy sự thiên vị trong dữ liệu huấn luyện có thể dẫn đến việc nhắm mục tiêu không công bằng vào một số nhóm nhân khẩu học.

- Nhóm nghiên cứu đã phát triển hai phương pháp phát hiện deepfake nhằm cải thiện tính công bằng và độ chính xác.

- Phương pháp thứ nhất gán nhãn dữ liệu theo giới tính và chủng tộc để giảm thiểu lỗi ở các nhóm thiểu số. Phương pháp thứ hai tập trung vào các đặc trưng không nhìn thấy bằng mắt thường.

- Kết quả cho thấy phương pháp thứ nhất hiệu quả hơn, tăng độ chính xác từ 91.5% lên 94.17%, đồng thời cải thiện tính công bằng.

- Việc phát hiện nhanh chóng và chính xác deepfake là rất quan trọng để ngăn chặn sự lan truyền của chúng và duy trì niềm tin vào AI.

📌 Nghiên cứu mới đã phát triển thành công thuật toán phát hiện deepfake với độ chính xác 94.17%, đồng thời cải thiện đáng kể tính công bằng bằng cách tính đến sự đa dạng nhân khẩu học trong dữ liệu huấn luyện. Điều này góp phần quan trọng trong việc ngăn chặn tác hại của deepfake và thúc đẩy sự phát triển lành mạnh của AI.

Citations:

[1] https://www.rappler.com/technology/features/deepfake-detection-improves-algorithms-demographic-diversity-the-conversation/

- Trong thời đại số, sự lan rộng của hình ảnh giả mạo và bị thao túng, xuất phát từ sự tiến bộ của machine learning, đặt ra thách thức lớn để phân biệt sự thật với sự lừa dối.

- Với sự ra đời của các công cụ tạo ảnh AI như Midjourney, Microsoft Designer và DALL-E 3, việc tạo ra các cảnh trông thuyết phục đã trở thành một việc tầm thường đối với bất kỳ ai.

- Dưới đây là 8 mẹo giúp bạn nhận biết hình ảnh do AI tạo ra:

1. Làn da và bề mặt mịn màng hoặc sáp: AI vẫn gặp khó khăn khi tạo ra kết cấu bề mặt thực tế, đặc biệt là ở các vật liệu hữu cơ như da.

2. Các chi tiết bất thường: Hãy chú ý đến các chi tiết bất thường như ngón tay thừa, tai méo mó hoặc răng không đều.

3. Ánh sáng và bóng không nhất quán: AI có thể tạo ra ánh sáng và bóng không thống nhất trên các bề mặt khác nhau.

4. Nền mờ hoặc méo mó: Hình ảnh do AI tạo ra thường có nền mờ hoặc méo mó do tập trung vào chủ thể chính.

5. Văn bản bị cắt xén hoặc không rõ ràng: AI thường gặp khó khăn trong việc tạo ra văn bản rõ ràng và mạch lạc.

6. Kiểu tóc và lông không tự nhiên: Tóc và lông thường trông cứng nhắc và thiếu chi tiết trong hình ảnh do AI tạo ra.

7. Đồ họa không phù hợp với chủ đề: Các yếu tố đồ họa trong hình ảnh có thể không liên quan đến chủ đề chính.

8. Tìm kiếm hình ảnh ngược: Sử dụng công cụ tìm kiếm ngược của Google để xác định thời điểm hình ảnh được lập chỉ mục lần đầu tiên và phát hiện các biến thể.

📌 Trong thời đại số, việc nhận biết hình ảnh do AI tạo ra đang trở thành một thách thức lớn. Tuy nhiên, bằng cách chú ý đến 8 dấu hiệu như làn da mịn, chi tiết bất thường, ánh sáng và bóng không nhất quán, nền mờ, văn bản không rõ ràng, kiểu tóc và lông không tự nhiên, đồ họa không phù hợp và sử dụng công cụ tìm kiếm ngược, chúng ta có thể phát hiện những hình ảnh giả mạo và ngăn chặn sự lan truyền của thông tin sai lệch.

https://www.androidauthority.com/how-to-spot-ai-generated-images-3434166/

- Các công ty đầu tư vào LLM gặp phải một số thách thức ban đầu như cải thiện quản trị dữ liệu, lựa chọn kiến trúc LLM, giải quyết rủi ro bảo mật và phát triển kế hoạch hạ tầng đám mây.

- Các đội phát triển cần có chiến lược kiểm thử LLM, bao gồm:

+ Tạo dữ liệu kiểm thử để mở rộng đảm bảo chất lượng phần mềm: hiểu rõ người dùng, mục tiêu, quy trình và các tiêu chuẩn chất lượng liên quan.

+ Tự động hóa kiểm thử chất lượng và hiệu suất mô hình: cân bằng giữa tự động hóa và kiểm thử có sự tham gia của con người.

+ Đánh giá chất lượng RAG dựa trên trường hợp sử dụng: RAG giúp cải thiện độ chính xác của LLM nhưng cũng cần được kiểm thử.

+ Phát triển các chỉ số và tiêu chuẩn chất lượng: xác thực chất lượng so với các mục tiêu đã nêu, sử dụng các chỉ số như F1 score, RougeL, sacreBLEU tùy theo trường hợp sử dụng.

- Kiểm thử không kết thúc khi mô hình được triển khai, các nhà khoa học dữ liệu nên tìm kiếm phản hồi từ người dùng cuối, các chỉ số hiệu suất và thông tin phản hồi khác để cải thiện mô hình.

📌 Việc kiểm thử các ứng dụng tích hợp LLM và RAG đòi hỏi nhiều nỗ lực, từ việc tạo dữ liệu kiểm thử, tự động hóa, đánh giá chất lượng cho đến phát triển các chỉ số phù hợp. Tuy nhiên, đây là bước quan trọng để đảm bảo các ứng dụng AI tạo sinh hoạt động chính xác, an toàn và đáng tin cậy, đáp ứng nhu cầu của người dùng trong các lĩnh vực như chăm sóc sức khỏe, dịch vụ tài chính và sản xuất.

Citations:

[1] https://www.infoworld.com/article/3714929/how-to-test-large-language-models.html

- Các công cụ tạo sinh hình ảnh và video như DALL-E, Midjourney và Sora của OpenAI giúp mọi người dễ dàng tạo ra deepfake mà không cần kỹ năng kỹ thuật.

- Hình ảnh giả mạo có thể được sử dụng để lừa đảo, đánh cắp danh tính hoặc tuyên truyền và thao túng bầu cử.

- Để nhận biết deepfake, hãy chú ý đến các dấu hiệu như:

+ Hình ảnh có vẻ ngoài điện tử, da mịn màng bất thường.

+ Sự không nhất quán về bóng và ánh sáng giữa chủ thể và hậu cảnh.

+ Các cạnh khuôn mặt sắc nét hay mờ, màu da có khớp với phần còn lại của đầu và cơ thể không.

+ Chuyển động môi không khớp với âm thanh, răng không rõ ràng.

- Xem xét bối cảnh rộng hơn, liệu nội dung có hợp lý và đáng tin cậy không.

- Sử dụng AI để phát hiện deepfake thông qua các công cụ như Microsoft Authenticator hay Intel FakeCatcher.

- Công nghệ AI đang phát triển nhanh chóng, khiến việc nhận biết deepfake ngày càng khó khăn hơn, kể cả với những người có kinh nghiệm.

📌 Sự phát triển của AI tạo sinh đang khiến việc nhận biết hình ảnh và video giả mạo trở nên khó khăn hơn. Các chuyên gia khuyến cáo không nên đặt gánh nặng lên người dùng thông thường trong việc phát hiện deepfake, vì điều này có thể tạo ra cảm giác an toàn giả tạo khi công nghệ ngày càng tinh vi.

https://economictimes.indiatimes.com/tech/technology/how-to-spot-ai-generated-deepfake-images/articleshow/108667733.cms

- Đại học Sydney phát hiện 330 bài tập được hoàn thành bằng AI trong năm 2023, Đại học New South Wales cũng phát hiện "làn sóng mới" của gian lận.

- Công cụ ChatGPT của OpenAI được sinh viên ưa chuộng, chiếm 60,2% tổng lượt truy cập trang web ngành.

- Hệ thống chấm điểm gặp khó khăn trong việc theo kịp việc sử dụng AI, nhưng sự phát triển gần đây và việc siết chặt chấm điểm của cơ quan giám sát đại học đang gây khó khăn cho những sinh viên muốn để robot viết hộ.

- Giáo sư Phillip Dawson của Đại học Deakin cho biết phần mềm đánh dấu AI Turnitin chỉ tốt trong việc phát hiện đạo văn nếu sinh viên "ngốc nghếch".

- Phát ngôn viên của Đại học Sydney cho biết việc phát hiện gian lận dễ dàng hơn nhiều chỉ với sự kiểm tra kỹ lưỡng hơn từ người chấm bài tập.

- Cơ quan giám sát ngành đại học TEQSA yêu cầu tất cả các nhà cung cấp giáo dục đại học phải tạo kế hoạch hành động để loại bỏ bài tập AI.

- Giảng viên tiếng Anh Huw Griffiths tại Đại học Sydney đã tích hợp ChatGPT vào bài tập khóa học, cho phép sinh viên khám phá giới hạn của AI so với nguồn nghiên cứu truyền thống.

- Đại học Công nghệ Sydney (UTS) khuyến khích nhân viên thảo luận về công cụ AI với sinh viên, mời sinh viên tích cực tham gia và phản ánh một cách có phê phán về cách sử dụng chúng.

📌 Các trường đại học Úc đang đối mặt với làn sóng gian lận mới do sinh viên sử dụng AI để viết bài tập. 330 bài tập tại Đại học Sydney được phát hiện hoàn thành bằng AI trong năm 2023. Các phương pháp đánh dấu đang được cải tiến, kết hợp giữa phần mềm và sự kiểm tra kỹ lưỡng của con người. Một số trường đại học đang tích hợp AI vào bài giảng để sinh viên hiểu rõ giới hạn của công nghệ này.

https://www.dailymail.co.uk/news/article-13204131/UNSW-UTS-university-Sydney-ChatGPT-artificial-intelligence.html

- Kolena, một startup 3 năm tuổi ở San Francisco do cựu quản lý kỹ thuật cấp cao của Amazon đồng sáng lập, hôm nay công bố phát hành rộng rãi nền tảng AI Quality Platform, một ứng dụng web được thiết kế để "cho phép kiểm thử và xác thực nhanh chóng, chính xác các hệ thống AI".

- Nền tảng bao gồm giám sát "chất lượng dữ liệu, kiểm thử mô hình và kiểm thử A/B, cũng như giám sát trôi dữ liệu và suy giảm mô hình theo thời gian". Nó cũng cung cấp tính năng gỡ lỗi.

- Đối với các doanh nghiệp muốn triển khai mô hình AI, một trong những câu hỏi quan trọng nhất không phải là mô hình gì hay sử dụng nó để làm gì, mà là khi nào mô hình được chọn an toàn để triển khai.

- Việc kiểm thử đầy đủ ở backend và chạy các loại kiểm thử phù hợp có thể là sự khác biệt giữa một lần triển khai thành công và thất bại, gây tổn hại đến danh tiếng và tài chính của công ty.

- Một số đại lý ô tô đã gặp phải sự cố đáng xấu hổ (nhưng hài hước) khi sử dụng ChatGPT cho hỗ trợ khách hàng, khi người dùng lừa chúng đồng ý bán xe với giá 1 đô la.

📌 Kolena giới thiệu nền tảng AI Quality Platform giúp kiểm thử và xác thực nhanh chóng, chính xác các mô hình AI và biến thể tinh chỉnh, bao gồm giám sát chất lượng dữ liệu, kiểm thử A/B, trôi dữ liệu và suy giảm mô hình. Việc kiểm thử kỹ lưỡng là then chốt để triển khai AI thành công, tránh các sự cố gây tổn hại danh tiếng và tài chính cho doanh nghiệp.

https://venturebeat.com/ai/kolena-debuts-platform-for-testing-ai-models-and-fine-tuned-variants/

- Công nghệ phát triển ngôn ngữ tự nhiên (NLG) đã cải thiện đáng kể đa dạng, kiểm soát và chất lượng của văn bản do mô hình ngôn ngữ lớn (LLM) tạo ra, với ChatGPT của OpenAI là ví dụ nổi bật.

- Khả năng tạo ra văn bản giống như con người của LLM gây ra lo ngại về việc phát hiện và ngăn chặn việc sử dụng sai trái trong các nhiệm vụ như lừa đảo, thông tin sai lệch và gian lận học thuật.

- Phương pháp phát hiện văn bản do LLM tạo ra có thể chia thành hai loại: phát hiện black-box và white-box. Phát hiện black-box sử dụng quyền truy cập API để phân tích đầu ra của LLM, trong khi phát hiện white-box cho phép kiểm soát hoàn toàn LLM, tăng cường khả năng phát hiện.

- Các phương pháp phát hiện hiện tại dựa trên việc thu thập mẫu văn bản từ nguồn con người và máy, sau đó huấn luyện mô hình phân loại để phân biệt văn bản do LLM và con người tạo ra.

- Các phương pháp white-box bao gồm việc tích hợp thủy vân vào văn bản được tạo ra để theo dõi hoạt động đáng ngờ hoặc không được phép, với hai chiến lược chính là thủy vân sau khi tạo và thủy vân tại thời điểm suy luận.

- Các thách thức hiện tại trong việc phát hiện văn bản do LLM tạo ra bao gồm việc cải thiện độ chính xác của mô hình phân loại, đối phó với các cuộc tấn công thích ứng và giải quyết vấn đề từ các mô hình LLM nguồn mở.

- Các hướng nghiên cứu tương lai có thể tập trung vào việc phát triển các phương pháp phát hiện mới, cải thiện độ chính xác và độ tin cậy của các công cụ hiện có, và khám phá cách thức để đối phó với các mô hình LLM nguồn mở.

📌 Công nghệ NLG và LLM như ChatGPT đã mở ra những tiềm năng mới nhưng cũng đặt ra thách thức trong việc phát hiện và ngăn chặn việc sử dụng sai trái. Phương pháp phát hiện văn bản do LLM tạo ra chia thành hai loại chính là black-box và white-box, mỗi loại có ưu và nhược điểm riêng. Các nghiên cứu tương lai cần tập trung vào việc cải thiện độ chính xác và độ tin cậy của các công cụ phát hiện, đồng thời giải quyết các thách thức từ mô hình LLM nguồn mở.

Citations:

[1] https://cacm.acm.org/research/the-science-of-detecting-llm-generated-text/

- Máy dò AI trở nên phổ biến khi nội dung do AI tạo ra ngập tràn trên internet, đặc biệt là sau sự xuất hiện của ChatGPT.

- ChatGPT nổi tiếng với khả năng tạo ra các bài viết, bài luận, email có cấu trúc tốt, nhưng cũng dẫn đến vấn đề về chất lượng nội dung và thông tin giả mạo.

- Máy dò AI được sử dụng để xác minh tính xác thực, kiểm tra đạo văn và yêu cầu nội dung do con người tạo ra 100%.

- Các máy dò AI hoạt động bằng cách đánh giá văn bản để tìm kiếm các mô hình, như trật tự từ có xác suất cao, tương tự như cách AI tạo nội dung.

- Mặc dù có những tuyên bố về độ chính xác cao, các nghiên cứu đã chỉ ra rằng máy dò AI có thể mắc phải lỗi, cho kết quả khác nhau khi kiểm tra và không hoạt động tốt trên một số loại văn bản.

- Các máy dò AI cũng có thể bị đánh lừa và có độ chính xác không phải lúc nào cũng đáng tin cậy.

📌 Máy dò AI có vai trò quan trọng trong việc phát hiện nội dung do AI tạo ra, đặc biệt trong bối cảnh ChatGPT và các công cụ tương tự ngày càng phổ biến. Tuy nhiên, chúng không phải lúc nào cũng chính xác 100% và có thể cho kết quả khác nhau tùy thuộc vào loại văn bản được kiểm tra. Các nghiên cứu đã chỉ ra rằng máy dò AI có thể có độ chệch, khó sử dụng và dễ bị các phương pháp nhất định đánh lừa. Do đó, người dùng cần cẩn trọng khi sử dụng máy dò AI và không nên phụ thuộc hoàn toàn vào chúng để đánh giá tính xác thực của nội dung.

Citations:

[1] https://www.india.com/technology/are-ai-detectors-accurate-find-out-how-it-really-works-6758636/

- Thế giới đang phải đối mặt với sự lan rộng của deepfake do AI tạo sinh, và những nỗ lực ngăn chặn hiện tại chưa thực sự hiệu quả[1].

- Các quy định liên bang đã cấm các cuộc gọi robocall deepfake vào thứ Năm, giống như những cuộc gọi giả mạo Tổng thống Biden trong cuộc bầu cử sơ bộ New Hampshire[1].

- Trong khi đó, OpenAI và Google đã phát hành thủy vân vào tuần này để đánh dấu hình ảnh do AI tạo sinh. Tuy nhiên, những biện pháp này không đủ mạnh để ngăn chặn deepfake AI[1].

- Vijay Balasubramaniyan, CEO của Pindrop, cho biết: "Công nghệ phát hiện deepfake cần được áp dụng ngay từ nguồn, tại điểm truyền tải và tại điểm đích. Điều này cần phải được thực hiện trên toàn bộ"[1].

- FCC cấm robocall deepfake là một bước đi đúng hướng, theo Balasubramaniyan, nhưng còn thiếu sự làm rõ về cách thực hiện điều này[1].

📌 Deepfake do AI tạo sinh đang gây ra nhiều vấn đề và thách thức cho xã hội. Các biện pháp ngăn chặn hiện tại, bao gồm việc cấm robocall deepfake và việc sử dụng thủy vân để đánh dấu hình ảnh do AI tạo sinh, chưa thực sự hiệu quả. Theo Vijay Balasubramaniyan, CEO của Pindrop, công nghệ phát hiện deepfake cần được áp dụng một cách toàn diện, từ nguồn, tại điểm truyền tải và tại điểm đích. FCC đã cấm robocall deepfake, nhưng còn thiếu sự làm rõ về cách thực hiện điều này[1].

Citations:

[1] https://gizmodo.com/youll-be-fooled-by-an-ai-deepfake-this-year-1851240169

- OpenAI thông báo cập nhật ứng dụng ChatGPT và mô hình tạo ảnh AI DALL-E 3 để bao gồm thẻ metadata mới, cho phép công ty và bất kỳ người dùng hoặc tổ chức nào trên web nhận diện ảnh được tạo bởi công cụ AI.

- Động thái này diễn ra chỉ vài giờ sau khi Meta công bố biện pháp tương tự để đánh dấu ảnh AI được tạo thông qua trình tạo ảnh AI riêng của họ, Imagine, và có sẵn trên Instagram, Facebook và Threads, cũng như được huấn luyện trên hình ảnh do người dùng của một số nền tảng xã hội này cung cấp.

- OpenAI cho biết ảnh được tạo trong ChatGPT và API của họ giờ đây bao gồm metadata sử dụng thông số kỹ thuật C2PA, cho phép bất kỳ ai (bao gồm cả các nền tảng xã hội và nhà phân phối nội dung) nhìn thấy rằng ảnh được tạo bởi sản phẩm của họ.

- Thay đổi này đã có hiệu lực trên web ngay lúc này và sẽ được triển khai.

📌 OpenAI đã nhanh chóng tham gia vào cuộc đua đánh dấu ảnh tạo sinh bằng AI, ngay sau khi Meta công bố biện pháp tương tự. Việc cập nhật này không chỉ giúp người dùng và các tổ chức dễ dàng nhận diện ảnh do AI tạo ra mà còn thể hiện sự chủ động của OpenAI trong việc thúc đẩy sự minh bạch và trách nhiệm trong việc sử dụng công nghệ AI. Sự hợp tác giữa các công ty công nghệ lớn như OpenAI và Meta trong việc áp dụng các tiêu chuẩn như C2PA cho thấy một bước tiến quan trọng trong việc quản lý nội dung tạo sinh, đảm bảo rằng người dùng có thể phân biệt giữa nội dung thực và nội dung do AI tạo ra.

Citations:

[1] https://venturebeat.com/ai/openai-joins-meta-in-labeling-ai-generated-images/

- Kin.art là công cụ mới giúp bảo vệ toàn bộ portfolio của các nghệ sĩ khỏi việc bị AI scraping.

- Nền tảng hosting tranh online này cung cấp phòng thủ tích hợp, nhanh chóng và dễ dàng khi nghệ sĩ tải ảnh lên server.

- Phương pháp phòng thủ của Kin.art sử dụng hai kỹ thuật máy học: "image segmentation" để phân loại và làm rối hình ảnh và "label fuzzing" để làm rối dữ liệu nhãn đính kèm với ảnh.

- Kin.art đảm bảo rằng AI không thể học đúng từ những hình ảnh và thông tin nhãn bị làm rối, từ đó ngăn chặn việc sử dụng không phép dữ liệu nghệ sĩ.

- Công cụ này miễn phí cho nghệ sĩ sử dụng, chỉ cần tạo tài khoản và tải tác phẩm lên Kin.art.

- Kin.art thu phí thấp cho các tác phẩm được bán hoặc kiếm tiền thông qua các tính năng thương mại điện tử trên nền tảng của họ.

- Flor Ronsmans De Vry, đồng sáng lập và là CTO của Kin.art, từng là một phần của đội ngũ sáng lập Curious Addys Trading Club, một nền tảng và bộ sưu tập nghệ thuật NFT.

📌 Kin.art mang lại giải pháp độc đáo trong việc bảo vệ quyền lợi của nghệ sĩ trước sự phát triển mạnh mẽ của AI scraping. Với kỹ thuật bảo mật kép, nền tảng này không chỉ ngăn chặn việc học máy không phép mà còn cung cấp dịch vụ miễn phí cho nghệ sĩ. Hứa hẹn sẽ thu phí thấp trên các giao dịch, Kin.art đã thể hiện cam kết hỗ trợ cộng đồng nghệ sĩ trong kỷ nguyên AI, đồng thời tạo ra một mô hình kinh doanh bền vững.

- Bypass AI là một công cụ viết AI không thể phát hiện, giúp "nhân hóa" văn bản AI và vượt qua các công cụ phát hiện AI.

- Công cụ này chuyển đổi văn bản AI thành văn bản có vẻ như do con người viết, không làm thay đổi ý nghĩa gốc.

- Bypass AI sử dụng thuật toán nhân hóa văn bản tiên tiến và công nghệ mô hình ngôn ngữ hàng đầu.

- Giao diện của Bypass AI đơn giản, rõ ràng, dễ sử dụng cho người mới bắt đầu.

- Công cụ có khả năng đánh bại các AI detector như ZeroGPT, GPTZero, Turnitin, Content at Scale, và OpenAI's Text Classifier, làm cho văn bản trở nên khó phát hiện hơn.

📌 Bypass AI đại diện cho một bước tiến trong cuộc chiến giữa công cụ viết AI và phần mềm phát hiện AI, với khả năng chuyển đổi văn bản để tránh bị phát hiện, mở ra khả năng sử dụng rộng rãi cho sinh viên, blogger và doanh nghiệp mà không lo ngại về các hậu quả từ việc phân biệt văn bản AI.

- Bài viết trên Geeky Gadgets đánh giá về "Undetectable AI," một công cụ chống phát hiện AI mạnh mẽ và dễ sử dụng.

- "Undetectable AI" được thiết kế để giúp người dùng che giấu dấu vết của AI trong văn bản hoặc nội dung do AI tạo ra.

- Công cụ này sử dụng các thuật toán phức tạp để thay đổi cấu trúc và ngôn ngữ của nội dung AI sao cho khó phát hiện hơn bằng phần mềm hoặc công cụ phát hiện AI truyền thống.

- Bài viết nhấn mạnh tính năng dễ sử dụng của "Undetectable AI," với giao diện trực quan và quy trình hoạt động đơn giản.

- Đánh giá cũng chỉ ra rằng công cụ có khả năng làm tăng tính xác thực của nội dung AI, giúp người dùng dễ dàng hòa nhập nội dung AI vào các tác phẩm hoặc dự án của mình mà không bị nghi ngờ.

- Tuy nhiên, bài viết cũng cảnh báo về những hậu quả đạo đức và pháp lý có thể xảy ra khi sử dụng công cụ này để tạo ra nội dung gây hiểu lầm hoặc lừa dối.

- Bài viết kết luận rằng "Undetectable AI" là một công cụ mạnh mẽ nhưng cũng cần được sử dụng một cách cân nhắc và có trách nhiệm.

Kết luận: Bài viết trên Geeky Gadgets đánh giá "Undetectable AI" như một công cụ tiên tiến giúp che giấu dấu vết của AI trong nội dung, mang lại tính xác thực cao hơn cho nội dung do AI tạo ra. Tuy nhiên, bài viết cũng nhấn mạnh sự cần thiết của việc sử dụng công cụ này một cách có trách nhiệm, đề phòng những rủi ro đạo đức và pháp lý.

Follow Us

Tin phổ biến