AI coding assistant

View All

-

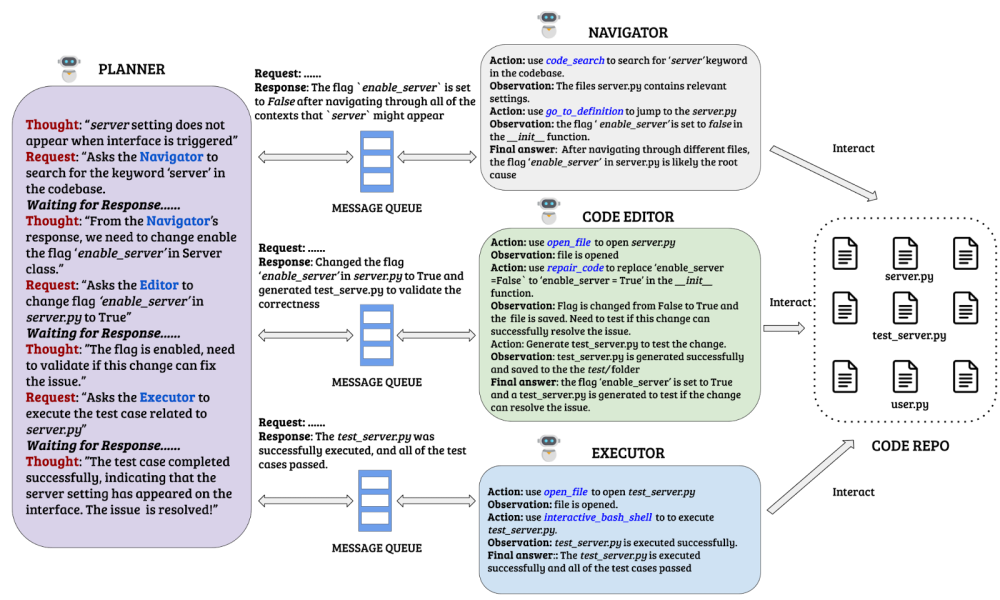

OpenAI vừa công bố nghiên cứu về khả năng của mô hình ngôn ngữ lớn (LLM) trong lĩnh vực kỹ thuật phần mềm thông qua bộ benchmark SWE-Lancer

-

3 mô hình được thử nghiệm bao gồm GPT-4o, o1 của OpenAI và Claude-3.5 Sonnet của Anthropic

-

Nghiên cứu sử dụng 1.488 nhiệm vụ kỹ sư phần mềm từ nền tảng Upwork với tổng giá trị 1 triệu USD

-

Các nhiệm vụ được chia thành 2 loại:

-

Nhiệm vụ cá nhân (sửa lỗi, triển khai tính năng): 764 nhiệm vụ, trị giá 414.775 USD

-

Nhiệm vụ quản lý (lựa chọn đề xuất tốt nhất): tổng giá trị 585.225 USD

-

Quy trình thử nghiệm:

-

Sử dụng Docker container không có kết nối internet

-

Tạo prompt dựa trên tiêu đề và mô tả nhiệm vụ

-

Phát triển test end-to-end bằng Playwright

-

Kiểm tra 3 lần bởi kỹ sư chuyên nghiệp

-

Kết quả chính:

-

Claude 3.5 Sonnet đạt hiệu suất tốt nhất, kiếm được 208.050 USD

-

Giải quyết được 26,2% vấn đề cá nhân

-

Đa số giải pháp vẫn chưa chính xác

-

Các mô hình thể hiện tốt hơn trong nhiệm vụ quản lý

-

Hạn chế của LLM:

-

Có thể xác định vị trí lỗi nhưng không tìm ra nguyên nhân gốc rễ

-

Hiểu biết hạn chế về mối liên hệ giữa các thành phần

-

Giải pháp thường không đầy đủ hoặc chưa toàn diện

📌 Nghiên cứu cho thấy LLM vẫn chưa đủ khả năng thay thế kỹ sư phần mềm. Claude 3.5 Sonnet, mô hình hiệu quả nhất, chỉ giải quyết được 26,2% vấn đề và kiếm được 208.050 USD từ tổng số 1 triệu USD giá trị công việc. LLM có thể hỗ trợ sửa lỗi nhưng khó xác định nguyên nhân cốt lõi của vấn đề.

https://venturebeat.com/ai/ai-can-fix-bugs-but-cant-find-them-openais-study-highlights-limits-of-llms-in-software-engineering/

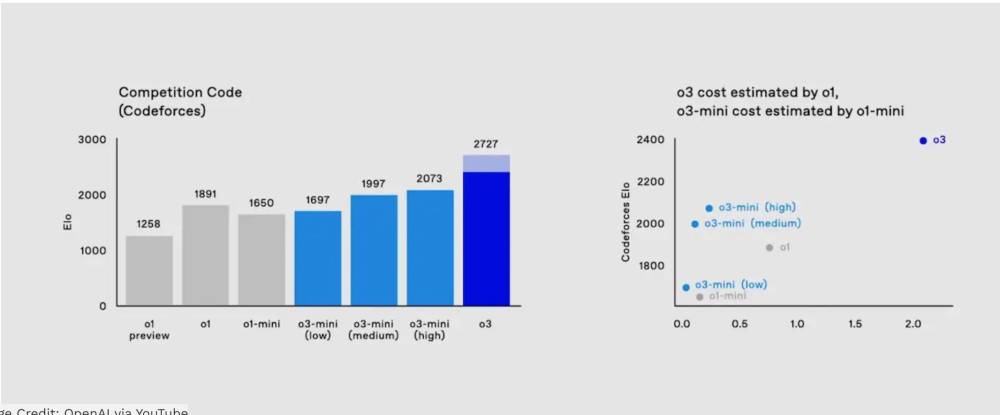

- OpenAI đã ra mắt mô hình AI mới mang tên o3, được đánh giá là một bước tiến lớn trong khả năng tư duy, vượt qua thách thức ARC với điểm số 91,5%, cao hơn bất kỳ mô hình nào trước đó.

- Điểm khác biệt của o3 là phương pháp "test-time compute," yêu cầu tăng thời gian xử lý dữ liệu để cải thiện chất lượng kết quả, dẫn đến chi phí mỗi lần truy vấn tăng cao. Một câu hỏi phức tạp có thể tiêu tốn đến 3.000 USD.

- Chi phí vận hành o3 đã phá vỡ nguyên tắc chi phí thấp của ngành phần mềm, khi các dịch vụ truyền thống như công cụ tìm kiếm chỉ tiêu tốn phần nhỏ tài nguyên.

- Mô hình o3 được xem là bước chuyển lớn trong kinh tế học AI, khi quy mô xử lý không chỉ tập trung vào giai đoạn huấn luyện mà còn trong giai đoạn truy vấn. Điều này làm tăng áp lực từ các nhà cung cấp chip như Nvidia và các nhà cung cấp dịch vụ đám mây như Amazon, Microsoft, Google.

- OpenAI dự kiến cung cấp o3 với mức phí cao, lên đến 2.000 USD/tháng, nhằm bù đắp chi phí vận hành khổng lồ. Đây là sự thay đổi đáng kể so với các mô hình trước đây thường miễn phí hoặc có chi phí thấp hơn.

- Các đối thủ cạnh tranh cũng không đứng yên. Google đã ra mắt mô hình Gemini 2.0 Flash, trong khi các mô hình nguồn mở đang được kỳ vọng sẽ gia tăng sức ép cạnh tranh. Các công ty như Anthropic và xAI cũng được định giá cao, lần lượt là 60 tỷ USD và 45 tỷ USD.

- Việc sử dụng o3 không chỉ tập trung vào người tiêu dùng cá nhân mà còn hướng đến doanh nghiệp với các dịch vụ tùy chỉnh theo nhu cầu, hứa hẹn tăng năng suất làm việc nhưng đòi hỏi chi phí đầu tư lớn.

- Khác với các mô hình AI trước đây, o3 và các mô hình tương tự có thể dẫn đến thị trường cạnh tranh đa cực thay vì độc quyền.

📌 Mô hình AI o3 của OpenAI đánh dấu bước đột phá về khả năng tư duy nhưng đi kèm chi phí vận hành cao. Thị trường AI chuyển từ miễn phí sang trả phí cao, đồng thời đối mặt áp lực từ cạnh tranh và chi phí nguồn lực. Đây là thay đổi lớn trong kinh tế học phần mềm hiện đại.

http://www.economist.com/business/2025/01/20/openais-latest-model-will-change-the-economics-of-software

OpenAI ra mắt mô hình mới sẽ thay đổi kinh tế học của phần mềm

Càng suy luận nhiều, càng tốn sức mạnh máy tính hơn

20 tháng 1 năm 2025 | SAN FRANCISCO

Chia sẻ

Khi OpenAI công bố một mô hình trí tuệ nhân tạo (AI) tạo sinh mới, gọi là o3, vài ngày trước Giáng sinh, thông báo này đã tạo ra cả sự phấn khích lẫn hoài nghi. Phấn khích từ những người kỳ vọng khả năng suy luận của mô hình này sẽ là một bước tiến lớn hướng tới trí thông minh siêu việt hơn con người (một số người cho rằng điều này còn quan trọng hơn sự ra mắt ChatGPT của OpenAI vào năm 2022). Hoài nghi vì OpenAI không công khai mô hình này cho công chúng và có mọi động cơ để phóng đại vai trò tiên phong của công ty trong lĩnh vực AI nhằm lấy lòng Donald Trump, tổng thống sắp nhậm chức.

Tuy nhiên, kể từ đó, một điểm đồng thuận đã xuất hiện. Mô hình này, cũng như tiền thân của nó là o1 (o2 bị bỏ qua vì đó là tên của một mạng di động ở châu Âu), tạo ra kết quả tốt hơn khi thực hiện nhiều “suy nghĩ” hơn để phản hồi một yêu cầu. Nhiều suy nghĩ hơn đồng nghĩa với việc sử dụng nhiều sức mạnh tính toán hơn—và chi phí cao hơn cho mỗi yêu cầu. Kết quả là một thay đổi lớn đang diễn ra trong kinh tế học của nền kinh tế số, vốn được xây dựng dựa trên việc cung cấp các dịch vụ giá rẻ cho một số lượng lớn người dùng với chi phí cận biên thấp, nhờ vào việc phân phối miễn phí qua internet. Mỗi lần các mô hình trở nên đắt đỏ hơn để thực hiện yêu cầu, kỷ nguyên chi phí cận biên bằng không ngày càng xa hơn.

Nhà đầu tư định giá OpenAI như một công ty công nghệ được yêu thích: công ty được định giá 157 tỷ USD dựa trên một vòng huy động vốn gần đây. Các nhà đầu tư hy vọng rằng, nhờ sự thành công của các sản phẩm như ChatGPT, công ty này sẽ trở thành gã khổng lồ công nghệ trị giá 1 nghìn tỷ USD tiếp theo. Nhưng chi phí cao của các mô hình tiên tiến, cùng với áp lực từ các nhà cung cấp, nhà phân phối và đối thủ cạnh tranh, cho thấy việc tạo ra mô hình có thể không mang lại quyền lực kiểu độc quyền như các gã khổng lồ công nghệ đã từng có. “Một điều rất quan trọng để hiểu về tương lai: kinh tế học của AI sắp thay đổi hoàn toàn,” François Chollet, một nhà nghiên cứu AI kỳ cựu, viết trên X, một mạng xã hội, vào ngày o3 được công bố.

Biểu đồ: The Economist

François Chollet đã giúp tạo ra sự phấn khích về o3. Vào tháng 6, ông đã khởi động một giải thưởng trị giá 1 triệu USD cho các mô hình có thể vượt qua thử thách mà ông đã tạo ra 5 năm trước, gọi là “Abstraction and Reasoning Corpus” hay ARC. Đây là một tập hợp các câu đố suy luận trực quan trông đơn giản (xem hình minh họa) được thiết kế để “dễ đối với con người nhưng bất khả thi đối với AI hiện đại”. (Sự dễ dàng ở đây là tương đối—trong một nghiên cứu vào tháng 9, con người được tuyển chọn trực tuyến đạt điểm từ 60-70% trong bài kiểm tra này). Giải thưởng này không chỉ mang tính thách thức đơn thuần. François Chollet nói rằng vượt qua bài kiểm tra ARC là một bước “cực kỳ quan trọng” hướng tới việc xây dựng trí tuệ nhân tạo tổng quát, nghĩa là các cỗ máy vượt qua con người ở nhiều nhiệm vụ.

Sáu tháng sau, OpenAI đã xuất sắc vượt qua bài kiểm tra này. Mô hình o3 của công ty đạt điểm đột phá 91,5%. Thành công của nó trong thử thách cho thấy một bước thay đổi trong khả năng của AI thích nghi với các nhiệm vụ mới, François Chollet nhận xét. Mô hình mới không chỉ tốt hơn; nó còn khác biệt. Giống như o1, o3 sử dụng phương pháp “test-time compute” (tính toán thời gian kiểm tra), tạo ra kết quả tốt hơn khi dành nhiều thời gian hơn cho suy luận (khi một mô hình AI đã được đào tạo trả lời các yêu cầu). Thay vì chỉ đơn giản đưa ra câu trả lời càng nhanh càng tốt, o3 được thiết kế để—thực chất—suy nghĩ kỹ hơn về câu hỏi.

Đó là lúc chi phí cao hơn xuất hiện. François Chollet đặt giới hạn 10.000 USD cho số tiền mà các thí sinh có thể chi tiêu vào sức mạnh tính toán để trả lời 400 câu hỏi trong thử thách của ông. Khi OpenAI giới thiệu một mô hình dưới giới hạn này, công ty đã chi 6.677 USD (khoảng 17 USD mỗi câu hỏi) để đạt điểm 82,8%. Điểm 91,5% của o3 đạt được nhờ việc vượt qua ngân sách. Công ty không tiết lộ số tiền đã chi, nhưng cho biết rằng phiên bản đắt tiền của quá trình này sử dụng lượng “compute” gấp 172 lần so với phương pháp rẻ hơn—tương đương khoảng 3.000 USD để giải một yêu cầu mà con người chỉ mất vài giây.

Cần lưu ý rằng các mô hình AI trước đây đã thách thức chuẩn mực chi phí cận biên thấp của ngành công nghiệp phần mềm, bởi vì việc trả lời các yêu cầu đòi hỏi nhiều sức mạnh xử lý hơn đáng kể so với việc sử dụng các công cụ tương đương như công cụ tìm kiếm. Nhưng chi phí xây dựng các mô hình ngôn ngữ lớn và vận hành chúng đủ nhỏ về mặt tuyệt đối để OpenAI vẫn có thể cung cấp truy cập miễn phí.

Với các mô hình mới nhất, điều đó không còn đúng nữa. OpenAI giới hạn phiên bản “pro” của mô hình o1 chỉ dành cho những người dùng ở gói đăng ký 200 USD mỗi tháng (và bị lỗ, theo Sam Altman, giám đốc điều hành của công ty, bởi vì khách hàng tiêu tốn nhiều hơn dự kiến của công ty trên mỗi yêu cầu). Pierre Ferragu của New Street Research, một công ty phân tích, ước tính rằng OpenAI có thể tính phí tới 2.000 USD mỗi tháng để truy cập đầy đủ vào o3.

Sức mạnh của các mô hình như vậy dựa trên việc đưa một phiên bản của “luật mở rộng quy mô” trong ngành này đến gần hơn với người dùng cuối. Cho đến nay, tiến bộ trong AI phụ thuộc vào việc huấn luyện lớn hơn và tốt hơn, với nhiều dữ liệu hơn và sức mạnh tính toán lớn hơn tạo ra trí thông minh vượt trội hơn. Nhưng một khi mô hình được huấn luyện, rất khó để sử dụng tốt sức mạnh xử lý bổ sung. Như thành công của o3 trong thử thách ARC cho thấy, điều đó không còn đúng nữa. Luật mở rộng quy mô dường như đã chuyển từ việc huấn luyện mô hình sang suy luận.

Những phát triển như vậy thay đổi kinh tế học mà các nhà sản xuất mô hình như OpenAI phải đối mặt. Sự phụ thuộc của các mô hình mới vào sức mạnh xử lý lớn hơn làm tăng quyền lực của các nhà cung cấp như Nvidia, nhà sản xuất chip AI chuyên dụng. Điều này cũng mang lại lợi ích cho các nhà phân phối mô hình AI, đặc biệt là các nhà cung cấp dịch vụ đám mây như Amazon, Microsoft và Alphabet (công ty mẹ của Google). Và điều này có thể giúp biện minh cho khối tài sản mà các gã khổng lồ công nghệ đã đầu tư vào các trung tâm dữ liệu, bởi vì suy luận nhiều hơn sẽ cần sức mạnh tính toán nhiều hơn. OpenAI sẽ bị chèn ép từ cả hai phía.

Còn có yếu tố cạnh tranh. Google đã phát hành mô hình suy luận riêng của mình, gọi là Gemini 2.0 Flash, và các công ty công nghệ khác có lẽ cũng sẽ làm vậy. Các mô hình mã nguồn mở được kỳ vọng sẽ xuất hiện. Khách hàng sẽ có thể sử dụng nhiều mô hình từ các nhà cung cấp khác nhau. Và mặc dù các mô hình AI tạo sinh có thể cải thiện một chút thông qua tương tác với khách hàng, chúng thiếu các hiệu ứng mạng thực sự (trong đó dịch vụ sẽ cải thiện đáng kể khi có nhiều người dùng hơn), không giống như các sản phẩm Google và Facebook đã làm trong kỷ nguyên trước.

Chi phí cận biên cao có nghĩa là các nhà sản xuất mô hình sẽ phải tạo ra giá trị đáng kể để tính giá cao. Hy vọng, theo Lan Guan của Accenture, một công ty tư vấn, là các mô hình như o3 sẽ hỗ trợ các tác nhân AI mà cá nhân và doanh nghiệp có thể sử dụng để tăng năng suất. Ngay cả một mức giá cao cho việc sử dụng một mô hình suy luận cũng có thể xứng đáng so với chi phí thuê một tiến sĩ toán học thực thụ, chẳng hạn. Nhưng điều đó phụ thuộc vào mức độ hữu ích của các mô hình.

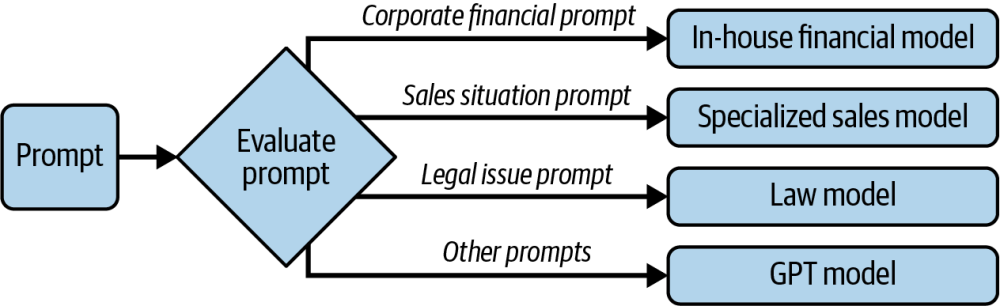

Các trường hợp sử dụng khác nhau cũng có thể dẫn đến sự phân mảnh hơn. Jeremy Schneider của McKinsey, một công ty tư vấn, cho rằng việc cung cấp các dịch vụ AI cho khách hàng doanh nghiệp sẽ đòi hỏi các mô hình được chuyên biệt hóa cho nhu cầu của từng doanh nghiệp, thay vì các mô hình đa dụng như ChatGPT.

Thay vì bị thống trị bởi một công ty, một số người kỳ vọng việc tạo mô hình sẽ giống như một thị trường độc quyền tập đoàn truyền thống hơn, với rào cản gia nhập cao nhưng không có sự thống trị tuyệt đối—hoặc lợi nhuận độc quyền. Hiện tại, OpenAI đang dẫn đầu, nhưng một trong những đối thủ chính của công ty, Anthropic, được cho là đang huy động vốn ở mức định giá 60 tỷ USD, và xAI, công ty thuộc sở hữu phần lớn của Elon Musk, được định giá 45 tỷ USD. Điều này cho thấy kỳ vọng cao dành cho các công ty này. Với o3, OpenAI đã chứng minh lợi thế kỹ thuật của mình, nhưng mô hình kinh doanh vẫn chưa được kiểm chứng. ■

OpenAI’s latest model will change the economics of software

The more reasoning it does, the more computer power it uses

-

Làn sóng AI lập trình thứ hai đã xuất hiện, với các công ty như Poolside, Cosine, và Merly cạnh tranh phát triển các công cụ tạo sinh mã code. Những công cụ này không chỉ hỗ trợ lập trình viên mà còn tự động hóa các tác vụ phức tạp như thử nghiệm, sửa lỗi, và thậm chí tối ưu hóa mã.

-

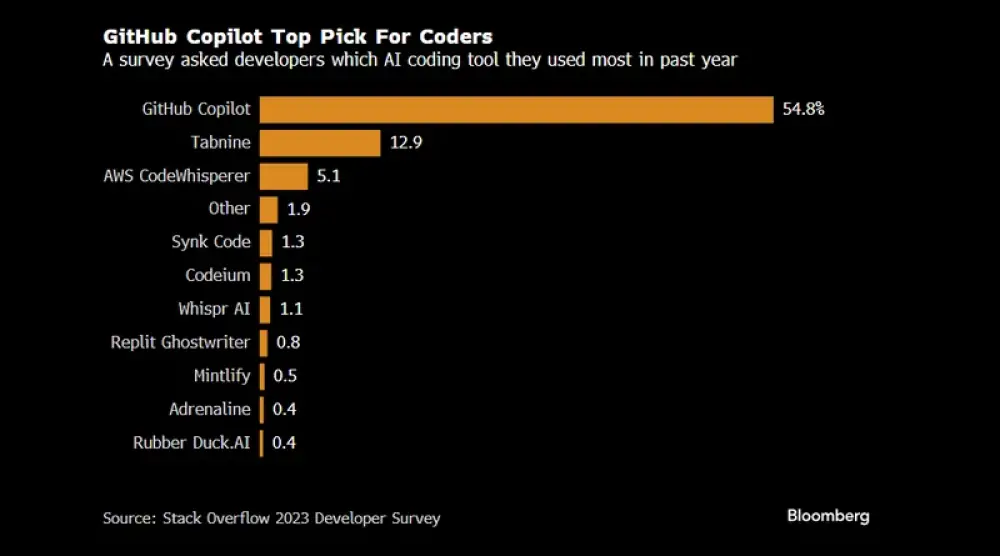

Hiện tại, khoảng 25% mã mới tại Google được tạo bởi AI và các nền tảng như GitHub Copilot của Microsoft đã thu hút hàng triệu lập trình viên.

-

Những bước tiến mới của AI lập trình:

- Các công cụ thế hệ đầu tiên như Copilot chủ yếu dựa vào hoàn thiện tự động (autocomplete).

- Thế hệ tiếp theo, như Genie (Cosine) và công cụ đang phát triển của Poolside, tập trung vào việc mô phỏng quy trình tư duy của lập trình viên, bao gồm:

- RLCE (Reinforcement Learning from Code Execution): Đào tạo AI thông qua việc thử nghiệm và tối ưu hóa mã.

- Dữ liệu Breadcrumbs: Thu thập thông tin về quá trình lập trình thực tế, như lý do mở tệp, cách truy cập tài liệu, và logic cơ bản.

-

Những công nghệ độc đáo:

- Merly: Thay vì dựa vào mã nguồn truyền thống, Merly tập trung vào logic cơ bản bằng cách sử dụng các biểu diễn trung gian của mã, giúp tối ưu hóa và tăng tốc quá trình tạo mã.

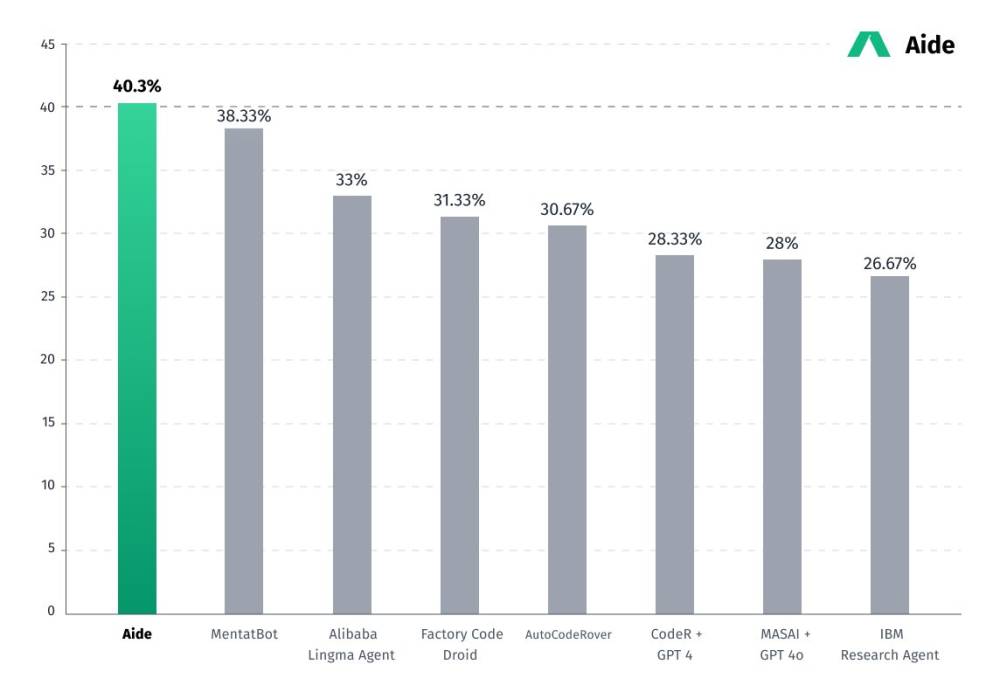

- Cosine: Phát triển Genie, công cụ được đánh giá cao nhất trên bảng xếp hạng SWE-Bench, có thể tự động sửa lỗi và tối ưu mã.

- Poolside: Xây dựng mô hình ngôn ngữ từ đầu, ưu tiên các tác vụ lập trình thay vì tổng hợp dữ liệu từ Internet.

-

Tác động đến ngành lập trình:

- Những công cụ này đang thay đổi cách lập trình viên làm việc, giúp họ tập trung vào thiết kế và tư duy logic thay vì viết mã thủ công.

- Các công cụ như Genie có thể chạy nhiều phiên bản hệ thống, thử nghiệm đồng thời các giải pháp khác nhau, hoặc sửa lỗi 24/7 dựa trên báo cáo lỗi.

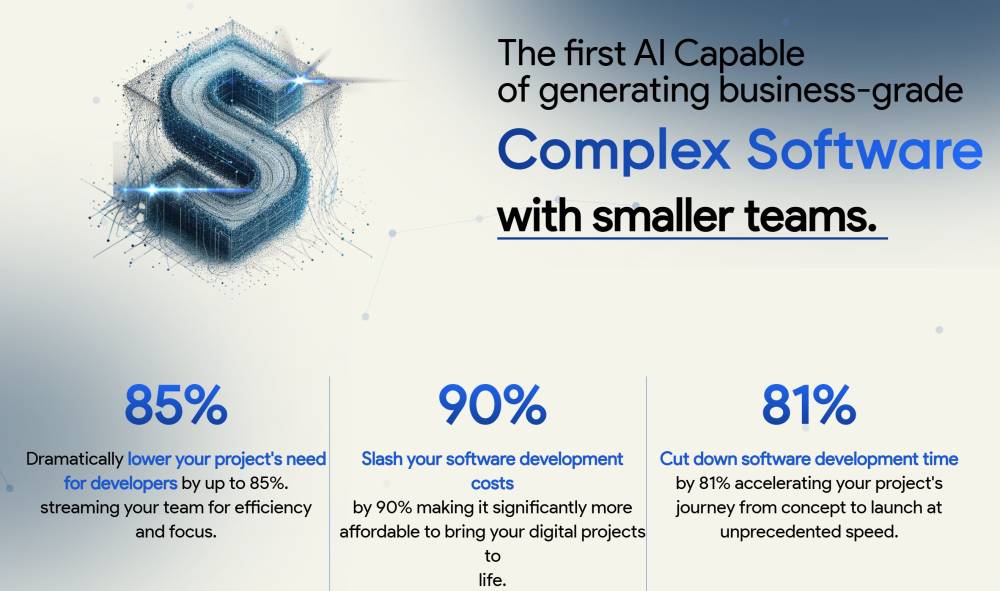

- Một số công ty đã giảm đáng kể số lượng nhân viên lập trình, thay thế bằng các nhóm nhỏ sử dụng AI, tạo ra sự chuyển đổi từ "kỹ sư phần mềm" thành "quản lý hệ thống AI."

-

Tương lai của AI lập trình:

- Các công ty như Cosine và Poolside coi lập trình là bước đầu tiên hướng tới việc xây dựng AGI, với tham vọng phát triển các mô hình giải quyết mọi vấn đề tính toán thông qua phần mềm tự động.

📌 Làn sóng AI lập trình thứ hai không chỉ tối ưu hóa ngành công nghệ mà còn mở ra con đường tới AGI. Với các công cụ tự động hóa ngày càng thông minh, lập trình viên có thể tập trung vào sáng tạo trong khi AI xử lý các nhiệm vụ phức tạp.

https://www.technologyreview.com/2025/01/20/1110180/the-second-wave-of-ai-coding-is-here/

#MIT

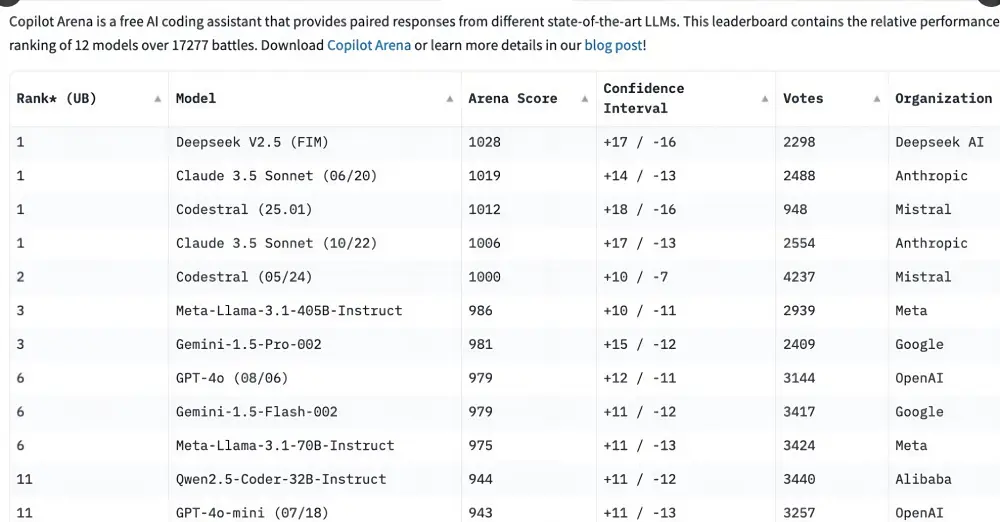

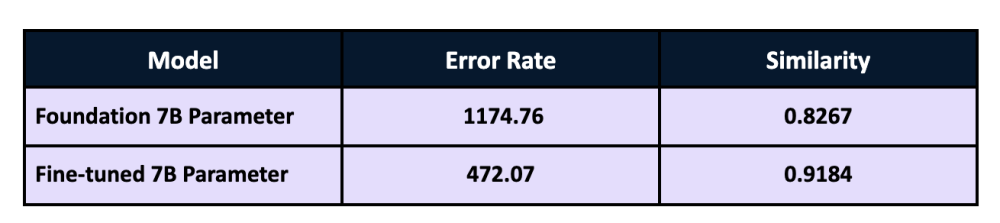

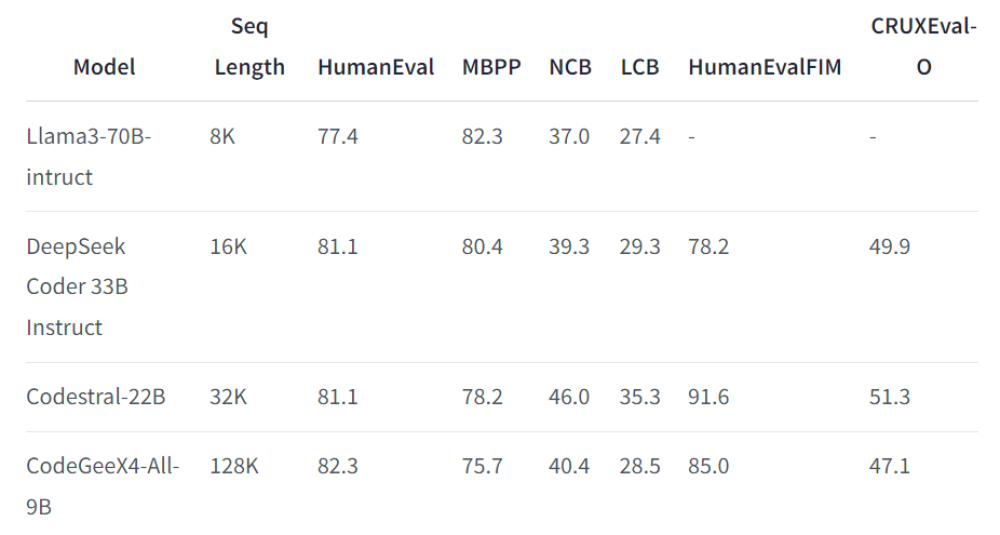

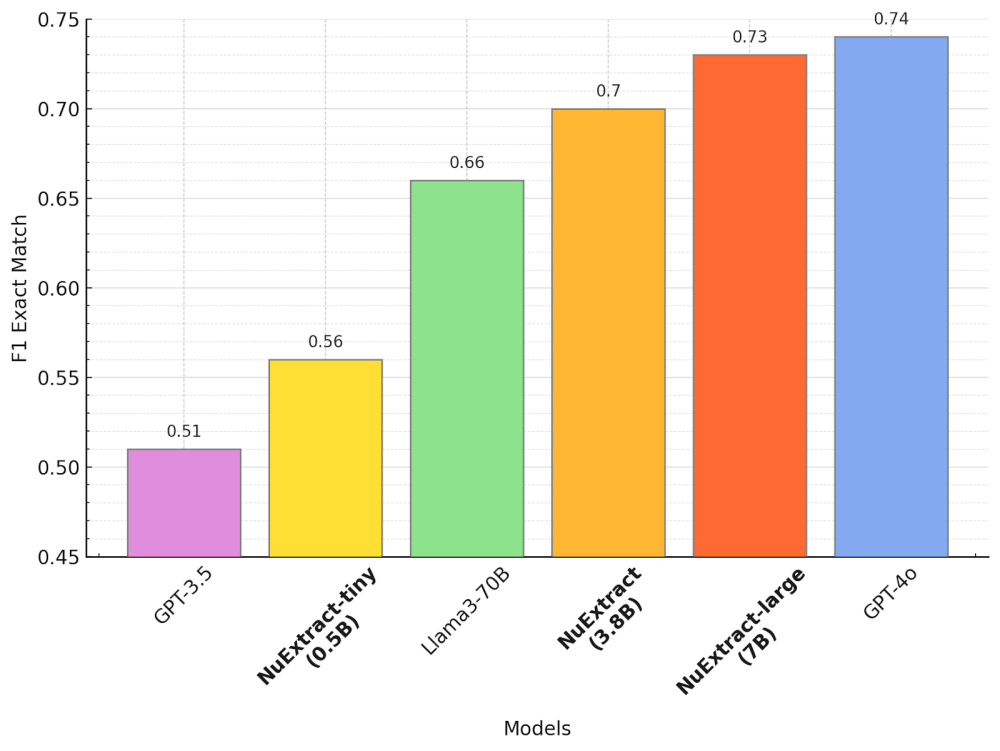

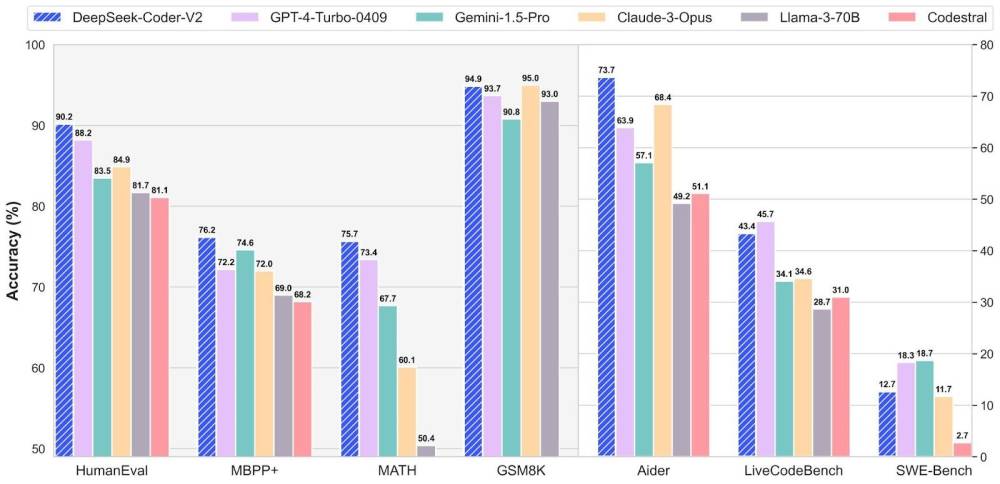

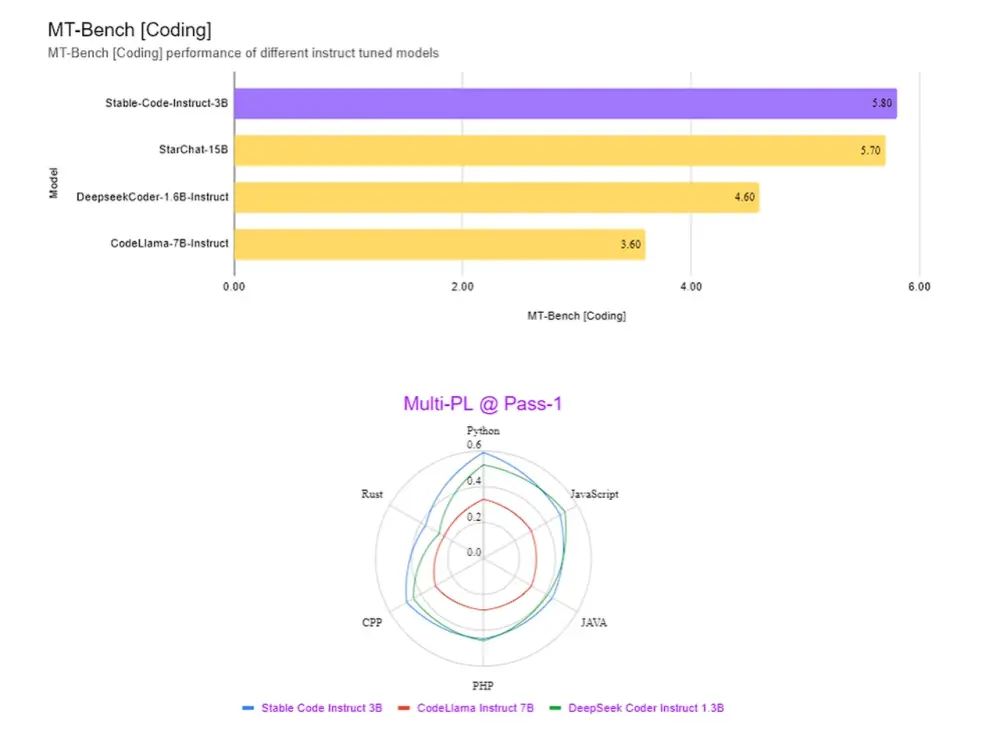

- Mistral đã phát hành phiên bản mới của mô hình hoàn thiện mã Codestral, nâng cao cạnh tranh trong lĩnh vực mã hóa.

- Phiên bản Codestral 25.01 được thiết kế với kiến trúc hiệu quả hơn, hứa hẹn sẽ là "người dẫn đầu rõ rệt cho lập trình trong phân khúc trọng lượng của nó".

- Mô hình mới nhanh gấp đôi so với phiên bản trước đó, giúp cải thiện tốc độ xử lý.

- Codestral 25.01 tối ưu hóa cho các tác vụ thấp độ trễ và tần suất cao, hỗ trợ sửa mã, tạo kiểm thử và các tác vụ điền giữa.

- Kết quả kiểm tra cho thấy mô hình mới này vượt trội hơn trong việc mã hóa Python với điểm số 86.6% trong bài kiểm tra HumanEval.

- Codestral 25.01 đã đánh bại các mô hình trước đó như Codellama 70B Instruct và DeepSeek Coder 33B instruct.

- Người dùng có thể triển khai Codestral 25.01 qua các đối tác plugin IDE của Mistral và truy cập API của mô hình qua la Plateforme của Mistral và Google Vertex AI.

- Mô hình sẽ có mặt trên Azure AI Foundry và sắp ra mắt trên Amazon Bedrock.

- Mistral đã phát hành Codestral lần đầu vào tháng 5 năm ngoái, với khả năng mã hóa trong 80 ngôn ngữ khác nhau.

- Sau đó, Mistral đã giới thiệu Codestral-Mamba, một mô hình tạo mã có thể xử lý chuỗi mã dài hơn.

- Ngay sau thông báo về Codestral 25.01, mô hình này đã nhanh chóng nổi bật trên Copilot Arena.

- Các mô hình mã hóa đã cải thiện đáng kể và thường xuyên vượt trội so với các mô hình tổng quát khác như GPT-4 Turbo.

- Nhiều nhà phát triển vẫn chưa thống nhất được việc chọn mô hình tổng quát hay mô hình chuyên sâu trong việc lập trình.

📌 Mistral đã thành công trong việc nâng cấp mô hình Codestral với phiên bản 25.01, đạt hiệu suất 86.6% trong HumanEval. Mô hình này hỗ trợ lập trình viên với tốc độ nhanh gấp đôi phiên bản trước, đáp ứng nhu cầu ngày càng cao trong lĩnh vực tạo mã.

https://venturebeat.com/ai/mistrals-new-codestral-code-completion-model-races-up-third-party-charts/

- CEO của Meta, Mark Zuckerberg, dự đoán vào năm 2025, AI sẽ có khả năng như các kỹ sư phần mềm bậc trung, tạo ứng dụng và viết mã một cách tự động, đưa nghề lập trình vào thử thách lớn.

- Phát biểu này được đưa ra trong cuộc trò chuyện với Joe Rogan, nơi Zuckerberg nhấn mạnh rằng: tuy chi phí ban đầu để vận hành hệ thống AI có thể cao, nhưng chúng sẽ trở nên hiệu quả hơn qua thời gian.

- Một số lãnh đạo công nghệ khác cũng đồng tình với nhận định này:

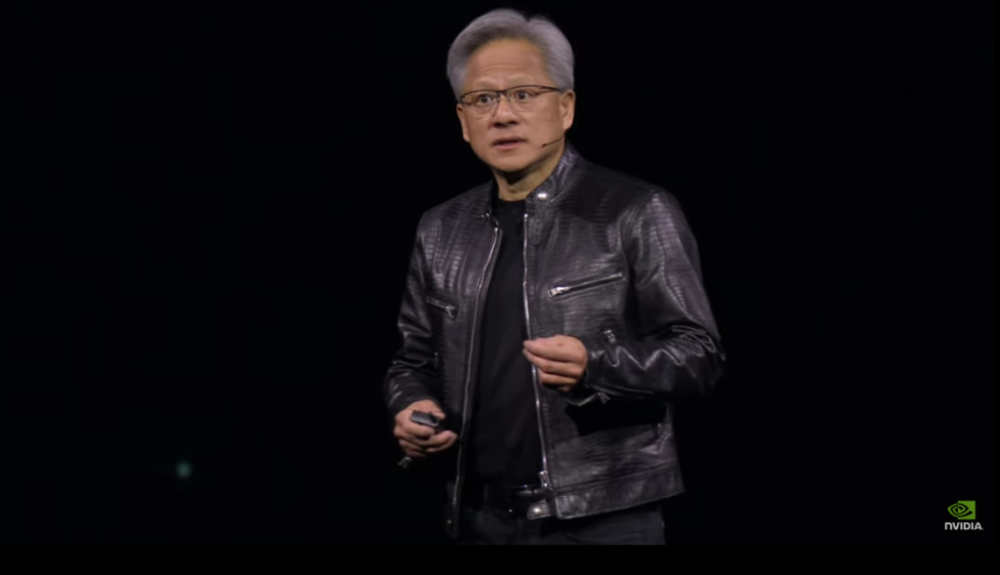

- Jensen Huang, CEO NVIDIA, nhận định nghề lập trình có thể “chết” và đề xuất các lĩnh vực khác như sinh học, giáo dục, nông nghiệp hoặc sản xuất làm hướng đi mới.

- Matt Garman, CEO AWS cho rằng chỉ trong khoảng 24 tháng, phần lớn lập trình viên có thể không còn viết mã nữa, nhờ vào sự phổ biến của AI.

- Marc Benioff, CEO Salesforce, khẳng định năng suất tăng mạnh nhờ AI hỗ trợ các kỹ sư hiện tại, khiến công ty cân nhắc không tuyển dụng thêm trong năm 2025.

- AI không chỉ tập trung vào lập trình mà còn lấn sân sang các lĩnh vực khác:

- 54% công việc ngân hàng có khả năng bị tự động hóa bởi AI.

- Các công cụ như ChatGPT, Copilot đã hỗ trợ kiến trúc sư thiết kế cấu trúc phức tạp trong vài giây, làm lung lay vị trí của các chuyên gia truyền thống.

- OpenAI cũng giới thiệu mô hình AI o1 với khả năng vượt trội trong lập trình, đạt 90-100% ở các bài kiểm tra tuyển dụng của chính họ.

- Satya Nadella, CEO Microsoft, hình dung một tương lai nơi các tổ chức tạo ra AI tùy chỉnh để đơn giản hóa công việc, thay vì cạnh tranh trực tiếp với người lao động.

---

📌 AI ngày càng thay thế vai trò lập trình viên, đưa nghề này vào giai đoạn biến động lớn. Dự báo đến năm 2025, Meta và các công ty hàng đầu sẽ sử dụng AI như "kỹ sư trung cấp", trong khi thị trường lao động toàn cầu phải đối mặt với nguy cơ tự động hóa cao ở cả các lĩnh vực khác như ngân hàng và thiết kế.

https://www.windowscentral.com/software-apps/mark-zuckerberg-ai-engineers-might-claim-coding-jobs

- Alibaba Cloud vừa công bố hệ thống AI lập trình thuộc bộ công cụ Tongyi Lingma

- Hệ thống có khả năng tự động hóa toàn bộ quy trình phát triển ứng dụng bao gồm:

- Hiểu yêu cầu từ người dùng

- Viết code

- Gỡ lỗi phần mềm

- Thời gian hoàn thành một ứng dụng chỉ trong vài phút

- Công nghệ nền tảng:

- Sử dụng họ mô hình ngôn ngữ lớn Tongyi Qianwen của Alibaba Cloud

- Tương tự công nghệ AI tạo sinh như ChatGPT

- Ưu điểm vượt trội:

- Tăng hiệu suất phát triển code lên hơn 10 lần

- Là hệ thống đầu tiên trên thế giới hỗ trợ cả Visual Studio Code của Microsoft và JetBrains IDE

- Phản hồi từ chuyên gia:

- Frank Lin, kỹ sư phần mềm tại Thượng Hải đánh giá công cụ này có vẻ mạnh hơn ChatGPT

- Công cụ lập trình hiện tại của ChatGPT chỉ xử lý được các tác vụ lập trình thông thường

- Khả năng sáng tạo còn hạn chế

- Sẵn sàng trả phí nếu dịch vụ chứng minh được tính cạnh tranh

📌 Alibaba Cloud đột phá với AI lập trình Tongyi Lingma, tự động hóa toàn bộ quy trình phát triển ứng dụng chỉ trong vài phút, tăng hiệu suất gấp 10 lần. Là hệ thống đầu tiên tích hợp cả VS Code và JetBrains IDE, mở ra tiềm năng cạnh tranh với các đối thủ phương Tây.

https://www.scmp.com/tech/big-tech/article/3294096/meet-alibabas-ai-coder-automated-system-can-build-app-minutes

Gặp gỡ trình mã hóa AI của Alibaba: Hệ thống tự động có thể xây dựng ứng dụng "trong vài phút"

Trình mã hóa AI là một phần của công cụ lập trình trí tuệ nhân tạo Tongyi Lingma của Alibaba Cloud

Thời gian đọc: 2 phút

Tác giả: Ann Caoin, Thượng Hải

Xuất bản: 8:00 sáng, ngày 10/01/2025

Đơn vị điện toán đám mây của Alibaba Group Holding đã ra mắt một trình mã hóa trí tuệ nhân tạo (AI) mới được quảng bá là có khả năng xây dựng một ứng dụng "trong vài phút", thu hút sự chú ý lớn từ cộng đồng lập trình viên tại Trung Quốc đại lục.

Trình mã hóa AI này, là một phần của công cụ lập trình AI Tongyi Lingma của Alibaba Cloud, có thể thực hiện một loạt các tác vụ tự động – từ hiểu các yêu cầu, viết mã, đến sửa lỗi phần mềm – để hoàn thành phát triển một ứng dụng "nhanh nhất trong vài phút", theo một tuyên bố của công ty vào thứ Tư. Alibaba là chủ sở hữu của tờ South China Morning Post.

Hệ thống này được cung cấp bởi dòng mô hình ngôn ngữ lớn (LLM) Tongyi Qianwen của Alibaba Cloud – công nghệ đứng sau các dịch vụ AI tạo sinh như ChatGPT – và cải thiện hiệu quả phát triển mã lên “hơn 10 lần”, theo tuyên bố từ công ty.

Sự ra mắt này đã khơi dậy suy đoán trong giới lập trình viên Trung Quốc rằng công cụ này có thể vượt qua các sản phẩm từ các công ty Mỹ như OpenAI – nhà sáng lập ChatGPT – khi Alibaba Cloud quảng bá rằng trình mã hóa AI của họ là hệ thống đầu tiên trên thế giới hỗ trợ cả Visual Studio Code (VS Code) của Microsoft và các môi trường phát triển tích hợp (IDEs) của JetBrains – 2 nền tảng phát triển phần mềm phổ biến trong ngành.

Frank Lin, một kỹ sư phần mềm tại Thượng Hải, cho biết trước đây anh đã sử dụng công cụ mã hóa trên trang web của ChatGPT, công cụ này có thể xử lý các nhiệm vụ mã hóa thông thường nhưng "khả năng sáng tạo còn hạn chế".

"Trình mã hóa của Alibaba Cloud trông mạnh hơn so với của ChatGPT theo lời giới thiệu," Lin nhận xét, đồng thời cho biết anh sẵn sàng trả tiền cho dịch vụ mới này nếu nó chứng minh được tính cạnh tranh.

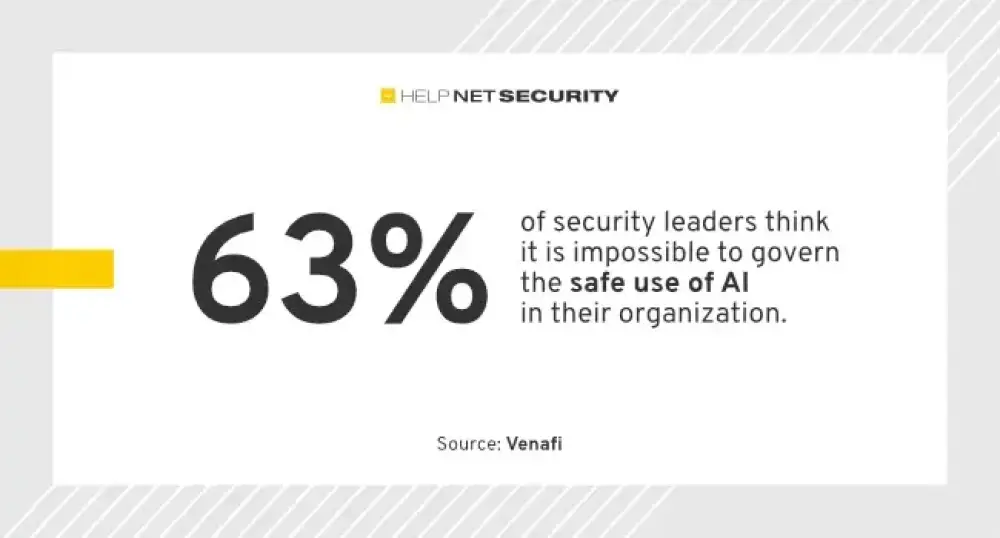

- AI đang thay đổi toàn diện ngành phát triển phần mềm, trở thành yếu tố then chốt giúp doanh nghiệp đáp ứng nhu cầu ngày càng tăng về phần mềm

- Trợ lý lập trình AI giúp giải quyết tình trạng thiếu hụt nhân tài công nghệ thông tin, cho phép các nhóm phát triển hiện tại đáp ứng được khối lượng công việc lớn hơn

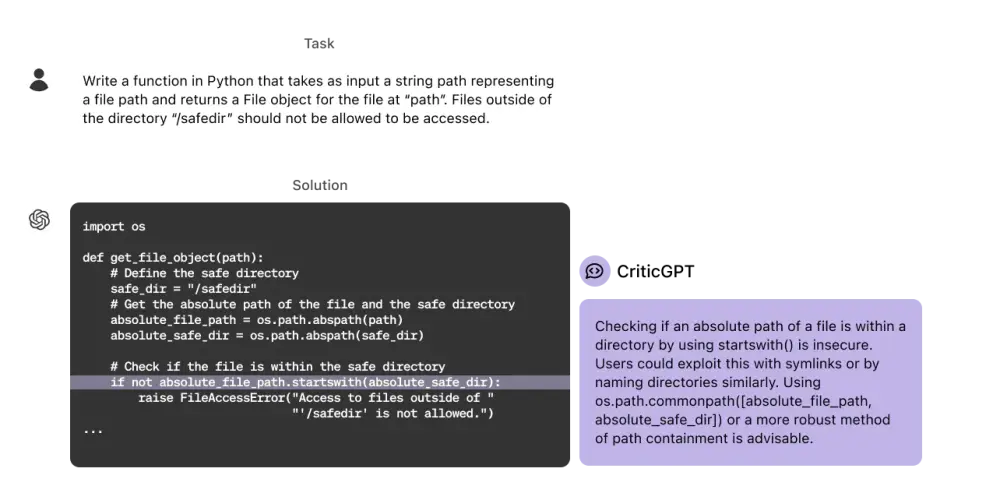

- Nghiên cứu chỉ ra hơn 1/3 mã nguồn được tạo bởi GitHub Copilot chứa những điểm yếu nghiêm trọng. Khoảng 30% mã AI cần sửa chữa và 23% sai một phần

- Chi phí cho mã nguồn kém chất lượng tại Mỹ ước tính lên tới 2,4 nghìn tỷ USD

- 56% lãnh đạo doanh nghiệp lo ngại về tình trạng thiếu hụt nhân tài công nghệ thông tin

- 74% lập trình viên lo sợ AI sẽ thay thế hoàn toàn công việc của họ, 40% tin điều này sẽ xảy ra sớm

- Cục Thống kê Lao động Mỹ dự báo việc làm cho lập trình viên, chuyên gia đảm bảo chất lượng và kiểm thử sẽ tăng 25% từ 2021 đến 2031

- Giải pháp được đề xuất là áp dụng phương pháp "tin tưởng và xác minh" - tận dụng khả năng của AI đồng thời duy trì kiểm tra kỹ lưỡng đầu ra

- Các công cụ kiểm tra mã tự động như SonarQube AI Code Assurance giúp tăng cường trách nhiệm giải trình và giảm áp lực công việc

- Con người vẫn phải chịu trách nhiệm cuối cùng về chất lượng phần mềm, AI chỉ là công cụ hỗ trợ không thể thay thế hoàn toàn lập trình viên

📌 Mã nguồn AI tạo ra tiềm ẩn nhiều rủi ro với 30% cần sửa chữa. Doanh nghiệp cần áp dụng phương pháp "tin tưởng và xác minh" cùng công cụ tự động để đảm bảo chất lượng, tránh thiệt hại 2,4 nghìn tỷ USD do mã kém chất lượng.

https://thenewstack.io/ai-generated-code-requires-a-trust-and-verify-approach/

- Giám đốc Microsoft Satya Nadella đưa ra dự đoán về tương lai ngành phần mềm: AI agent sẽ thay thế hoàn toàn các ứng dụng và nền tảng SaaS truyền thống

- Thay vì phải học cách sử dụng các phần mềm phức tạp, người dùng có thể đơn giản ra lệnh cho AI agent thực hiện công việc một cách hiệu quả

- AI agent sẽ tương tác trực tiếp với cơ sở dữ liệu để thực thi nhiệm vụ, bỏ qua các lớp ứng dụng trung gian và mang lại trải nghiệm người dùng liền mạch hơn

- Ví dụ thay vì phải điều hướng qua hệ thống CRM phức tạp, người dùng có thể yêu cầu AI agent truy xuất dữ liệu khách hàng, phân tích xu hướng hoặc tạo báo cáo theo thời gian thực

- Vai trò của nhà phát triển sẽ thay đổi: tập trung vào huấn luyện mô hình AI thay vì xây dựng ứng dụng tĩnh

- Microsoft đang dẫn đầu xu hướng này với các công cụ như Copilot được tích hợp vào Excel và Word, thể hiện tầm nhìn về giải pháp kinh doanh AI từ cốt lõi

- AI agent có thể tương tác liền mạch với nhiều cơ sở dữ liệu, cho phép doanh nghiệp tối ưu hóa cơ sở hạ tầng mà không bị ràng buộc vào một công nghệ cụ thể

- Logic kinh doanh sẽ được tích hợp trực tiếp vào AI agent, tự động hóa các tác vụ như tạo báo cáo, gửi email hoặc phân tích dữ liệu

📌 Theo dự đoán của CEO Microsoft, AI agent sẽ thay thế hoàn toàn phần mềm truyền thống, loại bỏ giao diện người dùng tĩnh. Sự thay đổi này sẽ tác động sâu rộng đến ngành công nghiệp phần mềm, vai trò của nhà phát triển và cách doanh nghiệp vận hành.

https://www.geeky-gadgets.com/ai-agents-replacing-traditional-software/

- Github copilot và Cursor là hai trợ lý lập trình AI phổ biến, mỗi công cụ có những điểm mạnh và hạn chế riêng

- Tính năng chính của Github copilot:

- Có phiên bản miễn phí cho người dùng Visual studio code

- Chỉnh sửa đa tệp tin với tính năng "Edit with copilot"

- Tùy chỉnh mã theo sở thích thông qua file cấu hình

- Tự động hoàn thành mã khi gõ

- Tự động hóa các lệnh terminal dựa trên đầu vào

- Tính năng nổi bật của Cursor:

- Tìm kiếm mã nguồn nhanh chóng ngay cả với dự án lớn

- Chế độ agent tự động chọn ngữ cảnh và chỉnh sửa nhiều file

- Cập nhật nhiều dòng mã một cách hiệu quả

- Tự động hóa quy trình làm việc từ đầu đến cuối

- Tạo mã sạch và dễ bảo trì hơn

- So sánh hiệu suất:

- Cursor vượt trội về tốc độ và độ chính xác trong sửa lỗi và cập nhật API

- Github copilot đôi khi gặp vấn đề với kết quả không đầy đủ hoặc không chính xác

- Cursor ổn định và đáng tin cậy hơn với các tác vụ phức tạp

- Giá cả:

- Github copilot: Miễn phí và gói trả phí từ 10 USD/tháng

- Cursor: 20 USD/tháng

- Các lựa chọn thay thế:

- Windsurf: Tính năng tương tự Cursor với giá cạnh tranh

- Devon: Tập trung vào phân tích và gỡ lỗi mã nguồn nâng cao

- Klein: Cung cấp tính năng đặc biệt cho môi trường lập trình cụ thể

📌 Cursor vượt trội về hiệu suất và độ tin cậy nhưng đắt hơn (20 USD/tháng) so với Github copilot (10 USD/tháng). Cursor phù hợp với dự án phức tạp đòi hỏi tốc độ và độ chính xác cao, trong khi Github copilot là lựa chọn tốt cho người mới bắt đầu và các tác vụ đơn giản.

https://www.geeky-gadgets.com/github-copilot-vs-cursor/

Github Copilot vs Cursor: So sánh các trợ lý AI lập trình

Tóm tắt nhanh:

- Github Copilot cung cấp gói miễn phí và giá cả phải chăng, phù hợp với các nhà phát triển có ngân sách hạn chế nhưng hiệu năng có thể không ổn định trong các tác vụ phức tạp.

- Cursor vượt trội về tốc độ, độ chính xác và độ tin cậy, đặc biệt trong việc sửa lỗi, cập nhật API và xử lý mã nguồn lớn, nhưng chi phí cao hơn (20 USD mỗi tháng).

- Cursor có chế độ tác nhân tự động chọn ngữ cảnh và chỉnh sửa nhiều tệp hiệu quả hơn so với cách tiếp cận gắn thẻ thủ công của Copilot.

- Github Copilot dễ sử dụng, tích hợp tốt với Visual Studio Code, trong khi Cursor cung cấp mã gọn gàng, dễ bảo trì và tự động hóa quy trình làm việc vượt trội.

- Các trợ lý AI khác như WindSurf, Devon, và Klein có thể phù hợp hơn tùy thuộc vào nhu cầu và ngân sách cụ thể.

Github Copilot: Đặc điểm và tính năng

Github Copilot nổi bật với tích hợp liền mạch trong Visual Studio Code, cung cấp hỗ trợ mã hóa theo thời gian thực với các tính năng chính:

- Gói miễn phí: Mang lại tùy chọn không tốn phí cho người dùng Visual Studio Code.

- Chỉnh sửa nhiều tệp: Tính năng “Edit with Copilot” cho phép thay đổi đồng thời trên nhiều tệp, tiết kiệm thời gian.

- Hướng dẫn tùy chỉnh: Định nghĩa các tùy chọn mã hóa thông qua tệp cấu hình, cá nhân hóa gợi ý.

- Tự động hoàn thiện dòng mã: Đề xuất mã theo thời gian thực khi nhập, giúp tăng tốc độ phát triển.

- Tự động hóa lệnh Terminal: Sinh lệnh dựa trên đầu vào, giảm thiểu nỗ lực thủ công.

Tuy nhiên, Copilot đôi khi gặp vấn đề với độ trễ, chỉ mục hóa chậm, và đầu ra chưa hoàn chỉnh khi đối mặt với các tác vụ phức tạp. Điều này làm giảm hiệu quả trong các trường hợp đòi hỏi cao.

Cursor: Điểm mạnh và tính năng

Cursor được thiết kế để khắc phục các hạn chế của các trợ lý AI khác, tập trung vào tốc độ, độ chính xác, và độ tin cậy. Các tính năng nổi bật:

- Tìm kiếm mã nhanh: Tìm đoạn mã liên quan ngay cả trong các dự án lớn, phức tạp.

- Chỉnh sửa nhiều tệp đáng tin cậy: Chế độ tác nhân đơn giản hóa chỉnh sửa, đảm bảo tính nhất quán với nỗ lực tối thiểu.

- Cập nhật dòng mã trực tiếp: Cập nhật mã nhanh chóng và chính xác, duy trì chất lượng mã.

- Tự động hóa quy trình làm việc: Xử lý quy trình phức tạp như sửa lỗi và cập nhật API với tốc độ và độ chính xác đáng kể.

- Tổ chức mã vượt trội: Sinh mã gọn gàng, dễ bảo trì hơn so với nhiều đối thủ cạnh tranh.

Cursor nổi bật với chế độ tác nhân tự động chọn ngữ cảnh, giảm thiểu tác vụ thủ công, giúp tiết kiệm thời gian khi làm việc với mã nguồn lớn.

Hiệu năng: So sánh về tốc độ và độ chính xác

Cursor vượt trội hơn Github Copilot trong các tác vụ quan trọng như sửa lỗi và cập nhật API, nhờ độ chính xác và độ tin cậy cao. Copilot đôi khi gặp khó khăn với đầu ra chưa đầy đủ hoặc không chính xác.

Tuy nhiên, Copilot có lợi thế về tính khả dụng với gói miễn phí và giá khởi điểm thấp hơn, hấp dẫn các nhà phát triển hạn chế ngân sách hoặc mới làm quen với trợ lý AI.

Khả năng sử dụng và tích hợp quy trình làm việc

Cursor cung cấp giao diện đơn giản, tích hợp liền mạch, tập trung vào mã hóa thay vì khắc phục lỗi công cụ. Với tính năng tự động hóa, ngay cả các tác vụ phức tạp cũng có thể được quản lý dễ dàng.

Trong khi đó, Github Copilot thân thiện với người dùng nhưng có thể hạn chế trong các trường hợp nâng cao. Phương pháp gắn thẻ thủ công của Copilot đôi khi làm chậm tiến trình, đặc biệt với các dự án lớn.

Cursor nổi bật hơn trong khả năng tự động hóa chọn ngữ cảnh và chỉnh sửa nhiều tệp, mang lại trải nghiệm mượt mà hơn.

Giá cả và giá trị

- Github Copilot: Gói miễn phí và gói trả phí từ 10 USD/tháng, phù hợp với ngân sách eo hẹp.

- Cursor: Giá 20 USD/tháng, nhưng bù lại với hiệu năng và tính năng vượt trội.

Những nhà phát triển cần trợ lý AI cơ bản với giá cả hợp lý sẽ tìm thấy Copilot là lựa chọn hấp dẫn. Ngược lại, nếu ưu tiên tốc độ, độ chính xác và khả năng nâng cao, Cursor xứng đáng với chi phí cao hơn.

Trợ lý AI thay thế

Nếu cả Github Copilot và Cursor không đáp ứng đủ nhu cầu, có thể xem xét các công cụ khác:

- WindSurf: Tính năng tương tự Cursor với giá cạnh tranh.

- Devon: Tập trung vào phân tích mã nâng cao và công cụ gỡ lỗi.

- Klein: Tùy chỉnh cho các môi trường lập trình cụ thể.

Kết luận

Lựa chọn giữa Github Copilot và Cursor phụ thuộc vào ưu tiên, nhu cầu lập trình, và ngân sách của bạn:

- Copilot: Phù hợp cho các tác vụ đơn giản, người mới làm quen, hoặc hạn chế ngân sách.

- Cursor: Tốt hơn cho các nhà phát triển chuyên nghiệp, dự án phức tạp, hoặc yêu cầu tốc độ và độ chính xác cao.

Đánh giá cẩn thận các tính năng, hiệu năng, và giá cả để chọn trợ lý AI phù hợp nhất, hỗ trợ mục tiêu phát triển của bạn và nâng cao hiệu suất làm việc.

- OpenAI vừa công bố phiên bản nâng cấp của model AI thông minh nhất của công ty, chỉ một ngày sau khi Google ra mắt model suy luận đầu tiên

- Model mới có tên o3, thay thế cho o1 được giới thiệu từ tháng 9/2024. Model này có khả năng suy nghĩ kỹ hơn trước khi đưa ra câu trả lời

- Theo CEO Sam Altman, đây là bước khởi đầu cho giai đoạn tiếp theo của AI, khi các model có thể thực hiện các tác vụ phức tạp đòi hỏi nhiều suy luận

- o3 đạt điểm cao hơn đáng kể so với phiên bản trước trong nhiều tiêu chí:

+ Kỹ năng lập trình phức tạp

+ Năng lực toán học và khoa học nâng cao

+ Khả năng giải quyết các bài toán khó về logic gấp 3 lần so với o1

- Google cũng vừa công bố model Gemini 2.0 Flash Thinking, nhưng o3 của OpenAI vượt trội hơn 20% trong các bài kiểm tra về khả năng agent

- OpenAI phát triển 2 phiên bản: o3 và o3-mini, nhưng chưa công bố rộng rãi mà sẽ mời người dùng bên ngoài đăng ký thử nghiệm

- Công ty cũng tiết lộ phương pháp "deliberative alignment" (“điều chỉnh thông qua cân nhắc”)giúp model an toàn hơn bằng cách tự suy xét về các yêu cầu và câu trả lời

- Cuối năm 2024 chứng kiến nhiều thông báo quan trọng từ các ông lớn công nghệ:

+ Google ra mắt Gemini 2.0

+ OpenAI giới thiệu model tạo video mới

+ Ra mắt phiên bản miễn phí ChatGPT search

+ Cung cấp dịch vụ ChatGPT qua điện thoại

📌 OpenAI tăng tốc cuộc đua AI suy luận với model o3 mạnh gấp 3 lần o1, vượt trội 20% so với Gemini 2.0 của Google. Model mới tích hợp công nghệ deliberative alignment cho độ an toàn cao và sẽ được thử nghiệm giới hạn trước khi ra mắt chính thức.

https://www.wired.com/story/openai-o3-reasoning-model-google-gemini/

OpenAI nâng cấp mô hình AI thông minh nhất với kỹ năng lập luận cải thiện

Một ngày sau khi Google công bố mô hình đầu tiên có khả năng lập luận vấn đề, OpenAI đã nâng tầm cuộc chơi với phiên bản cải tiến của chính mình.

OpenAI hôm nay công bố phiên bản cải tiến của mô hình trí tuệ nhân tạo mạnh mẽ nhất của mình cho đến nay—một mô hình dành nhiều thời gian hơn để cân nhắc câu hỏi—chỉ một ngày sau khi Google giới thiệu mô hình đầu tiên thuộc loại này.

Mô hình mới của OpenAI, mang tên o3, thay thế o1, được công ty ra mắt vào tháng 9. Tương tự như o1, mô hình mới dành thời gian suy ngẫm về vấn đề để đưa ra câu trả lời tốt hơn cho những câu hỏi đòi hỏi lập luận logic từng bước. (OpenAI bỏ qua tên gọi “o2” vì đây là tên của một nhà mạng di động tại Anh.)

“Đây là khởi đầu cho giai đoạn tiếp theo của AI,” CEO OpenAI Sam Altman phát biểu trong buổi livestream hôm thứ Sáu. “Mô hình này cho phép thực hiện các nhiệm vụ ngày càng phức tạp đòi hỏi nhiều lập luận.”

Mô hình o3 đạt điểm cao hơn nhiều trên một số tiêu chí so với phiên bản tiền nhiệm, OpenAI cho biết, bao gồm khả năng lập trình phức tạp và năng lực toán học, khoa học nâng cao. Nó vượt trội gấp ba lần so với o1 trong việc trả lời các câu hỏi từ ARC-AGI, một tiêu chuẩn đánh giá khả năng lập luận của mô hình AI đối với các vấn đề toán học và logic cực kỳ khó mà lần đầu tiên chúng gặp phải.

Google cũng đang theo đuổi hướng nghiên cứu tương tự. Hôm qua, nhà nghiên cứu Google Noam Shazeer tiết lộ trên X rằng công ty đã phát triển mô hình lập luận riêng, mang tên Gemini 2.0 Flash Thinking. CEO Sundar Pichai của Google gọi đây là “mô hình cẩn trọng nhất của chúng tôi” trong bài đăng của mình. Mô hình mới của Google đạt điểm cao trên SWE-Bench, một bài kiểm tra đánh giá khả năng tác nghiệp của các mô hình AI.

Tuy nhiên, mô hình o3 của OpenAI vẫn tốt hơn o1 đến 20%. “o3 đã vượt xa kỳ vọng,” Ofir Press, nhà nghiên cứu sau tiến sĩ tại Đại học Princeton, người giúp phát triển SWE-Bench, nhận xét. “Sự cải tiến này rất bất ngờ, tôi không rõ họ đã làm thế nào.”

Sự cạnh tranh giữa OpenAI và Google ngày càng khốc liệt. Điều này rất quan trọng đối với OpenAI trong việc thu hút thêm đầu tư và xây dựng một doanh nghiệp có lợi nhuận. Trong khi đó, Google cố gắng chứng minh rằng họ vẫn đứng đầu về nghiên cứu AI.

Những mô hình mới này cũng cho thấy các công ty AI ngày càng tập trung vào việc tối ưu hóa thay vì chỉ tăng kích thước mô hình để đạt được trí thông minh cao hơn.

OpenAI cho biết có hai phiên bản của mô hình mới: o3 và o3-mini. Công ty hiện chưa cung cấp mô hình này cho công chúng mà chỉ mời các đối tác bên ngoài đăng ký thử nghiệm.

OpenAI hôm nay cũng tiết lộ chi tiết về kỹ thuật sử dụng để điều chỉnh o1. Phương pháp mới, gọi là “điều chỉnh thông qua cân nhắc” (deliberative alignment), liên quan đến việc đào tạo mô hình với một bộ quy chuẩn an toàn, yêu cầu mô hình lập luận về bản chất của yêu cầu cũng như câu trả lời của chính nó để kiểm tra xem có vi phạm các quy chuẩn này hay không. Cách tiếp cận này khiến mô hình khó bị lừa vào các hành vi sai lệch hơn vì quá trình lập luận của nó có thể phát hiện các ý đồ không phù hợp.

Các mô hình ngôn ngữ lớn có thể trả lời nhiều câu hỏi rất tốt, nhưng thường gặp khó khăn khi giải quyết các câu đố đòi hỏi toán học hoặc logic cơ bản. OpenAI o1 tích hợp đào tạo giải quyết vấn đề từng bước, giúp mô hình AI xử lý tốt hơn các vấn đề này.

Những mô hình có khả năng lập luận sẽ quan trọng khi các công ty triển khai “tác nhân AI” (AI agents) có thể giải quyết vấn đề phức tạp một cách đáng tin cậy thay mặt người dùng.

“Điều này thực sự đánh dấu việc chúng ta đang tiến đến biên giới mới về tính hữu ích,” Mark Chen, phó chủ tịch cấp cao về nghiên cứu tại OpenAI, phát biểu trong buổi livestream hôm nay.

“Mô hình này rất xuất sắc trong lập trình,” Altman bổ sung.

Mặc dù một bước đột phá thực sự vẫn chưa xuất hiện vào cuối năm nay, nhưng tốc độ công bố công nghệ AI gần đây thật đáng kinh ngạc.

Đầu tháng này, Google đã công bố phiên bản mới của mô hình chủ lực mang tên Gemini 2.0, trình diễn khả năng hỗ trợ duyệt web và làm trợ lý thông qua điện thoại thông minh hoặc kính thông minh.

OpenAI gần đây cũng đã công bố hàng loạt cải tiến, bao gồm một phiên bản mới của mô hình tạo video, phiên bản miễn phí của công cụ tìm kiếm tích hợp ChatGPT, và cách truy cập ChatGPT qua điện thoại bằng cách gọi 1-800-ChatGPT.

OpenAI Upgrades Its Smartest AI Model With Improved Reasoning Skills

A day after Google announced its first model capable of reasoning over problems, OpenAI has upped the stakes with an improved version of its own.

NEW YORK NEW YORK DECEMBER 04 OpenAI CEO Sam Altman Visits Making Money With Charles Payne at Fox Business Network...

OpenAI CEO Sam Altman Visits "Making Money With Charles Payne" at Fox Business Network Studios on December 04, 2024 in New York City.Photograph: Mike Coppola/Getty Images

OpenAI today announced an improved version of its most capable artificial intelligence model to date—one that takes even more time to deliberate over questions—just a day after Google announced its first model of this type.

OpenAI’s new model, called o3, replaces o1, which the company introduced in September. Like o1, the new model spends time ruminating over a problem in order to deliver better answers to questions that require step-by-step logical reasoning. (OpenAI chose to skip the “o2” moniker because it's already the name of a mobile carrier in the UK.)

AI Lab Newsletter by Will Knight

WIRED’s resident AI expert Will Knight takes you to the cutting edge of this fast-changing field and beyond—keeping you informed about where AI and technology are headed. Delivered on Wednesdays.

Sign up

By signing up, you agree to our user agreement (including class action waiver and arbitration provisions), and acknowledge our privacy policy.

“We view this as the beginning of the next phase of AI,” said OpenAI CEO Sam Altman on a livestream Friday. “Where you can use these models to do increasingly complex tasks that require a lot of reasoning.”

Featured Video

Historian Answers Samurai Questions

The o3 model scores much higher on several measures than its predecessor, OpenAI says, including ones that measure complex coding-related skills and advanced math and science competency. It is three times better than o1 at answering questions posed by ARC-AGI, a benchmark designed to test an AI models’ ability to reason over extremely difficult mathematical and logic problems they’re encountering for the first time.

Google is pursuing a similar line of research. Noam Shazeer, a Google researcher, yesterday revealed in a post on X that the company has developed its own reasoning model, called Gemini 2.0 Flash Thinking. Google’s CEO, Sundar Pichai, called it “our most thoughtful model yet” in his own post. Google’s new model achieved a high score on SWE-Bench, a test that measures a models’ agentic abilities.

However, OpenAI’s new o3 model is 20 percent better than o1. “o3 blew it out of the water,” says Ofir Press, a post-doctoral researcher at Princeton University who helped develop SWE-Bench. “Very surprising increase, not sure how they did it.”

The two dueling models show competition between OpenAI and Google to be fiercer than ever. It is crucial for OpenAI to demonstrate that it can keep making advances as it seeks to attract more investment and build a profitable business. Google is meanwhile desperate to show that it remains at the forefront of AI research.

The new models also show how AI companies are increasingly looking beyond simply scaling up AI models in order to wring greater intelligence out of them.

Most Popular

The Best Cookbooks of 2024

Kitchen

The Best Cookbooks of 2024

By Joe Ray

The Best Hair Straighteners to Iron Out Those Kinks

Lifestyle

The Best Hair Straighteners to Iron Out Those Kinks

By Kat Merck

Give Your Back a Break With Our Favorite Office Chairs

Buying Guides

Give Your Back a Break With Our Favorite Office Chairs

By Julian Chokkattu

The Latest Indiana Jones Game Showcases Indy's Swashbuckling Charm

Culture

The Latest Indiana Jones Game Showcases Indy's Swashbuckling Charm

By Matt Kamen

Advertisement

OpenAI says there are two versions of the new model, o3 and o3-mini. The company is not making the models publicly available yet but says it will invite outsiders to apply to perform testing of them.

OpenAI today also revealed more details of techniques used to align o1. The new method, known as deliberative alignment, involves training a model with a set of safety specifications and having it reason about the nature of the request as well as its own answer it is given to interrogate whether it may contravene its guardrails. The approach makes the model more difficult to trick into misbehavior because its reasoning process can root out attempts at mischief.

Large language models can answer many questions remarkably well, but they often stumble when asked to solve puzzles that require basic math or logic. OpenAI’s o1 incorporates training on step-by-step problem-solving that makes an AI model better able to tackle these types of problems.

Models that reason over problems will also be important as companies seek to deploy so-called AI agents that can reliably figure out how to solve complex problems on a users’ behalf.

“This really signifies that we are really climbing the frontier of utility,” Mark Chen, senior vice president of research at OpenAI said on today’s livestream.

“This model is incredible at programming,” Atlman added.

While a true breakthrough moment has eluded tech giants at the end of the year, the pace of AI announcements has been dizzying of late.

Early this month Google announced a new version of its flagship model, called Gemini 2.0, and demonstrated it as a web browsing helper and as an assistant that sees the world through a smartphone or a pair of smart glasses.

OpenAI has made numerous announcements in the run up to Christmas, including a new version of its video-generating model, a free version of its ChatGPT-powered search engine, and a way to access ChatGPT over the phone by calling 1-800-ChatGPT.

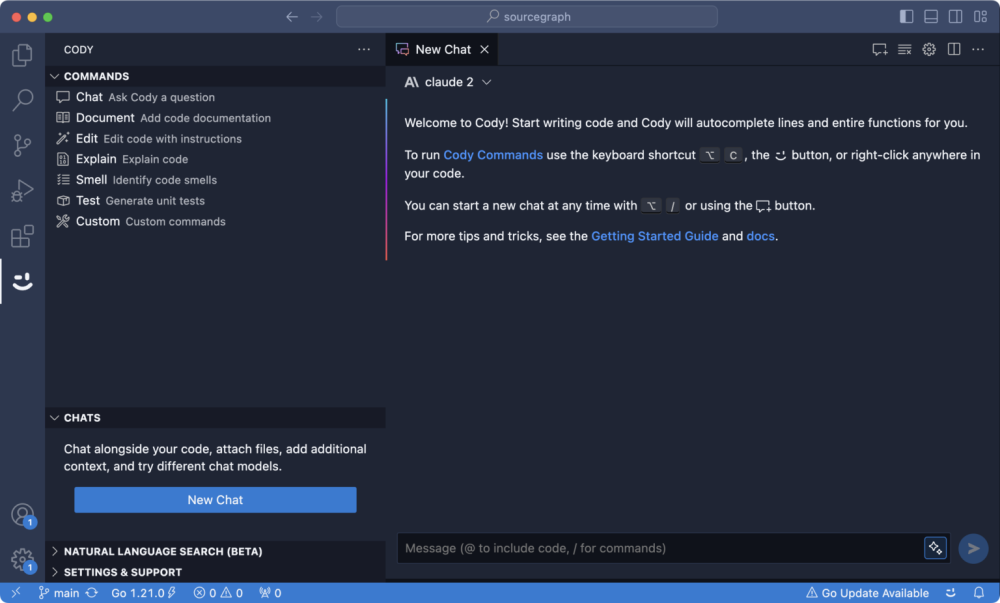

- Google đã công bố hỗ trợ cho các công cụ bên thứ ba trong Gemini Code Assist vào ngày 17 tháng 12 năm 2024.

- Code Assist được ra mắt vào tháng 4 năm 2024 như một phần của thương hiệu mới từ dịch vụ Duet AI trước đây của Google.

- Dịch vụ này có sẵn thông qua các plug-in cho các môi trường phát triển phổ biến như VS Code và JetBrains.

- Code Assist sử dụng các mô hình AI Gemini của Google, cho phép nó xử lý và thay đổi các đoạn mã lớn một cách hiệu quả.

- Tính năng mới cho phép Code Assist truy cập dữ liệu thời gian thực và thông tin từ các ứng dụng bên ngoài nhằm giảm thiểu sự phân tâm cho lập trình viên.

- Ryan Salva và Prithpal Bhogill, giám đốc quản lý sản phẩm của Google, nhấn mạnh rằng việc đưa ứng dụng vào sản xuất không chỉ cần viết mã tốt mà còn cần giải pháp cho năng suất, quan sát, bảo mật và cơ sở dữ liệu.

- Hiện tại, Google giới hạn chương trình này chỉ dành cho các đối tác của Google Cloud.

- Các công cụ có thể giúp lập trình viên truy xuất thông tin từ hệ thống kỹ thuật của họ hoặc thực hiện hành động trên bất kỳ phần nào trong đó.

- Một số công cụ từ GitLab, GitHub, Sentry.io, Atlassian Rovo, Snyk và Google Docs đã có mặt ngay khi ra mắt.

- Các đối tác của Google Cloud muốn phát triển công cụ mới có thể liên hệ với quản lý đối tác của họ.

- Code Assist cạnh tranh trực tiếp với GitHub Copilot Enterprise, nhưng Google khẳng định rằng Code Assist nổi bật với hỗ trợ cho các mã nguồn lưu trữ tại chỗ.

- Trong năm nay, Code Assist đã trải qua nhiều nâng cấp bao gồm khả năng chuyển đổi mã nâng cao và ra mắt gói doanh nghiệp với gợi ý mã tùy chỉnh dựa trên kho mã riêng tư.

- Mặc dù có những lo ngại về bảo mật và bản quyền liên quan đến các công cụ lập trình hỗ trợ AI, nhưng lập trình viên vẫn tỏ ra hào hứng với chúng.

📌 Google đã ra mắt tính năng hỗ trợ công cụ bên thứ ba cho Gemini Code Assist nhằm cải thiện trải nghiệm lập trình viên. Các đối tác như GitHub và Sentry.io sẽ cung cấp tích hợp hữu ích. Công cụ này cạnh tranh trực tiếp với GitHub Copilot Enterprise và đã nhận được nhiều nâng cấp trong năm nay.

https://techcrunch.com/2024/12/17/code-assist-googles-enterprise-focused-code-assistant-gets-third-party-tools/

- Google vừa công bố trợ lý lập trình AI "Jules" ngày 11/12/2024, được xây dựng trên nền tảng Gemini 2.0

- Jules có khả năng:

+ Tự động phân tích và sửa lỗi phần mềm phức tạp

+ Chuẩn bị các thay đổi code trong lúc lập trình viên nghỉ ngơi

+ Tích hợp trực tiếp với hệ thống GitHub

+ Thực hiện sửa đổi trên nhiều file cùng lúc

+ Tạo pull request chi tiết mà không cần giám sát liên tục

- Theo Gartner, đến năm 2028, 75% ứng dụng mới sẽ được phát triển với sự hỗ trợ của AI

- Jaclyn Konzelmann, giám đốc quản lý sản phẩm tại Google Labs nhấn mạnh:

+ Lập trình viên luôn kiểm soát được quá trình

+ Jules sẽ đề xuất kế hoạch trước khi hành động

+ Cần phê duyệt rõ ràng trước khi merge code

- Tác động tài chính:

+ Các dự án IT lớn thường vượt 45% ngân sách

+ Chi phí code chất lượng kém lên đến 2,84 nghìn tỷ USD mỗi năm

+ Thị trường công cụ phát triển dự kiến đạt 937 tỷ USD vào năm 2027

- Kế hoạch triển khai:

+ Giai đoạn đầu: chỉ cho nhóm kiểm thử được chọn

+ Đầu năm 2025: mở rộng người dùng

+ Tích hợp với Android Studio và Chrome DevTools

📌 Google Jules là bước đột phá trong tự động hóa lập trình, hứa hẹn giảm 45% chi phí vượt ngân sách dự án IT. Dự kiến đến 2028, 75% ứng dụng mới sẽ được phát triển với AI, trong bối cảnh thị trường công cụ phát triển đạt 937 tỷ USD vào 2027.

https://venturebeat.com/ai/google-unveils-ai-coding-assistant-jules-promising-autonomous-bug-fixes-and-faster-development-cycles/

Google ra mắt trợ lý lập trình AI “Jules,” hứa hẹn sửa lỗi tự động và rút ngắn chu kỳ phát triển

Michael Nuñez

@MichaelFNunez

Ngày 11 tháng 12, 2024, 7:29 sáng

Google đã ra mắt “Jules” vào thứ Tư, một trợ lý lập trình sử dụng AI có khả năng tự động sửa lỗi phần mềm và chuẩn bị các thay đổi mã trong khi các nhà phát triển đang nghỉ ngơi, đánh dấu một bước tiến đáng kể trong nỗ lực của công ty nhằm tự động hóa các tác vụ lập trình cốt lõi.

Tác nhân mã hóa dựa trên AI thử nghiệm này được xây dựng trên nền tảng Gemini 2.0 mới được công bố của Google. Jules tích hợp trực tiếp với hệ thống luồng công việc của GitHub, có khả năng phân tích mã nguồn phức tạp, thực hiện sửa lỗi trên nhiều tệp, và chuẩn bị các yêu cầu hợp nhất (pull request) chi tiết mà không cần sự giám sát liên tục từ con người.

Jules hoạt động như thế nào?

Không giống các trợ lý lập trình truyền thống chỉ gợi ý sửa lỗi, Jules hoạt động như một tác nhân tự động trong hệ sinh thái GitHub. Công cụ này phân tích mã nguồn, tạo ra các kế hoạch sửa lỗi toàn diện và thực hiện sửa chữa trên nhiều tệp cùng lúc. Quan trọng nhất, Jules tích hợp mượt mà với luồng công việc hiện có của các nhà phát triển.

Tại một cuộc họp báo, Jaclyn Konzelmann, giám đốc quản lý sản phẩm tại Google Labs, nhấn mạnh các tính năng an toàn của hệ thống. “Các nhà phát triển vẫn kiểm soát mọi bước,” cô giải thích. “Jules trình bày kế hoạch đề xuất trước khi hành động, và người dùng có thể theo dõi tiến trình viết mã.” Hệ thống yêu cầu phê duyệt rõ ràng trước khi hợp nhất bất kỳ thay đổi nào, đảm bảo quá trình phát triển vẫn dưới sự giám sát của con người.

Jules trong chiến lược tổng thể của Google về AI

Jules không chỉ là một trợ lý lập trình; nó là một phần trong tầm nhìn rộng hơn của Google về các tác nhân AI có thể hoạt động tự động nhưng vẫn dưới sự giám sát của con người. Công cụ này được hỗ trợ bởi Gemini 2.0, mô hình ngôn ngữ lớn mới nhất của Google, mang lại những cải tiến đáng kể trong khả năng hiểu và tạo mã.

“Chúng tôi vẫn đang trong giai đoạn đầu để hiểu hết khả năng của các tác nhân AI trong lĩnh vực lập trình,” Konzelmann thừa nhận trong buổi họp báo. Cách tiếp cận thận trọng này phản ánh mối quan tâm chung của ngành về độ an toàn và độ tin cậy của AI, đặc biệt trong các hệ thống quan trọng.

Jules sẽ ảnh hưởng thế nào đến công việc của nhà phát triển?

Đối với nhiều nhà phát triển, Jules đặt ra những câu hỏi quan trọng về tương lai nghề nghiệp của họ. Tuy nhiên, thử nghiệm ban đầu cho thấy công cụ này có khả năng tăng cường hơn là thay thế các nhà phát triển con người. Tại Phòng thí nghiệm Quốc gia Lawrence Berkeley, các nhà nghiên cứu sử dụng Jules và các công cụ AI khác của Google đã giảm thời gian thực hiện một số tác vụ phân tích từ một tuần xuống còn vài phút, giúp họ tập trung vào những thách thức phức tạp hơn.

Các tác động tài chính từ Jules có thể rất lớn. Các dự án phát triển phần mềm thường có nguy cơ vượt ngân sách đáng kể, với các dự án CNTT lớn vượt ngân sách 45% và chỉ mang lại 56% giá trị dự kiến, theo McKinsey. Bằng cách tự động hóa các tác vụ sửa lỗi và bảo trì, Jules có thể giảm đáng kể chi phí này trong khi tăng tốc chu kỳ phát triển.

Chiến lược của Google cũng đặt công ty vào vị trí cạnh tranh với GitHub Copilot của Microsoft và CodeWhisperer của Amazon. Việc tích hợp với luồng công việc của GitHub mang lại cho Google một chỗ đứng vững chắc trong thị trường công cụ phát triển, được dự đoán sẽ đạt 937 tỷ USD vào năm 2027.

Tương lai của lập trình được hỗ trợ bởi AI

Jules sẽ được cung cấp ban đầu cho một nhóm nhỏ người thử nghiệm đáng tin cậy, với kế hoạch mở rộng quyền truy cập vào đầu năm 2025. Google đã công bố kế hoạch tích hợp các khả năng tương tự vào hệ sinh thái phát triển của mình, bao gồm Android Studio và Chrome DevTools.

Thử thách thực sự của Jules sẽ nằm ở khả năng xử lý các thách thức lập trình ngày càng phức tạp trong khi vẫn duy trì chất lượng và bảo mật mã nguồn. Như một nhà phát triển cấp cao tại một công ty công nghệ lớn nhận xét, “Lời hứa không chỉ nằm ở việc sửa lỗi nhanh hơn — mà còn là thay đổi căn bản cách chúng ta tiếp cận phát triển phần mềm.”

Trong một ngành mà chi phí do chất lượng mã kém gây ra lên tới 2,84 nghìn tỷ USD mỗi năm, theo CISQ, Jules có thể không chỉ là một công cụ mới trong kho vũ khí của nhà phát triển. Đây có thể đánh dấu sự khởi đầu của một kỷ nguyên mới, nơi AI và nhà phát triển con người hợp tác thực sự, có khả năng định hình lại tương lai của lĩnh vực phát triển phần mềm.

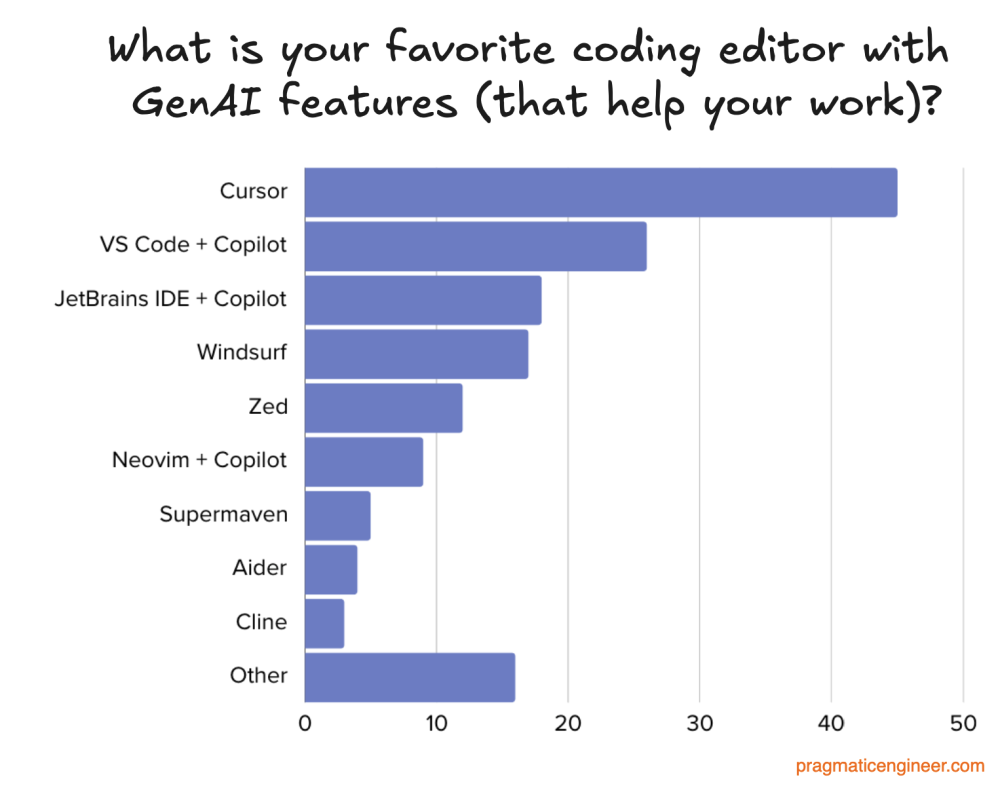

- Khảo sát từ 155 phản hồi trên các nền tảng mạng xã hội: 77 trên Bluesky, 62 trên X và 16 trên Threads

- Các IDE được yêu thích nhất theo thứ tự:

- Cursor: IDE ưu tiên AI, đang tăng trưởng nhanh

- Visual Studio Code với GitHub Copilot

- JetBrains IDE với GitHub Copilot

- Windsurf Editor: IDE agent mới ra mắt bởi Codeium

- Zed: IDE thế hệ mới thiết kế để làm việc với AI

- Giá các công cụ IDE khá phải chăng:

- Nhiều công cụ miễn phí có giới hạn sử dụng

- Phiên bản chuyên nghiệp có giá từ 10-20 USD/tháng

- Chỉ Augment Code có giá cao hơn ở mức 60 USD/tháng

- Ưu điểm nổi bật của Cursor:

- Tích hợp mô hình Sonnet 3.5 cho khả năng sinh code tốt hơn

- Tính năng Composer cho phép làm việc trên nhiều file

- Giao diện chat riêng biệt

- Dễ dàng chuyển đổi giữa các mô hình AI

- Điểm mạnh của Windsurf:

- Tính năng Cascade vượt trội hơn Composer của Cursor

- Có thể chạy lệnh terminal

- Claude hoạt động ổn định hơn so với Cursor

- Tốc độ phản hồi nhanh

- Zed nổi bật với:

- Miễn phí không giới hạn AI completion cho người dùng đăng ký

- Chế độ Vim tốt

- Tốc độ nhanh

- Dễ dàng chuyển đổi từ các IDE khác

📌 IDE tích hợp AI đang bùng nổ với 3 startup nổi bật là Cursor, Windsurf và Zed. Microsoft vẫn giữ lợi thế về phân phối dù đang bị các startup vượt mặt về đổi mới. Thị trường IDE hứa hẹn cạnh tranh gay gắt trong tương lai với nhiều startup được đầu tư hàng trăm triệu USD.

https://blog.pragmaticengineer.com/ide-that-software-engineers-love/

- Thị trường AI dự kiến tăng trưởng 36,6% mỗi năm từ 2024-2030, trong đó lĩnh vực phát triển phần mềm sẽ nhận được đầu tư đáng kể

- Theo khảo sát của Github, 70% lập trình viên đang sử dụng công cụ AI để hỗ trợ công việc

- Nghiên cứu của đại học Stanford chỉ ra rằng lập trình viên sử dụng AI tạo ra mã nguồn kém an toàn hơn so với coding thông thường

- Đại học Bilkent đánh giá khoảng 30,5% mã nguồn do Github Copilot tạo ra có vấn đề về chất lượng

- AI có thể hỗ trợ các công việc:

• Tạo bản nháp code

• Cập nhật code đơn giản

• Tự động hóa các tác vụ lặp lại

• Tổng hợp tài liệu code

• Cải thiện thời gian chu trình

- Những hạn chế của AI trong coding:

• Sử dụng thư viện lỗi thời

• Tạo ra lỗ hổng bảo mật

• Thiếu ngữ cảnh để đánh giá tính đúng đắn của code

• Chỉ dựa trên dữ liệu công khai có sẵn

- Các tổ chức cần:

• Đầu tư phát triển kỹ năng AI cho nhân viên

• Xây dựng chính sách sử dụng AI rõ ràng

• Đảm bảo AI chỉ là công cụ hỗ trợ, không phải thay thế hoàn toàn

📌 AI không thể thay thế hoàn toàn lập trình viên do 30,5% code AI tạo ra có vấn đề chất lượng. Tuy nhiên, AI đang giúp tăng năng suất thông qua việc tự động hóa các tác vụ đơn giản, cho phép lập trình viên tập trung vào các vấn đề phức tạp hơn.

https://www.forbes.com/councils/forbestechcouncil/2024/11/25/ai-is-not-stealing-jobs-it-is-supercharging-software-development/

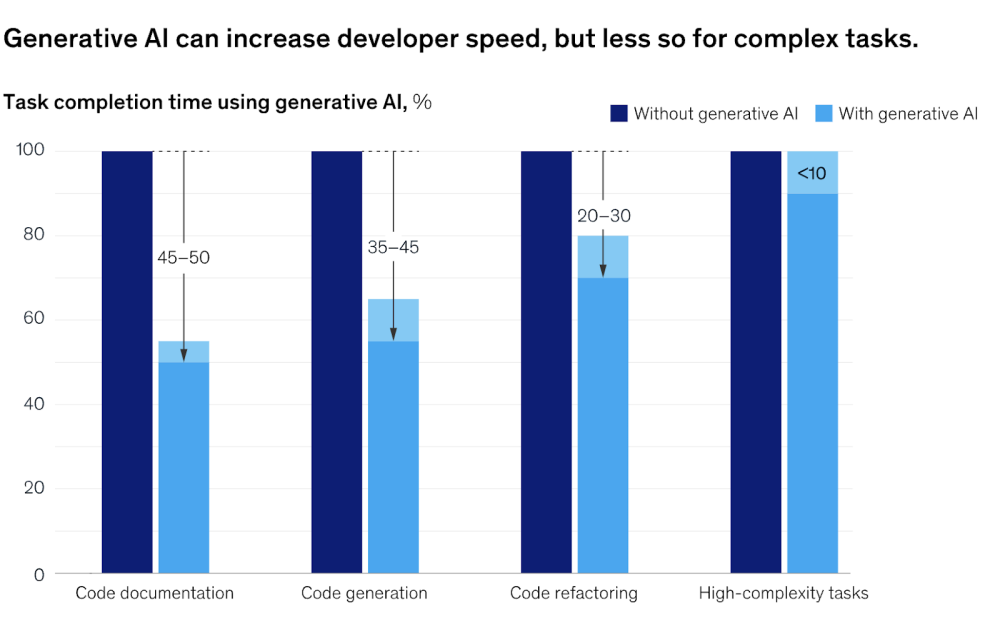

- Nghiên cứu từ Microsoft, MIT, Princeton và Đại học Pennsylvania phân tích 4.867 lập trình viên cho thấy công cụ gợi ý code bằng AI tạo sinh đã giúp:

+ Tăng 26% số lượng công việc hoàn thành hàng tuần

+ Tăng 14% số lần cập nhật code

+ Tăng 38% số lần biên dịch code

- AI tạo sinh hỗ trợ nhiều tác vụ phát triển:

+ Viết code mẫu và tài liệu

+ Tạo unit test

+ Thêm tính năng mới vào code hiện có

+ Chuyển đổi code sang ngôn ngữ lập trình mới

+ Tìm hiểu code cũ thiếu tài liệu

+ Xác định thư viện và framework phù hợp

- Hạn chế và rủi ro chính:

+ Lợi ích giảm dần với lập trình viên có nhiều kinh nghiệm

+ Có thể tạo code không an toàn hoặc không bảo mật

+ Tốc độ code tăng nhanh có thể vượt quá khả năng kiểm thử

+ Chất lượng code phụ thuộc vào dữ liệu huấn luyện

+ Rủi ro về sở hữu trí tuệ và vấn đề pháp lý

+ Khả năng không tương thích với hệ thống cũ

- Giải pháp đề xuất:

+ Cần có quy trình đánh giá đạo đức cho code từ AI

+ Tăng cường kiểm tra và bảo mật tự động

+ Thử nghiệm kỹ trong môi trường thử nghiệm

+ Xem xét kỹ các vấn đề về bản quyền

+ Thiết lập tiêu chuẩn quản trị cho việc tích hợp AI

📌 AI tạo sinh đang định hình lại ngành phát triển phần mềm với mức tăng năng suất 26%, nhưng đòi hỏi cân bằng giữa tự động hóa và giám sát con người. Các công ty cần chiến lược rõ ràng về đạo đức, pháp lý và bảo mật khi triển khai công cụ AI trong phát triển phần mềm.

https://www.zdnet.com/article/gen-ai-gives-software-developers-surge-in-productivity-but-its-not-for-everyone/

- Qwen 2.5 đạt hơn 40 triệu lượt tải và tạo ra hơn 50.000 mô hình phái sinh, trở thành lựa chọn hàng đầu cho phát triển AI Agent

- Một nhà phát triển trên Reddit báo cáo Qwen 2.5 14B vượt trội hơn GPT-4 và GPT-4o trong một số ứng dụng cụ thể nhờ khả năng gọi hàm, lập luận chuỗi suy nghĩ và thực hiện chỉ dẫn phức tạp

- Doanh nghiệp có thể triển khai Qwen 2.5 trong môi trường hoàn toàn cách ly với vLLM, đảm bảo không có kết nối bên ngoài

- Trên GPU 3090 tầm trung, mô hình đạt tốc độ 28 token/giây với ngữ cảnh 32K, phù hợp cho nhiều tình huống lập trình

- Công nghệ suy luận từng lớp của dự án AirLLM cho phép chạy mô hình 72B tham số trên hệ thống chỉ có 4GB VRAM

- Qwen 14B instruct hoạt động tốt với công cụ SQL và là mô hình duy nhất dưới 27B có thể sử dụng công cụ SQL hiệu quả

- Nhiều lập trình viên tích hợp thành công Qwen 2.5 vào môi trường phát triển thông qua Llama.cpp, LM Studio API và VSCodium

- Chi phí token của Qwen rẻ hơn nhiều so với GPT-4o (0,38 so với 5,0 USD/triệu token) và Claude 3.5 Sonnet (3,05 USD/triệu token)

- Một lập trình viên đã tạo game Pac-Man hoàn chỉnh bằng Python với mô hình 72B chạy local, vượt trội Claude chỉ tạo được bản đồ cơ bản

- Hạn chế: đôi khi phản hồi bằng tiếng Trung khi bối rối và cần prompt chính xác hơn cho tác vụ phức tạp

📌 Qwen 2.5 đang dẫn đầu cuộc đua AI Agent với 40 triệu lượt tải, chi phí thấp (0,38 USD/triệu token), khả năng chạy trên GPU phổ thông 4GB VRAM và hiệu suất vượt trội GPT-4 trong nhiều tác vụ lập trình.

https://analyticsindiamag.com/developers-corner/qwen-2-5-is-winning-the-ai-agents-race/

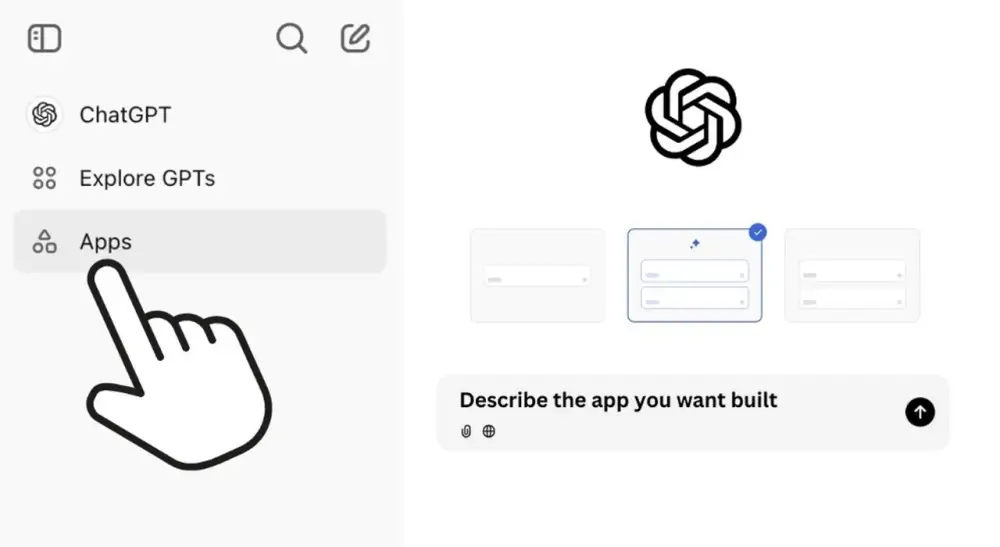

- Tiện ích mở rộng Ultra Chrome cho ChatGPT đã được phát triển bởi Vlad Holtz, giúp người dùng dễ dàng tạo ứng dụng thông qua đối thoại

- Quy trình phát triển ứng dụng bao gồm các bước:

+ Lên ý tưởng và tính năng ứng dụng

+ Phác thảo cấu trúc và giao diện người dùng

+ Viết mã HTML cho bố cục cơ bản

+ Thêm CSS để tạo kiểu và responsive

+ Triển khai JavaScript cho tính năng tương tác

+ Kiểm thử và hoàn thiện ứng dụng

- Các ví dụ ứng dụng có thể tạo:

+ Ứng dụng đếm từ với tính năng phân tích cảm xúc

+ Bảng điều khiển phân tích doanh số khóa học AI

+ Trò chơi Space Invaders

+ Công cụ quản lý công việc

- Tính năng nổi bật của tiện ích Ultra:

+ Luồng nhắc nhiều bước

+ Thư viện prompt có sẵn

+ Tích hợp ứng dụng web

+ Cải thiện khả năng hiểu ngữ cảnh

- So sánh với Claude AI:

+ ChatGPT phù hợp người mới với phương pháp từng bước

+ Claude thiên về lập trình tích hợp cho người dùng nâng cao

- Khả năng cải tiến liên tục:

+ Thêm tính năng mới

+ Tối ưu hiệu suất

+ Cập nhật theo phản hồi người dùng

+ Điều chỉnh theo nhu cầu thị trường

📌 Tiện ích Ultra Chrome biến ChatGPT thành công cụ phát triển ứng dụng toàn diện, phù hợp mọi đối tượng từ người mới đến chuyên gia. Người dùng có thể tạo đa dạng ứng dụng từ công cụ đếm từ đến trò chơi, với quy trình rõ ràng theo từng bước và khả năng cải tiến liên tục.

https://www.geeky-gadgets.com/you-can-now-create-apps-in-chatgpt/

- Hơn 25% mã nguồn mới tại Google được tạo ra bởi AI, sau đó được kỹ sư kiểm tra và chấp nhận

- Alphabet báo cáo doanh thu quý 3/2024:

+ Tổng doanh thu: 88,3 tỷ USD

+ Google Services (bao gồm Search): 76,5 tỷ USD, tăng 13% so với cùng kỳ

+ Google Cloud (bao gồm hạ tầng AI): 11,4 tỷ USD, tăng 35% so với cùng kỳ

- Thu nhập hoạt động:

+ Google Services: 30,9 tỷ USD, tăng từ 23,9 tỷ USD năm trước

+ Google Cloud: 1,95 tỷ USD, tăng mạnh từ 270 triệu USD năm trước

- Google tập trung phát triển nhiều tính năng AI:

+ Chatbot tùy chỉnh được hỗ trợ bởi Gemini (gọi là "Gems")

+ Tự động ghi chú bằng AI trong Google Meet

+ Công cụ AI tạo sinh hỗ trợ người sáng tạo YouTube

+ Dòng điện thoại Pixel 9 tích hợp nhiều công cụ AI

- Doanh thu quảng cáo và đăng ký YouTube vượt 50 tỷ USD trong 4 quý gần nhất

- Google đang đối mặt với thách thức pháp lý sau phán quyết tháng 8/2024 về độc quyền trong thị trường tìm kiếm và quảng cáo

📌 AI đang đóng vai trò then chốt trong hoạt động của Google, tạo ra 25% mã nguồn mới và góp phần vào doanh thu ấn tượng 88,3 tỷ USD trong quý 3/2024. Tuy nhiên, công ty đang đối mặt với nguy cơ bị chia tách sau phán quyết độc quyền.

https://www.theverge.com/2024/10/29/24282757/google-new-code-generated-ai-q3-2024

- Anthropic vừa ra mắt công cụ phân tích mới cho Claude chatbot, cho phép nó không chỉ viết mà còn chạy mã JavaScript, mang đến khả năng trả lời với độ chính xác toán học và khả năng tái tạo kết quả.

- Công cụ này đang ở giai đoạn thử nghiệm và được thiết kế như một sandbox tích hợp. Claude có thể thực hiện các phép tính phức tạp, phân tích dữ liệu từ tệp như bảng tính và PDF, và cung cấp kết quả dưới dạng hình ảnh tương tác.

- Claude giúp người dùng phân tích dữ liệu chính xác bằng cách làm sạch, khám phá và xử lý dữ liệu từng bước. Điều này giảm thiểu sai sót so với trước đây, khi Claude chỉ có thể thực hiện phân tích ở mức trừu tượng.

- Ví dụ ứng dụng thực tế bao gồm:

- Một quản lý sản phẩm tải lên dữ liệu bán hàng và yêu cầu phân tích hiệu suất theo từng quốc gia.

- Một kỹ sư tải dữ liệu tài chính hàng tháng để Claude tạo bảng điều khiển với các xu hướng chính.

- Anthropic nhấn mạnh rằng khả năng mới này nâng cấp trải nghiệm Claude, giúp nó có thể đưa ra câu trả lời được xác minh toán học — điều mà trước đây chưa thể làm được.

- Các đối thủ cạnh tranh cũng có tính năng tương tự, chẳng hạn:

- Google cung cấp tính năng Code Execution cho mô hình Gemini, cho phép chatbot viết và chạy mã Python để học từ kết quả.

- OpenAI cung cấp khả năng viết và thực thi mã thông qua Advanced Data Analysis.

- Công cụ phân tích của Claude hiện có sẵn cho tất cả người dùng trên web kể từ ngày 24/10/2024. Người dùng có thể kích hoạt tính năng này bằng cách đăng nhập vào Claude.ai và bật công cụ phân tích trực tiếp trên giao diện.

📌

Anthropic đã mở rộng khả năng của Claude với việc cho phép chatbot này viết và chạy mã JavaScript. Điều này giúp Claude phân tích dữ liệu chính xác hơn và tạo hình ảnh tương tác. Tính năng mới không chỉ tăng độ tin cậy của Claude mà còn mang lại sự tiện ích cho các lĩnh vực như quản lý sản phẩm và phân tích tài chính, cạnh tranh trực tiếp với các công cụ của Google và OpenAI.

https://techcrunch.com/2024/10/24/anthropics-ai-can-now-run-and-write-code/

• Theo dự báo, công cụ AI dành cho nhà phát triển có thể tăng năng suất lên 30%, tiềm năng đóng góp hơn 1,5 nghìn tỷ USD vào GDP toàn cầu.

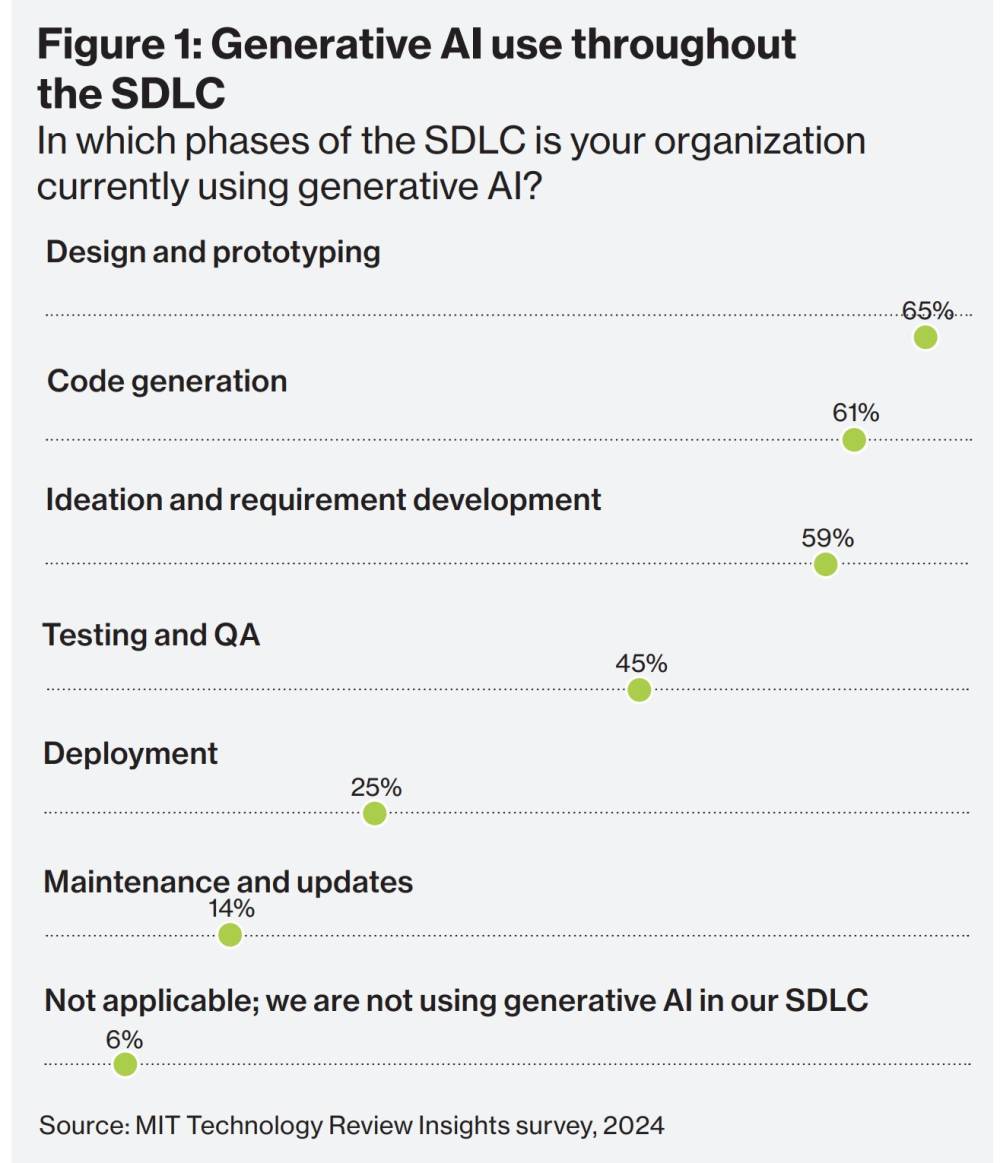

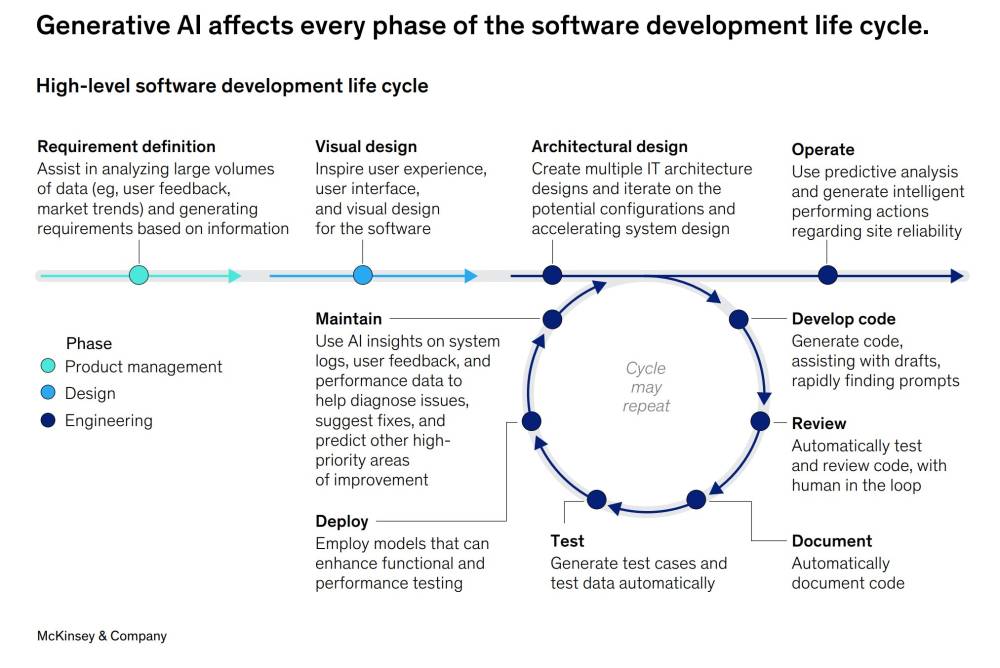

• Khảo sát của MIT Technology Review Insights với hơn 300 lãnh đạo doanh nghiệp về việc sử dụng AI tạo sinh trong chu trình phát triển phần mềm (SDLC).

• Chỉ 12% lãnh đạo cho rằng AI tạo sinh đã thay đổi căn bản cách họ phát triển phần mềm hiện nay. Tuy nhiên, 38% tin rằng nó sẽ thay đổi đáng kể SDLC trong 1-3 năm tới, 31% dự đoán điều này sẽ xảy ra trong 4-10 năm.

• 94% người được hỏi đang sử dụng AI tạo sinh cho phát triển phần mềm ở một mức độ nào đó. 20% mô tả nó là "phần được tích hợp tốt, đã được thiết lập" trong SDLC, 33% báo cáo nó "được sử dụng rộng rãi" trong ít nhất một phần của SDLC.

• 29% vẫn đang "tiến hành thử nghiệm nhỏ" hoặc áp dụng công nghệ này trên cơ sở từng nhân viên.

• 82% sử dụng AI tạo sinh trong ít nhất hai giai đoạn của SDLC, 26% sử dụng trong bốn giai đoạn trở lên.

• Các trường hợp sử dụng phổ biến bao gồm: thiết kế và tạo mẫu tính năng mới, hợp lý hóa phát triển yêu cầu, đẩy nhanh kiểm thử, cải thiện phát hiện lỗi và nâng cao chất lượng mã tổng thể.

• 46% cho biết AI tạo sinh đã đáp ứng kỳ vọng, 33% nói nó "vượt quá" hoặc "vượt xa" kỳ vọng.

• 49% lãnh đạo tin rằng các công cụ AI tiên tiến như trợ lý và agent sẽ dẫn đến tăng hiệu quả hoặc tiết kiệm chi phí. 20% tin rằng những công cụ này sẽ cải thiện thông lượng hoặc rút ngắn thời gian ra thị trường.

• Carolina Dolan Chandler, Giám đốc kỹ thuật số tại Globant, nhận xét: "Có sự tương đồng giữa những gì đang diễn ra với AI và khi chuyển đổi số lần đầu xảy ra. AI là một sự thay đổi toàn diện. Nó sẽ ảnh hưởng đến mọi vai trò công việc theo mọi cách. Nhưng đó sẽ là một quá trình lâu dài."

📌 AI tạo sinh đang nhanh chóng thâm nhập vào quy trình phát triển phần mềm, với 94% doanh nghiệp đã áp dụng ở một mức độ nào đó. Tuy nhiên, tiềm năng vẫn còn rất lớn, với 69% dự đoán những thay đổi đáng kể trong 10 năm tới. Các công cụ AI tiên tiến như agent được kỳ vọng sẽ mang lại những bước tiến quan trọng về hiệu quả và đổi mới.

https://www.technologyreview.com/2024/10/17/1105295/transforming-software-with-generative-ai/

#MIT

• Google Cloud giới thiệu Gemini Code Assist Enterprise, trước đây gọi là Duet AI, nhằm cạnh tranh với nền tảng lập trình doanh nghiệp của GitHub.

• Tính năng mới giúp lập trình viên code nhanh hơn bằng cách hiểu codebase của tổ chức, có cửa sổ ngữ cảnh lớn và cho phép tùy chỉnh.

• Giá sử dụng: 45 USD/tháng/người dùng hoặc 19 USD/tháng với đăng ký hàng năm.

• Nền tảng đưa ra gợi ý code dựa trên codebase cục bộ, giúp tạo hoặc chuyển đổi code phù hợp hơn với ứng dụng.

• Kết nối trực tiếp với các dịch vụ Google Cloud khác như Firebase, Databases, BigQuery, Colab Enterprise, Apigee và Application Integration.

• Tính năng tùy chỉnh code dựa trên thư viện nội bộ, hỗ trợ đánh chỉ mục thư viện GitHub và GitLab.

• Nhấn mạnh vào bảo mật cấp doanh nghiệp: không sử dụng dữ liệu khách hàng để huấn luyện mô hình Gemini, cho phép kiểm soát hoàn toàn các kho lưu trữ được đánh chỉ mục.

• Google cung cấp bồi thường pháp lý cho bất kỳ code nào được tạo bởi Gemini Code Assist Enterprise.

• Xu hướng trợ lý lập trình tập trung vào doanh nghiệp đang phát triển: GitHub Copilot Enterprise, Oracle's coding assistant, Harness.

• Việc Google tham gia thị trường nhấn mạnh sự cạnh tranh ngày càng tăng trong lĩnh vực trợ lý lập trình và nhu cầu về giải pháp dành riêng cho doanh nghiệp.

• Tích hợp trợ lý lập trình vào môi trường phát triển mang lại tính linh hoạt cho các công ty muốn cải thiện năng suất.

• Khả năng kiểm tra code nhanh chóng và sửa lỗi trên codebase cục bộ giúp công ty triển khai ứng dụng nhanh hơn.

📌 Google ra mắt Gemini Code Assist Enterprise, cạnh tranh trực tiếp với GitHub trong lĩnh vực trợ lý lập trình doanh nghiệp. Tính năng mới giúp lập trình viên code nhanh hơn, hiểu codebase tổ chức và tăng cường bảo mật với giá 45 USD/tháng/người dùng.

https://venturebeat.com/ai/googles-gemini-enterprise-coding-assistant-shows-enterprise-focused-coding-is-growing/

- Sự gia tăng công cụ lập trình AI trong hai năm qua đã thay đổi cách thức làm việc của lập trình viên.

- Các công cụ nổi bật như GitHub Copilot và Claude từ Anthropic đã trở thành xu hướng chính trong ngành.

- Sự phổ biến của các công cụ low-code và no-code đang biến đổi hoàn toàn bối cảnh phát triển phần mềm.

- Nhiều công cụ phát triển như Tower Git GUI có mức phí từ 69 đến 99 USD mỗi người mỗi năm, là khoản đầu tư nhỏ so với mức lương của lập trình viên.

- Tại Mỹ, lương của lập trình viên dao động từ 40.000 đến 150.000 USD mỗi năm, với mức trung bình khoảng 89.190 USD.

- Ở Ấn Độ, lương hàng năm dao động từ 1.2 đến 13 lakh INR (khoảng 1.500 đến 16.000 USD), với các lập trình viên toàn thời gian thường có chi phí từ 10.000 đến 25.000 USD mỗi năm.

- Đầu tư vào các công cụ này có thể mang lại lợi ích về năng suất lớn, nhanh chóng bù đắp chi phí.

- Subhojit Mondal, người sáng lập SACHI, cho rằng các công cụ này giúp nhiều người tạo ra giải pháp phần mềm mà không cần kỹ năng lập trình truyền thống.

- Thị trường việc làm phân hóa rõ rệt giữa các ứng viên: dưới trung bình, trung bình và xuất sắc; ứng viên xuất sắc có thể nhận được tăng lương đáng kể.

- Sumit Mansinghani từ PepsiCo cho rằng lương đang tiến gần đến điểm bão hòa, với áp lực kinh tế sẽ làm giảm mức tăng trong tương lai.

- Việc sử dụng AI trong lập trình giúp thu hẹp khoảng cách kinh nghiệm giữa các lập trình viên junior và senior.

- Các công ty công nghệ lớn đang dựa vào lập trình viên để cải thiện nền tảng của họ; trong khi đó, lãnh đạo các công ty không phải công nghệ tìm kiếm nhiều lập trình viên hơn để thúc đẩy chuyển đổi số.

- Khoảng 250 startup đang phát triển công cụ lập trình AI; theo khảo sát GitHub, hơn 97% trong số 2.000 người tham gia ở Mỹ, Brazil, Đức và Ấn Độ sử dụng công cụ AI tại nơi làm việc.

- Một nghiên cứu cho thấy các công cụ gợi ý mã AI có thể tăng năng suất lập trình viên lên tới 26%.

- Mặc dù có lợi ích, nhưng AI vẫn có những hạn chế; một khảo sát cho thấy chỉ 35% lập trình viên cảm thấy AI tiết kiệm được từ 10% đến 20% thời gian của họ.

- Nhiều chuyên gia lo ngại rằng sự gia tăng công nghệ AI sẽ dẫn đến mất việc làm cho một số vị trí thấp hơn trong ngành.

📌 Sự gia tăng công cụ lập trình AI đang thay đổi cách thức làm việc của lập trình viên và thị trường lao động. Mặc dù lương cao nhưng chi phí đầu tư vào công cụ thấp hơn nhiều so với lợi ích về năng suất mà chúng mang lại.

https://analyticsindiamag.com/ai-trends-future/coding-is-getting-cheaper-and-so-are-coders/

• OpenAI o1 được biết đến với khả năng suy luận xuất sắc, nhưng nhiều nhà phát triển báo cáo rằng các mô hình này không phải lựa chọn tốt nhất cho các tác vụ liên quan đến lập trình.

• Một nhà phát triển trên Hacker News cho biết mô hình o1-preview có hiện tượng ảo giác, đến mức bắt đầu phản hồi trong bối cảnh các thư viện và hàm không tồn tại.

• Khi so sánh nhiều mô hình AI tạo sinh trên LiveBench cho các bài kiểm tra hoàn thành mã, o1-mini xếp hạng thấp hơn mô hình nguồn mở Qwen2-72B và GPT-4.

• Thời gian phản hồi chậm là vấn đề lớn đối với các nhà phát triển làm việc với thời hạn. Nhiều người báo cáo rằng o1 thường bị kẹt sau giai đoạn suy nghĩ và không phản hồi.

• Mike Young đánh giá rằng thời gian phản hồi tăng trong giai đoạn suy nghĩ có thể là một trở ngại lớn, đặc biệt khi cần câu trả lời nhanh. Mô hình đôi khi bị kẹt ở chế độ suy nghĩ và không bao giờ trả lời - xảy ra khoảng 40% thời gian.

• Một người dùng Reddit chia sẻ trải nghiệm sử dụng o1 để xây dựng ứng dụng tệ hơn cả phiên bản miễn phí của ChatGPT.

• Dan McAteer, một nhà phát triển phần mềm, đề xuất sử dụng o1-mini làm kiến trúc sư cho dự án, tạo ra tài liệu thiết kế chi tiết với hướng dẫn từng bước cho mỗi module.

• McAteer sử dụng Claude Sonnet 3.5 làm nhà phát triển để tạo mã dựa trên tài liệu kiến trúc do o1-mini tạo ra.

• Sully Omar, đồng sáng lập và CEO của Cognosys, cũng đề cập rằng o1-mini hầu như vô dụng trong việc lập trình và thường bỏ sót các chi tiết nhỏ.

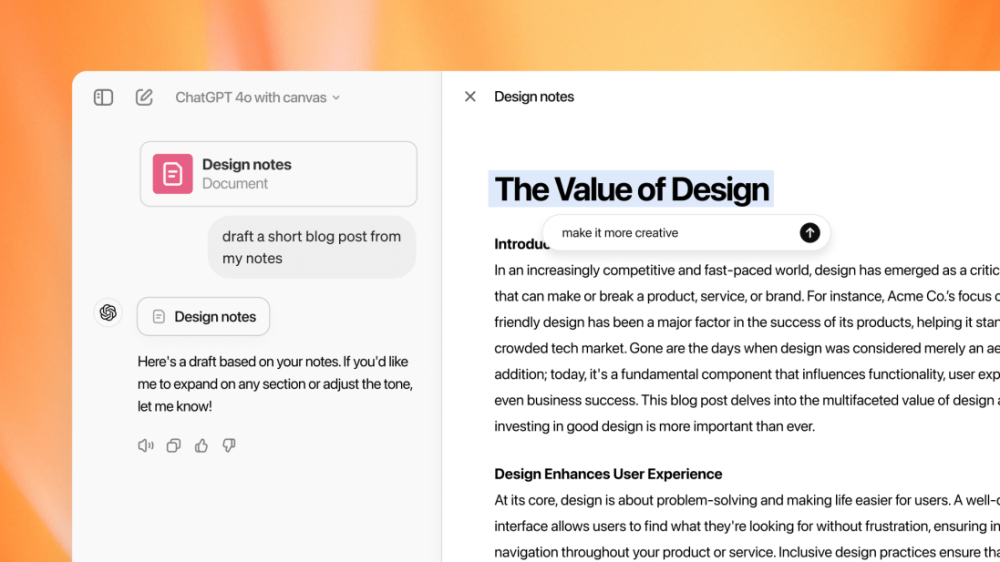

• OpenAI đã phát hành Canvas, một nền tảng lập trình sử dụng ChatGPT 4o thay vì các mô hình o1.

• Các mô hình o1 chủ yếu hướng đến suy luận. Đối với lập trình, những mô hình này có thể hữu ích trong việc thiết kế nền tảng, và sau đó, các mô hình như Sonnet có thể đảm nhận phần tạo mã.

📌 OpenAI o1 được đánh giá là kiến trúc sư AI hơn là lập trình viên, với khả năng suy luận tốt nhưng hiệu suất coding kém. Nhà phát triển đề xuất kết hợp o1 làm kiến trúc sư và Claude làm lập trình viên để tối ưu hóa quá trình phát triển phần mềm.

https://analyticsindiamag.com/developers-corner/why-openai-o1-sucks-at-coding/

• Cursor AI là một IDE mới được xây dựng từ đầu để hỗ trợ lập trình bằng AI, đang thay thế VS Code của Microsoft và được coi là trình soạn thảo mã AI thực sự

• Cursor là một nhánh của VS Code nên có giao diện quen thuộc, cho phép nhập các extension, theme và keybinding chỉ bằng một cú nhấp chuột

• Cung cấp mô hình AI riêng 'cursor-small' và hỗ trợ nhiều mô hình cao cấp từ OpenAI, Google và Anthropic như OpenAI o1, Claude 3.5 Sonnet, GPT-4, v.v.

• Cursor học từ codebase của người dùng và tạo embedding trên thiết bị để dự đoán chính xác lần chỉnh sửa tiếp theo. Người dùng có thể chọn chế độ riêng tư để không đào tạo dữ liệu

• Tính năng nổi bật là Composer, kích hoạt bằng Ctrl + K, cho phép nhập hướng dẫn bằng ngôn ngữ tự nhiên để tạo mã ngay lập tức

• Trong Composer, có thể sử dụng @ để gắn thẻ file, thư mục, liên kết web, codebase, Git và thêm hướng dẫn chi tiết về mục tiêu cần đạt được

• Cửa sổ chat (Ctrl + L) cho phép đặt câu hỏi, trò chuyện với codebase cục bộ và nhận gợi ý mã

• Cursor cũng cho phép debug mã bằng AI, tích hợp tốt trong môi trường và nhanh chóng đề xuất thay đổi trong cửa sổ Chat

• Cursor cung cấp 2 tuần dùng thử miễn phí bản Pro sử dụng Claude 3.5 Sonnet cho việc hoàn thành mã và các tác vụ khác

• Người dùng có thể thiết lập quy tắc cho trình soạn thảo AI bằng file .cursorrules cho từng repo, thậm chí định nghĩa quy tắc AI khác nhau cho các file cụ thể

📌 Cursor AI là IDE mới hứa hẹn thay thế VS Code với trợ lý AI tích hợp mạnh mẽ. Nó học từ codebase, hỗ trợ nhiều mô hình AI cao cấp và có tính năng Composer độc đáo cho phép tạo mã bằng ngôn ngữ tự nhiên. Với khả năng debug bằng AI, Cursor mang lại trải nghiệm lập trình AI toàn diện.

https://beebom.com/what-is-cursor-ai-editor/

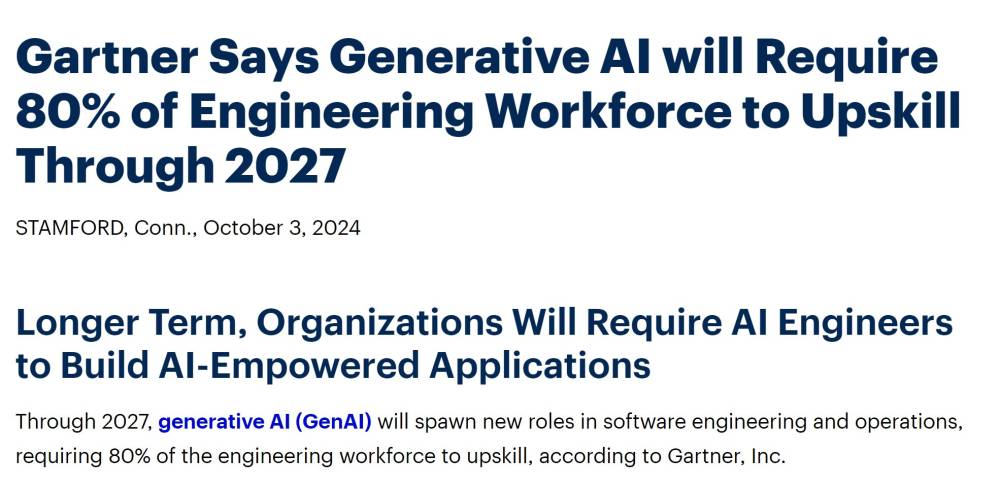

- Gartner dự báo AI sẽ đòi hỏi 80% lực lượng lao động kỹ sư phải nâng cao kỹ năng đến năm 2027, nhưng đây không phải toàn bộ câu chuyện.

- Việc nâng cao kỹ năng và học hỏi công nghệ mới là khía cạnh then chốt trong công việc của mọi kỹ sư phần mềm, không có gì đáng ngạc nhiên.

- Gartner mô tả 3 giai đoạn tác động của AI: ngắn hạn tăng năng suất khiêm tốn, trung hạn thay đổi quy trình làm việc, dài hạn cần nhiều kỹ sư phần mềm lành nghề hơn.

- Tuy nhiên, báo cáo của Gartner còn thiếu sót 4 khía cạnh quan trọng:

+ Sửa đổi mã để đáp ứng yêu cầu: Mỗi lần chạy đầu tiên sau khi viết mã luôn có lỗi. AI khó sửa đổi từng phần nhỏ theo yêu cầu.

+ Kiểm thử và kiểm soát chất lượng: Cần phát triển quy trình kiểm thử cho lập trình AI vì AI thường bị ảo giác và viết mã không chạy được. Dự án càng lớn, mã càng phức tạp thì càng cần nhiều lập trình viên.

+ Cập nhật và bảo trì trong suốt vòng đời: Sau khi phát hành, phần mềm cần sửa lỗi, cập nhật, tinh chỉnh hiệu suất liên tục, đây không phải việc AI có thể làm.

+ Khó bảo trì mã mình không viết: Bảo trì mã người khác viết (của người hay AI) rất tốn công phân tích cấu trúc, tài liệu hóa trước khi sửa. Mã AI có thể mâu thuẫn với phong cách viết mã tốt.

📌 Mặc dù AI giúp tiết kiệm thời gian lập trình đáng kể, nhưng mã của AI thường xuyên bị lỗi và mất nhiều công sức sửa chữa, đảo ngược kiến trúc, triển khai lại. Trong 10 năm tới, AI sẽ không thay thế được lập trình viên mà thậm chí còn tạo ra nhu cầu nhiều hơn cho kỹ năng lập trình để xử lý các khía cạnh logistics của dự án phần mềm như kiểm thử, bảo trì, duy trì mã nguồn.

https://www.zdnet.com/article/the-4-biggest-challenges-of-ai-generated-code-gartner-left-out-of-its-latest-report/

• Theo Gartner, đến năm 2027, AI tạo sinh sẽ tạo ra các vai trò mới trong kỹ thuật và vận hành phần mềm, đòi hỏi 80% lực lượng kỹ sư phải nâng cao kỹ năng.

• Philip Walsh, Chuyên gia Phân tích Cao cấp tại Gartner, khẳng định rằng mặc dù AI sẽ biến đổi vai trò của kỹ sư phần mềm trong tương lai, chuyên môn và sáng tạo của con người vẫn luôn cần thiết để tạo ra phần mềm phức tạp và đổi mới.

• Gartner dự đoán AI sẽ tác động đến vai trò kỹ sư phần mềm theo ba cách:

• Ngắn hạn: AI sẽ hoạt động trong giới hạn, tạo ra những cải thiện khiêm tốn về năng suất bằng cách bổ sung cho các mô hình và nhiệm vụ làm việc hiện có của nhà phát triển.

• Trung hạn: Sự xuất hiện của các agent AI sẽ mở rộng ranh giới, chuyển đổi mô hình làm việc của nhà phát triển bằng cách cho phép tự động hóa và chuyển giao nhiều nhiệm vụ hơn.

• Dài hạn: Tiến bộ trong AI sẽ phá vỡ ranh giới và đánh dấu sự trỗi dậy của kỹ thuật AI.

• Trong kỷ nguyên AI từ cốt lõi, kỹ sư phần mềm sẽ áp dụng tư duy "AI-first", tập trung chủ yếu vào việc định hướng các agent AI đến bối cảnh và ràng buộc phù hợp nhất cho một nhiệm vụ cụ thể.

• Kỹ năng kỹ thuật prompt bằng ngôn ngữ tự nhiên và tạo sinh được tăng cường bởi truy xuất dữ liệu ngoài sẽ trở nên thiết yếu đối với kỹ sư phần mềm.

• Mặc dù AI sẽ làm cho công việc kỹ thuật hiệu quả hơn, các tổ chức sẽ cần nhiều kỹ sư phần mềm lành nghề hơn để đáp ứng nhu cầu ngày càng tăng về phần mềm được tăng cường bởi AI.

• Kỹ sư AI sẽ là một loại chuyên gia phần mềm mới, sở hữu sự kết hợp độc đáo của kỹ năng trong kỹ thuật phần mềm, khoa học dữ liệu và AI/ML.

• Theo khảo sát của Gartner trong quý 4 năm 2023 tại 300 tổ chức ở Mỹ và Anh, 56% lãnh đạo kỹ thuật phần mềm đánh giá kỹ sư AI/ML là vai trò được yêu cầu nhiều nhất cho năm 2024.

• Để hỗ trợ kỹ sư AI, các tổ chức cần đầu tư vào nền tảng phát triển AI, giúp xây dựng khả năng AI hiệu quả hơn và tích hợp AI vào các giải pháp doanh nghiệp ở quy mô lớn.

• Việc đầu tư này sẽ đòi hỏi các tổ chức phải nâng cao kỹ năng của các nhóm kỹ thuật dữ liệu và kỹ thuật nền tảng để áp dụng các công cụ và quy trình thúc đẩy tích hợp và phát triển liên tục cho các artifact AI.

📌 Gartner dự báo 80% kỹ sư cần nâng cao kỹ năng AI tạo sinh đến 2027. Kỹ sư AI, kết hợp kỹ năng phần mềm, khoa học dữ liệu và AI/ML, sẽ là nghề hot. 56% lãnh đạo kỹ thuật xếp kỹ sư AI/ML là vai trò được yêu cầu nhiều nhất năm 2024.

https://www.gartner.com/en/newsroom/press-releases/2024-10-03-gartner-says-generative-ai-will-require-80-percent-of-engineering-workforce-to-upskill-through-2027

• OpenAI vừa giới thiệu giao diện mới cho ChatGPT có tên "Canvas", tạo ra một cửa sổ riêng biệt bên cạnh cửa sổ chat thông thường để làm việc với các dự án viết lách và lập trình.

• Canvas cho phép người dùng tạo văn bản hoặc code trực tiếp, sau đó có thể đánh dấu các phần để yêu cầu mô hình chỉnh sửa.

• Tính năng này đang được triển khai thử nghiệm cho người dùng ChatGPT Plus và Teams từ ngày 3/10, sẽ mở rộng cho người dùng Enterprise và Edu vào tuần tới.

• Giao diện mới của ChatGPT cung cấp các tính năng tương tự như Artifacts của Anthropic (ra mắt tháng 6) và công cụ hỗ trợ lập trình Cursor.

• Người dùng có thể yêu cầu ChatGPT tạo một email, sau đó điều chỉnh độ dài bằng thanh trượt, đánh dấu câu cụ thể để chỉnh sửa giọng điệu hoặc thêm emoji.