AI riêng tư

View All

- Các công ty công nghệ lớn như Google, Microsoft, Anthropic và OpenAI đang phát triển thế hệ chatbot mới gọi là "AI agent", có khả năng điều khiển máy tính thay người dùng

- Sam Altman, CEO OpenAI khẳng định AI agent có thể hoàn thành công việc cả tháng chỉ trong 1 giờ

- ChatGPT hiện có 300 triệu người dùng hàng tuần, đây là động lực để các công ty tìm cách phát triển công nghệ AI thiết yếu hơn nữa

- Google đang thử nghiệm agent Mariner có khả năng đặt hàng tạp hóa trực tuyến bằng cách đọc công thức nấu ăn và tự động thêm nguyên liệu vào giỏ hàng

- Anthropic cảnh báo AI agent đôi khi hiểu sai và thực hiện lệnh từ văn bản trên trang web, bất chấp chỉ dẫn của người dùng

- Chuyên gia bảo mật Johann Rehberger đã chứng minh lỗ hổng này bằng cách khiến AI agent tự động tải và chạy malware

- AI agent cần "nhìn thấy" màn hình máy tính qua screenshot và tải lên cloud để phân tích, tiềm ẩn rủi ro về quyền riêng tư

- Microsoft đã trì hoãn ra mắt tính năng Recall - cho phép tìm kiếm mọi hoạt động trên máy tính qua screenshot, sau khi nhận phản hồi về quyền riêng tư

- Corynne McSherry từ Electronic Frontier Foundation cảnh báo người dùng nên thận trọng vì các công ty công nghệ có thể sử dụng dữ liệu thu thập được để quảng cáo hoặc bán cho bên thứ ba

- Chuyên gia Yacine Jernite lo ngại AI agent trong môi trường làm việc có thể khiến nhân viên mất thời gian sửa lỗi và vô tình cung cấp dữ liệu để thay thế chính họ

📌 Năm 2025, AI agent sẽ là xu hướng công nghệ mới có khả năng tự động hóa nhiều tác vụ thay con người, tuy nhiên đặt ra thách thức lớn về quyền riêng tư và bảo mật khi chúng cần quyền truy cập sâu vào đời sống số của người dùng.

https://www.washingtonpost.com/technology/2025/01/05/agents-ai-chatbots-google-mariner/

Bước nhảy vọt tiếp theo của AI yêu cầu truy cập sâu vào đời sống số của bạn

Các giám đốc điều hành công nghệ đang quảng bá "các tác nhân AI" (AI agents), những trợ lý kỹ thuật số có thể thực hiện các tác vụ trên máy tính, như là bước phát triển lớn tiếp theo của trí tuệ nhân tạo.

Ngày 5 tháng 1, 2025, 7:35 sáng EST

Các công ty công nghệ đã tiên phong phát triển chatbot AI nay cho biết rằng các phiên bản mạnh mẽ hơn, được gọi là “tác nhân” (agents), sẽ giúp mọi người hoàn thành công việc.

SAN FRANCISCO — Các công ty công nghệ đang chạy đua để nâng cấp các chatbot như ChatGPT không chỉ để cung cấp câu trả lời mà còn để kiểm soát máy tính nhằm thực hiện hành động thay cho người dùng.

Các chuyên gia về trí tuệ nhân tạo và an ninh mạng cảnh báo rằng công nghệ này sẽ yêu cầu người dùng tiết lộ nhiều hơn về đời sống số của mình cho các tập đoàn, có thể gây ra các vấn đề mới về quyền riêng tư và bảo mật.

Trong vài tuần gần đây, các giám đốc điều hành từ các công ty AI hàng đầu bao gồm Google, Microsoft, Anthropic và OpenAI đều dự đoán rằng một thế hệ trợ lý kỹ thuật số mới được gọi là “tác nhân AI” sẽ hoàn toàn thay đổi cách mọi người tương tác với máy tính.

Họ cho rằng công nghệ này, dự kiến sẽ là trọng tâm lớn của ngành vào năm 2025, ban đầu sẽ tự động hóa các công việc nhàm chán như mua sắm trực tuyến hoặc nhập liệu và cuối cùng sẽ xử lý những công việc phức tạp mà con người phải mất hàng giờ để hoàn thành.

“Điều này sẽ là một thay đổi rất lớn đối với cách thế giới hoạt động trong thời gian ngắn,” Sam Altman, Giám đốc điều hành OpenAI, cho biết tại một sự kiện của công ty vào tháng 10. “Mọi người sẽ yêu cầu một tác nhân làm một việc gì đó mà trước đây phải mất cả tháng, và nó sẽ hoàn thành trong một giờ.”

OpenAI đã nói rằng các tác nhân sẽ được hưởng lợi từ công việc gần đây của họ trong việc làm cho phần mềm AI có khả năng suy luận tốt hơn. Vào tháng 12, công ty đã ra mắt một hệ thống có tên là O1, hiện có sẵn thông qua ChatGPT, với mục tiêu giải quyết các vấn đề theo từng giai đoạn.

Mặc dù ChatGPT một mình có 300 triệu người dùng hàng tuần, OpenAI và các đối thủ như Google và Microsoft cần tìm ra các cách mới để khiến công nghệ AI của mình trở nên thiết yếu. Các công ty công nghệ đã đầu tư hàng trăm tỷ đô la vào công nghệ này trong hai năm qua, một cam kết lớn mà các nhà phân tích phố Wall cảnh báo sẽ khó thu hồi vốn.

Một mục tiêu tham vọng của các công ty phát triển tác nhân AI là làm cho chúng tương tác với các phần mềm khác như con người, bằng cách hiểu giao diện trực quan và sau đó nhấp chuột hoặc nhập dữ liệu để hoàn thành tác vụ.

Các công ty AI đang ra mắt và thử nghiệm các phiên bản tác nhân có thể xử lý các tác vụ như mua sắm trực tuyến, đặt lịch hẹn với bác sĩ hoặc lọc và trả lời email. Salesforce và các nhà cung cấp phần mềm doanh nghiệp khác đã mời khách hàng của họ tạo các phiên bản giới hạn của tác nhân để thực hiện các công việc như chăm sóc khách hàng.

Trong một buổi trình diễn gần đây tại trụ sở của Google ở Mountain View, California, một tác nhân AI do phòng thí nghiệm DeepMind của công ty phát triển, có tên là Mariner, được giao một tài liệu chứa công thức nấu ăn và được yêu cầu mua nguyên liệu trực tuyến.

Mariner, xuất hiện dưới dạng thanh bên trong trình duyệt Chrome, đã điều hướng đến trang web của chuỗi cửa hàng tạp hóa Safeway. Từng mục một, tác nhân này tìm kiếm từng sản phẩm trong danh sách và thêm vào giỏ hàng trực tuyến, tạm dừng khi hoàn thành để hỏi xem người đặt nhiệm vụ có muốn nó hoàn tất giao dịch hay không.

Mariner hiện chưa có sẵn công khai và Google vẫn đang làm việc để làm cho nó hữu ích đồng thời cho phép con người duy trì quyền kiểm soát đối với một số hành động nhất định, như thanh toán.

“Nó đang thực hiện một số tác vụ rất tốt, nhưng chắc chắn còn nhiều cải tiến mà chúng tôi muốn thực hiện,” Jaclyn Konzelmann, giám đốc quản lý sản phẩm tại Google, nói khi trình diễn tác nhân này.

Tác nhân AI mang lại nhiều hứa hẹn lớn. Một bot có thể trả lời các email thông thường trong khi một người chăm sóc con cái hoặc thực hiện công việc quan trọng hơn có thể rất hữu ích với nhiều người, và các doanh nghiệp có thể tìm thấy vô số ứng dụng cho các trợ lý AI có thể lập kế hoạch và thực hiện các hành động phức tạp.

Tuy nhiên, ngay cả những lãnh đạo trong ngành công nghệ đang chạy đua phát triển tác nhân AI cũng thừa nhận rằng chúng mang lại những rủi ro mới.

“Khi bạn cho phép một mô hình AI làm điều gì đó như vậy, có rất nhiều thứ mà nó có thể làm,” Dario Amodei, giám đốc điều hành của Anthropic AI, nói tại một hội nghị của Viện An toàn AI Hoa Kỳ vào tháng 11. “Nó có thể nói mọi thứ thay mặt tôi, thực hiện hành động, tiêu tiền hoặc thay đổi trạng thái nội bộ của máy tính.”

AI’s next leap requires intimate access to your digital life

- Một cuộc khảo sát từ Cleveland Clinic cho thấy 1/5 người Mỹ đã hỏi AI về lời khuyên sức khỏe.

- Theo số liệu từ Tebra, khoảng 25% người Mỹ nghiêng về việc sử dụng chatbot thay vì tham gia các buổi tư vấn.

1. Không hỏi AI về lời khuyên y tế: Chatbot không tuân thủ quy định HIPAA nên không nên sử dụng để hỏi thông tin sức khỏe.

2. Tránh chia sẻ mật khẩu: Không cung cấp mật khẩu truy cập cho AI vì điều này có thể dẫn đến rủi ro bảo mật.

3. Không tiết lộ số điện thoại: Đừng cung cấp số điện thoại của bản thân hoặc người khác cho chatbot.

4. Không chia sẻ thông tin tài chính: Địa chỉ ngân hàng, số thẻ tín dụng và thông tin tài chính khác không nên được nhập vào hệ thống AI.

5. Tránh tiết lộ tên và địa chỉ: Thông tin nhận dạng cá nhân như tên và địa chỉ phải được giữ kín.

6. Không gửi thông tin nhạy cảm khác: Không chia sẻ câu trả lời cho các câu hỏi bảo mật hay thông tin cá nhân khác.

7. Không sử dụng AI cho tài liệu công việc: Tránh tải lên các tài liệu bí mật liên quan đến công ty hoặc dự án.

8. Không hỏi về nội dung trái phép: Hạn chế yêu cầu AI cung cấp thông tin về các hoạt động không hợp pháp hay nội dung khiêu dâm.

9. Không chia sẻ thông tin về người khác: Đừng đưa thông tin cá nhân của người khác vào các cuộc trò chuyện với AI.

10. Sử dụng từ “redacted”: Nếu cần hỏi thông tin cụ thể, hãy dùng ký hiệu hoặc từ “redacted” để thay thế cho thông tin nhạy cảm.

📌 Thông tin sức khỏe không nên được hỏi từ chatbot vì nguy cơ rò rỉ thông tin cá nhân. 25% người Mỹ thích sử dụng chatbot thay vì tư vấn, nhưng không nên chia sẻ dữ liệu nhạy cảm. Hãy sử dụng cẩn thận để bảo đảm an toàn thông tin.

https://nypost.com/2024/12/26/tech/why-you-should-never-ask-ai-medical-advice-and-9-other-things-to-avoid/

- Cơ quan bảo vệ dữ liệu Italy (Garante) phạt OpenAI 15 triệu euro (tương đương 16,2 triệu USD) sau cuộc điều tra về việc sử dụng dữ liệu cá nhân của ChatGPT

- Các vi phạm chính của OpenAI:

+ Xử lý dữ liệu cá nhân người dùng để huấn luyện ChatGPT mà không có cơ sở pháp lý đầy đủ

+ Vi phạm nguyên tắc minh bạch và nghĩa vụ thông tin đối với người dùng

+ Không có hệ thống xác minh độ tuổi phù hợp để ngăn trẻ em dưới 13 tuổi tiếp xúc nội dung không phù hợp

- OpenAI phải thực hiện chiến dịch truyền thông 6 tháng trên các phương tiện truyền thông Italy để nâng cao nhận thức về cách ChatGPT hoạt động và thu thập dữ liệu

- Garante từng tạm cấm ChatGPT tại Italy vào năm 2023 vì vi phạm quy định bảo vệ dữ liệu của EU

- OpenAI phản hồi:

+ Cho rằng mức phạt không tương xứng

+ Khẳng định số tiền phạt gấp 20 lần doanh thu của họ tại Italy trong thời gian vi phạm

+ Sẽ tiến hành kháng cáo quyết định này

- Theo quy định GDPR của EU, mức phạt tối đa có thể lên đến 20 triệu euro hoặc 4% doanh thu toàn cầu của công ty vi phạm

📌 Cơ quan quản lý Italy áp mức phạt kỷ lục 15 triệu euro với OpenAI vì vi phạm quyền riêng tư trong việc thu thập và xử lý dữ liệu người dùng ChatGPT. Vụ việc này đánh dấu một tiền lệ quan trọng trong việc giám sát AI tạo sinh tại châu Âu.

https://www.reuters.com/technology/italy-fines-openai-15-million-euros-over-privacy-rules-breach-2024-12-20/

• Ủy ban bảo vệ dữ liệu châu Âu (EDPB) vừa công bố ý kiến về cách các nhà phát triển AI có thể sử dụng dữ liệu cá nhân mà không vi phạm luật bảo mật của khối này[1].

• EDPB đưa ra hướng dẫn về 3 vấn đề chính:

- Xác định tính ẩn danh của mô hình AI

- Xem xét cơ sở pháp lý cho việc xử lý dữ liệu

- Đánh giá tính hợp pháp của các mô hình được huấn luyện trái phép[1].

• OpenAI đã gặp rắc rối với ChatGPT tại nhiều quốc gia châu Âu:

- Italy: Kết luận sơ bộ về vi phạm GDPR

- Ba Lan và Áo: Khiếu nại về cơ sở pháp lý xử lý dữ liệu và vấn đề ảo giác[1].

• Về tính ẩn danh của mô hình:

- Cần đánh giá từng trường hợp cụ thể

- Mô hình phải "rất khó có khả năng" nhận dạng cá nhân

- Cần áp dụng các biện pháp kỹ thuật như chọn lọc dữ liệu nguồn, lọc dữ liệu và áp dụng các phương pháp bảo vệ quyền riêng tư[1].

• Về cơ sở pháp lý "lợi ích chính đáng":

- Phải đáp ứng ba tiêu chí: mục đích hợp pháp, tính cần thiết và cân bằng quyền lợi

- Cần xem xét kỳ vọng hợp lý của chủ thể dữ liệu

- Có thể áp dụng biện pháp giảm thiểu rủi ro[1].

• Về mô hình được huấn luyện bất hợp pháp:

- Đánh giá theo từng trường hợp

- Có thể hợp pháp hóa nếu đảm bảo ẩn danh trong giai đoạn triển khai

- Cần thận trọng để tránh lạm dụng hệ thống[1].

📌 EDPB đặt ra khuôn khổ pháp lý chặt chẽ cho AI tạo sinh tại châu Âu, với mức phạt có thể lên tới 4% doanh thu toàn cầu. Các nhà phát triển AI phải chứng minh tính ẩn danh của mô hình và đảm bảo cơ sở pháp lý phù hợp cho việc xử lý dữ liệu cá nhân.

Citations:

[1] https://techcrunch.com/2024/12/18/eu-privacy-body-weighs-in-on-some-tricky-genai-lawfulness-questions/

Cơ quan Bảo vệ Dữ liệu EU cân nhắc các câu hỏi khó về tính hợp pháp của AI tạo sinh

Natasha Lomas

8:18 AM PST · Ngày 18 tháng 12 năm 2024

Ủy ban Bảo vệ Dữ liệu Châu Âu (EDPB) đã công bố ý kiến vào thứ Tư về cách các nhà phát triển AI có thể sử dụng dữ liệu cá nhân để phát triển và triển khai các mô hình AI, chẳng hạn như mô hình ngôn ngữ lớn (LLM), mà không vi phạm luật bảo mật của khối EU. Ủy ban đóng vai trò định hướng quan trọng trong việc áp dụng các luật này, cung cấp hướng dẫn hỗ trợ việc thực thi quy định, vì vậy các quan điểm của họ rất quan trọng.

Những vấn đề mà ý kiến của EDPB đề cập bao gồm liệu các mô hình AI có thể được coi là ẩn danh (điều này có nghĩa là luật bảo mật sẽ không áp dụng); liệu cơ sở pháp lý "lợi ích hợp pháp" có thể được sử dụng để xử lý dữ liệu cá nhân một cách hợp pháp trong quá trình phát triển và triển khai các mô hình AI (điều này có nghĩa là không cần tìm kiếm sự đồng ý của cá nhân); và liệu các mô hình AI được phát triển bằng dữ liệu xử lý bất hợp pháp có thể được triển khai hợp pháp hay không.

Vấn đề cơ sở pháp lý

Câu hỏi về cơ sở pháp lý nào phù hợp để đảm bảo các mô hình AI tuân thủ Quy định Bảo vệ Dữ liệu Chung (GDPR) vẫn là một vấn đề nóng bỏng. OpenAI từng gặp rắc rối khi ChatGPT bị cho là vi phạm GDPR. Không tuân thủ các quy định về bảo mật có thể dẫn đến mức phạt lên đến 4% doanh thu toàn cầu hàng năm hoặc yêu cầu thay đổi cách các công cụ AI hoạt động.

Năm ngoái, cơ quan bảo vệ dữ liệu của Ý phát hiện sơ bộ rằng chatbot của OpenAI vi phạm GDPR. Từ đó, các khiếu nại khác cũng đã được nộp ở Ba Lan và Áo, tập trung vào cơ sở pháp lý cho việc xử lý dữ liệu, xu hướng tạo ra thông tin sai và việc không thể sửa chữa thông tin sai lệch về cá nhân.

Những điểm chính trong ý kiến của EDPB

Tính ẩn danh của mô hình

EDPB xác định rằng mô hình AI chỉ có thể được coi là ẩn danh nếu "rất khó có khả năng" xác định danh tính cá nhân từ dữ liệu được sử dụng để tạo mô hình hoặc thông qua các truy vấn. Tuy nhiên, điều này phải được đánh giá "dựa trên từng trường hợp cụ thể."

Ý kiến cũng cung cấp một danh sách không đầy đủ các phương pháp mà nhà phát triển có thể sử dụng để đảm bảo tính ẩn danh, bao gồm:

- Chọn nguồn dữ liệu đào tạo để hạn chế thu thập dữ liệu cá nhân.

- Lọc dữ liệu trong giai đoạn chuẩn bị trước đào tạo.

- Áp dụng các kỹ thuật bảo vệ quyền riêng tư như differential privacy.

Lợi ích hợp pháp

Cơ sở pháp lý "lợi ích hợp pháp" có thể là lựa chọn hàng đầu của các nhà phát triển AI vì nó không yêu cầu sự đồng ý của từng cá nhân, điều không khả thi với khối lượng dữ liệu khổng lồ mà LLM sử dụng. Tuy nhiên, EDPB nhấn mạnh rằng cần có bài kiểm tra ba bước để xác định tính phù hợp của cơ sở này:

- Mục đích hợp pháp: Ví dụ, tạo mô hình AI hỗ trợ hội thoại hoặc cải thiện phát hiện mối đe dọa thông tin có thể được coi là mục đích hợp pháp.

- Tính cần thiết: Việc xử lý phải thực sự đạt được mục đích hợp pháp và không có cách nào ít xâm phạm hơn để đạt được điều đó.

- Cân bằng quyền lợi cá nhân: Xem xét tác động của việc xử lý dữ liệu đến quyền lợi cá nhân, bao gồm kỳ vọng hợp lý của họ và các biện pháp giảm thiểu rủi ro.

Mô hình được đào tạo bất hợp pháp

Một điểm nhấn quan trọng khác trong ý kiến là cách xử lý các mô hình AI được đào tạo trên dữ liệu bất hợp pháp. EDPB gợi ý rằng nếu dữ liệu cá nhân được ẩn danh trước khi triển khai mô hình, GDPR có thể không áp dụng cho hoạt động tiếp theo của mô hình. Tuy nhiên, các nhà nghiên cứu cảnh báo rằng cách tiếp cận này có thể tạo tiền lệ nguy hiểm, tiềm ẩn việc hợp pháp hóa việc thu thập dữ liệu không có cơ sở pháp lý.

Tác động đến ngành công nghệ

Ý kiến của EDPB cung cấp hướng dẫn quan trọng cho các cơ quan giám sát trong việc điều chỉnh AI tạo sinh, đồng thời đưa ra các tín hiệu cho các nhà phát triển về cách họ có thể thiết kế và phát triển để giảm thiểu rủi ro pháp lý. Tuy nhiên, EDPB cũng nhấn mạnh rằng sẽ không có giải pháp chung cho mọi trường hợp, và việc tuân thủ GDPR sẽ đòi hỏi sự điều chỉnh cẩn thận trong từng tình huống cụ thể.

- Gần đây xuất hiện nhiều lo ngại về việc Microsoft thu thập dữ liệu từ tài liệu Word và bảng tính Excel để huấn luyện hệ thống AI

- Microsoft đã giới thiệu tính năng Connected Experiences vào tháng 10, được kích hoạt mặc định trong menu Options với 3 tùy chọn:

+ Turn On Experiences That Analyze Your Content

+ Turn On Experiences That Download Online Content

+ Turn On All Connected Experiences

- Người phát ngôn Microsoft khẳng định:

+ Không sử dụng dữ liệu khách hàng từ Microsoft 365 để huấn luyện mô hình ngôn ngữ lớn

+ Connected Services không liên quan đến quá trình huấn luyện AI

+ Đây là tính năng tiêu chuẩn ngành nhằm kết nối internet để nâng cao năng suất

- Connected Experiences cung cấp các tính năng hữu ích:

+ Đề xuất thông tin và hình ảnh liên quan từ web khi soạn thảo

+ Hỗ trợ cộng tác thời gian thực và tích hợp lưu trữ đám mây

+ Công cụ Editor trong Word giúp kiểm tra ngữ pháp và văn phong

- Người dùng có thể tắt Connected Services bằng cách:

+ Mở menu File trong Word/Excel

+ Chọn Options > Trust Center > Trust Center Settings

+ Vào Privacy Options > Privacy Settings

+ Bỏ chọn 3 tùy chọn trong phần Connected Experiences

📌 Microsoft đã chính thức phủ nhận việc sử dụng dữ liệu người dùng từ Microsoft 365 để huấn luyện AI. Tính năng Connected Experiences chỉ nhằm cải thiện trải nghiệm người dùng thông qua kết nối internet và có thể dễ dàng tắt đi trong cài đặt.

https://www.howtogeek.com/is-microsoft-using-your-word-documents-to-train-ai/

- OpenAI đã tích hợp chức năng tìm kiếm vào ChatGPT, đánh dấu bước ngoặt trong cách tiếp cận thông tin của người dùng

- Lợi ích chính của tính năng mới:

* Tăng hiệu quả bằng cách kết hợp tìm kiếm và tạo nội dung trong một phiên

* Cung cấp thông tin cập nhật về thị trường tài chính, tin tức mới nhất

* Tổng hợp kết quả tìm kiếm có cấu trúc với các danh mục phụ

* Hỗ trợ ra quyết định nhanh hơn trong lĩnh vực tài chính, tìm việc

- Thay đổi cách tương tác với thông tin:

* Tạo trải nghiệm đối thoại động thay vì danh sách liên kết tĩnh

* Cho phép đào sâu, đặt câu hỏi và tinh chỉnh hiểu biết

* Tạo trải nghiệm học tập phong phú và hấp dẫn hơn

- Rủi ro và thách thức:

* Tập trung quyền kiểm soát thông tin vào một nền tảng

* Khả năng khai thác thời gian và dữ liệu người dùng

* Chuyển đổi sang mô hình trả phí

* Lo ngại về quyền riêng tư và đạo đức từ việc thu thập dữ liệu

* Nguy cơ lan truyền nội dung thiên lệch hoặc sai lệch

- Giải pháp đề xuất:

* Thiết lập quy định rõ ràng về xử lý dữ liệu

* Đảm bảo minh bạch về cách sử dụng thông tin

* Duy trì tiêu chuẩn nghiêm ngặt về độ chính xác

* Người dùng cần hiểu rõ chính sách dữ liệu

📌 Tính năng tìm kiếm mới của ChatGPT mang lại hiệu quả cao nhưng cũng tiềm ẩn rủi ro về quyền riêng tư và kiểm soát thông tin. Cần có khung pháp lý chặt chẽ và minh bạch trong xử lý dữ liệu để cân bằng giữa tiến bộ công nghệ và bảo vệ người dùng.

https://www.forbes.com/sites/geruiwang/2024/11/02/chatgpts-new-search-function-efficiency-clashes-with-exploitations/

• LinkedIn đã tạm dừng thu thập dữ liệu người dùng Hong Kong cho mô hình AI tạo sinh sau khi cơ quan giám sát quyền riêng tư của thành phố bày tỏ lo ngại.

• Văn phòng ủy viên bảo vệ dữ liệu cá nhân (PCPD) cho biết LinkedIn đã phản hồi các câu hỏi về cài đặt mặc định cho phép thu thập dữ liệu người dùng Hong Kong để đào tạo các mô hình AI.

• LinkedIn xác nhận đã tạm dừng sử dụng dữ liệu cá nhân của người dùng Hong Kong cho mục đích này từ ngày 11/10/2024.

• Trước đó vào tháng 9, LinkedIn đã cập nhật chính sách quyền riêng tư, cho phép mặc định sử dụng dữ liệu và nội dung của người dùng để đào tạo AI tạo sinh của nền tảng.

• Người dùng phải tự tắt tùy chọn này trong cài đặt tài khoản nếu không muốn chia sẻ thông tin.

• Công ty đã tạm dừng thu thập dữ liệu người dùng Anh vào tháng trước sau khi cơ quan quản lý quyền riêng tư của nước này bày tỏ lo ngại tương tự.

• Francis Fong Po-kiu, chủ tịch danh dự của Liên đoàn công nghệ thông tin Hong Kong, cảnh báo về nguy cơ rò rỉ dữ liệu người dùng khi các công ty công nghệ thu thập thông tin để đào tạo mô hình AI.

• Ông đặt câu hỏi về cách che giấu dữ liệu cá nhân và liệu có thông tin nào bị rò rỉ trong quá trình này không.

• Fong cho rằng việc sử dụng tính năng AI tạo sinh trên các nền tảng mạng xã hội là xu hướng ngày càng phổ biến, khiến các cơ quan quản lý quyền riêng tư ngày càng lo ngại về an toàn dữ liệu cá nhân trực tuyến.

• Người phát ngôn của LinkedIn cho biết công ty luôn sử dụng một số hình thức tự động hóa cho các sản phẩm và minh bạch với người dùng về lựa chọn và việc sử dụng dữ liệu của họ.

• LinkedIn tin rằng người dùng nên có khả năng kiểm soát dữ liệu của mình, vì vậy họ đang cung cấp tùy chọn từ chối đào tạo mô hình AI ở các quốc gia thực hiện việc này.

• Công ty cho biết nhu cầu về các công cụ hỗ trợ viết bằng AI là rất cao.

• Việc sử dụng dữ liệu thành viên cho mô hình AI tạo sinh đã bị dừng ở Khu vực kinh tế châu Âu, Vương quốc Anh, Thụy Sĩ, Hong Kong và Trung Quốc đại lục.

📌 LinkedIn đã tạm dừng thu thập dữ liệu người dùng Hong Kong cho AI tạo sinh từ 11/10/2024 sau khi cơ quan giám sát quyền riêng tư bày tỏ lo ngại. Công ty cam kết minh bạch và cho phép người dùng kiểm soát dữ liệu, đồng thời đã dừng thu thập dữ liệu ở nhiều khu vực khác như châu Âu và Trung Quốc.

https://www.scmp.com/news/hong-kong/society/article/3282452/linkedin-suspends-collecting-hong-kong-users-data-genai-privacy-watchdog

• Meta vừa bổ sung tính năng AI mới cho kính Ray-Ban Meta, cho phép người dùng sử dụng camera trên kính để nhận thông tin về môi trường xung quanh và ghi nhớ vị trí đỗ xe.

• Kính Ray-Ban Meta giờ đây hỗ trợ quay video cho mục đích AI, cung cấp "trợ giúp liên tục theo thời gian thực".

• Khi được hỏi liệu Meta có sử dụng hình ảnh thu thập từ kính để huấn luyện mô hình AI hay không, công ty từ chối trả lời rõ ràng.

• Anuj Kumar, giám đốc cấp cao phụ trách AI wearables của Meta, nói rằng họ không công khai thảo luận về vấn đề này.

• Một phát ngôn viên khác của Meta cho biết đây không phải là thông tin họ thường chia sẻ ra bên ngoài.

• Việc Meta không đưa ra câu trả lời rõ ràng "không" gợi ý rằng công ty có thể đang có kế hoạch sử dụng hình ảnh từ kính để huấn luyện AI.

• Meta đã huấn luyện AI của mình trên các hình ảnh và story được đăng công khai trên Instagram và Facebook, coi đó là dữ liệu công khai.

• Tuy nhiên, dữ liệu thu thập từ kính Ray-Ban Meta dành riêng để tương tác với AI không giống như hình ảnh đăng công khai trên Instagram.

• Các tính năng AI mới trên kính sẽ chụp nhiều hình ảnh thụ động để cung cấp cho AI trả lời câu hỏi về môi trường xung quanh người đeo.

• Ví dụ, khi hỏi kính giúp chọn trang phục, hàng chục hình ảnh bên trong nhà người đeo sẽ được chụp và tải lên đám mây.

• Trước đây, kính Ray-Ban Meta chủ yếu được sử dụng để chụp ảnh và quay video một cách chủ động, người dùng biết rõ khi nào họ đang chụp.

• Với AI, người dùng không giữ lại những hình ảnh này vì chúng được thu thập chỉ để tương tác với trợ lý AI.

• Meta không xác nhận rõ ràng điều gì xảy ra với hình ảnh từ kính được tải lên máy chủ đám mây để sử dụng AI.

• Người dùng kính Ray-Ban Meta nên nhận thức rằng sử dụng các tính năng AI mới có thể dẫn đến việc Meta thu thập hàng trăm ảnh riêng tư mà họ không có ý định hoặc không biết là đang chia sẻ.

• Nếu Meta thực sự không sử dụng kính Ray-Ban Meta theo cách này, công ty nên tuyên bố rõ ràng để khách hàng biết chính xác những gì đang được chia sẻ với Meta và được sử dụng cho mục đích gì.

📌 Meta từ chối xác nhận việc sử dụng hình ảnh từ kính Ray-Ban Meta để huấn luyện AI, gây lo ngại về quyền riêng tư. Tính năng AI mới có thể thu thập hàng trăm ảnh cá nhân mà người dùng không biết. Meta cần minh bạch hơn về cách xử lý dữ liệu này.

https://www.macrumors.com/2024/10/01/meta-ray-bans-ai-training/

• OpenAI gần đây phản đối dự luật của California nhằm thiết lập các tiêu chuẩn an toàn cơ bản cho các nhà phát triển mô hình AI lớn, trái ngược với lập trường ủng hộ quy định AI trước đây của CEO Sam Altman.

• Công ty đã có nhiều động thái cho thấy nhu cầu ngày càng tăng về việc thu thập dữ liệu, bao gồm cả dữ liệu liên quan đến hành vi trực tuyến, tương tác cá nhân và sức khỏe.

• OpenAI đã ký kết nhiều thỏa thuận hợp tác với các công ty truyền thông lớn như Time, Financial Times, Axel Springer, Le Monde, Prisa Media và Condé Nast. Điều này có thể cho phép OpenAI tiếp cận lượng lớn nội dung và phân tích hành vi người dùng.

• Công ty đã đầu tư vào startup webcam Opal, có thể dẫn đến việc thu thập dữ liệu sinh trắc học nhạy cảm như biểu cảm khuôn mặt.

• OpenAI và Thrive Global đã ra mắt Thrive AI Health, một dự án sử dụng AI để cá nhân hóa và mở rộng quy mô thay đổi hành vi trong lĩnh vực sức khỏe.

• Sam Altman, CEO của OpenAI, cũng liên quan đến WorldCoin - một dự án tiền điện tử gây tranh cãi sử dụng quét mống mắt để nhận dạng sinh trắc học. WorldCoin tuyên bố đã quét mống mắt của hơn 6,5 triệu người trên gần 40 quốc gia.

• Các mô hình AI hiện tại như GPT-4 chủ yếu được đào tạo trên dữ liệu công khai từ internet. Tuy nhiên, các mô hình trong tương lai sẽ cần nhiều dữ liệu hơn và việc thu thập dữ liệu đang trở nên khó khăn hơn.

• Việc tập trung kiểm soát nhiều loại dữ liệu có thể cho phép OpenAI có ảnh hưởng đáng kể đến người dùng trong cả lĩnh vực cá nhân và công cộng.

• Lịch sử gần đây của OpenAI không giúp giảm bớt lo ngại về an toàn và quyền riêng tư. Việc Sam Altman bị loại bỏ tạm thời khỏi vị trí CEO vào tháng 11/2023, được cho là do xung đột nội bộ về định hướng chiến lược của công ty.

• Altman được biết đến là người ủng hộ mạnh mẽ việc thương mại hóa và triển khai nhanh chóng các công nghệ AI, thường ưu tiên tăng trưởng và thâm nhập thị trường hơn là các biện pháp an toàn.

• Việc OpenAI gần đây phản đối dự luật California cho thấy một xu hướng đáng lo ngại về thái độ chống lại quy định của công ty.

📌 OpenAI đang mở rộng thu thập dữ liệu qua các thỏa thuận truyền thông và đầu tư vào công nghệ sinh trắc học, gây lo ngại về quyền riêng tư. Công ty phản đối quy định AI ở California, ưu tiên tăng trưởng hơn an toàn. Việc tập trung kiểm soát dữ liệu có thể cho phép OpenAI có ảnh hưởng lớn đến người dùng.

https://theconversation.com/openais-data-hunger-raises-privacy-concerns-237448

• LinkedIn vừa tiết lộ đang sử dụng dữ liệu người dùng để huấn luyện các mô hình AI của mình mà không có sự đồng ý rõ ràng từ người dùng.

• Dữ liệu được sử dụng bao gồm thông tin trang cá nhân, bài đăng và các nội dung khác trên LinkedIn.

• LinkedIn khẳng định không gửi dữ liệu người dùng cho OpenAI, nhưng có sử dụng các mô hình của OpenAI thông qua dịch vụ Azure AI của Microsoft.

• Hiện tại, các chính sách của LinkedIn như Điều khoản Trang, Thỏa thuận Người dùng, Chính sách Quyền riêng tư và Chính sách Bản quyền không đề cập đến AI.

• LinkedIn đang cập nhật Thỏa thuận Người dùng và Chính sách Quyền riêng tư để công khai việc sử dụng dữ liệu cho AI.

• Người dùng EU được tự động loại trừ khỏi việc thu thập dữ liệu cho AI "cho đến khi có thông báo mới".

• Một số người dùng cho rằng Microsoft nên trả tiền cho việc khai thác dữ liệu của họ trên LinkedIn.

• Người dùng có thể tắt cài đặt này bằng cách vào Cài đặt > Quyền riêng tư dữ liệu > Dữ liệu để cải thiện AI tạo sinh.

• LinkedIn thuộc sở hữu của Microsoft, công ty có mối quan hệ tài chính chặt chẽ với OpenAI.

• Chính sách hiện tại của LinkedIn cấm người dùng sử dụng phần mềm, thiết bị, script hoặc robot để thu thập dữ liệu từ nền tảng.

• LinkedIn cũng cấm người dùng bán hoặc kiếm lợi từ bất kỳ dữ liệu nào được đăng tải trên nền tảng.

• Việc sử dụng dữ liệu cho AI đã gây ra tranh cãi, với một số người dùng kêu gọi tắt tính năng này ngay lập tức.

• Ido Banai, CEO của VectorField, cho rằng người dùng nên được trả tiền mỗi khi dữ liệu của họ được sử dụng để huấn luyện máy học.

📌 LinkedIn đang âm thầm sử dụng dữ liệu người dùng để huấn luyện AI mà không có sự đồng ý rõ ràng. Người dùng EU được bảo vệ tốt hơn, trong khi những người khác cần chủ động tắt cài đặt này. Vấn đề này làm dấy lên tranh cãi về quyền riêng tư và bồi thường cho việc sử dụng dữ liệu cá nhân trong thời đại AI.

https://www.pcmag.com/news/linkedin-is-quietly-training-ai-on-your-data-heres-how-to-stop-it

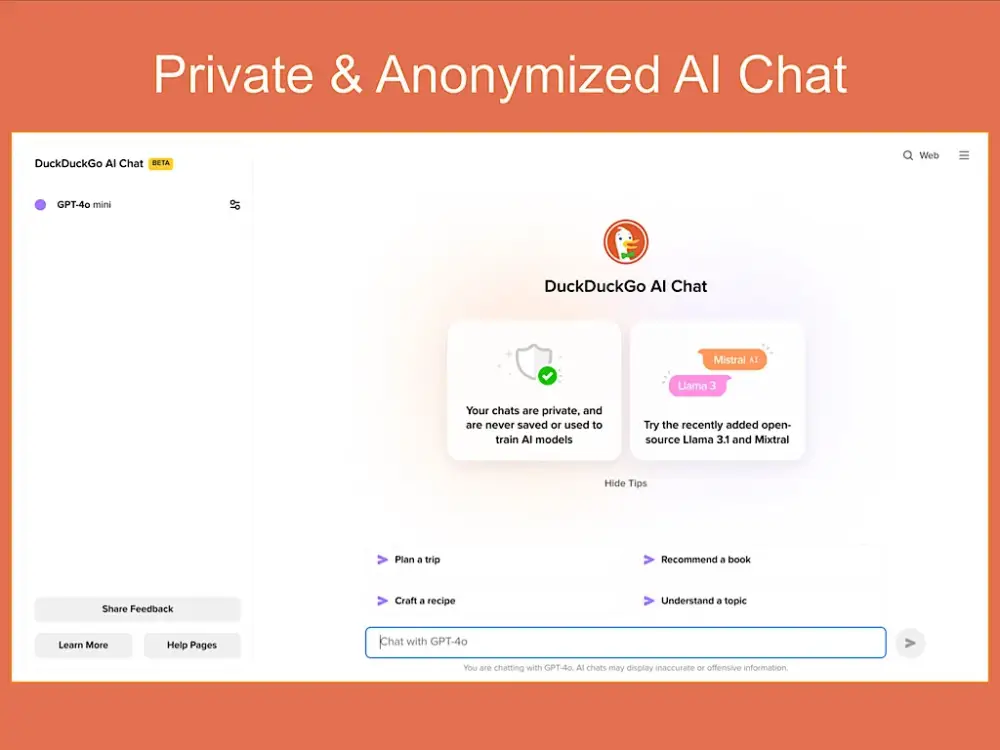

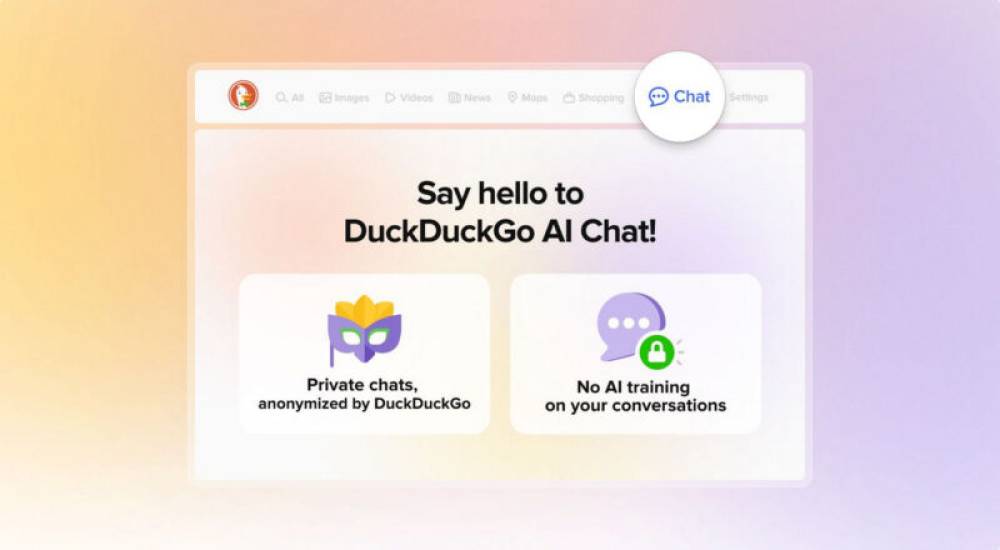

- DuckDuckGo đã ra mắt dịch vụ AI Chat miễn phí và ẩn danh vào tháng 6 năm 2024.

- Dịch vụ này cho phép người dùng tương tác với 4 mô hình ngôn ngữ lớn khác nhau mà không cần tạo tài khoản hay cung cấp thông tin cá nhân.

- Các mô hình AI Chat bao gồm: GPT-4o mini từ OpenAI, Claude 3 Haiku từ Anthropic, Llama 3.1 70B từ Meta và Mixtral 8x7B từ Mistral AI.

- DuckDuckGo cam kết không sử dụng thông tin người dùng để huấn luyện các mô hình AI, đảm bảo quyền riêng tư cho người dùng.

- Để bắt đầu sử dụng AI Chat, người dùng chỉ cần truy cập trang web duck.ai hoặc duckduckgo.com/chat và chọn mô hình chat mong muốn.

- Người dùng có thể chuyển đổi giữa các mô hình khác nhau để so sánh phản hồi và tìm ra lựa chọn phù hợp nhất cho nhu cầu của mình.

- DuckDuckGo cũng cung cấp tính năng chuyển đổi từ tìm kiếm sang AI Chat thông qua các lệnh bang như !ai hoặc !chat.

- Người dùng có thể sao chép phản hồi từ AI Chat vào clipboard của thiết bị để lưu trữ hoặc chia sẻ.

- Một số hạn chế của AI Chat là không có khả năng truy cập nội dung internet hiện tại; người dùng nên sử dụng tìm kiếm tiêu chuẩn cho thông tin mới nhất.

- DuckDuckGo khuyến nghị một số lựa chọn thay thế như OpenAI’s ChatGPT, Microsoft’s Copilot và Google’s Gemini cho những ai cần thông tin cập nhật hơn.

📌 DuckDuckGo đã giới thiệu dịch vụ AI Chat miễn phí với tính năng ẩn danh, cho phép người dùng tương tác với bốn mô hình ngôn ngữ lớn mà không cần lo lắng về quyền riêng tư. Dịch vụ này mở ra nhiều lựa chọn cho việc tìm kiếm thông tin an toàn và hiệu quả.

https://www.techrepublic.com/article/duckduckgo-joins-ai-chat/

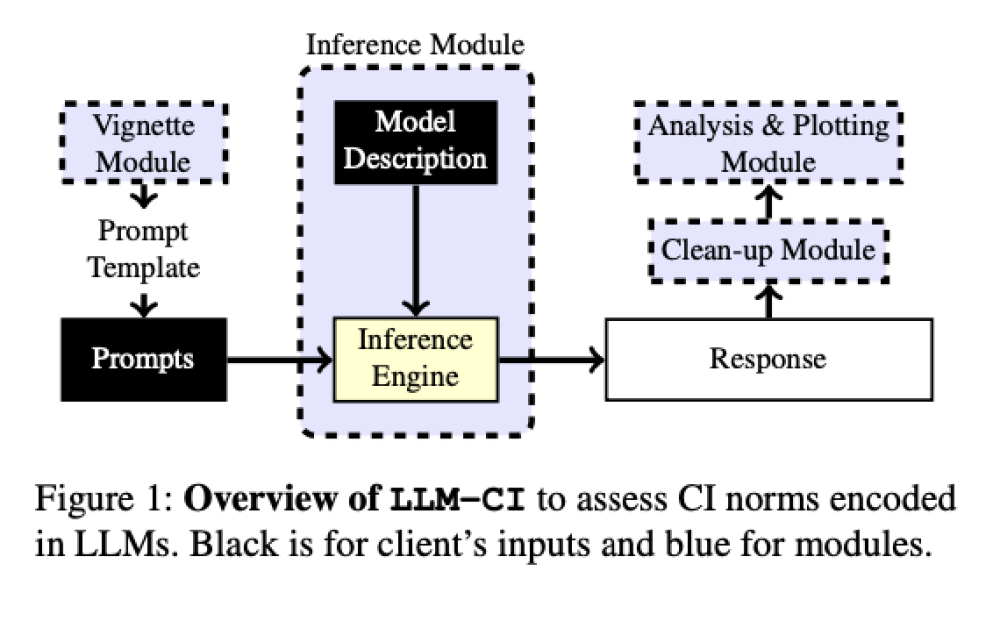

• Các mô hình ngôn ngữ lớn (LLM) đang được triển khai rộng rãi trong các hệ thống kỹ thuật-xã hội như y tế và giáo dục, nhưng thường mã hóa các chuẩn mực xã hội từ dữ liệu huấn luyện, gây lo ngại về sự phù hợp với kỳ vọng về quyền riêng tư và hành vi đạo đức.

• Thách thức chính là đảm bảo các mô hình này tuân thủ chuẩn mực xã hội trong các bối cảnh, kiến trúc mô hình và bộ dữ liệu khác nhau. Độ nhạy cảm với lời nhắc - khi thay đổi nhỏ trong lời nhắc dẫn đến phản hồi khác nhau - làm phức tạp việc đánh giá.

• Các phương pháp truyền thống tập trung vào khả năng kỹ thuật như độ trôi chảy và độ chính xác, bỏ qua việc mã hóa chuẩn mực xã hội. Một số cách tiếp cận cố gắng đánh giá chuẩn mực riêng tư bằng lời nhắc hoặc bộ dữ liệu cụ thể, nhưng thường không tính đến độ nhạy cảm với lời nhắc.

• Một nhóm nghiên cứu từ Đại học York và Đại học Waterloo giới thiệu LLM-CI, một khung mới dựa trên lý thuyết Tính toàn vẹn theo ngữ cảnh (CI) để đánh giá cách LLM mã hóa chuẩn mực riêng tư trong các bối cảnh khác nhau.

• LLM-CI sử dụng chiến lược đánh giá đa lời nhắc để giảm thiểu độ nhạy cảm với lời nhắc, chọn các lời nhắc tạo ra đầu ra nhất quán trên các biến thể khác nhau. Phương pháp này cũng kết hợp các tình huống thực tế đại diện cho các tình huống nhạy cảm về quyền riêng tư.

• Khung này được thử nghiệm trên các bộ dữ liệu như tình huống IoT và COPPA, mô phỏng các kịch bản riêng tư trong thế giới thực. Đánh giá cũng xem xét ảnh hưởng của siêu tham số và kỹ thuật tối ưu hóa đối với việc tuân thủ chuẩn mực.

• LLM-CI cho thấy cải thiện đáng kể trong việc đánh giá cách LLM mã hóa chuẩn mực riêng tư. Các mô hình được tối ưu hóa bằng kỹ thuật điều chỉnh đạt độ chính xác theo ngữ cảnh lên đến 92% trong việc tuân thủ chuẩn mực riêng tư.

• Phương pháp đánh giá mới dẫn đến tăng 15% tính nhất quán trong phản hồi, xác nhận rằng việc điều chỉnh các thuộc tính mô hình như dung lượng và áp dụng chiến lược điều chỉnh cải thiện đáng kể khả năng của LLM trong việc phù hợp với kỳ vọng của xã hội.

• LLM-CI cung cấp cách tiếp cận toàn diện và mạnh mẽ để đánh giá cách LLM mã hóa chuẩn mực riêng tư bằng cách tận dụng phương pháp đánh giá đa lời nhắc. Nó đại diện cho bước tiến quan trọng hướng tới việc triển khai có đạo đức LLM trong các ứng dụng thực tế.

📌 LLM-CI cải thiện đáng kể việc đánh giá chuẩn mực riêng tư trong AI bằng phương pháp đa lời nhắc. Độ chính xác theo ngữ cảnh đạt 92%, tăng 15% tính nhất quán phản hồi. Đây là bước tiến quan trọng hướng tới triển khai AI có đạo đức trong thực tế.

https://www.marktechpost.com/2024/09/13/llm-ci-a-new-machine-learning-framework-to-assess-privacy-norms-encoded-in-llms/

• Meta xác nhận sẽ khởi động lại kế hoạch sử dụng bài đăng công khai trên Facebook và Instagram của người dùng Anh để huấn luyện hệ thống AI của mình.

• Công ty tuyên bố đã "kết hợp phản hồi từ cơ quan quản lý" vào cách tiếp cận "từ chối tham gia" đã được sửa đổi để "minh bạch hơn nữa".

• Meta cho rằng việc này sẽ giúp các mô hình AI tạo sinh của họ "phản ánh văn hóa, lịch sử và thành ngữ của Anh".

• Từ tuần tới, người dùng Anh sẽ bắt đầu thấy thông báo trong ứng dụng giải thích về kế hoạch này. Meta dự định bắt đầu sử dụng nội dung công khai để huấn luyện AI trong những tháng tới.

• Động thái này diễn ra 3 tháng sau khi Meta tạm dừng kế hoạch do áp lực từ cơ quan quản lý ở Anh, với Văn phòng Ủy viên Thông tin (ICO) nêu lo ngại về cách Meta có thể sử dụng dữ liệu người dùng Anh.

• Ủy ban Bảo vệ Dữ liệu Ireland, cơ quan quản lý quyền riêng tư chính của Meta tại EU, cũng phản đối kế hoạch của Meta. Chưa rõ khi nào Meta sẽ khởi động lại nỗ lực huấn luyện AI ở EU.

• Meta đã sử dụng nội dung do người dùng tạo ra ở các thị trường như Mỹ để tăng cường AI, nhưng các quy định về quyền riêng tư toàn diện của châu Âu đã tạo ra thách thức.

• Trước đó vào tháng 5, Meta bắt đầu thông báo cho người dùng ở châu Âu về thay đổi chính sách quyền riêng tư sắp tới, nói rằng họ sẽ bắt đầu sử dụng nội dung từ bình luận, tương tác với công ty, cập nhật trạng thái, ảnh và chú thích đi kèm để huấn luyện AI.

• Tổ chức phi lợi nhuận về quyền riêng tư noyb đã đệ đơn khiếu nại với các quốc gia thành viên EU, cho rằng Meta vi phạm nhiều khía cạnh của Quy định Bảo vệ Dữ liệu Chung (GDPR) của EU.

• Meta vẫn giữ cách tiếp cận "từ chối tham gia" thay vì "chọn tham gia", khiến người dùng phải chủ động từ chối việc sử dụng thông tin của họ. Công ty nói rằng họ dựa vào cơ sở pháp lý "lợi ích hợp pháp" trong GDPR.

• Meta tuyên bố đã đơn giản hóa biểu mẫu từ chối lần này, kết hợp phản hồi từ ICO. Tuy nhiên, công ty chưa giải thích cụ thể cách thức đơn giản hóa.

• ICO cho biết sẽ "theo dõi tình hình" khi Meta tiến hành kế hoạch sử dụng dữ liệu của Anh để huấn luyện mô hình AI.

📌 Meta tiếp tục kế hoạch sử dụng dữ liệu người dùng Anh để huấn luyện AI, bất chấp lo ngại về quyền riêng tư. Công ty tuyên bố đã cải thiện tính minh bạch và quy trình từ chối, nhưng vẫn giữ cách tiếp cận "từ chối tham gia" gây tranh cãi. ICO sẽ giám sát chặt chẽ việc tuân thủ luật bảo vệ dữ liệu của Meta.

https://techcrunch.com/2024/09/13/meta-reignites-plans-to-train-ai-using-uk-users-public-facebook-and-instagram-posts/

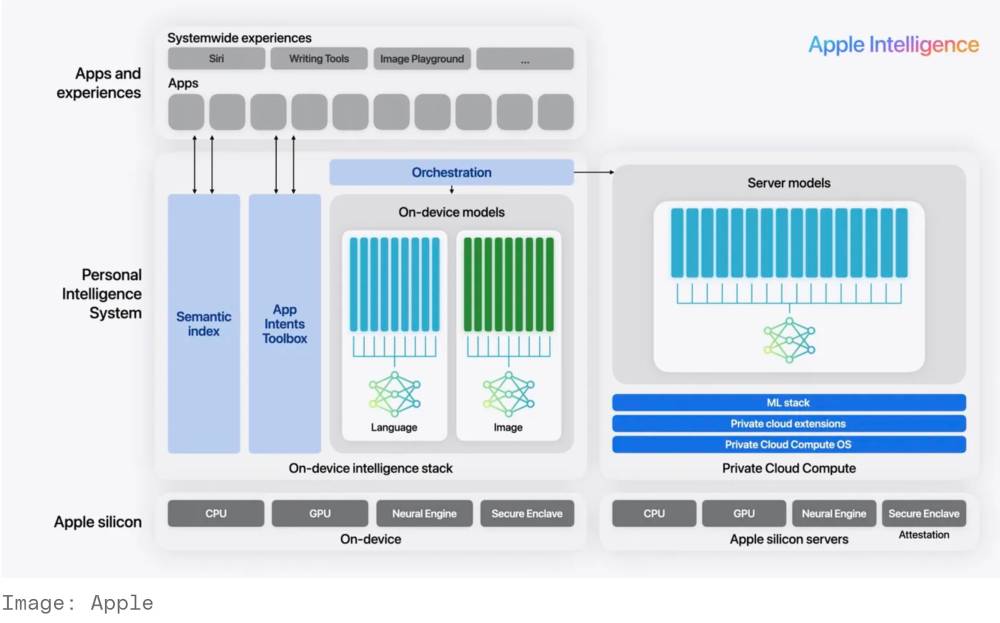

- Apple đã giới thiệu Private Cloud Compute (PCC) trong iOS 18 và macOS Sequoia, nhằm bảo vệ quyền riêng tư của người dùng.

- PCC cho phép xử lý dữ liệu trên đám mây mà không làm lộ thông tin cá nhân, tạo ra một "bong bóng quyền riêng tư" cho người dùng.

- Craig Federighi, phó giám đốc phần mềm của Apple, cho biết PCC là một bước đột phá trong việc bảo vệ dữ liệu trong môi trường đám mây.

- Hệ thống này sử dụng công nghệ mã hóa và quản lý khóa mạnh mẽ, đảm bảo rằng dữ liệu không bao giờ rời khỏi thiết bị của người dùng.

- PCC không có bộ nhớ lưu trữ lâu dài, giúp ngăn chặn việc lưu giữ dữ liệu sau khi xử lý.

- Các máy chủ PCC được thiết kế đặc biệt, sử dụng phần mềm và phần cứng bảo mật đã được Apple phát triển trong 20 năm qua.

- Hệ thống này không cho phép quyền truy cập đặc quyền và hạn chế quản lý từ xa, nhằm ngăn chặn các cuộc tấn công.

- Apple cam kết thực hiện nhiều xử lý AI trên thiết bị cá nhân, nhưng vẫn cần sử dụng đám mây cho một số tác vụ.

- PCC bao gồm cơ chế kiểm toán bên ngoài, cho phép công chúng kiểm tra tính chính xác và bảo mật của hệ thống.

- Apple đã ghi lại tất cả các máy chủ PCC vào một nhật ký chứng thực mã hóa, đảm bảo tính minh bạch và ngăn chặn các hành vi xấu.

- Hệ thống này đã được thử nghiệm và chưa phát hiện lỗi nào từ khi ra mắt bản beta.

- Apple cũng đang mở rộng khả năng của Apple Intelligence sang nhiều quốc gia và ngôn ngữ khác nhau, bao gồm cả hỗ trợ cho tiếng Trung, tiếng Pháp, tiếng Nhật và tiếng Tây Ban Nha trong năm tới.

📌 Apple đã phát triển Private Cloud Compute (PCC) để bảo vệ quyền riêng tư người dùng trong AI tạo sinh, với khả năng xử lý dữ liệu an toàn mà không phơi nhiễm thông tin cá nhân. Hệ thống này đã nhận được phản hồi tích cực và đang được mở rộng ra nhiều thị trường.

https://www.wired.com/story/apple-private-cloud-compute-ai/

- Ủy ban Bảo vệ Dữ liệu Ireland (DPC) đã mở cuộc điều tra xem Google có tuân thủ luật riêng tư của EU khi phát triển mô hình AI PaLM 2 hay không. Cuộc điều tra tập trung vào việc Google có thực hiện Đánh giá Tác động Bảo vệ Dữ liệu trước khi xử lý dữ liệu cá nhân của công dân EU liên quan đến việc phát triển mô hình này hay không.

- DPC cho biết Đánh giá Tác động Bảo vệ Dữ liệu là vô cùng quan trọng để đảm bảo quyền và tự do cơ bản của cá nhân được xem xét và bảo vệ thích đáng khi xử lý dữ liệu cá nhân có khả năng gây ra rủi ro cao.

- Cuộc điều tra này là một phần trong nỗ lực rộng lớn hơn của DPC, phối hợp với các cơ quan quản lý ngang hàng của EU/EEA, nhằm quản lý việc xử lý dữ liệu cá nhân của công dân EU/EEA trong quá trình phát triển các mô hình và hệ thống AI.

- Trước đó, Meta đã tạm dừng kế hoạch sử dụng dữ liệu cá nhân để huấn luyện mô hình AI sau khi DPC nêu lo ngại. Meta cũng thông báo sẽ không triển khai các mô hình AI đa phương thức trong tương lai tại EU do "tính không thể đoán trước" của môi trường quản lý châu Âu.

📌 Ủy ban Bảo vệ Dữ liệu Ireland điều tra Google về việc tuân thủ luật riêng tư EU khi phát triển mô hình AI PaLM 2, đồng thời cảnh báo Đánh giá Tác động Bảo vệ Dữ liệu là vô cùng quan trọng. Cuộc điều tra là một phần nỗ lực quản lý xử lý dữ liệu cá nhân trong AI của DPC và các cơ quan quản lý EU. Động thái này diễn ra sau khi Meta tạm dừng kế hoạch huấn luyện AI và không triển khai mô hình đa phương thức tại EU do lo ngại về quy định.

https://www.rte.ie/news/business/2024/0912/1469621-data-watchdog-google-ai/

• Ủy ban Bảo vệ Dữ liệu Ireland (DPC) đã kết thúc thủ tục tòa án liên quan đến việc X xử lý dữ liệu người dùng để đào tạo chatbot AI Grok.

• DPC sẽ xem xét các khiếu nại được đệ trình theo Quy định Bảo vệ Dữ liệu Chung (GDPR) của EU và có thể áp dụng các biện pháp trừng phạt nếu phát hiện vi phạm.

• X đã đồng ý ngừng xử lý dữ liệu cho việc đào tạo Grok vào đầu tháng 8/2024 và cam kết xóa dữ liệu người dùng châu Âu thu thập từ 7/5/2024 đến 1/8/2024.

• Tuy nhiên, X không bị yêu cầu xóa các mô hình AI đã được đào tạo bằng dữ liệu này.

• Các hình phạt theo GDPR có thể lên tới 4% doanh thu hàng năm toàn cầu. Với doanh thu của X đang sụt giảm mạnh, mức phạt này có thể gây tổn thất lớn.

• Các nhà quản lý cũng có quyền yêu cầu thay đổi hoạt động để chấm dứt vi phạm, nhưng quá trình điều tra và thực thi có thể kéo dài nhiều năm.

• Vẫn chưa rõ liệu GDPR có thể yêu cầu xóa mô hình AI được đào tạo bằng dữ liệu xử lý bất hợp pháp hay không.

• Các công cụ AI tạo sinh như Grok có nguy cơ tạo ra thông tin sai lệch, đe dọa quyền và tự do cơ bản của người dùng.

• Giám đốc đối ngoại toàn cầu của X, Nick Pickles, đã rời công ty sau 10 năm làm việc.

• X đang đối mặt với nhiều thách thức khác như bị cấm ở Brazil, chỉ trích ở Anh về vai trò trong việc lan truyền thông tin sai lệch, và điều tra theo khung quản lý nội dung của EU.

📌 X đối mặt nguy cơ bị phạt nặng vì sử dụng trái phép dữ liệu người dùng châu Âu cho AI Grok. Mặc đã ngừng thu thập, X vẫn có thể dùng mô hình AI đã đào tạo. Vụ việc đặt ra thách thức cho việc quản lý AI tạo sinh theo GDPR.

https://techcrunch.com/2024/09/06/elon-musks-x-could-still-face-sanctions-for-training-grok-on-europeans-data/

• Cơ quan bảo vệ dữ liệu Hà Lan (AP) đã phạt Clearview AI 30,5 triệu euro (khoảng 33,7 triệu USD) vì vi phạm nhiều quy định của GDPR.

• Đây là mức phạt lớn nhất mà Clearview AI phải đối mặt tại châu Âu, vượt qua các khoản phạt trước đó tại Pháp, Ý, Hy Lạp và Anh vào năm 2022.

• AP cảnh báo sẽ áp dụng thêm khoản phạt lên đến 5,1 triệu euro nếu Clearview tiếp tục không tuân thủ, nâng tổng mức phạt có thể lên tới 35,6 triệu euro.

• Cuộc điều tra bắt đầu vào tháng 3/2023 sau khi nhận được khiếu nại từ 3 cá nhân về việc Clearview không đáp ứng yêu cầu truy cập dữ liệu.

• Các vi phạm chính của Clearview bao gồm: xây dựng cơ sở dữ liệu sinh trắc học mà không có cơ sở pháp lý hợp lệ, không minh bạch và không thông báo cho các cá nhân có dữ liệu bị thu thập.

• Clearview AI đã xây dựng cơ sở dữ liệu 30 tỷ hình ảnh bằng cách thu thập ảnh selfie của người dùng trên internet mà không được sự đồng ý.

• Công ty không thể kháng cáo quyết định này vì đã không phản đối trong quá trình điều tra.

• AP cảnh báo sẽ xử phạt nặng bất kỳ tổ chức Hà Lan nào sử dụng dịch vụ của Clearview AI.

• Clearview AI vẫn tiếp tục vi phạm GDPR và chưa thay đổi hành vi bất chấp các khoản phạt trước đó tại châu Âu.

• AP đang xem xét khả năng truy cứu trách nhiệm cá nhân đối với lãnh đạo Clearview để buộc công ty tuân thủ luật pháp.

• Việc xử phạt cá nhân lãnh đạo có thể hiệu quả hơn trong việc thúc đẩy tuân thủ, vì họ có thể muốn đi lại tự do trong EU.

📌 Clearview AI bị phạt kỷ lục 30,5 triệu euro tại Hà Lan vì vi phạm GDPR nghiêm trọng. Cơ quan bảo vệ dữ liệu Hà Lan đang xem xét truy cứu trách nhiệm cá nhân lãnh đạo công ty để buộc tuân thủ, với tổng mức phạt có thể lên tới 35,6 triệu euro nếu tiếp tục vi phạm.

https://techcrunch.com/2024/09/03/clearview-ai-hit-with-its-largest-gdpr-fine-yet-as-dutch-regulator-considers-holding-execs-personally-liable/

• Hiện có hơn 25 vụ kiện bản quyền đang chờ xét xử chống lại các công ty AI.

• Vụ Thomson Reuters kiện ROSS Intelligence bị hoãn ngay trước ngày xét xử. Đây có thể là vụ kiện tiên phong tạo tiền lệ cho các vụ khác.

• Vụ kiện tập thể Sarah Andersen chống lại Stability AI cáo buộc công ty này sử dụng tác phẩm của nghệ sĩ mà không được phép để huấn luyện AI tạo hình ảnh.

• Getty Images kiện Stability AI vì sử dụng hơn 12 triệu ảnh trong thư viện của họ mà không có giấy phép để huấn luyện hệ thống AI Stable Diffusion.

• Vụ kiện Zhang chống Google cáo buộc công ty sử dụng tác phẩm có bản quyền để huấn luyện công cụ AI tạo hình ảnh từ văn bản.

• Meta bị kiện trong vụ Richard Kadrey vì cáo buộc vi phạm bản quyền khi sử dụng sách để huấn luyện mô hình LLaMa.

• OpenAI đối mặt với vụ kiện tương tự từ Sarah Silverman và các tác giả khác liên quan đến ChatGPT.

• Anthropic bị kiện bởi các nhà văn và nhà báo vì cáo buộc sử dụng tác phẩm của họ để huấn luyện chatbot Claude.

• Nvidia bị kiện vì cáo buộc sử dụng 196.640 cuốn sách để huấn luyện nền tảng AI NeMo.

• Các công ty âm nhạc lớn kiện Anthropic vì sử dụng lời bài hát trái phép để huấn luyện Claude.

• Tổ chức Authors Guild cùng các tác giả nổi tiếng như John Grisham, George R.R. Martin kiện OpenAI và Microsoft.

• New York Times kiện Microsoft và OpenAI vì sử dụng hàng triệu bài báo có bản quyền để huấn luyện mô hình GPT.

• Các vụ kiện về quyền riêng tư cáo buộc OpenAI và Google thu thập dữ liệu người dùng trái phép.

• Elon Musk kiện Sam Altman và OpenAI vì không giữ đúng lời hứa phát triển công nghệ nguồn mở.

📌 Hơn 25 vụ kiện bản quyền và quyền riêng tư đang chờ xét xử chống lại các công ty AI lớn như OpenAI, Meta và Google. Các vụ kiện tập trung vào việc sử dụng nội dung có bản quyền để huấn luyện AI và thu thập dữ liệu người dùng trái phép, với sự tham gia của nhiều tổ chức lớn như Getty Images, New York Times và Authors Guild.

https://www.fastcompany.com/91179905/openai-anthropic-and-meta-tracking-the-lawsuits-filed-against-the-major-ai-companies

- Các bản ghi công khai như hồ sơ tòa án, khai báo tài chính chứa nhiều thông tin cá nhân nhạy cảm và có thể không chính xác, ví dụ như tội nói dối trong các vụ ly hôn.

- Việc sử dụng dữ liệu này để phân tích tâm lý học hoặc đánh giá rủi ro tài chính có thể ảnh hưởng bất công đến cơ hội việc làm, nhà ở của những người liên quan.

- Dữ liệu cá nhân có thể bị lạm dụng bởi những kẻ lừa đảo hoặc chính phủ đàn áp.

- Các mô hình AI thường là hộp đen, khó giải thích quyết định và cá nhân ít có quyền kiểm soát dữ liệu của mình một khi đã vào mô hình.

- Cần có các quy định pháp lý hạn chế thu thập, sử dụng và lưu trữ dữ liệu cá nhân, đặc biệt là trong bối cảnh máy tính lượng tử, AI tạo sinh và tin tặc ngày càng tinh vi.

📌 Các bản ghi công khai chứa nhiều thông tin cá nhân nhạy cảm và thiên lệch, không nên được sử dụng để huấn luyện hệ thống AI vì nhiều rủi ro về quyền riêng tư, an ninh và công bằng. Cần có các quy định pháp lý nghiêm ngặt hạn chế việc này.

https://thehill.com/opinion/technology/4820294-ai-data-public-records-privacy/

• X (trước đây là Twitter) đã đồng ý không sử dụng dữ liệu cá nhân thu thập từ người dùng EU để huấn luyện hệ thống AI của mình, trước khi người dùng có quyền từ chối.

• Ủy ban Bảo vệ Dữ liệu Ireland (DPC) đã yêu cầu tòa án đình chỉ hoặc hạn chế X xử lý dữ liệu người dùng cho mục đích phát triển, huấn luyện hoặc tinh chỉnh hệ thống AI.

• X cho biết họ cho phép tất cả người dùng quyết định liệu bài đăng công khai của họ có thể được sử dụng bởi chatbot AI Grok hay không, bằng cách bỏ chọn một ô trong cài đặt quyền riêng tư.

• Tuy nhiên, Thẩm phán Leonie Reynolds chỉ ra rằng X đã bắt đầu xử lý dữ liệu người dùng EU để huấn luyện AI từ ngày 7/5, nhưng chỉ cung cấp tùy chọn từ chối từ ngày 16/7. Tính năng này cũng không được triển khai ngay cho tất cả người dùng.

• Luật sư của X cho biết dữ liệu thu thập từ người dùng EU trong khoảng thời gian từ 7/5 đến 1/8 sẽ không được sử dụng cho đến khi tòa án quyết định về lệnh đình chỉ của DPC.

• X phản đối lệnh đình chỉ, cho rằng nó "không có căn cứ, quá rộng và nhắm vào X mà không có lý do chính đáng".

• Quyết định của X diễn ra sau khi Meta trì hoãn ra mắt các mô hình AI ở châu Âu, và Google cũng đồng ý trì hoãn và thay đổi chatbot AI Gemini sau khi tham vấn với cơ quan quản lý Ireland.

• Các luật sư của X sẽ nộp hồ sơ phản đối lệnh đình chỉ trước ngày 4/9.

📌 X đồng ý tạm dừng sử dụng dữ liệu người dùng EU để huấn luyện AI, sau yêu cầu của cơ quan quản lý Ireland. Quyết định này phản ánh xu hướng thắt chặt quy định về AI ở châu Âu, ảnh hưởng đến cả Meta và Google. X phải nộp phản đối trước 4/9.

https://www.reuters.com/technology/artificial-intelligence/x-agrees-not-use-some-eu-user-data-train-ai-chatbot-2024-08-08/

• Michal Kosinski, nhà tâm lý học tại Đại học Stanford, tuyên bố AI của ông có thể phát hiện trí thông minh, xu hướng tình dục và quan điểm chính trị của một người chỉ bằng cách quét khuôn mặt với độ chính xác cao.

• Trong một nghiên cứu năm 2021, Kosinski đã phát triển một mô hình nhận diện khuôn mặt có thể dự đoán chính xác niềm tin chính trị của một người với độ chính xác 72% chỉ bằng cách quét ảnh khuôn mặt, so với tỷ lệ chính xác 55% của con người.

• Kosinski cho rằng công trình của ông nên được xem như một cảnh báo cho các nhà hoạch định chính sách về những nguy cơ tiềm ẩn của nghiên cứu này và các công trình tương tự của những người khác.

• Tuy nhiên, nhiều ứng dụng của nghiên cứu này có vẻ khá tiêu cực, và việc công bố chúng có thể truyền cảm hứng cho việc tạo ra các công cụ phân biệt đối xử mới.

• Các mô hình không đạt độ chính xác 100%, có thể dẫn đến việc nhắm mục tiêu sai người.

• Năm 2017, Kosinski đồng công bố một bài báo về mô hình nhận diện khuôn mặt có thể dự đoán xu hướng tính dục với độ chính xác 91%. Tuy nhiên, Chiến dịch Nhân quyền và GLAAD gọi nghiên cứu này là "nguy hiểm và có sai sót" vì nó có thể được sử dụng để phân biệt đối xử với người đồng tính.

• Đã có nhiều ví dụ trong thực tế về việc nhận diện khuôn mặt xâm phạm cuộc sống và quyền của mọi người, như Rite Aid nhắm mục tiêu không công bằng vào các nhóm thiểu số là kẻ trộm cắp và Macy's đổ lỗi sai cho một người đàn ông về một vụ cướp bạo lực mà anh ta không phạm tội.

• Việc công bố nghiên cứu của Kosinski có thể được coi là một cảnh báo, nhưng nó cũng giống như việc đưa ra hướng dẫn chi tiết cho những tên trộm muốn đột nhập vào nhà bạn.

• Công nghệ này kết hợp với các cuộc chiến văn hóa đang diễn ra - như việc xác định sai giới tính của các vận động viên Olympic mùa hè này - có thể là công thức dẫn đến thảm họa.

📌 AI nhận diện khuôn mặt của Kosinski có thể dự đoán chính xác 72% niềm tin chính trị và 91% xu hướng tính dục, gây lo ngại về quyền riêng tư. Mặc dù được coi là cảnh báo, nghiên cứu này có thể bị lạm dụng để phân biệt đối xử và xâm phạm quyền công dân.

https://futurism.com/the-byte/ai-face-data

• Chính phủ Argentina do Tổng thống Javier Milei lãnh đạo vừa công bố kế hoạch sử dụng trí tuệ nhân tạo (AI) để dự đoán và ngăn chặn tội phạm trước khi xảy ra.

• Bộ An ninh Argentina cho biết đơn vị AI mới sẽ tập trung vào "phòng ngừa, phát hiện, điều tra và truy tố tội phạm", đồng thời tiến hành giám sát bằng drone, tuần tra mạng xã hội và sử dụng công nghệ nhận diện khuôn mặt để tăng cường các biện pháp an ninh.

• Động thái này diễn ra sau khi tòa án Buenos Aires phán quyết vào năm 2023 rằng việc chính quyền sử dụng công nghệ nhận diện khuôn mặt là vi hiến tại thành phố này. Thẩm phán cho rằng hệ thống được triển khai mà không tuân thủ các yêu cầu pháp lý về bảo vệ quyền cá nhân của người dân Buenos Aires.

• Các nhóm nhân quyền lo ngại việc triển khai công nghệ này có thể xâm phạm quyền tự do biểu đạt, khi người dân lo lắng về việc chính phủ giám sát các bài đăng trên mạng xã hội của họ, dẫn đến hiệu ứng răn đe đối với những gì họ chọn công bố.

• Một số người cũng lo ngại về tác động của AI đối với giới học thuật, bao gồm những gì các học giả và sinh viên sẽ chia sẻ và liệu nó có bị giám sát bởi công nghệ mới nổi này hay không.

• Trung tâm Argentina về Nghiên cứu Tự do Biểu đạt và Tiếp cận Thông tin cho biết AI và các công nghệ tương tự đã được sử dụng để lập hồ sơ các học giả, nhà báo, chính trị gia và nhà hoạt động. Họ muốn biết các công nghệ này được phát triển như thế nào, xuất xứ từ đâu và sẽ được sử dụng ra sao. Nhóm này cho rằng bất kỳ sự thiếu minh bạch nào cũng sẽ "đáng lo ngại".

• Chuyến thăm Thung lũng Silicon của Tổng thống Javier Milei hồi đầu năm nay đang được nhìn nhận khác đi dưới ánh sáng của động thái tăng cường phát hiện tội phạm bằng AI. Vào tháng 5, ông đã gặp gỡ một số lãnh đạo công nghệ và khuyến khích họ cân nhắc đầu tư vào đất nước của ông.

📌 Argentina triển khai AI để dự đoán tội phạm, gây tranh cãi về quyền riêng tư. Chính phủ khẳng định mục tiêu an ninh, trong khi các nhóm nhân quyền cảnh báo nguy cơ giám sát quá mức. Việc sử dụng AI trong an ninh đặt ra thách thức cân bằng giữa an toàn công cộng và quyền cá nhân.

https://www.upi.com/Top_News/World-News/2024/08/02/ar-using-ai-to-stop-crime-early/3981722571581/

• OpenAI ra mắt mô hình GPT-4o mới vào ngày 13/5, với khả năng giải phương trình, kể chuyện và nhận diện cảm xúc từ biểu hiện khuôn mặt.

• Chuyên gia lo ngại GPT-4o có thể thu thập nhiều thông tin hơn, gây rủi ro về quyền riêng tư. OpenAI từng gặp vấn đề với cơ quan quản lý ở Ý vì thu thập dữ liệu cá nhân trái phép.

• Chính sách quyền riêng tư của OpenAI cho phép thu thập nhiều loại dữ liệu, bao gồm thông tin cá nhân, dữ liệu sử dụng và nội dung người dùng nhập vào.

• ChatGPT sử dụng dữ liệu chia sẻ để huấn luyện mô hình, trừ khi người dùng tắt tính năng này trong cài đặt hoặc sử dụng phiên bản doanh nghiệp.

• OpenAI tuyên bố "ẩn danh hóa" dữ liệu cá nhân, nhưng cách tiếp cận dường như là "thu thập tất cả trước, sắp xếp sau".

• Chính sách cho phép OpenAI chia sẻ thông tin cá nhân với các đối tác, nhà cung cấp dịch vụ và cơ quan thực thi pháp luật.

• OpenAI đã giới thiệu các công cụ kiểm soát quyền riêng tư, cho phép người dùng quản lý dữ liệu của họ.

• Người dùng có thể tắt việc đóng góp dữ liệu để cải thiện mô hình trong phần cài đặt.

• Sử dụng "Temporary Chat" giúp ngăn OpenAI thu thập dữ liệu, nhưng sẽ làm giảm chức năng và độ chính xác của ChatGPT.

• Các biện pháp bảo vệ quyền riêng tư khác bao gồm: xóa lịch sử trò chuyện, thêm hướng dẫn cá nhân hóa, kiểm soát liên kết chia sẻ, yêu cầu xuất dữ liệu và xóa tài khoản.

• Hạn chế chia sẻ dữ liệu có thể ảnh hưởng đến trải nghiệm sử dụng, giảm độ cá nhân hóa và độ chính xác của AI.

📌 GPT-4o của OpenAI mang lại khả năng mạnh mẽ nhưng cũng gây lo ngại về quyền riêng tư. Người dùng cần cân nhắc giữa bảo vệ dữ liệu và tối ưu trải nghiệm, có thể áp dụng các biện pháp như tắt thu thập dữ liệu, sử dụng Temporary Chat và hạn chế chia sẻ thông tin nhạy cảm.

https://www.wired.com/story/can-chatgpt-4o-be-trusted-with-your-private-data/

• Human Rights Watch (HRW) vừa hoàn thành cuộc kiểm toán toàn diện về dữ liệu huấn luyện AI và phát hiện hình ảnh trẻ em bị thu thập từ internet đã được sử dụng để huấn luyện các mô hình AI mà không có sự đồng ý của trẻ em hoặc gia đình.

• Theo HRW, tên của một số trẻ được liệt kê trong chú thích đi kèm hoặc URL lưu trữ hình ảnh. Trong nhiều trường hợp, danh tính của trẻ dễ dàng bị truy nguyên, bao gồm thông tin về thời gian và địa điểm chụp ảnh.

• Nhiều hình ảnh bị thu thập không có sẵn công khai trên internet mà được ẩn sau cài đặt quyền riêng tư trên các trang mạng xã hội phổ biến.

• "Sharenting" - đăng thông tin, hình ảnh và câu chuyện về cuộc sống của con cái lên mạng - ngày càng bị chỉ trích vì nhiều lý do chính đáng. Một đứa trẻ 3 tuổi không thể đồng ý một cách có ý nghĩa để cha mẹ chia sẻ video thất bại trong việc tập đi vệ sinh cho cả thế giới xem.

• Báo cáo của HRW cho thấy cha mẹ không thể biết được hậu quả lâu dài của việc chia sẻ thông tin về con cái. 10 năm trước, không ai tưởng tượng được rằng album ảnh kỳ nghỉ gia đình họ chia sẻ có thể bị đưa vào học máy.

• Tòa án Tối cao Mỹ đã bác bỏ học thuyết Chevron vào tháng trước, tước bỏ quyền lực của các cơ quan liên bang như FTC và trao quyền cho tòa án. Điều này gây khó khăn cho việc ban hành luật bảo vệ quyền riêng tư ở cấp liên bang.

• Trong khi chờ đợi, AI sẽ tiếp tục thu thập dữ liệu của trẻ em - và cuối cùng, việc đó có hợp pháp hay không sẽ phụ thuộc vào bang bạn sống.

• Chia sẻ ảnh trận đấu bóng chày nhỏ của con bạn có thể là cách thú vị để giữ liên lạc với gia đình gần xa, nhưng cho đến khi có biện pháp bảo vệ đáng kể, đó là rủi ro mà tác giả không khuyên ai nên thực hiện.

📌 Việc sử dụng hình ảnh trẻ em để huấn luyện AI mà không có sự đồng ý gây lo ngại lớn về quyền riêng tư. Phụ huynh cần thận trọng khi chia sẻ ảnh con online. Cần có luật bảo vệ dữ liệu cá nhân cấp liên bang, nhưng quyết định của Tòa án Tối cao gây khó khăn cho việc này.

https://thehill.com/opinion/technology/4794388-ai-training-children-photos-privacy-chevron/

• X (trước đây là Twitter) đang mặc định sử dụng dữ liệu người dùng để huấn luyện chatbot AI Grok mà không thông báo rõ ràng.

• Elon Musk gần đây thông báo Grok đã bắt đầu quá trình "huấn luyện siêu cụm", nhưng không tiết lộ việc sử dụng dữ liệu người dùng X.

• Thông tin này được tiết lộ bởi người dùng "EasyBakedOven" trên X, cho biết nền tảng đã kích hoạt cài đặt mặc định cho phép sử dụng dữ liệu của mọi người.

• X mô tả cài đặt này là để "cải thiện trải nghiệm liên tục", họ có thể sử dụng bài đăng, tương tác, đầu vào và kết quả của người dùng với Grok để huấn luyện và tinh chỉnh.

• Dữ liệu này cũng có thể được chia sẻ với xAI, công ty AI của Musk.

• Người dùng có thể từ chối cho phép sử dụng dữ liệu của họ bằng cách vào Cài đặt > Quyền riêng tư và an toàn > Nội dung bạn thấy > Huấn luyện AI.

• Việc sử dụng dữ liệu người dùng để huấn luyện AI đang gây tranh cãi, với nhiều công ty bị chỉ trích vì làm điều này mà không có sự đồng ý rõ ràng.

• Musk trước đây đã chỉ trích việc các công ty khác sử dụng dữ liệu công khai để huấn luyện AI, nhưng giờ X cũng đang làm điều tương tự.

• Grok được quảng cáo là một chatbot AI "chống woke", nhưng một số người dùng nhận thấy nó đưa ra câu trả lời ngược lại với kỳ vọng.

• Việc này làm dấy lên lo ngại về quyền riêng tư và sử dụng dữ liệu cá nhân trong phát triển AI.

📌 X của Elon Musk đang mặc định sử dụng dữ liệu người dùng để huấn luyện AI Grok mà không thông báo rõ ràng. Người dùng có thể từ chối trong cài đặt. Điều này gây tranh cãi về quyền riêng tư và sử dụng dữ liệu cá nhân trong phát triển AI.

https://www.zdnet.com/article/elon-musks-x-now-trains-its-grok-ai-on-your-data-by-default-heres-how-to-opt-out/

• Chuỗi siêu thị AEON của Nhật Bản đã triển khai hệ thống AI đánh giá và chuẩn hóa nụ cười của nhân viên tại 240 cửa hàng trên toàn quốc từ ngày 1/7/2024.

• Hệ thống có tên "Mr Smile" do công ty công nghệ InstaVR phát triển, có khả năng đánh giá chính xác thái độ phục vụ của nhân viên bán hàng.

• Mr Smile phân tích hơn 450 yếu tố bao gồm biểu cảm khuôn mặt, âm lượng giọng nói và cách chào hỏi. Hệ thống còn tích hợp các yếu tố "trò chơi" để khuyến khích nhân viên cải thiện thái độ.

• AEON cho biết đã thử nghiệm hệ thống tại 8 cửa hàng với khoảng 3.400 nhân viên và nhận thấy thái độ phục vụ cải thiện gấp 1,6 lần trong vòng 3 tháng.

• Mục tiêu của AEON là "chuẩn hóa nụ cười của nhân viên và làm hài lòng khách hàng ở mức tối đa".

• Chính sách này đã gây ra lo ngại về việc hệ thống AI có thể làm gia tăng quấy rối nơi làm việc, đặc biệt là từ phía khách hàng - một vấn đề nghiêm trọng ở Nhật Bản.

• Hiện tượng quấy rối từ khách hàng, được gọi là "kasu-hara" ở Nhật, bao gồm việc sử dụng ngôn ngữ lăng mạ và khiếu nại lặp đi lặp lại.

• Theo khảo sát của công đoàn lớn nhất Nhật Bản UA Zensen, gần một nửa trong số 30.000 nhân viên làm việc trong ngành dịch vụ và các lĩnh vực khác cho biết đã từng bị quấy rối bởi khách hàng.

• Nhiều ý kiến cho rằng việc cưỡng ép nhân viên cười theo "tiêu chuẩn" là một hình thức quấy rối khách hàng khác, và nụ cười nên là điều tự nhiên, chân thành chứ không phải sản phẩm.

• Chiến lược này được so sánh với chiến dịch "Nụ cười 0 yên" của McDonald's tại Nhật Bản, vốn đã bị chỉ trích vì tạo thêm gánh nặng cho nhân viên được trả lương theo giờ thấp nhất.

• Bộ Y tế, Lao động và Phúc lợi Nhật Bản đã công bố hướng dẫn chống quấy rối khách hàng vào năm 2022, kêu gọi các công ty duy trì tiêu chuẩn dịch vụ mà không hy sinh sức khỏe của nhân viên.

• Gần đây, một siêu thị ở tỉnh Fukuoka đã triển khai quầy thanh toán siêu chậm, cho phép khách hàng dành tới 20 phút để thanh toán mà không cảm thấy áp lực. Biện pháp này nhằm thể hiện sự quan tâm đến khách hàng cao tuổi và khuyết tật, đồng thời giúp tăng doanh số bán hàng lên 10%.

📌 AEON triển khai AI đánh giá nụ cười nhân viên tại 240 cửa hàng, nhằm chuẩn hóa thái độ phục vụ. Hệ thống gây tranh cãi về quấy rối nơi làm việc. Khảo sát cho thấy 50% nhân viên dịch vụ Nhật Bản từng bị quấy rối bởi khách hàng. Chính phủ kêu gọi cân bằng tiêu chuẩn dịch vụ và sức khỏe nhân viên.

https://www.scmp.com/news/people-culture/article/3271333/japan-supermarket-chain-uses-ai-gauge-staff-smiles-speech-tones-quality-service-push

• Tổ chức Human Rights Watch (HRW) phát hiện 190 bức ảnh trẻ em Australia được liên kết trong bộ dữ liệu AI phổ biến LAION-5B, bao gồm cả trẻ em bản địa dễ bị tổn thương.

• Các bức ảnh này được thu thập "mà không có sự đồng ý hay biết đến của trẻ em hoặc gia đình", có thể được sử dụng để tạo ra deepfake chân thực của trẻ em Australia thật.

• URL trong bộ dữ liệu đôi khi tiết lộ thông tin nhận dạng của trẻ em như tên và địa điểm, gây nguy cơ về quyền riêng tư và an toàn.

• Ngay cả video YouTube được đặt ở chế độ riêng tư cũng bị thu thập vào bộ dữ liệu, bất chấp chính sách của YouTube cấm AI thu thập thông tin nhận dạng.

• Việc xóa liên kết khỏi bộ dữ liệu LAION-5B không xóa hình ảnh trên mạng và không thay đổi các mô hình AI đã được đào tạo trên chúng.

• Trẻ em bản địa đối mặt với những rủi ro độc đáo do văn hóa hạn chế sao chép ảnh người đã khuất trong thời gian để tang.

• Australia dự kiến công bố bản dự thảo cải cách Đạo luật Quyền riêng tư vào tháng 8, bao gồm dự thảo luật bảo vệ dữ liệu trẻ em đầu tiên.

• HRW kêu gọi Bộ luật Quyền riêng tư Trực tuyến của Trẻ em cấm "thu thập dữ liệu cá nhân của trẻ em vào hệ thống AI" và "sao chép hoặc thao túng hình ảnh của trẻ em mà không có sự đồng ý".

• Chuyên gia nhấn mạnh cần có sự can thiệp của cơ quan quản lý để ngăn chặn việc đào tạo AI trên dữ liệu trẻ em trước khi nó xảy ra.

• YouTube tuyên bố việc thu thập trái phép nội dung vi phạm Điều khoản Dịch vụ và họ tiếp tục có hành động chống lại hành vi lạm dụng này.

• Các chuyên gia cho rằng việc yêu cầu phụ huynh gỡ bỏ ảnh trẻ em trên mạng là "không thực tế và thậm chí là vô lý", thay vào đó cần có biện pháp bảo vệ pháp lý.

📌 AI đang khai thác hình ảnh trẻ em Australia trên mạng bất chấp các biện pháp bảo mật. 190 ảnh trẻ em được phát hiện trong bộ dữ liệu LAION-5B, gây nguy cơ về quyền riêng tư và an toàn. Các chuyên gia kêu gọi siết chặt quy định pháp lý để bảo vệ trẻ em trong thời đại AI.

https://arstechnica.com/tech-policy/2024/07/ai-trains-on-kids-photos-even-when-parents-use-strict-privacy-settings/

- Meta đã bắt đầu sử dụng dữ liệu công khai từ tài khoản người dùng Mỹ từ năm 2023 để cải thiện các tính năng AI của mình như trợ lý Meta AI, AI Stickers và công cụ tạo ảnh Imagine.

- Kế hoạch cập nhật chính sách quyền riêng tư vào ngày 26/6 để đào tạo các mô hình AI trên dữ liệu công khai từ tài khoản EU và Anh đã bị tạm dừng vô thời hạn do phản ứng từ các cơ quan quản lý.

- Người dùng Mỹ không có tùy chọn chọn không chia sẻ dữ liệu, nhưng có thể hạn chế bằng cách đặt hồ sơ Instagram ở chế độ riêng tư và không chia sẻ công khai trên Facebook.

- Meta chỉ sử dụng thông tin được chia sẻ công khai để đào tạo AI, bao gồm ảnh, video, chú thích trong feed và Reels của Instagram nếu tài khoản ở chế độ công khai, và bất cứ thứ gì được chia sẻ với đối tượng Public trên Facebook.

- Meta không sử dụng dữ liệu từ tin nhắn riêng tư, trực tiếp trên Facebook và Instagram, cũng như từ stories hoặc Threads.

- Để hạn chế dữ liệu bị truy cập, người dùng có thể chuyển hồ sơ Instagram sang chế độ riêng tư trong phần cài đặt trên iOS, hoặc chọn đối tượng khác Public như Friends hoặc Only Me cho các bài đăng trên Facebook.

- Các thay đổi này sẽ không có hiệu lực hồi tố, nghĩa là các bài đăng cũ đã công khai có thể đã giúp AI của Meta học cách suy nghĩ và nói chuyện giống con người hơn.

📌 Meta đang tận dụng lợi thế dữ liệu khổng lồ từ hàng tỷ người dùng toàn cầu để đẩy nhanh quá trình phát triển AI, bất chấp những lo ngại về quyền riêng tư. Người dùng Mỹ hiện không thể chọn không chia sẻ dữ liệu, nhưng vẫn có thể hạn chế phần nào bằng cách điều chỉnh cài đặt riêng tư trên Instagram và Facebook, mặc dù các bài đăng cũ có thể đã bị sử dụng.

https://www.wsj.com/tech/ai/meta-ai-training-instagram-facebook-explained-a3d36cdb

#WSJ

- Ứng dụng xử lý đơn hàng nhà hàng sử dụng ngôn ngữ tự nhiên để tìm kiếm đơn hàng.

- Sử dụng ID prefix để quản lý và xóa dữ liệu dễ dàng.

- RAG (Retrieval Augmented Generation) giúp thêm dữ liệu riêng tư vào phản hồi của LLM, đảm bảo tính chính xác và ngữ cảnh cụ thể.

- RAG cho phép người dùng tương tác với cửa hàng, truy xuất đơn hàng cũ, mua sản phẩm mới bằng ngôn ngữ tự nhiên.

- Dữ liệu cá nhân và thông tin nhận dạng cá nhân (PII) được cung cấp cho mô hình tạo sinh tại thời điểm suy luận để đáp ứng yêu cầu của người dùng.

- Khi xóa dữ liệu bằng ID prefix, hệ thống sẽ không còn thông tin về người dùng đó.

- RAG cung cấp khả năng cá nhân hóa trong khi kiểm soát chặt chẽ PII, chỉ chia sẻ dữ liệu riêng tư khi cần thiết và có thể nhanh chóng xóa bỏ.

- Xây dựng phần mềm AI bảo mật yêu cầu phân loại dữ liệu thành công khai, riêng tư và PII.

- Dữ liệu công khai: tên công ty, ảnh đại diện, chức danh công việc.

- Dữ liệu riêng tư: khóa API, ID tổ chức.

- PII: tên đầy đủ, ngày sinh, ID tài khoản.

- Sử dụng tokenization để tránh lưu trữ PII trong cơ sở dữ liệu vector, thay vào đó lưu trữ khóa ngoại hoặc tham chiếu đến hệ thống khác.

- Hashing có thể được sử dụng để làm mờ dữ liệu người dùng trước khi ghi vào metadata.

- Mã hóa metadata trước khi upsert và giải mã khi truy vấn để bảo vệ dữ liệu người dùng.

- Xóa dữ liệu trong cơ sở dữ liệu vector bằng cách xóa toàn bộ namespace.

- Xây dựng phần mềm AI bảo mật yêu cầu lập kế hoạch cẩn thận và sử dụng các kỹ thuật như ID-prefixing và lọc metadata để xóa dữ liệu người dùng hiệu quả.

📌 Bài viết giải thích cách sử dụng RAG để bảo vệ dữ liệu cá nhân trong phần mềm AI, bao gồm việc phân loại dữ liệu, sử dụng tokenization, hashing và mã hóa metadata. RAG giúp xóa dữ liệu người dùng nhanh chóng và đảm bảo quyền riêng tư.

https://thenewstack.io/building-privacy-aware-ai-software-with-vector-databases/

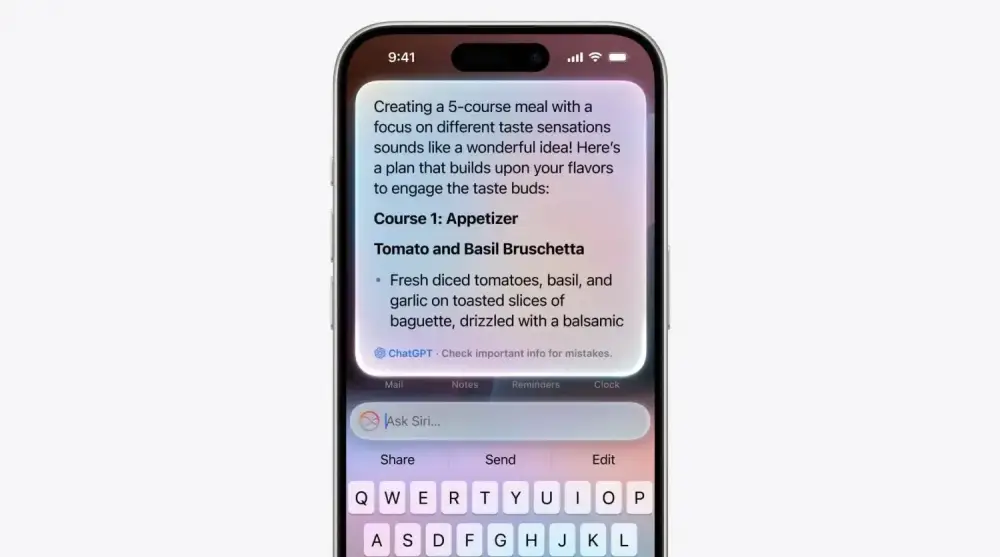

- Apple giới thiệu Apple Intelligence, tích hợp AI tạo sinh vào hệ điều hành mới, hỗ trợ viết văn bản, tạo hình ảnh, emoji và quản lý thông tin cá nhân.

- Apple hợp tác với OpenAI, tích hợp ChatGPT vào các tính năng của Apple Intelligence, giúp OpenAI tiếp cận hàng triệu người dùng phổ thông.

- Sức mạnh của Apple nằm ở việc tận dụng lượng người dùng khổng lồ, kết hợp dữ liệu cá nhân với AI tạo sinh để mang lại giá trị cho người dùng.

- Apple đang đánh cược rằng giải pháp AI tổng hợp sẽ vượt trội hơn các sản phẩm đơn lẻ, nhờ hàng tỷ thiết bị của hãng trên toàn cầu.

- Thông báo của Apple cho thấy AI tạo sinh sẽ trở nên phổ biến và không thể tránh khỏi khi được tích hợp vào các thiết bị thông dụng.

- Tuy nhiên, kế hoạch này không đảm bảo thành công. Các lỗi và hạn chế của công nghệ AI tạo sinh có thể gây ra những hậu quả nghiêm trọng cho hệ sinh thái của Apple.

📌 Apple đang đưa AI tạo sinh đến với hàng tỷ thiết bị, biến chúng thành "con ngựa thành Troy" để thâm nhập vào cuộc sống hàng ngày. Tuy nhiên, việc triển khai rộng rãi công nghệ chưa hoàn thiện này có thể phá vỡ "vườn bao" mà Apple đã dày công xây dựng, gây ra những hậu quả khó lường.

https://www.theatlantic.com/technology/archive/2024/06/apple-generative-ai-wwdc/678648/

- Apple đã giới thiệu Private Cloud Compute (PCC) để hỗ trợ các tính năng Apple Intelligence, đảm bảo dữ liệu người dùng được bảo mật.

- PCC được xây dựng trên phần cứng Apple silicon tùy chỉnh và một hệ điều hành được tăng cường bảo mật, được thiết kế riêng cho quyền riêng tư.

- Apple cho biết họ đã viết một hệ điều hành được tăng cường bảo mật, khác với macOS và iOS mới được công bố tại WWDC.

- Hệ điều hành mới này là một tập hợp con được tăng cường của nền tảng iOS và macOS, được điều chỉnh để hỗ trợ các tác vụ suy luận Large Language Model (LLM).

- Gốc tin cậy của PCC là node tính toán của Apple, phần cứng máy chủ tùy chỉnh mang lại sức mạnh và bảo mật của chip Apple silicon vào trung tâm dữ liệu.

- Khi ra mắt PCC, Apple sẽ công khai hình ảnh phần mềm của mọi bản dựng sản xuất PCC để nghiên cứu bảo mật, bao gồm mọi ứng dụng, tệp thực thi liên quan và chính hệ điều hành.

- Phần mềm sẽ được công bố trong vòng 90 ngày kể từ khi được đưa vào nhật ký hoặc sau khi các bản cập nhật phần mềm liên quan khả dụng, tùy điều kiện nào đến sớm hơn.

📌 Apple đã phát triển một hệ điều hành mới được tăng cường bảo mật dựa trên nền tảng iOS và macOS, tùy chỉnh để hỗ trợ Private Cloud Compute. Công ty sẽ công khai mã nguồn trong vòng 90 ngày để thúc đẩy nghiên cứu bảo mật.

https://www.techradar.com/pro/apple-quietly-released-a-new-operating-system-that-almost-nobody-noticed-unnamed-os-surfaces-in-private-cloud-compute-blog-as-apple-goes-ballistic-on-ai

- Tại WWDC, Apple giới thiệu Apple Intelligence, một bộ công cụ AI tạo sinh mới cho iPhone, iPad và Mac, bao gồm viết lại email, tóm tắt thông báo và tạo emoji tùy chỉnh.

- Apple nhấn mạnh việc bảo mật dữ liệu người dùng thông qua hai phương pháp: sử dụng mô hình AI trên thiết bị và kết nối với máy chủ đám mây khi cần thiết.

- Apple Intelligence sử dụng mô hình AI tự phát triển, không huấn luyện bằng dữ liệu cá nhân mà sử dụng dữ liệu công khai và được cấp phép, loại bỏ các thông tin nhạy cảm như số an sinh xã hội và số thẻ tín dụng.

- Các mô hình AI của Apple được tối ưu hóa cho hiệu suất và kích thước để phù hợp với các thiết bị như iPhone, giúp giảm bớt lo ngại về bảo mật khi xử lý yêu cầu AI tại chỗ.

- Apple sử dụng kỹ thuật "fine-tuning" để cải thiện mô hình AI cho các nhiệm vụ cụ thể như kiểm tra chính tả hoặc tóm tắt văn bản, thông qua các "adapters" có thể thay đổi.

- Đối với các yêu cầu phức tạp hơn, Apple sử dụng máy chủ Private Cloud Compute (PCC) với hệ điều hành riêng dựa trên nền tảng iOS, có bảo mật cao và không lưu trữ dữ liệu lâu dài.

- Kết nối giữa thiết bị người dùng và PCC được mã hóa từ đầu đến cuối, và Apple không thể truy cập dữ liệu trong PCC do không có công cụ quản lý máy chủ từ xa.

- Siri có thể gửi một số truy vấn đến ChatGPT trên đám mây, nhưng chỉ khi người dùng cho phép, chuyển trách nhiệm bảo mật sang OpenAI.

- Apple Intelligence sẽ được ra mắt vào mùa thu, và người dùng sẽ có cơ hội kiểm chứng sự cân bằng giữa trải nghiệm AI chất lượng và bảo mật dữ liệu.

📌 Apple Intelligence giới thiệu các công cụ AI tạo sinh mới, tập trung vào bảo mật dữ liệu người dùng bằng cách sử dụng mô hình AI trên thiết bị và đám mây. Apple không huấn luyện mô hình bằng dữ liệu cá nhân và sử dụng kết nối mã hóa để bảo vệ dữ liệu khi cần xử lý trên đám mây.

https://www.theverge.com/2024/6/13/24175985/apple-intelligence-ai-model-local-cloud-privacy-how-it-works

- Dữ liệu công khai hiện tại đã đủ để tạo ra các mô hình đa năng chất lượng cao, nhưng không đủ để cung cấp năng lượng cho các mô hình chuyên biệt mà doanh nghiệp cần. Trong khi đó, các quy định AI đang ngày càng khiến việc xử lý dữ liệu nhạy cảm thô an toàn trở nên khó khăn hơn.

- Các công ty công nghệ hàng đầu như Google, Anthropic, Meta, Microsoft đã bắt đầu sử dụng dữ liệu tổng hợp để huấn luyện các mô hình như Gemma, Claude, Llama 3, Phi-3 và đạt được những cải thiện đáng kể về hiệu suất.

- Trong kỷ nguyên AI, chất lượng dữ liệu được định nghĩa bởi 5 yếu tố: khối lượng, tốc độ, đa dạng, độ chính xác và quyền riêng tư. Thiếu bất kỳ yếu tố nào trong số này, các nút thắt về chất lượng dữ liệu sẽ cản trở hiệu suất mô hình và giá trị kinh doanh.

- Dữ liệu tổng hợp chất lượng cao phải bao gồm: hệ thống phát hiện và chuyển đổi dữ liệu nhạy cảm tiên tiến, tạo thông qua các bộ chuyển đổi được đào tạo trước và kiến trúc dựa trên tác nhân, quyền riêng tư khác biệt ở cấp độ đào tạo mô hình, độ chính xác và tiện ích có thể đo lường được cùng với các biện pháp bảo vệ quyền riêng tư có thể chứng minh được, các nhóm đánh giá, xác thực và điều chỉnh dữ liệu.

- Sự sụp đổ mô hình không phải do dữ liệu tổng hợp gây ra mà là do vòng lặp phản hồi trong các hệ thống AI và học máy cùng với nhu cầu quản trị dữ liệu tốt hơn. Dữ liệu tổng hợp bảo mật quyền riêng tư chất lượng cao là giải pháp cho sự sụp đổ mô hình, không phải là nguyên nhân.

📌 Dữ liệu tổng hợp chất lượng cao, bảo mật quyền riêng tư là phương tiện đáng tin cậy và hiệu quả nhất để tạo ra dữ liệu chất lượng cao mà không ảnh hưởng đến hiệu suất hoặc quyền riêng tư, giúp các nhà phát triển xây dựng các mô hình chính xác, kịp thời và chuyên biệt hơn một cách an toàn.

https://www.infoworld.com/article/3715521/solving-the-data-quality-problem-in-generative-ai.html

- Tại WWDC 2024, Apple giới thiệu "Apple Intelligence", một dịch vụ AI rộng khắp trên MacOS "Sequoia", iPadOS 18 và iOS 18.

- Apple công bố "Private Cloud Compute", cho phép chạy một số mô hình AI trên thiết bị và một số trên môi trường điện toán đám mây an toàn khi cần sức mạnh xử lý bổ sung.

- Private Cloud Compute sử dụng máy chủ với chip tùy chỉnh của Apple thay vì chip Intel và AMD thông thường.

- Dữ liệu người dùng sẽ không bị Apple thu thập. Các chuyên gia độc lập có thể kiểm tra mã chạy trên máy chủ để xác minh lời hứa về quyền riêng tư.

- Apple hợp tác với OpenAI để tích hợp ChatGPT vào Siri, nhấn mạnh việc xin phép người dùng trước khi sử dụng ChatGPT và không ghi lại yêu cầu và thông tin.

- Đây được coi là một tiêu chuẩn mới cho quyền riêng tư và AI, mở khóa trí tuệ mà bạn có thể tin tưởng.

📌 Apple đã giới thiệu Private Cloud Compute tại WWDC 2024, sử dụng chip tùy chỉnh an toàn hơn và có thể được kiểm tra bởi các chuyên gia bảo mật. Họ cũng hợp tác với OpenAI để tích hợp ChatGPT vào Siri, đồng thời cam kết bảo vệ quyền riêng tư của người dùng bằng cách không thu thập dữ liệu và xin phép trước khi sử dụng AI.

https://www.zdnet.com/article/heres-how-apples-keeping-your-cloud-processed-ai-data-safe-and-why-it-matters/

- Elon Musk đã gọi iOS 18 là "vi phạm bảo mật không thể chấp nhận" do tích hợp ChatGPT và đe dọa cấm sử dụng thiết bị Apple tại các công ty của ông, bao gồm Tesla, SpaceX và X.

- Ông Musk cho biết khách đến thăm sẽ phải giao nộp điện thoại Apple của họ khi đến các công ty của ông, và các thiết bị này sẽ được lưu trữ trong lồng Faraday.

- Không rõ liệu Musk có xem buổi công bố AI của Apple trong sự kiện WWDC hay không, hay ông chỉ phản ứng một cách bộc phát. Musk hiện đang điều hành xAI, một đối thủ trực tiếp của OpenAI.

- iOS 18 tích hợp sâu ChatGPT, nhưng chỉ khi người dùng cho phép rõ ràng. Điều này không khác nhiều so với việc tải ứng dụng ChatGPT từ App Store, ngoại trừ việc truy cập thuận tiện hơn.

- Người dùng có thể sử dụng các tính năng của ChatGPT trong iOS với gói miễn phí của ChatGPT-4o hoặc mua gói ChatGPT Plus và đăng nhập vào tài khoản của họ.

- Apple cho biết sẽ tích hợp các nhà cung cấp mô hình AI bên thứ ba khác trong tương lai.

- Apple tuân thủ nghiêm ngặt về quyền riêng tư và bảo mật, và khách hàng doanh nghiệp có thể chặn sử dụng các tính năng ChatGPT và Apple Intelligence bằng các kiểm soát MDM tiêu chuẩn.

📌 Elon Musk đã chỉ trích iOS 18 vì tích hợp ChatGPT, gọi đó là "vi phạm bảo mật" và đe dọa cấm sử dụng thiết bị Apple tại các công ty của ông. Ông yêu cầu khách đến thăm giao nộp điện thoại Apple, và Apple khẳng định tích hợp ChatGPT chỉ khi người dùng cho phép.

https://9to5mac.com/2024/06/10/elon-musk-calls-ios-18-a-security-violation-for-integrating-chatgpt-says-he-will-ban-use-of-apple-devices-at-tesla/

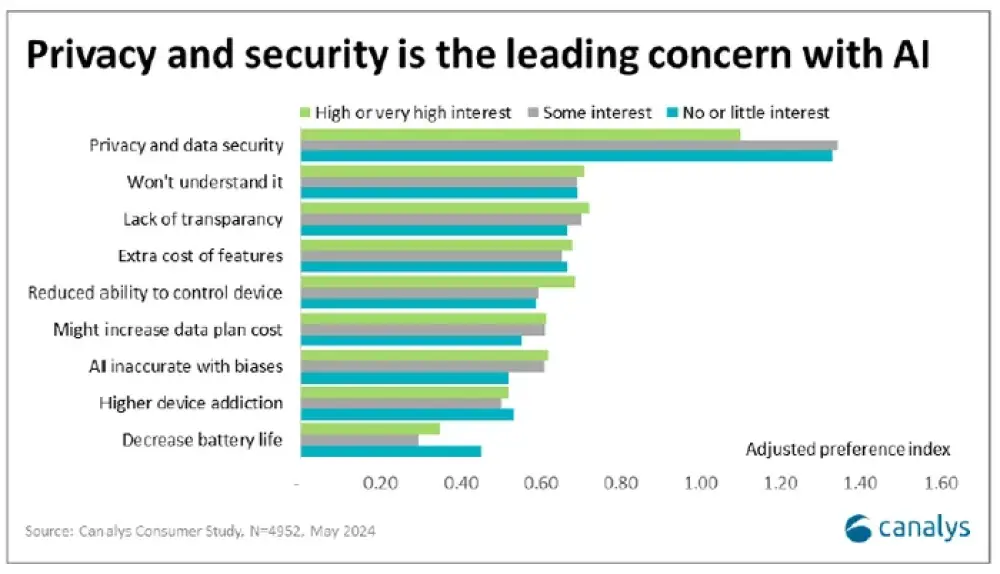

- Canalys định nghĩa smartphone có khả năng AI tạo sinh (GenAI) là có phần cứng AI chuyên dụng như ASIC, cho phép chạy các mô hình AI tạo sinh hiệu quả và hỗ trợ suy luận tại chỗ theo thời gian thực với độ trễ tối thiểu.

- Các tính năng AI trong tương lai có thể mang lại cho nhà mạng "những tuyến kinh doanh mới" và "thỏa thuận chia sẻ doanh thu", nhưng đây là "thách thức lớn để vận hành hạ tầng này", theo Runar Bjorhovde, chuyên gia phân tích của Canalys.

- Lưu lượng dữ liệu trung bình trên mỗi smartphone là 21GB/tháng vào năm 2023 và dự kiến đạt 56GB/tháng vào năm 2029, theo báo cáo của Ericsson.

- Các nhà mạng đang nỗ lực đẩy mạnh việc chạy AI trên chính thiết bị thay vì qua Internet và đám mây công cộng. Điều này giảm tải lưu lượng mạng và nhà mạng kiểm soát tốt hơn quyền riêng tư và bảo mật.

- Mối quan ngại hàng đầu của người dùng là rủi ro về quyền riêng tư và bảo mật dữ liệu khi chạy AI trên smartphone.

- Canalys dự báo 16% smartphone toàn cầu xuất xưởng năm nay sẽ có khả năng AI, con số này sẽ tăng lên 54% vào năm 2028. Smartphone có khả năng AI sẽ đạt tốc độ tăng trưởng kép hàng năm (CAGR) 63% từ 2023-2028.

- Nhóm người dùng đam mê công nghệ, chiếm 7% người mua smartphone AI, là cơ hội tốt nhất để nhà mạng bán thêm smartphone mới có khả năng AI. Đây là nhóm khách hàng giá trị cao, quan tâm nâng cấp lên công nghệ mới nhất.

- Người mua smartphone ở Trung Quốc và Ấn Độ có xu hướng "mạnh mẽ hơn nhiều đối với đổi mới công nghệ mới nhất". Trong khi đó, ở châu Âu, "tính bền vững đang trở thành mối quan tâm hàng đầu".

📌 Sự gia tăng của smartphone có khả năng AI mang lại cơ hội kinh doanh mới cho nhà mạng, nhưng cũng đặt ra thách thức lớn về hạ tầng. Canalys dự báo đến năm 2028, 54% smartphone toàn cầu sẽ có khả năng AI với CAGR 63% giai đoạn 2023-2028. Tuy nhiên, việc thuyết phục người dùng nâng cấp lên smartphone AI sẽ khác biệt giữa các khu vực, với Trung Quốc và Ấn Độ nhiệt tình hơn so với châu Âu.

https://www.lightreading.com/ai-machine-learning/operators-to-play-a-tricky-game-with-ai-capable-smartphone-sales-canalys-report

- Ngành công nghiệp AI đang tiến gần đến một bước chuyển đổi mà dữ liệu người dùng sẽ trở nên tối quan trọng và niềm tin sẽ là hàng hóa quan trọng nhất, được gọi là "AI 2.0".

- AI tạo sinh 1.0 là phi cá nhân hóa. Để AI hiểu chúng ta, nó phải có dữ liệu về chúng ta, và trước khi cho phép điều đó, chúng ta phải có niềm tin.

- Chúng ta có thể xây dựng niềm tin bằng các quy định bảo vệ dữ liệu cá nhân và thúc đẩy tính minh bạch. Tác giả đề xuất 4 quy tắc cho tính minh bạch và quyền riêng tư dữ liệu.

- Nếu các công ty AI cần đào tạo trên thông tin có bản quyền, họ có thể trả tiền cho nó với ngân sách hàng chục và hàng trăm tỷ đô la.

- Một mô hình AI của Mỹ dựa trên quyền sở hữu rõ ràng và quyền riêng tư dữ liệu sẽ truyền cảm hứng cho nhiều người tham gia hơn mô hình AI của Trung Quốc với dữ liệu do Đảng Cộng sản kiểm soát.

📌 Để AI 2.0 mang lại giá trị lớn hơn, cần có mối quan hệ mới với công chúng dựa trên niềm tin. Mỹ có lợi thế trong cuộc đua này nếu có các quy định đúng đắn về quyền sở hữu và quyền riêng tư dữ liệu, trái ngược với mô hình kiểm soát dữ liệu của Trung Quốc.

https://www.fastcompany.com/91137724/for-ai-to-really-succeed-we-need-to-protect-private-data

- DuckDuckGo đã ra mắt dịch vụ "AI Chat" mới cho phép người dùng trò chuyện với bốn mô hình ngôn ngữ lớn (LLM) tầm trung từ OpenAI, Anthropic, Meta và Mistral trong một giao diện tương tự như ChatGPT, đồng thời cố gắng bảo vệ quyền riêng tư và ẩn danh.

- Dịch vụ AI Chat của DuckDuckGo hiện đang cung cấp quyền truy cập vào GPT-3.5 Turbo của OpenAI, Claude 3 Haiku của Anthropic và hai mô hình nguồn mở là Llama 3 của Meta và Mixtral 8x7B của Mistral.

- Dịch vụ hiện miễn phí sử dụng trong giới hạn hàng ngày. Người dùng có thể truy cập AI Chat thông qua công cụ tìm kiếm DuckDuckGo, các liên kết trực tiếp đến trang web hoặc bằng cách sử dụng các phím tắt "!ai" hoặc "!chat" trong trường tìm kiếm.

- Theo DuckDuckGo, các cuộc trò chuyện trên dịch vụ được ẩn danh, với siêu dữ liệu và địa chỉ IP bị xóa để ngăn chặn việc truy nguyên về cá nhân. Công ty tuyên bố rằng các cuộc trò chuyện không được sử dụng để đào tạo mô hình AI.