Tạp chí NATURE: Cách Trung Quốc tạo ra mô hình AI DeepSeek và gây sốc cho thế giới

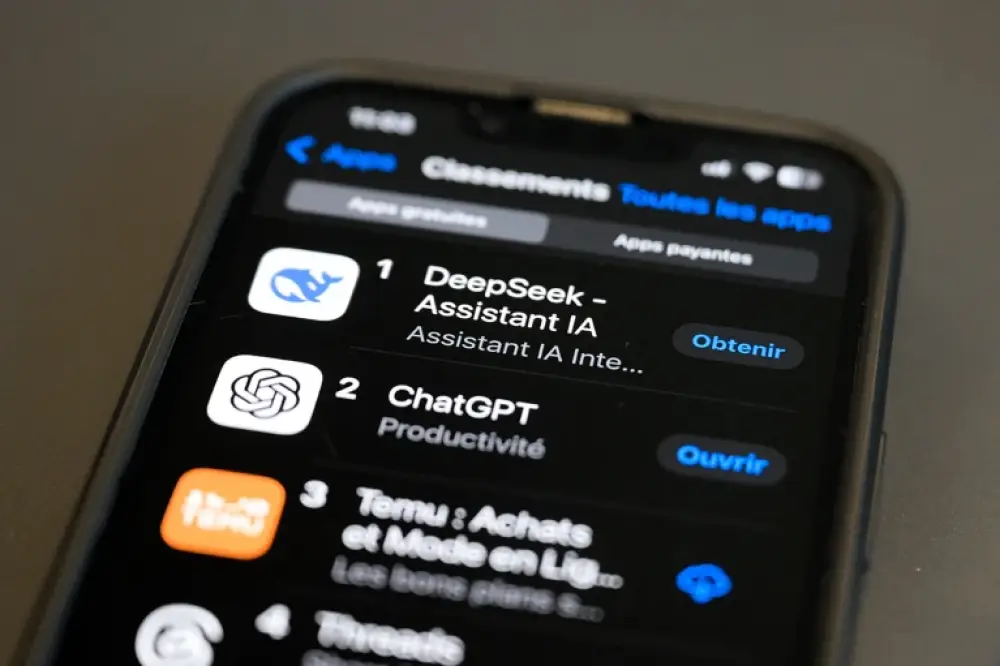

- Công ty khởi nghiệp DeepSeek tại Hàng châu đã gây chấn động khi phát hành 2 mô hình ngôn ngữ lớn có hiệu năng ngang tầm với các công cụ của các gã khổng lồ công nghệ Mỹ

- DeepSeek-R1 ra mắt ngày 20/1/2024, là mô hình nguồn mở một phần, có khả năng giải quyết một số vấn đề khoa học tương đương với o1 của OpenAI

- Janus-Pro-7B được phát hành đầu tuần, có thể tạo hình ảnh từ văn bản tương tự như DALL-E 3 của OpenAI và Stable Diffusion

- Chính phủ Trung quốc đặt mục tiêu trở thành quốc gia dẫn đầu về AI vào năm 2030:

+ Đến 2022, có 440 trường đại học được phê duyệt đào tạo chuyên ngành AI

+ Trung quốc cung cấp gần 50% nhà nghiên cứu AI hàng đầu thế giới

+ Mỹ chỉ chiếm 18% số nhà nghiên cứu AI

- DeepSeek phát triển hiệu quả trong bối cảnh bị Mỹ kiểm soát xuất khẩu chip AI từ 2022:

+ Sử dụng khoảng 2.000 chip H800 của Nvidia để huấn luyện DeepSeek-V3

+ So với Meta dùng hơn 16.000 chip H100 tiên tiến hơn cho Llama 3.1

+ Áp dụng kiến trúc mixture-of-experts và multi-head latent attention để tối ưu hiệu suất

- Các công ty công nghệ Trung quốc khác cũng đạt thành tựu:

+ Alibaba ra mắt Qwen2.5-Max vượt trội hơn DeepSeek-V3

+ Moonshot AI và ByteDance phát hành Kimi 1.5 và 1.5-pro vượt o1 trong một số bài kiểm tra

📌 Với chính sách ưu tiên phát triển AI quốc gia, đầu tư mạnh vào giáo dục và nguồn nhân lực, Trung quốc đã tạo ra DeepSeek - mô hình AI có hiệu năng ngang tầm OpenAI dù chỉ sử dụng 2.000 chip so với 16.000 chip của đối thủ, mở ra hướng đi mới cho các nước có nguồn lực hạn chế.

https://www.nature.com/articles/d41586-025-00259-0

Cách Trung Quốc tạo ra mô hình AI DeepSeek và khiến thế giới sửng sốt

Các chính sách của chính phủ, nguồn tài trợ hào phóng và đội ngũ kỹ sư AI dồi dào đã giúp các công ty Trung Quốc tạo ra những mô hình ngôn ngữ lớn (LLM) tiên tiến.

Gemma Conroy & Smriti Mallapaty

Công ty khởi nghiệp công nghệ DeepSeek của Trung Quốc đã khiến thế giới công nghệ chấn động khi tung ra 2 mô hình ngôn ngữ lớn (LLM) có hiệu năng ngang ngửa các công cụ hàng đầu do các tập đoàn công nghệ Mỹ phát triển, nhưng lại được xây dựng với chi phí và tài nguyên tính toán chỉ bằng một phần nhỏ.

Ngày 20/1, công ty có trụ sở tại Hàng Châu này đã ra mắt DeepSeek-R1, một mô hình ‘lập luận’ bán mã nguồn mở có khả năng giải quyết một số bài toán khoa học với tiêu chuẩn tương đương o1, mô hình LLM tiên tiến nhất của OpenAI – công ty có trụ sở tại San Francisco, California, ra mắt vào cuối năm ngoái. Và đầu tuần này, DeepSeek tiếp tục giới thiệu một mô hình khác có tên Janus-Pro-7B, có khả năng tạo hình ảnh từ văn bản giống như DALL-E 3 của OpenAI và Stable Diffusion của Stability AI tại London.

Nếu hiệu suất của DeepSeek-R1 khiến nhiều người bên ngoài Trung Quốc bất ngờ, thì các nhà nghiên cứu trong nước lại cho rằng thành công của công ty này là điều tất yếu, phù hợp với tham vọng trở thành cường quốc trí tuệ nhân tạo (AI) của chính phủ.

Yunji Chen, nhà khoa học máy tính chuyên nghiên cứu chip AI tại Viện Công nghệ Tính toán thuộc Viện Hàn lâm Khoa học Trung Quốc ở Bắc Kinh, nhận định rằng việc một công ty như DeepSeek xuất hiện tại Trung Quốc là điều không thể tránh khỏi, nhờ vào lượng đầu tư mạo hiểm khổng lồ vào các công ty phát triển LLM, cùng với số lượng lớn tiến sĩ trong các lĩnh vực khoa học, công nghệ, kỹ thuật và toán học, bao gồm cả AI. “Nếu không phải DeepSeek, thì sẽ có một công ty LLM Trung Quốc khác làm được những điều tương tự.”

Thực tế là đã có nhiều công ty khác. Ngày 29/1, gã khổng lồ công nghệ Alibaba đã giới thiệu LLM tiên tiến nhất của mình cho đến nay, Qwen2.5-Max, mà theo công ty, có hiệu năng vượt trội so với DeepSeek V3 – một LLM khác do DeepSeek phát hành vào tháng 12. Tuần trước, Moonshot AI và ByteDance cũng ra mắt các mô hình lập luận mới, Kimi 1.5 và 1.5-pro, mà theo tuyên bố của các công ty này, có thể vượt mặt o1 trong một số bài kiểm tra chuẩn.

Ưu tiên của chính phủ

Năm 2017, chính phủ Trung Quốc công bố kế hoạch đưa đất nước trở thành cường quốc AI hàng đầu thế giới vào năm 2030. Chính phủ giao nhiệm vụ cho ngành công nghiệp phải đạt được những đột phá lớn về AI, “để công nghệ và ứng dụng đạt đến trình độ dẫn đầu thế giới” vào năm 2025.

Việc xây dựng một đội ngũ nhân tài AI trở thành ưu tiên hàng đầu. Theo báo cáo từ Trung tâm An ninh và Công nghệ Mới nổi (CSET) tại Đại học Georgetown ở Washington DC, đến năm 2022, Bộ Giáo dục Trung Quốc đã phê duyệt 440 trường đại học cung cấp chương trình đào tạo cử nhân chuyên ngành AI. Cùng năm đó, Trung Quốc cung cấp gần một nửa số nhà nghiên cứu AI hàng đầu thế giới, trong khi Mỹ chỉ chiếm 18%, theo think tank MacroPolo ở Chicago, Illinois.

Marina Zhang, nhà nghiên cứu chính sách khoa học tại Đại học Công nghệ Sydney, Australia, chuyên về đổi mới công nghệ ở Trung Quốc, cho rằng DeepSeek có thể đã hưởng lợi từ các khoản đầu tư của chính phủ vào giáo dục và phát triển nhân tài AI. Các khoản đầu tư này bao gồm nhiều học bổng, tài trợ nghiên cứu và hợp tác giữa học thuật với doanh nghiệp. Bà cũng chỉ ra rằng các sáng kiến do nhà nước hậu thuẫn, chẳng hạn như Phòng thí nghiệm Kỹ thuật Quốc gia về Công nghệ và Ứng dụng Học sâu do công ty công nghệ Baidu ở Bắc Kinh dẫn dắt, đã đào tạo hàng nghìn chuyên gia AI.

Thông tin chính xác về đội ngũ nhân sự của DeepSeek khá khó tìm, nhưng theo lời nhà sáng lập Liang Wenfeng trên truyền thông Trung Quốc, công ty đã tuyển dụng các cử nhân và nghiên cứu sinh tiến sĩ từ những trường đại học hàng đầu Trung Quốc. Một số lãnh đạo của công ty còn dưới 35 tuổi, thuộc thế hệ lớn lên trong thời kỳ Trung Quốc vươn lên thành cường quốc công nghệ, Zhang nhận xét. “Họ có động lực mạnh mẽ hướng đến tự chủ đổi mới.”

Wenfeng, 39 tuổi, cũng là một doanh nhân trẻ, tốt nghiệp ngành khoa học máy tính tại Đại học Chiết Giang – một trường danh tiếng ở Hàng Châu. Gần một thập kỷ trước, ông đồng sáng lập quỹ đầu cơ High-Flyer và đến năm 2023, ông thành lập DeepSeek.

Jacob Feldgoise, chuyên gia nghiên cứu về nhân tài AI tại CSET, cho rằng các chính sách quốc gia thúc đẩy hệ sinh thái phát triển mô hình AI đã giúp các công ty như DeepSeek thu hút cả vốn đầu tư lẫn nhân tài.

Tuy nhiên, dù số lượng chương trình đào tạo AI tại các trường đại học tăng lên, Feldgoise cho biết vẫn chưa rõ có bao nhiêu sinh viên tốt nghiệp với bằng chuyên ngành AI thực sự và liệu họ có được đào tạo đúng kỹ năng mà các công ty cần hay không. Ông cũng lưu ý rằng trong những năm gần đây, một số công ty AI Trung Quốc than phiền rằng “chất lượng sinh viên tốt nghiệp từ các chương trình này không đạt kỳ vọng”, dẫn đến việc một số doanh nghiệp phải hợp tác trực tiếp với các trường đại học.

“Hiệu suất trong điều kiện hạn chế”

Các nhà khoa học nhận định rằng điều đáng kinh ngạc nhất về thành công của DeepSeek là công ty đã phát triển DeepSeek-R1 và Janus-Pro-7B trong bối cảnh chính phủ Mỹ áp đặt kiểm soát xuất khẩu, ngăn Trung Quốc tiếp cận các chip tính toán AI tiên tiến từ năm 2022.

Zhang cho rằng ban lãnh đạo DeepSeek thể hiện một cách tiếp cận đổi mới mang đậm phong cách Trung Quốc, tập trung vào tối ưu hóa hiệu suất trong điều kiện hạn chế. Tuy nhiên, bà lưu ý rằng công ty chưa công bố chi tiết cụ thể về số lượng phần cứng sử dụng.

DeepSeek từng cho biết họ đã sử dụng khoảng 2.000 chip H800 của Nvidia – nhà sản xuất chip của Mỹ – để đào tạo DeepSeek-V3, một mô hình phát hành vào tháng 12/2024 và có hiệu năng vượt trội so với GPT-4o của OpenAI, vốn ra mắt vào tháng 5 cùng năm, theo các bài kiểm tra chuẩn. Trong khi đó, Llama 3.1 405B, một LLM tiên tiến do Meta ở Menlo Park, California, phát hành vào tháng 7, lại dựa vào hơn 16.000 chip H100 của Nvidia – loại chip mạnh hơn nhiều. Một bài đăng trên WeChat năm 2022 của High-Flyer tiết lộ rằng quỹ này sở hữu 10.000 chip A100 – một dòng chip cũ hơn của Nvidia – mà DeepSeek có thể đã tiếp cận. Việc sử dụng các chip kém mạnh hơn có thể đã giúp DeepSeek giảm đáng kể chi phí phát triển mô hình. “Vấn đề chúng tôi đối mặt chưa bao giờ là tiền bạc, mà là lệnh cấm đối với các chip cao cấp,” Wenfeng nói với truyền thông Trung Quốc vào tháng 7/2024.

DeepSeek áp dụng nhiều phương pháp để tăng hiệu suất mô hình. Chẳng hạn, công ty sử dụng kiến trúc ‘mixture-of-experts’ – một phương pháp học máy giúp huấn luyện mô hình nhanh hơn so với kỹ thuật truyền thống và yêu cầu ít tham số hơn. Nhờ đó, DeepSeek có thể đào tạo mô hình với số lượng chip ít hơn, theo Chang Xu, nhà khoa học máy tính tại Đại học Sydney. Ngoài ra, công ty còn triển khai một phiên bản cải tiến của kỹ thuật ‘multi-head latent attention’, giúp mô hình lưu trữ nhiều dữ liệu hơn với dung lượng bộ nhớ ít hơn.

Tuần này, một số báo cáo truyền thông cho biết OpenAI đang xem xét cáo buộc rằng DeepSeek đã sử dụng đầu ra từ các mô hình của OpenAI để huấn luyện mô hình của mình. (OpenAI hiện đang bị các tổ chức tin tức kiện vì vi phạm sở hữu trí tuệ). DeepSeek vẫn chưa đưa ra phản hồi về cáo buộc này. Dù vậy, ngay cả khi điều đó là sự thật, “nó cũng không làm giảm giá trị thành tựu” của DeepSeek trong việc phát triển R1, theo Lewis Tunstall, nhà nghiên cứu tại nền tảng khoa học mở Hugging Face ở Bern, Thụy Sĩ. Thành tựu của DeepSeek nằm ở việc áp dụng phương pháp học máy để trang bị khả năng “lập luận” cho một LLM – điều mà các thí nghiệm đã tái hiện được, ông cho biết. Hugging Face hiện đang dẫn đầu một dự án nhằm thử tái tạo R1 từ đầu. “Tôi nghĩ rằng chúng ta sẽ sớm biết liệu dữ liệu tổng hợp từ OpenAI có thực sự cần thiết hay không,” ông nói.

Theo Yanbo Wang, nhà nghiên cứu chính sách khoa học chuyên về đổi mới tại Đại học Hong Kong, những thành tựu của DeepSeek có thể trở thành hình mẫu cho các quốc gia có tham vọng phát triển AI nhưng không đủ nguồn lực tài chính và phần cứng để đào tạo các LLM quy mô lớn theo cách tiếp cận truyền thống của Silicon Valley. “Điều này có thể dẫn đến sự ra đời của một ‘đội quân’ mô hình AI mới,” ông nhận định.

doi: https://doi.org/10.1038/d41586-025-00259-0

How China created AI model DeepSeek and shocked the world

Government policies, generous funding and a pipeline of AI graduates have helped Chinese firms create advanced LLMs.

By Gemma Conroy & Smriti Mallapaty

Chinese technology start-up DeepSeek has taken the tech world by storm with the release of two large language models (LLMs) that rival the performance of the dominant tools developed by US tech giants — but built with a fraction of the cost and computing power.

On 20 January, the Hangzhou-based company released DeepSeek-R1, a partly open-source ‘reasoning’ model that can solve some scientific problems at a similar standard to o1, OpenAI's most advanced LLM, which the company based in San Francisco, California, unveiled late last year. And earlier this week, DeepSeek launched another model called Janus-Pro-7B, which can generate images from text prompts much like OpenAI’s DALL-E 3 and Stable Diffusion, made by Stability AI in London.

If DeepSeek-R1’s performance surprised many people outside of China, researchers inside the country say the start-up’s success is to be expected and fits with the government’s ambition to be a global leader in artificial intelligence (AI).

It was inevitable that a company such as DeepSeek would emerge in China, given the huge venture-capital investment in firms developing LLMs and the many people who hold doctorates in science, technology, engineering or mathematics fields, including AI, says Yunji Chen, a computer scientist working on AI chips at the Institute of Computing Technology of the Chinese Academy of Sciences in Beijing. “If there was no DeepSeek, there would be some other Chinese LLM that could do great things.”

In fact, there are. On 29 January, tech behemoth Alibaba released its most advanced LLM so far, Qwen2.5-Max, which the company says outperforms DeepSeek's V3, another LLM the firm released in December. And last week, Moonshot AI and ByteDance released new reasoning models, Kimi 1.5 and 1.5-pro, which the companies claim can outperform o1 on some benchmark tests.

Government priority

In 2017, the Chinese government announced its intention for the country to become the world leader in AI by 2030. It tasked the industry with completing major AI breakthroughs “such that technologies and applications achieve a world-leading level” by 2025.

Developing a pipeline of ‘AI talent’ became a priority. By 2022, the Chinese ministry of education had approved 440 universities to offer undergraduate degrees specializing in AI, according to a report from the Center for Security and Emerging Technology (CSET) at Georgetown University in Washington DC. In that year, China supplied almost half of the world’s leading AI researchers, while the United States accounted for just 18%, according to the think tank MacroPolo in Chicago, Illinois.

DeepSeek probably benefited from the government’s investment in AI education and talent development, which includes numerous scholarships, research grants and partnerships between academia and industry, says Marina Zhang, a science-policy researcher at the University of Technology Sydney in Australia who focuses on innovation in China. For instance, she adds, state-backed initiatives such as the National Engineering Laboratory for Deep Learning Technology and Application, which is led by tech company Baidu in Beijing, have trained thousands of AI specialists.

Exact figures on DeepSeek’s workforce are hard to find, but company founder Liang Wenfeng told Chinese media that the company has recruited graduates and doctoral students from top-ranking Chinese universities. Some members of the company’s leadership team are younger than 35 years old and have grown up witnessing China’s rise as a tech superpower, says Zhang. “They are deeply motivated by a drive for self-reliance in innovation.”

Wenfeng, at 39, is himself a young entrepreneur and graduated in computer science from Zhejiang University, a top institution in Hangzhou. He co-founded the hedge fund High-Flyer almost a decade ago and established DeepSeek in 2023.

Jacob Feldgoise, who studies AI talent in China at the CSET, says national policies that promote a model development ecosystem for AI will have helped companies such as DeepSeek, in terms of attracting both funding and talent.

But despite the rise in AI courses at universities, Feldgoise says it is not clear how many students are graduating with dedicated AI degrees and whether they are being taught the skills that companies need. Chinese AI companies have complained in recent years that “graduates from these programmes were not up to the quality they were hoping for”, he says, leading some firms to partner with universities.

‘Efficiency under constraints’

Perhaps the most impressive element of DeepSeek’s success, say scientists, is that it developed DeepSeek-R1 and Janus-Pro-7B amid US government’s export controls, which have blocked China’s access to advanced AI computing chips since 2022.

Zhang says DeepSeek’s leadership embodies a distinctly Chinese approach to innovation, emphasizing efficiency under constraints. However, the company hasn’t disclosed specific details about how much hardware it uses, she adds.

DeepSeek has said that it used around 2,000 H800 chips built by US chip-maker Nvidia to train DeepSeek-V3, a model it released in December1 that outperforms OpenAI’s LLM GPT-4o, launched in May last year, on benchmark tests. By contrast, Llama 3.1 405B, a sophisticated LLM released in July from Meta in Menlo Park, California, relies on more than 16,000 of the more advanced H100 Nvidia chips. In a 2022 post on social-media platform WeChat, High-Flyer said that it had 10,000 of Nvidia’s older A100 chips, which DeepSeek probably has access to. DeepSeek’s use of less powerful chips probably made its models cheaper to build. “The problem we face has never been money, but the ban on high-end chips,” Wenfeng told Chinese media in July 2024.

DeepSeek draws on a variety of approaches to boost the efficiency of its models. For instance, it deploys a ‘mixture-of-experts’ architecture, a machine-learning method that trains models faster than conventional techniques, and with fewer parameters. This enables the company to train models with fewer chips, says Chang Xu, a computer scientist at the University of Sydney. It also uses an innovative version of another technique, called multi-head latent attention, which allows the model to store more data with less memory.

This week, media reports suggested that OpenAI was reviewing claims that DeepSeek trained its model using outputs from OpenAI models. (OpenAI is being sued for intellectual property infringements by news organisations). DeepSeek has yet to respond to the claims. Even if true, it would “in no way diminish” DeepSeek’s achievement in creating R1, says Lewis Tunstall, a researcher at the open-science platform Hugging Face, based in Bern, Switzerland. Their advance is in using a learning approach to instill ‘reasoning’ abilities into an LLM, which experiments have already reproduced, he says. Hugging Face is leading a project to try to recreate R1 from scratch. “I expect we will learn rather quickly whether synthetic data from OpenAI is truly needed or not,” he says.

DeepSeek’s achievements could offer a blueprint for countries that have AI ambitions but lack the financial resources and hardware to train massive LLMs using the standard Silicon Valley approach, says Yanbo Wang, a science-policy researcher who focuses on innovation at Hong Kong University. “This could invite the creation of a large army of new models,” he says.

doi: https://doi.org/10.1038/d41586-025-00259-0

Thảo luận

Follow Us

Tin phổ biến