Sử dụng LLM riêng để tìm kiếm dữ liệu kinh doanh đối mặt với rủi ro rò rỉ dữ liệu và thông tin sai lệch

- Các công ty sử dụng mô hình ngôn ngữ lớn (LLM) riêng tư để tìm kiếm dữ liệu kinh doanh đối mặt với rủi ro rò rỉ dữ liệu và thông tin sai lệch nếu không thực hiện các biện pháp bảo mật đúng cách.

- Synopsys đã tiết lộ lỗ hổng CSRF trong thành phần EmbedAI của SamurAI, cho phép kẻ tấn công tải dữ liệu độc hại vào mô hình ngôn ngữ.

- Lỗ hổng này khai thác chính sách cross-origin không an toàn và thiếu quản lý phiên, có thể ảnh hưởng đến cả LLM riêng tư hoặc chatbot.

- Các công ty cần kiểm tra và đảm bảo rằng các biện pháp bảo mật cho ứng dụng web cũng được áp dụng cho API của ứng dụng AI.

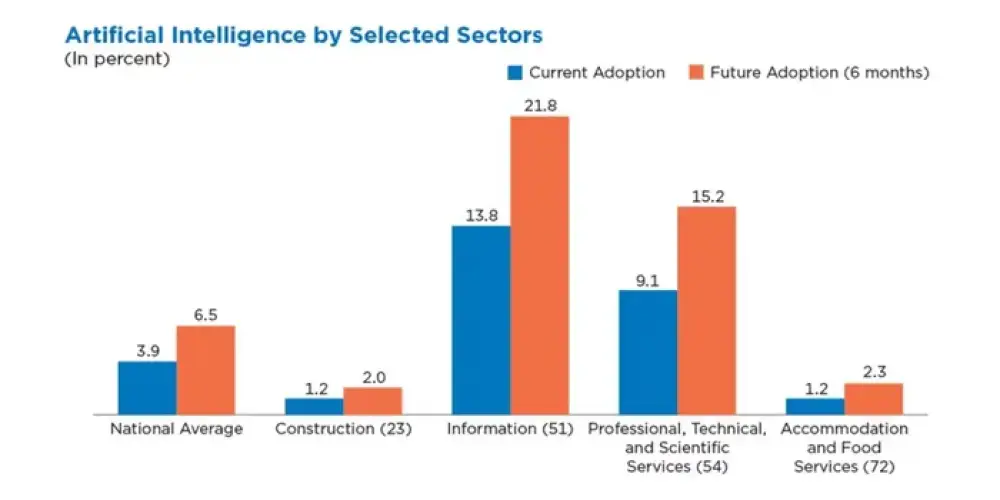

- Chỉ 4% các công ty Mỹ đã áp dụng AI vào hoạt động kinh doanh, nhưng tỷ lệ này cao hơn trong ngành thông tin (14%) và dịch vụ chuyên nghiệp (9%).

- Các rủi ro không chỉ đến từ mô hình AI mà còn từ các thành phần phần mềm và công cụ phát triển ứng dụng AI.

- Các lỗ hổng đã bị khai thác, như trong trường hợp framework Ray, với hàng trăm triển khai bị tấn công do cấu hình không an toàn.

- Các công ty cần phân đoạn dữ liệu và LLM để chỉ những nhân viên có quyền truy cập mới được sử dụng các dịch vụ LLM tương ứng.

- Cần giảm thiểu các thành phần sử dụng để phát triển công cụ AI và thường xuyên cập nhật phần mềm để giảm thiểu rủi ro khai thác.

📌 Các công ty sử dụng LLM riêng tư cần thực hiện các biện pháp bảo mật nghiêm ngặt để tránh rủi ro rò rỉ dữ liệu và thông tin sai lệch. Việc phân đoạn dữ liệu và thường xuyên cập nhật phần mềm là cần thiết để bảo vệ hệ thống AI.

https://www.darkreading.com/application-security/flawed-ai-tools-create-worries-for-private-llms-chatbots

Thảo luận

Follow Us

Tin phổ biến