Khám phá các mô hình ngôn ngữ nhỏ (SLM) - tương lai của AI hiệu quả và dễ tiếp cận

• Mô hình ngôn ngữ nhỏ (SLM) đang trở thành tâm điểm trong lĩnh vực xử lý ngôn ngữ tự nhiên, hướng tới việc đưa trí tuệ nhân tạo chất lượng cao lên các thiết bị hàng ngày.

• SLM thường có từ 100 triệu đến 5 tỷ tham số, nhỏ hơn nhiều so với mô hình ngôn ngữ lớn (LLM), nhưng vẫn có thể thực hiện các tác vụ ngôn ngữ phức tạp một cách hiệu quả.

• Nghiên cứu tập trung vào việc tối ưu hóa mô hình AI cho các thiết bị có tài nguyên tính toán hạn chế như điện thoại thông minh, máy tính bảng và thiết bị đeo.

• Các phương pháp như cắt tỉa mô hình, chưng cất kiến thức và lượng tử hóa được sử dụng để giảm độ phức tạp của mô hình lớn mà không ảnh hưởng đến hiệu suất.

• Nghiên cứu từ Đại học Bưu chính Viễn thông Bắc Kinh và các đối tác giới thiệu thiết kế kiến trúc mới cho SLM, tập trung vào mô hình transformer chỉ có bộ giải mã.

• Các cải tiến bao gồm cơ chế attention đa truy vấn và mạng nơ-ron feed-forward có cổng (FFN), giúp giảm bộ nhớ và tăng hiệu quả xử lý.

• Kiến trúc mới sử dụng attention nhóm truy vấn để giảm số lượng nhóm truy vấn mà vẫn duy trì sự đa dạng của attention.

• SiLU (Sigmoid Linear Unit) được sử dụng làm hàm kích hoạt, cho thấy cải thiện đáng kể trong xử lý các tác vụ ngôn ngữ.

• Kỹ thuật bù phi tuyến tính được áp dụng để giải quyết vấn đề sụp đổ đặc trưng thường gặp ở các mô hình nhỏ.

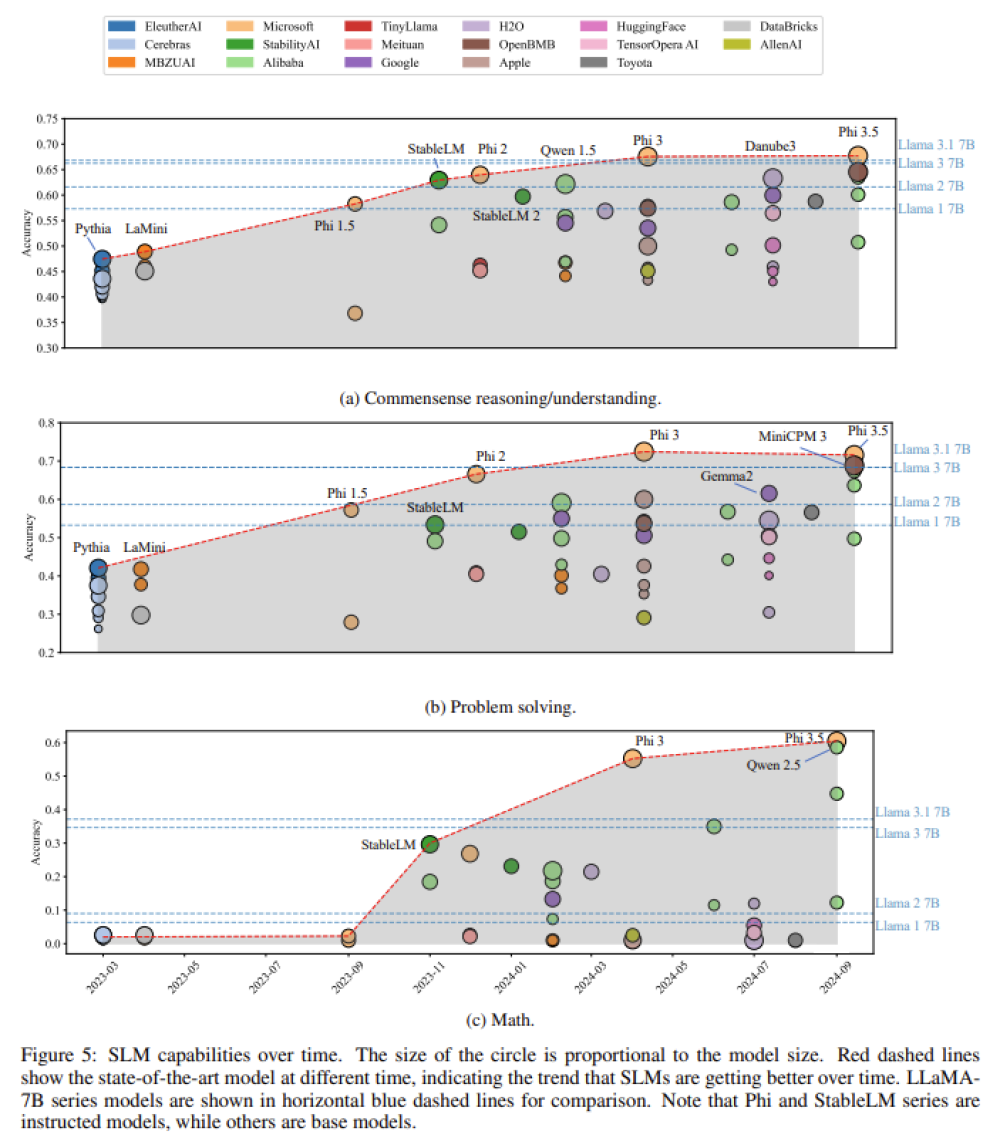

• Mô hình Phi-3 mini đạt độ chính xác cao hơn 14,5% trong các tác vụ lập luận toán học so với LLaMA 3.1 - một mô hình lớn với 7 tỷ tham số.

• Trong các tác vụ lập luận thông thường, họ mô hình Phi vượt trội so với nhiều mô hình hàng đầu, đạt độ chính xác 67,6%.

• Mô hình Phi-3 đạt độ chính xác 72,4% trong các tác vụ giải quyết vấn đề, đứng trong top các SLM hiệu suất cao.

• Các mô hình được thử nghiệm trên nhiều thiết bị biên như Jetson Orin NX và điện thoại thông minh cao cấp, cho thấy giảm đáng kể độ trễ suy luận và sử dụng bộ nhớ.

• Mô hình Qwen-2 1.5B giảm độ trễ suy luận hơn 50%, trở thành một trong những mô hình hiệu quả nhất được thử nghiệm.

• OpenELM-3B sử dụng ít hơn 30% bộ nhớ so với các mô hình khác có số lượng tham số tương tự.

📌 SLM đang mở ra tương lai cho AI hiệu quả và dễ tiếp cận trên các thiết bị hàng ngày. Với kiến trúc sáng tạo như attention nhóm truy vấn và FFN có cổng, các mô hình nhỏ như Phi-3 đã vượt trội hơn cả LLM trong nhiều tác vụ, đồng thời giảm đáng kể độ trễ và sử dụng bộ nhớ trên thiết bị cạnh.

https://www.marktechpost.com/2024/09/26/a-comprehensive-survey-of-small-language-models-architectures-datasets-and-training-algorithms/

Thảo luận

Follow Us

Tin phổ biến