DeepSeek-R1: Mô hình LLM mở mới vượt OpenAI o1 với chi phí chỉ thấp hơn 90-95%

- DeepSeek, một startup AI Trung Quốc, công bố mô hình LLM mở mới mang tên DeepSeek-R1, cải tiến hiệu suất và giảm chi phí tới 90-95% so với OpenAI o1.

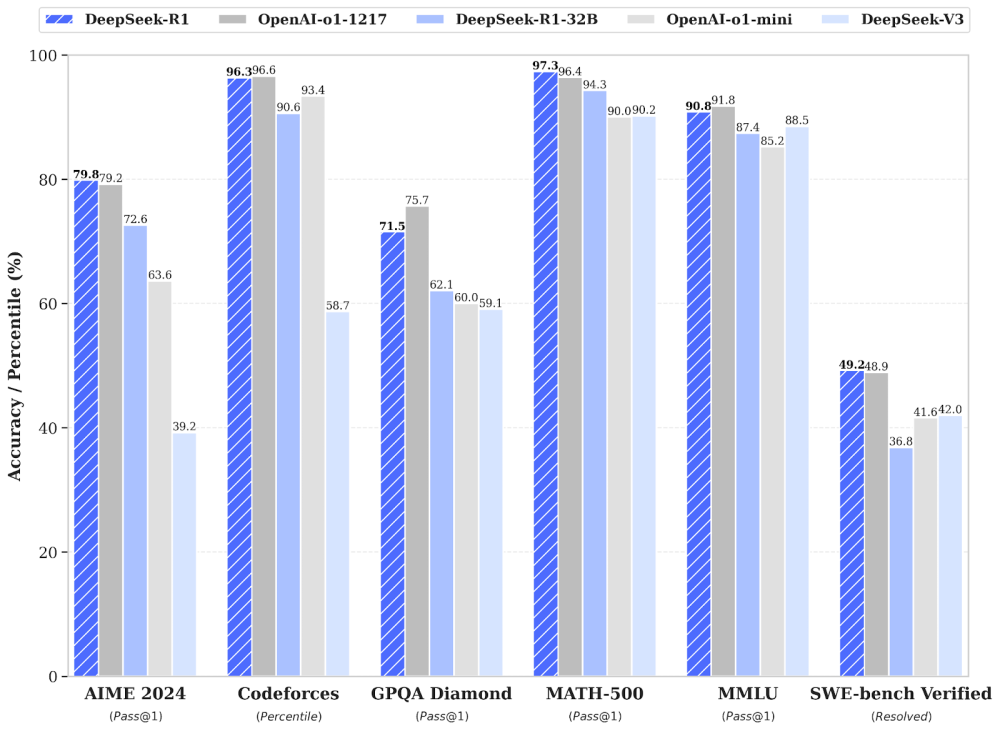

- DeepSeek-R1 sử dụng mô hình hỗn hợp DeepSeek V3, đạt được hiệu suất tương đương với o1 trong các tác vụ toán học, lập trình và suy luận.

- Mô hình này hoàn toàn mở và có sẵn trên Hugging Face dưới giấy phép MIT, cho phép cộng động phát triển và sử dụng.

- Trong các bài kiểm tra, DeepSeek-R1 đạt 79.8% trong bài kiểm tra toán AIME 2024 và 97.3% trong MATH-500.

- DeepSeek-R1 cũng ghi điểm 2.029 trên Codeforces, tốt hơn 96.3% lập trình viên con người.

- DeepSeek-R1 cho thấy khả năng kiến thức tổng quát tốt với độ chính xác 90.8% trên MMLU, chỉ đứng sau o1 với 91.8%.

- Mô hình được phát triển từ DeepSeek-R1-Zero, sử dụng học tăng cường hoàn toàn mà không cần dữ liệu giám sát.

- DeepSeek-R1 được cải tiến bằng cách kết hợp học tăng cường và tinh chỉnh giám sát để xử lý các nhiệm vụ phức tạp.

- Chi phí sử dụng DeepSeek-R1 cực kỳ thấp so với OpenAI o1: 0.55 USD cho mỗi triệu token đầu vào và 2.19 USD cho mỗi triệu token đầu ra.

- Mô hình có thể được thử nghiệm trên nền tảng DeepSeek, tương tự như ChatGPT, và người dùng có thể truy cập mã nguồn và trọng số mô hình qua Hugging Face.

📌 DeepSeek-R1 đã chứng minh khả năng xuất sắc tại thị trường AI mở, đạt hiệu suất gần tương đương OpenAI o1 trong khi giảm chi phí tới 95%. Sự cạnh tranh này mở ra cơ hội cho AI mở phát triển mạnh mẽ hơn trong tương lai.

https://venturebeat.com/ai/open-source-deepseek-r1-uses-pure-reinforcement-learning-to-match-openai-o1-at-95-less-cost/

Thảo luận

Follow Us

Tin phổ biến