Ảo giác trong LLM: tại sao không thể loại bỏ hoàn toàn và cách quản lý hiệu quả

• Nghiên cứu mới thách thức quan điểm truyền thống về ảo giác trong mô hình ngôn ngữ lớn (LLM), cho rằng đây là đặc điểm không thể tránh khỏi thay vì lỗi ngẫu nhiên.

• Ảo giác được định nghĩa là thông tin có vẻ hợp lý nhưng không chính xác do mô hình tạo ra. Nghiên cứu cho rằng ảo giác bắt nguồn từ nền tảng toán học và logic cơ bản của LLM.

• Khái niệm "Ảo giác cấu trúc" được giới thiệu, dựa trên lý thuyết tính toán và Định lý bất toàn thứ nhất của Gödel. Mỗi giai đoạn trong quá trình LLM đều có xác suất không bằng 0 tạo ra ảo giác.

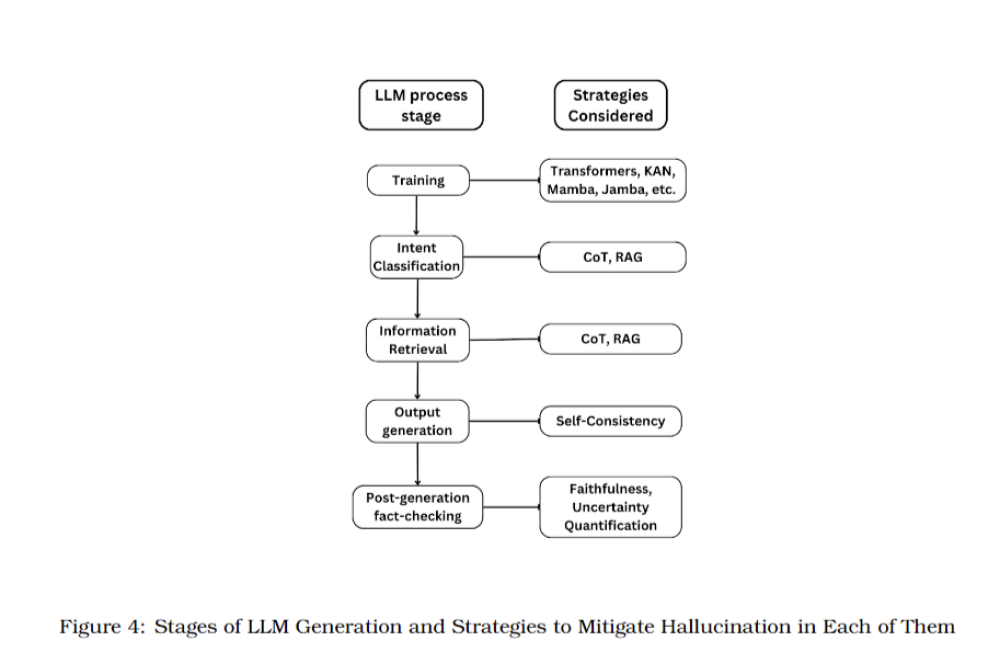

• Các nhà nghiên cứu đề xuất phương pháp toàn diện để giải quyết ảo giác trong LLM, bao gồm:

- Cải thiện kỹ thuật truy xuất thông tin như Chain-of-Thought prompting và tạo sinh được tăng cường bởi truy xuất dữ liệu ngoài

- Tăng cường đầu vào bằng cách kết hợp tài liệu truy xuất với truy vấn gốc

- Sử dụng phương pháp Self-Consistency trong quá trình tạo đầu ra

- Áp dụng kỹ thuật hậu xử lý như Uncertainty Quantification và Faithfulness Explanation Generation

• Nghiên cứu khẳng định rằng ảo giác trong LLM là bản chất và chắc chắn về mặt toán học, không thể loại bỏ hoàn toàn thông qua cải tiến kiến trúc hay dữ liệu huấn luyện.

• Các tiến bộ về kiến trúc như transformer hay các mô hình thay thế như KAN, Mamba và Jamba có thể cải thiện quá trình huấn luyện nhưng không giải quyết được vấn đề cơ bản của ảo giác.

• Hiệu suất của LLM, bao gồm khả năng truy xuất và tạo thông tin chính xác, bị giới hạn bởi thiết kế cấu trúc vốn có của chúng.

• Nghiên cứu nhấn mạnh sự cần thiết phải hiểu thực tế về khả năng và hạn chế của LLM, thay vì kỳ vọng loại bỏ hoàn toàn ảo giác.

• Các tác giả kêu gọi chuyển hướng từ việc cố gắng loại bỏ sang quản lý hiệu quả những hạn chế vốn có này trong LLM.

📌 Nghiên cứu khẳng định ảo giác trong LLM là không thể tránh khỏi và không thể loại bỏ hoàn toàn. Mọi giai đoạn tạo đầu ra của LLM đều có khả năng sinh ảo giác. Cần thay đổi cách tiếp cận từ loại bỏ sang quản lý hiệu quả những hạn chế này của LLM.

https://www.marktechpost.com/2024/09/17/understanding-the-inevitable-nature-of-hallucinations-in-large-language-models-a-call-for-realistic-expectations-and-management-strategies/

Thảo luận

Follow Us

Tin phổ biến