Nghiên cứu tác động của việc tinh chỉnh mô hình ngôn ngữ lớn với kiến thức mới đến khả năng tạo ra câu trả lời không chính xác.

- Mô hình ngôn ngữ lớn (LLMs) khi được tinh chỉnh với dữ liệu mới có thể không học được kiến thức một cách hiệu quả.

- Trong quá trình tinh chỉnh, LLMs thường gặp phải thông tin mới không có trong kiến thức đã học trước đó.

- Các mô hình này có xu hướng tạo ra câu trả lời không chính xác khi được huấn luyện với dữ liệu mới.

- Nghiên cứu đã thiết kế một thí nghiệm kiểm soát để đánh giá tác động của việc học từ các ví dụ tinh chỉnh mang thông tin mới.

- Kết quả cho thấy, việc học từ các ví dụ mang thông tin mới có mối liên hệ tuyến tính với xu hướng tạo sinh không chính xác của mô hình so với kiến thức đã có.

- Việc học từ các ví dụ có thông tin đã biết lại gắn liền với việc sử dụng hiệu quả hơn kiến thức sẵn có.

- Phát hiện này nhấn mạnh rủi ro khi giới thiệu kiến thức mới thông qua tinh chỉnh và ủng hộ quan điểm rằng LLMs chủ yếu thu nạp kiến thức thông qua quá trình tiền huấn luyện.

- Các mô hình được tinh chỉnh với các ví dụ có độ chắc chắn thấp trong kiến thức (MaybeKnown) lại cho kết quả tốt hơn trong thử nghiệm, cho thấy sự cần thiết của việc bao gồm các ví dụ này trong quá trình tinh chỉnh.

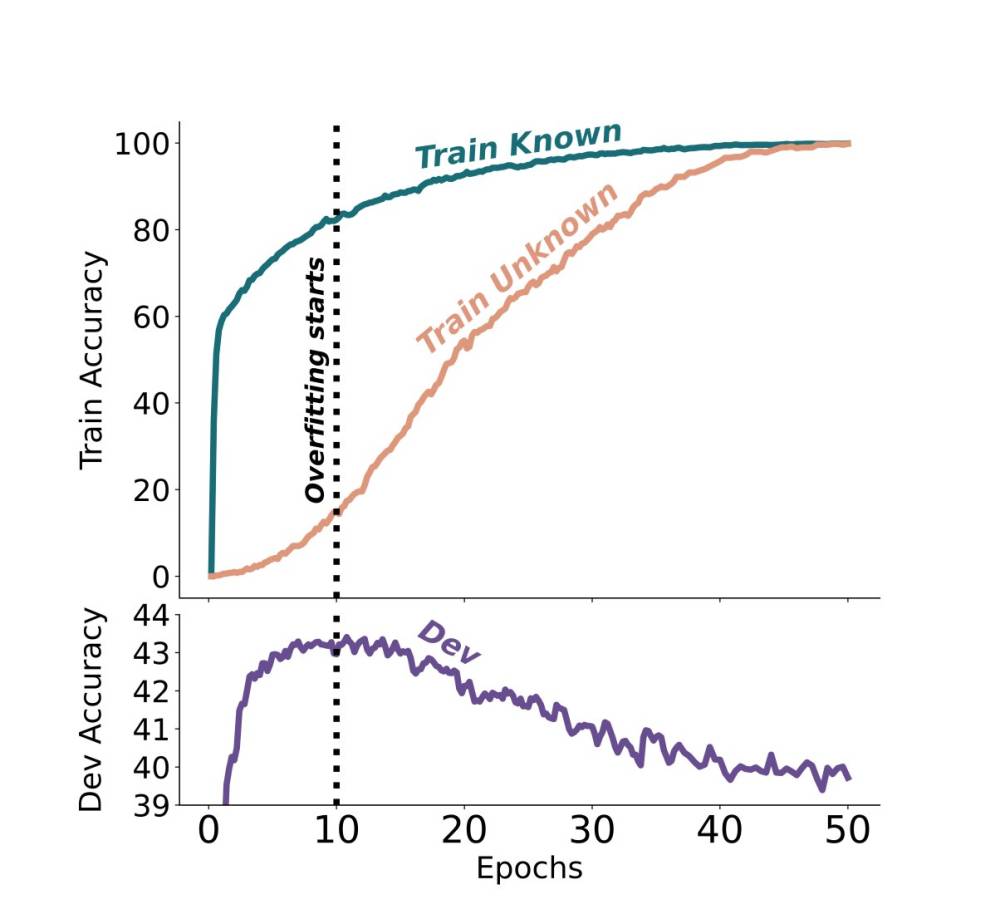

- Việc sử dụng sớm dừng (early-stopping) có thể giảm thiểu rủi ro của việc tạo sinh không chính xác do các ví dụ không biết gây ra, vì chúng thường xuất hiện ở giai đoạn sau của quá trình tinh chỉnh.

📌 Nghiên cứu chỉ ra rằng việc tinh chỉnh mô hình ngôn ngữ lớn với kiến thức mới có thể dẫn đến tạo sinh không chính xác, đặc biệt là khi mô hình học các ví dụ mang thông tin mới. Việc học từ các ví dụ có thông tin đã biết lại gắn liền với việc sử dụng hiệu quả hơn kiến thức sẵn có.

Citations:

[1] https://arxiv.org/pdf/2405.05904

Thảo luận

Follow Us

Tin phổ biến